Содержание

- 2. Классификация технологий параллельного программирования (ТТП) 1. Технологии параллельного программирования (ТПП) обычно реализуются как расширения традиционных языков

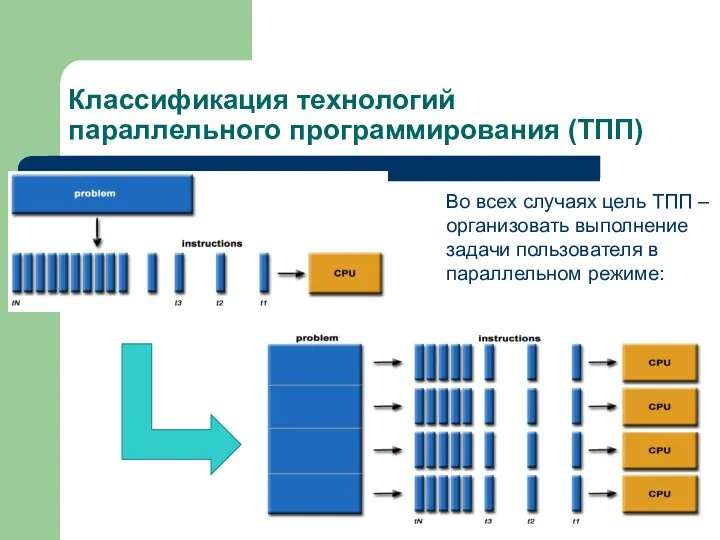

- 3. Классификация технологий параллельного программирования (ТПП) Во всех случаях цель ТПП – организовать выполнение задачи пользователя в

- 4. Что такое MPI Message Passing Interface – одна из популярных технологий для организации параллельных вычислений. MPI

- 5. Структура MPI Главные составляющие MPI Коммуникатор (группа процессов плюс контекст взаимодействия) Типы передаваемых данных (всегда передаем

- 6. Процедуры MPI повторение и дополнение пройденного на семинарах «ПРОЖИТОЧНЫЙ МИНИМУМ» MPI_Init инициализация параллельной части программы MPI_Finalize

- 7. Операции “Point-to-Point”: асинхронный обмен MPI_Isend: Передача сообщения, аналогичная MPI_Send, однако возврат происходит сразу после инициализации процесса

- 8. Операции MPI “Point-to-Point”: Объединение запросов на взаимодействие Несколько запросов на прием и/или передачу могут объединяться вместе

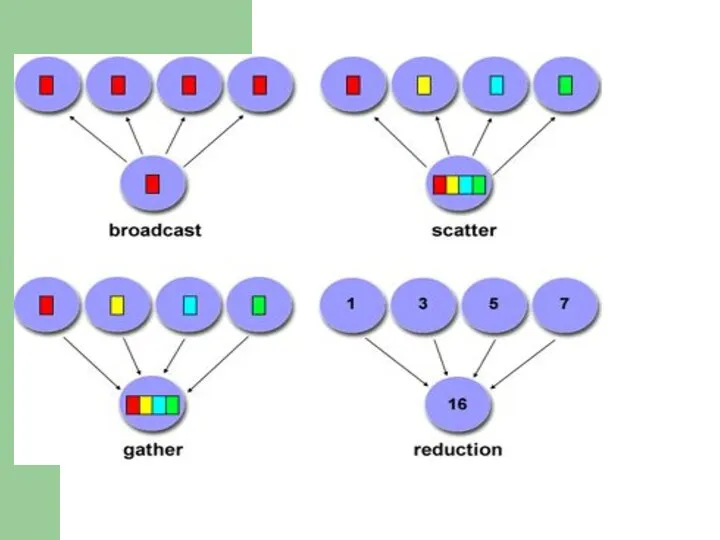

- 9. Коллективные операции MPI В операциях коллективного взаимодействия процессов участвуют все процессы коммуникатора. Соответствующая процедура должна быть

- 11. Группы и коммуникаторы В MPI существуют широкие возможности для операций над группами процессов и коммуникаторами. Это

- 12. Операции с группами процессов Новые группы можно создавать как на основе уже существующих групп, так и

- 13. Операции с коммуникаторами Коммуникатор предоставляет возможность независимых обменов данными в отдельной группе. Каждой группе процессов может

- 14. Виртуальные топологии Топология – механизм сопоставления процессам некоторого коммуникатора альтернативной схемы адресации. Топология используется программистом для

- 15. Виртуальные топологии: декатрова топология Декартова топология MPI_Cart_create: Создание коммуникатора, обладающего декартовой топологией, из процессов существующего коммуникатора

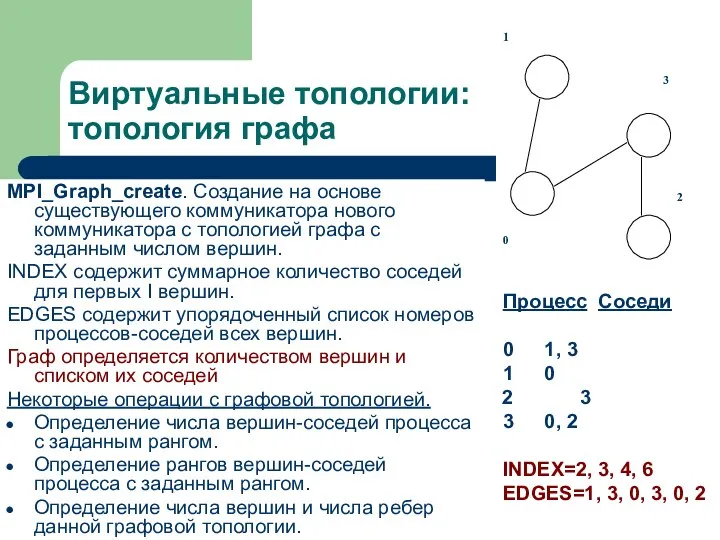

- 16. Виртуальные топологии: топология графа MPI_Graph_create. Создание на основе существующего коммуникатора нового коммуникатора с топологией графа с

- 17. Пересылка разнотипных данных Под сообщением в MPI понимается массив однотипных данных, расположенных в последовательных ячейках памяти.

- 18. Пересылка разнотипных данных: Производные типы данных Производные типы данных создаются во время выполнения программы с помощью

- 19. Пересылка разнотипных данных: Производные типы данных Таким образом, последовательность элементов данных в производном типе может отличаться

- 21. Скачать презентацию

V значит Vilki. Первый семинар

V значит Vilki. Первый семинар Нейронные сети

Нейронные сети Введение в профессиональную деятельность (для направления Информационные системы и технологии)

Введение в профессиональную деятельность (для направления Информационные системы и технологии) Інформаційно-пошукове бюро

Інформаційно-пошукове бюро Архитектура операционной системы

Архитектура операционной системы Python старт в IT - будущее. Искусственный интеллект

Python старт в IT - будущее. Искусственный интеллект Проект на тему Сайт ВК

Проект на тему Сайт ВК Дистанционное обучение

Дистанционное обучение Ввод-вывод данных на консоль в С++

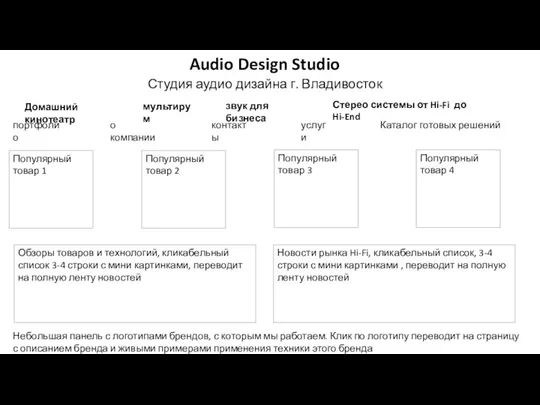

Ввод-вывод данных на консоль в С++ Audio Design Studio

Audio Design Studio Понятие алгоритмов, свойства алгоритма

Понятие алгоритмов, свойства алгоритма CodeEvening. Web-разработка

CodeEvening. Web-разработка Successful apps $1,000,000,000 case

Successful apps $1,000,000,000 case Структура данных Scapegoat Tree

Структура данных Scapegoat Tree Тестирование программного обеспечения

Тестирование программного обеспечения Эволюция данных

Эволюция данных Обучение вместе с МЭО. План проведения занятий с МЭО в условиях дистанционного обучения

Обучение вместе с МЭО. План проведения занятий с МЭО в условиях дистанционного обучения Системное программное обеспечение

Системное программное обеспечение Алгоритмы и работа с величинами

Алгоритмы и работа с величинами Тема: Основные понятия алгебры логики. Логические выражения и логические операции

Тема: Основные понятия алгебры логики. Логические выражения и логические операции Модификация данных

Модификация данных Расшифровка. Самый умный по информатике

Расшифровка. Самый умный по информатике Проектирование информационной системы учета комплектующих для компьютерной и офисной техники (на примере МУП ЯТЭК)

Проектирование информационной системы учета комплектующих для компьютерной и офисной техники (на примере МУП ЯТЭК) Всемирный день информации

Всемирный день информации Одномерные массивы целых чисел. Алгоритмизация и программирование

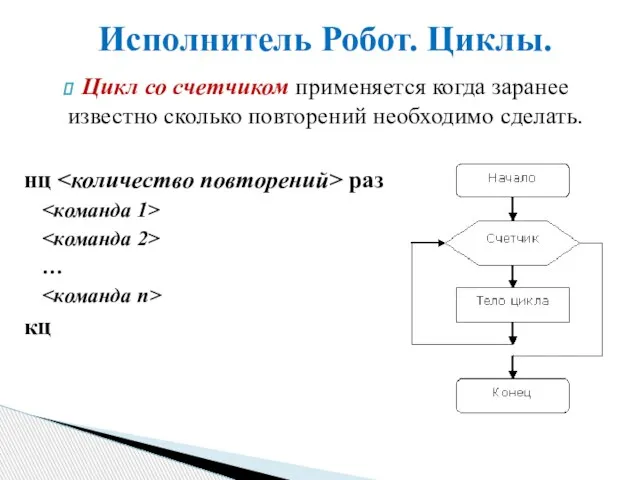

Одномерные массивы целых чисел. Алгоритмизация и программирование Исполнитель Робот. Циклы

Исполнитель Робот. Циклы Методологические аспекты эволюции информационных технологий

Методологические аспекты эволюции информационных технологий СберКласс для учеников в ВКонтакте

СберКласс для учеников в ВКонтакте