Содержание

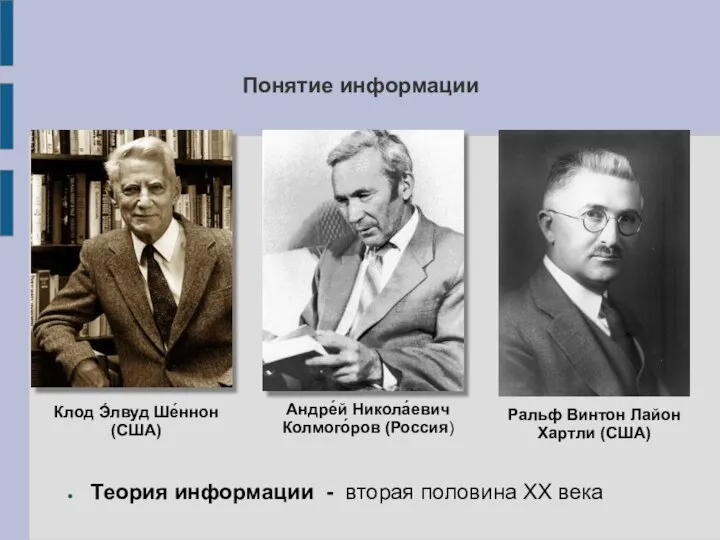

- 2. Понятие информации Теория информации - вторая половина XX века Клод Э́лвуд Ше́ннон (США) Андре́й Никола́евич Колмого́ров

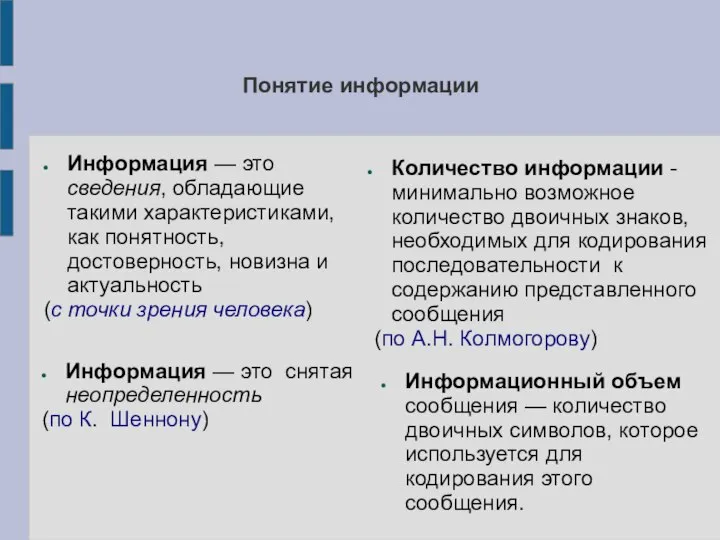

- 3. Понятие информации Информация — это сведения, обладающие такими характеристиками, как понятность, достоверность, новизна и актуальность (с

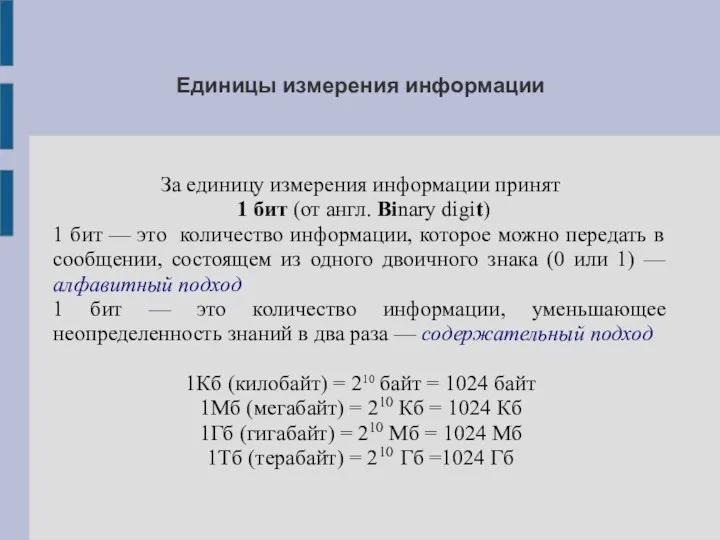

- 4. Единицы измерения информации За единицу измерения информации принят 1 бит (от англ. Binary digit) 1 бит

- 5. ВОПРОСЫ И ЗАДАНИЯ Расскажите, как вы понимаете термин «информация». Что общего и каковы различия между бытовым

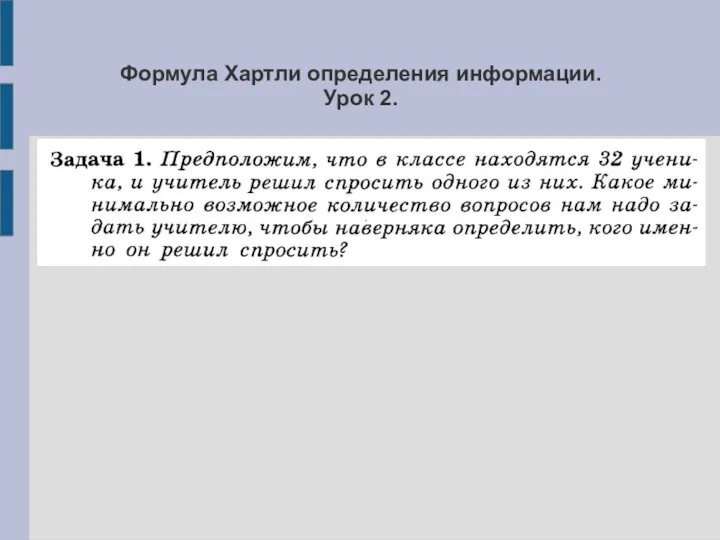

- 6. Формула Хартли определения информации. Урок 2.

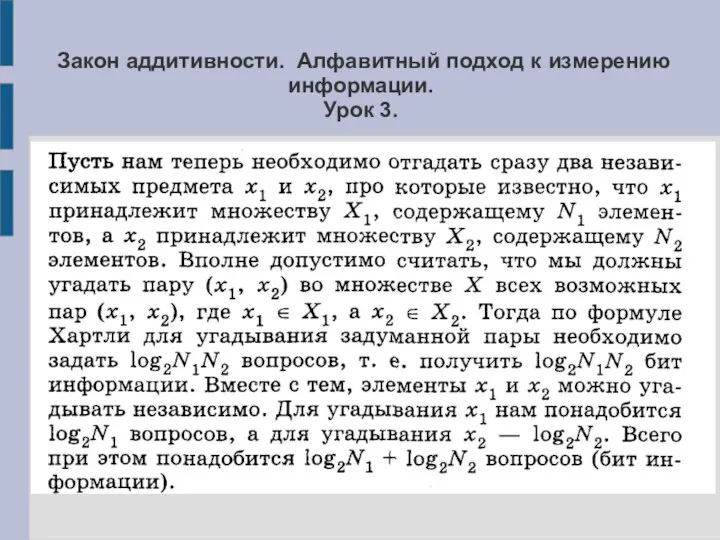

- 7. Закон аддитивности. Алфавитный подход к измерению информации. Урок 3.

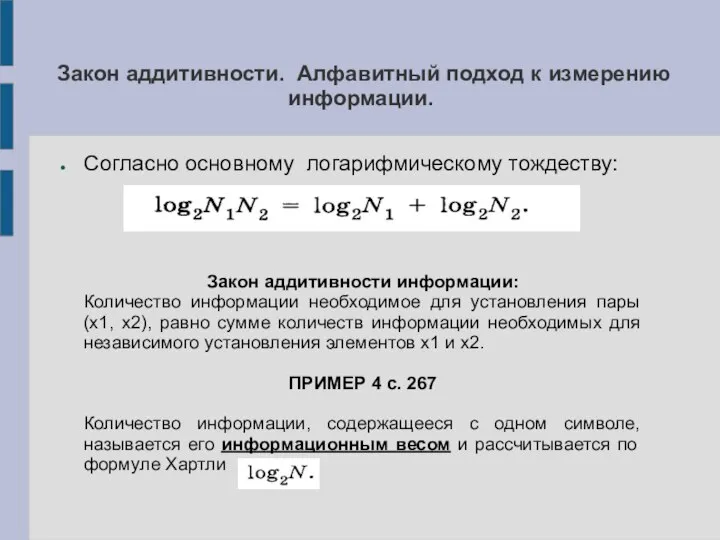

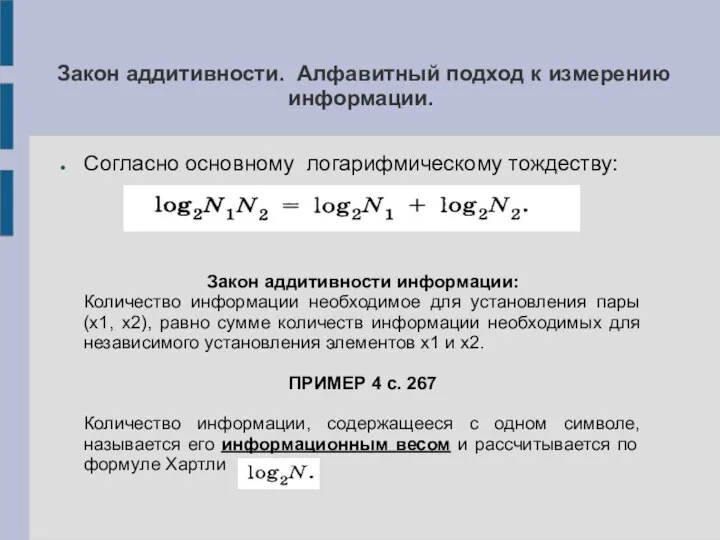

- 8. Закон аддитивности. Алфавитный подход к измерению информации. Согласно основному логарифмическому тождеству: Закон аддитивности информации: Количество информации

- 9. Закон аддитивности. Алфавитный подход к измерению информации. Согласно основному логарифмическому тождеству: Закон аддитивности информации: Количество информации

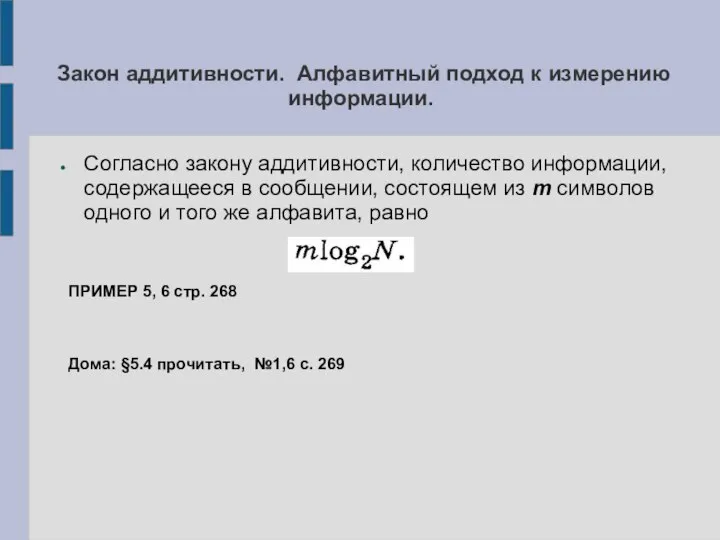

- 10. Закон аддитивности. Алфавитный подход к измерению информации. Согласно закону аддитивности, количество информации, содержащееся в сообщении, состоящем

- 11. Оптимальное кодирование информации и её сложность. Урок 7. ОСНОВЫ ТЕОРИИ ИНФОРМАЦИИ

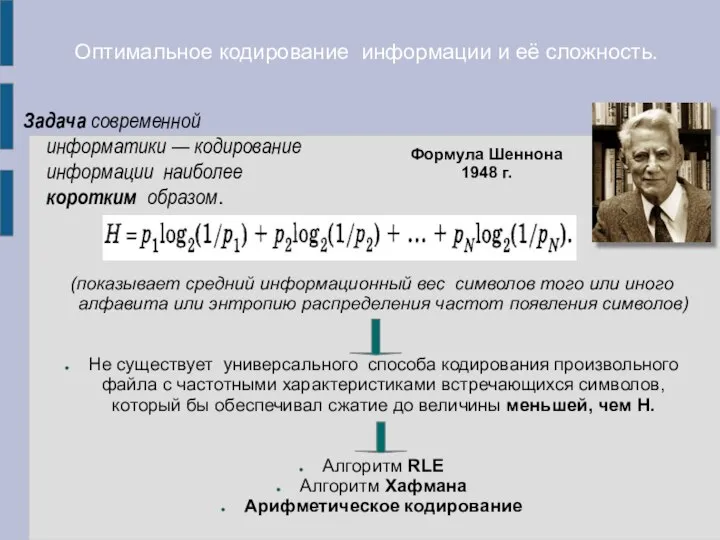

- 12. Оптимальное кодирование информации и её сложность. Задача современной информатики — кодирование информации наиболее коротким образом. (показывает

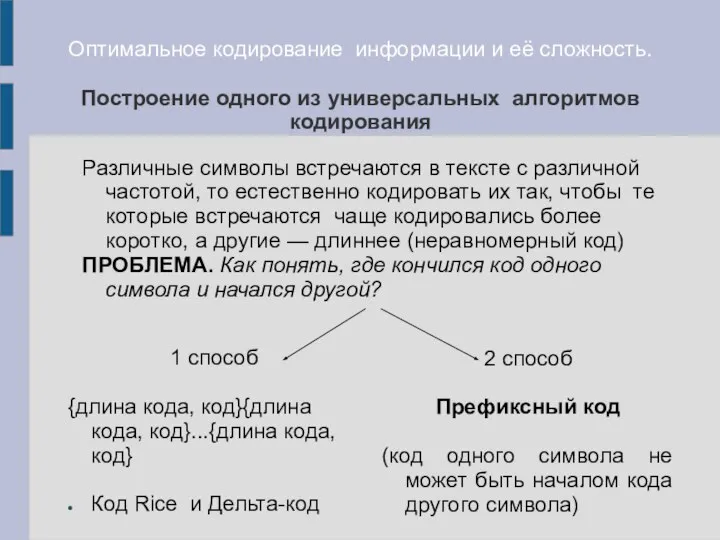

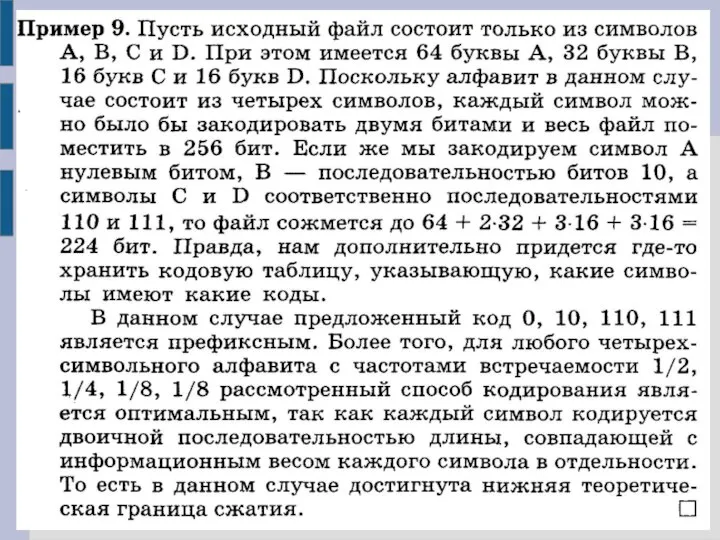

- 13. Оптимальное кодирование информации и её сложность. Построение одного из универсальных алгоритмов кодирования 1 способ {длина кода,

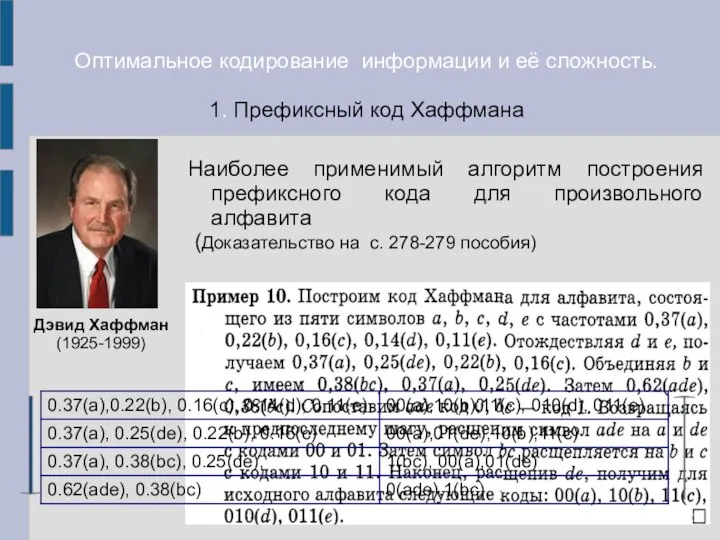

- 15. Оптимальное кодирование информации и её сложность. 1. Префиксный код Хаффмана Наиболее применимый алгоритм построения префиксного кода

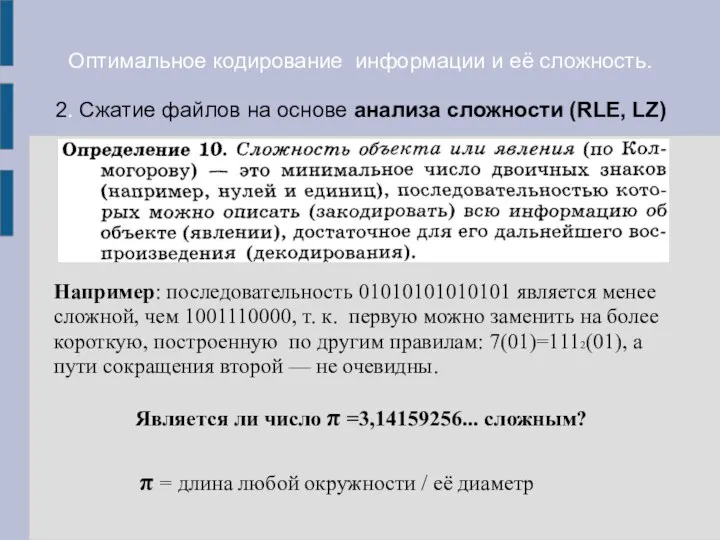

- 16. Оптимальное кодирование информации и её сложность. 2. Сжатие файлов на основе анализа сложности (RLE, LZ) Например:

- 18. Скачать презентацию

Способы записи алгоритмов. Основы алгоритмизации

Способы записи алгоритмов. Основы алгоритмизации Обработка изображений в системах управления. Методы восстановления изображений. Лекция 7

Обработка изображений в системах управления. Методы восстановления изображений. Лекция 7 Обслуживание операционной системы

Обслуживание операционной системы Современные модели качества программных продуктов

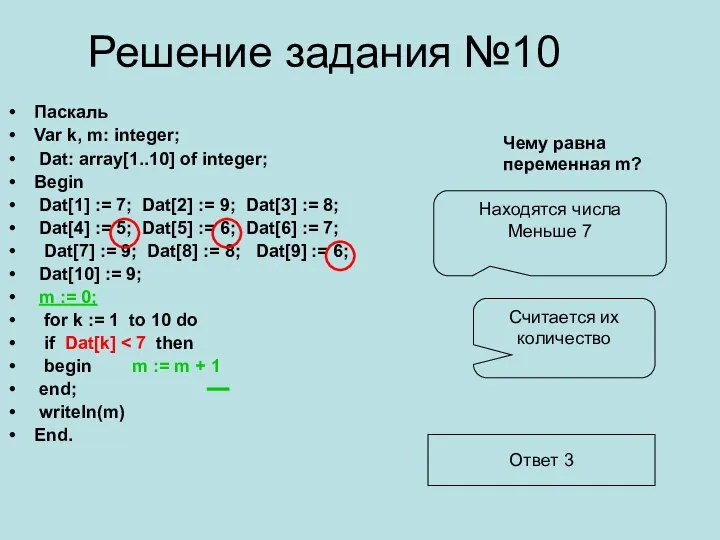

Современные модели качества программных продуктов Решение задания №10. Паскаль

Решение задания №10. Паскаль Формирование универсальных учебных действий через организацию метапредметных связей на уроках информатики

Формирование универсальных учебных действий через организацию метапредметных связей на уроках информатики Презентация "NetSchool" - скачать презентации по Информатике

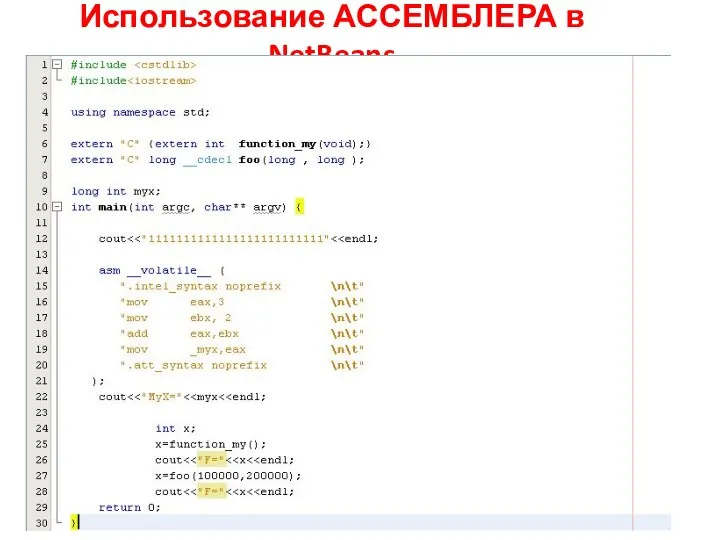

Презентация "NetSchool" - скачать презентации по Информатике Использование ассемблера в NetBeans

Использование ассемблера в NetBeans Циклы и графика. Lazarus

Циклы и графика. Lazarus Технология программирования на языке Python

Технология программирования на языке Python Викторина по информатике

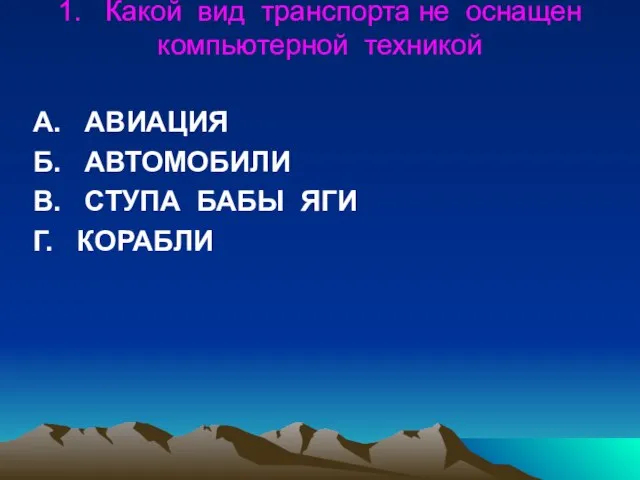

Викторина по информатике Профессиональное прикладное программное обеспечение логистической деятельности

Профессиональное прикладное программное обеспечение логистической деятельности Поиск информации в сети. Интернет

Поиск информации в сети. Интернет Использование и создание медиатекста

Использование и создание медиатекста Аттестационная работа: Фильм на тему Представление графической информации в компьютере

Аттестационная работа: Фильм на тему Представление графической информации в компьютере Разработка образовательного интернетпортала и создание мультимедийных учебных курсов для ИП Мирошниченко

Разработка образовательного интернетпортала и создание мультимедийных учебных курсов для ИП Мирошниченко Электронная почта

Электронная почта Файлы и файловые системы

Файлы и файловые системы Antivirus 441. Преимущества

Antivirus 441. Преимущества Технология программирования на языке Рython и разработка программ для машинного обучения (Лекция iv)

Технология программирования на языке Рython и разработка программ для машинного обучения (Лекция iv) Инструкция по настройке UMB

Инструкция по настройке UMB Інформаційні технології в освіті - виклик глобального інформаційного суспільства

Інформаційні технології в освіті - виклик глобального інформаційного суспільства Человек в виртуальном пространстве

Человек в виртуальном пространстве Работа с готовой электронной таблицей. Практическая работа №11. 8 класс

Работа с готовой электронной таблицей. Практическая работа №11. 8 класс Архив организации СПО

Архив организации СПО ESET NOD32 Antivirus

ESET NOD32 Antivirus ИТ-диктант - всероссийская образовательная акция по информационным технологиям

ИТ-диктант - всероссийская образовательная акция по информационным технологиям Область применения контрольно-кассовой техники

Область применения контрольно-кассовой техники