Содержание

- 2. 4.1. Машина (метод) опорных векторов (SVM, Support Vector Machine – Вапник В. и др. – 60-80

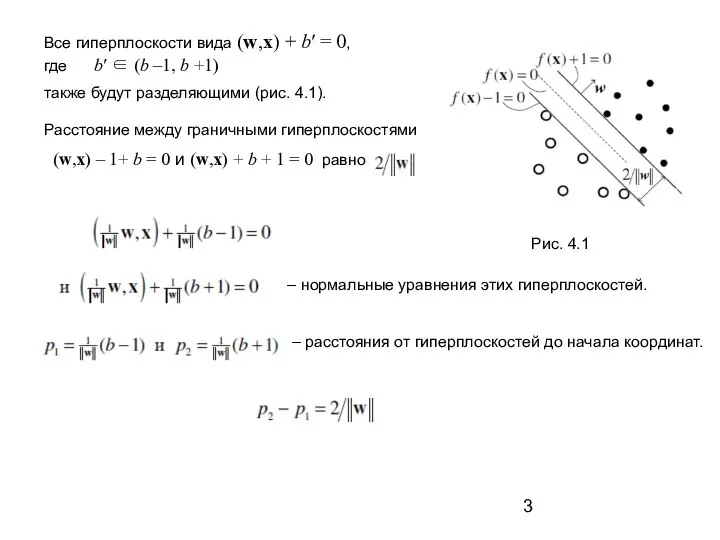

- 3. Все гиперплоскости вида (w,x) + b′ = 0, где b′ ∈ (b –1, b +1) также

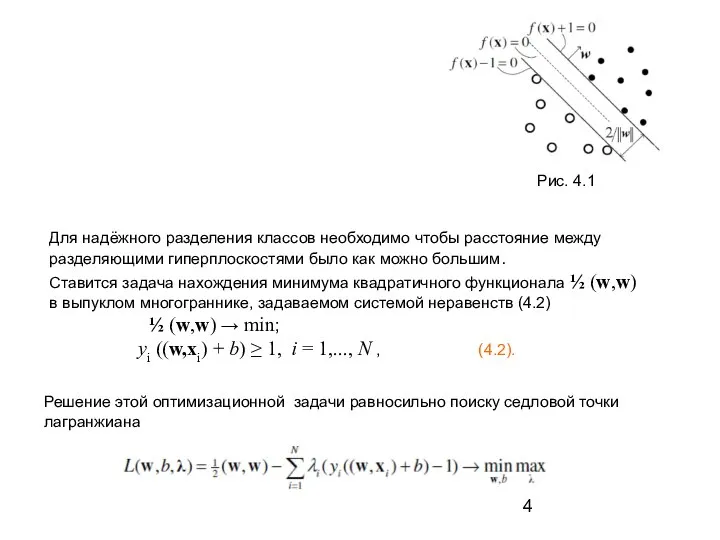

- 4. Рис. 4.1 Для надёжного разделения классов необходимо чтобы расстояние между разделяющими гиперплоскостями было как можно большим.

- 5. Свойства Метода опорных векторов: 1) это наиболее быстрый способ нахождения решающих функций; 2) метод сводится к

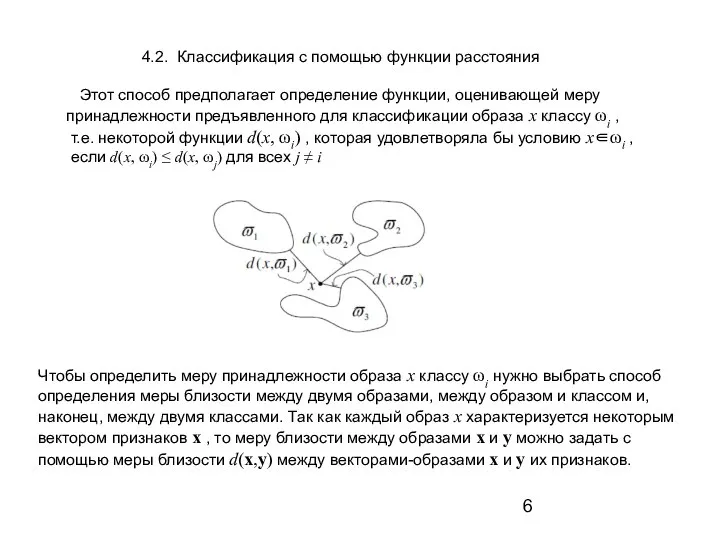

- 6. 4.2. Классификация с помощью функции расстояния Этот способ предполагает определение функции, оценивающей меру принадлежности предъявленного для

- 7. В качестве такой меры близости чаще всего используют метрику, т.е. такую неотрицательную функцию d : Rn

- 8. 2. Метод ближайшего соседа. В этом способе расстояние определяется в соответствии со следующим алгоритмом: а) Определяется

- 9. Предположим, что имеется множество прецедентов, т.е. обучающая выборка Ξ = {x1 ,..., xN} в пространстве признаков

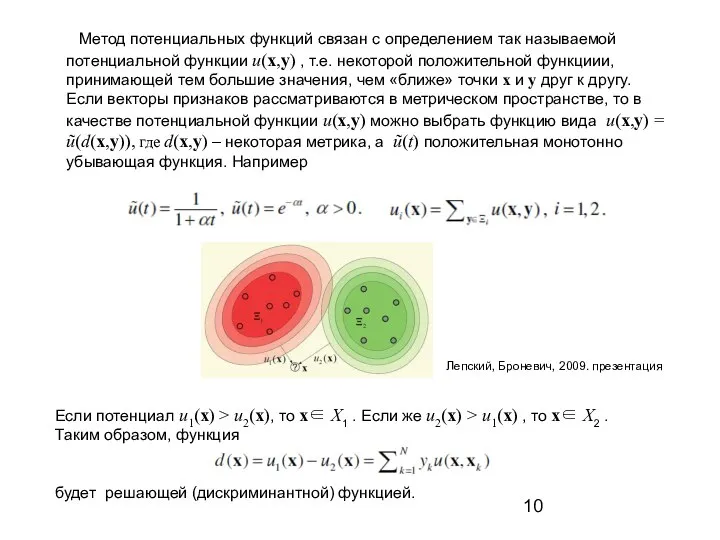

- 10. Метод потенциальных функций связан с определением так называемой потенциальной функции u(x,y) , т.е. некоторой положительной функциии,

- 11. Решающая функция может и не содержать всех слагаемых и будет иметь вид (1) где xj∈ Ξ

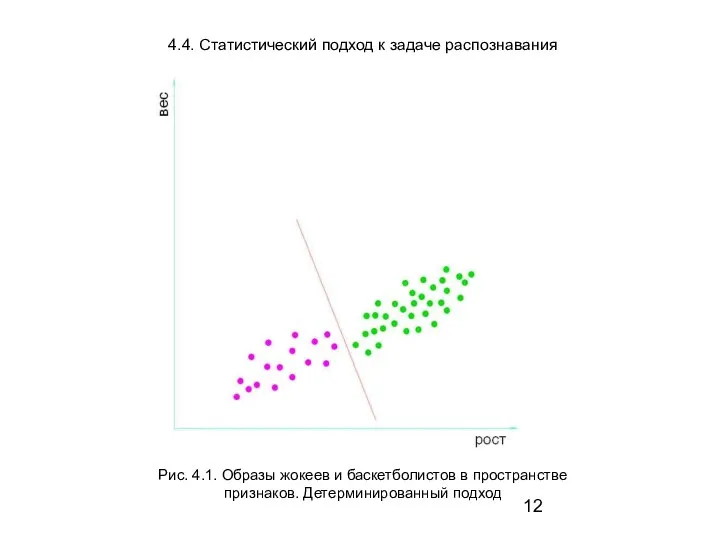

- 12. Рис. 4.1. Образы жокеев и баскетболистов в пространстве признаков. Детерминированный подход 4.4. Статистический подход к задаче

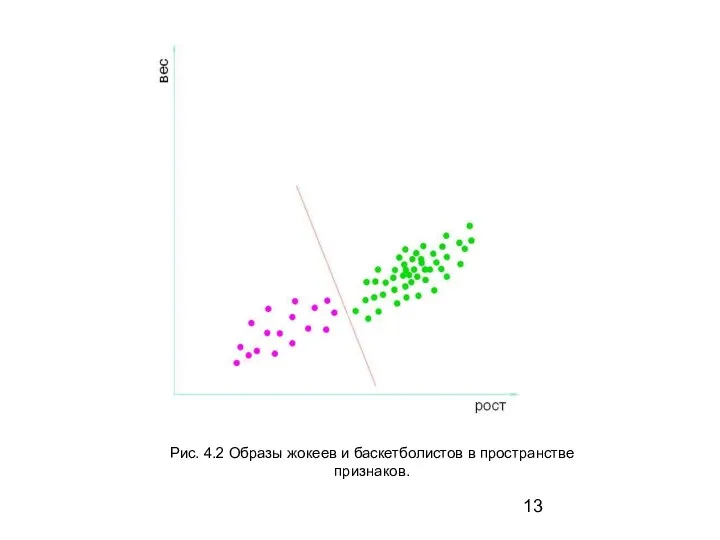

- 13. Рис. 4.2 Образы жокеев и баскетболистов в пространстве признаков.

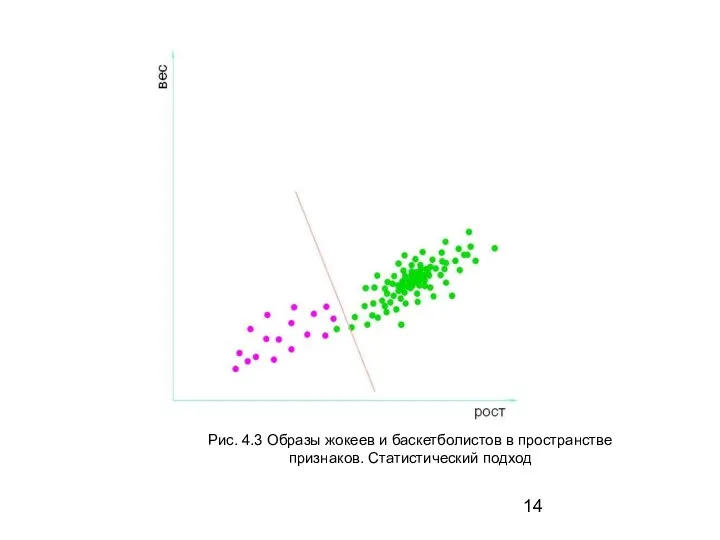

- 14. Рис. 4.3 Образы жокеев и баскетболистов в пространстве признаков. Статистический подход

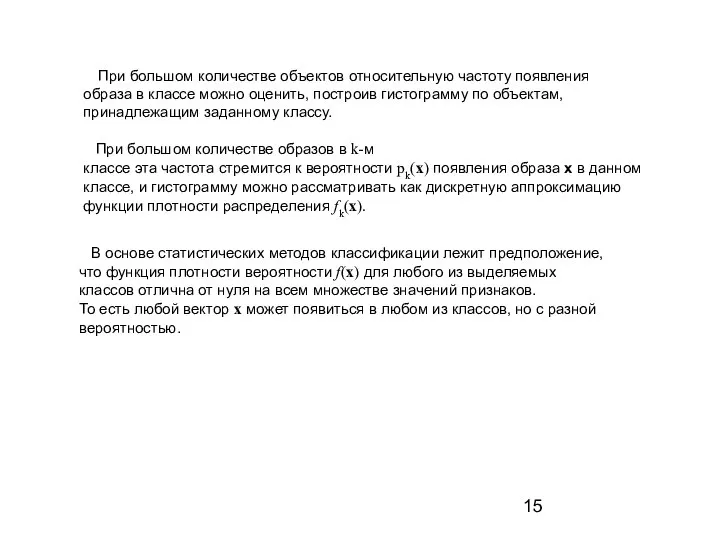

- 15. При большом количестве объектов относительную частоту появления образа в классе можно оценить, построив гистограмму по объектам,

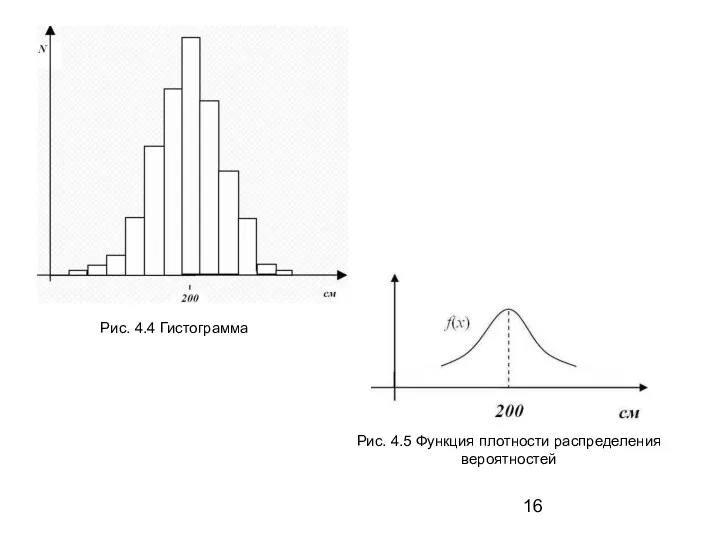

- 16. Рис. 4.4 Гистограмма Рис. 4.5 Функция плотности распределения вероятностей

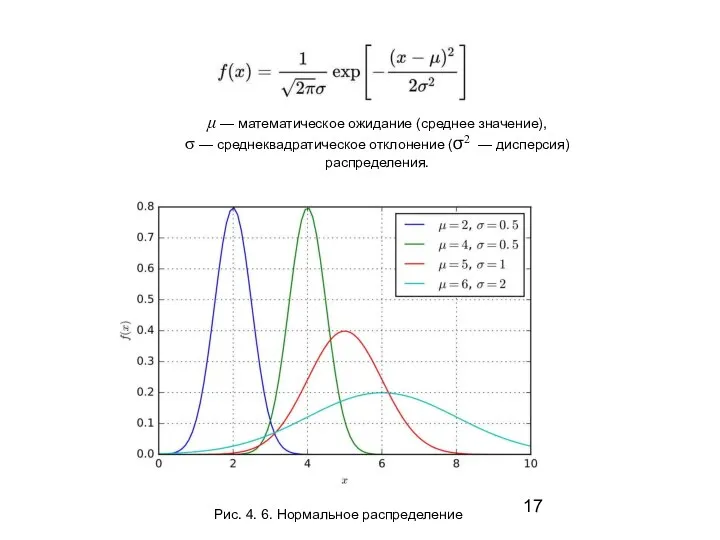

- 17. Рис. 4. 6. Нормальное распределение μ — математическое ожидание (среднее значение), σ — среднеквадратическое отклонение (σ2

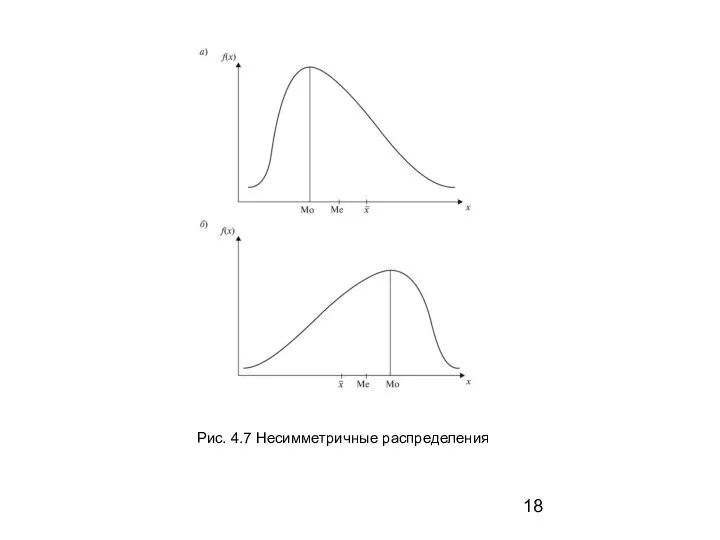

- 18. Рис. 4.7 Несимметричные распределения

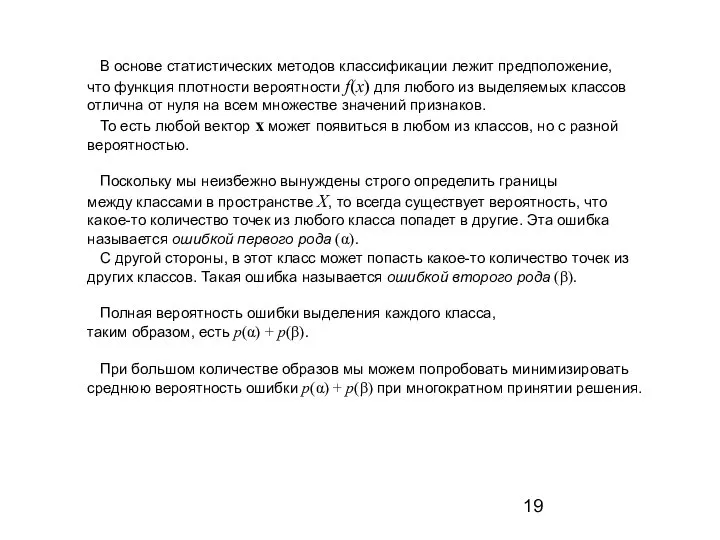

- 19. В основе статистических методов классификации лежит предположение, что функция плотности вероятности f(x) для любого из выделяемых

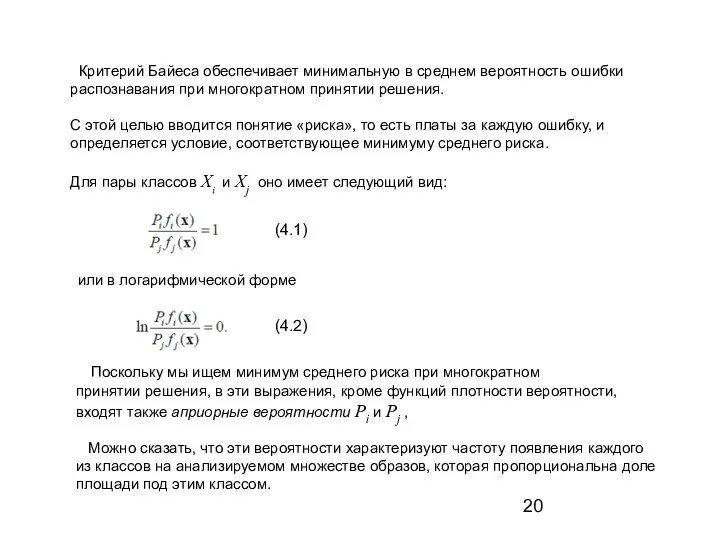

- 20. Критерий Байеса обеспечивает минимальную в среднем вероятность ошибки распознавания при многократном принятии решения. С этой целью

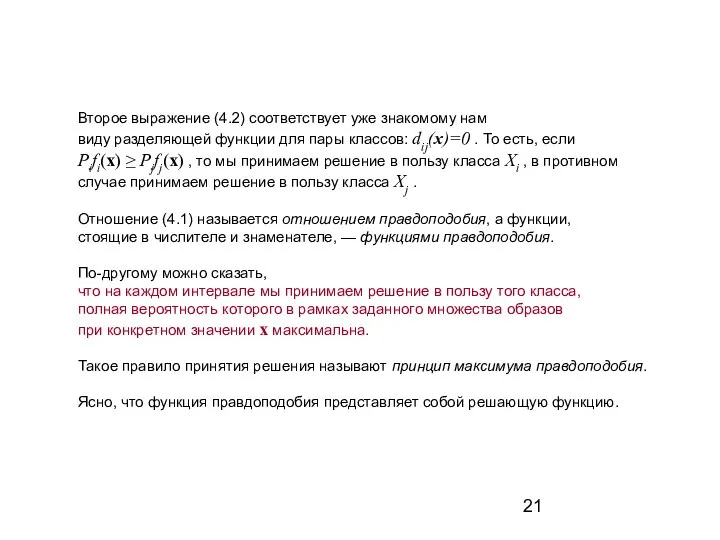

- 21. Второе выражение (4.2) соответствует уже знакомому нам виду разделяющей функции для пары классов: dij(x)=0 . То

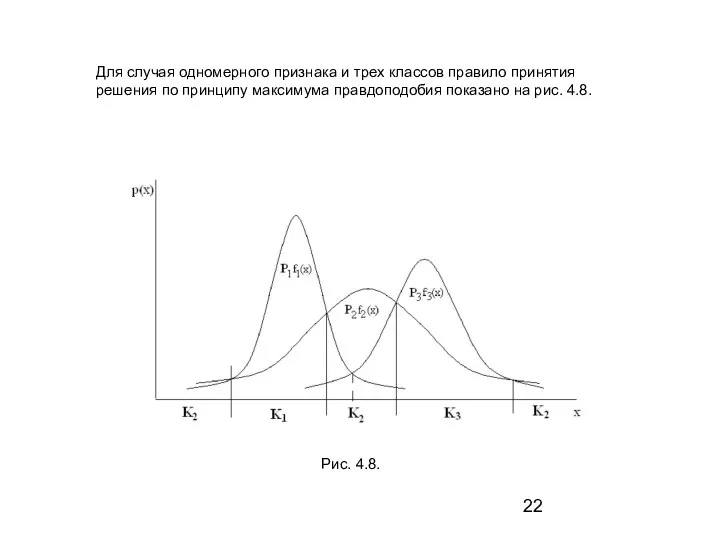

- 22. Для случая одномерного признака и трех классов правило принятия решения по принципу максимума правдоподобия показано на

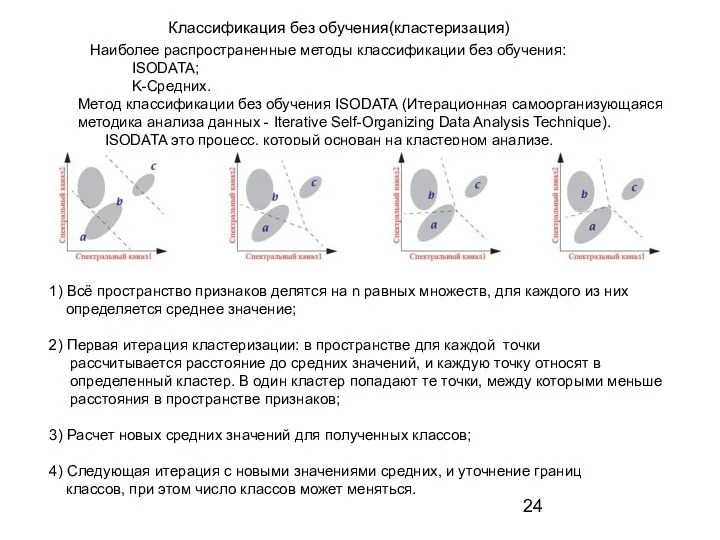

- 24. Наиболее распространенные методы классификации без обучения: ISODATA; K-Средних. Метод классификации без обучения ISODATA (Итерационная самоорганизующаяся методика

- 26. Скачать презентацию

Сайт коммерческой фирмы. Макет сайта

Сайт коммерческой фирмы. Макет сайта Разработка факсимильного шрифта на основе собственного почерка. Программы для создания собственного шрифта

Разработка факсимильного шрифта на основе собственного почерка. Программы для создания собственного шрифта Способы управления. Клавиатура и мышь

Способы управления. Клавиатура и мышь Библиотека конвертеров данных eCAD-КОМПАС

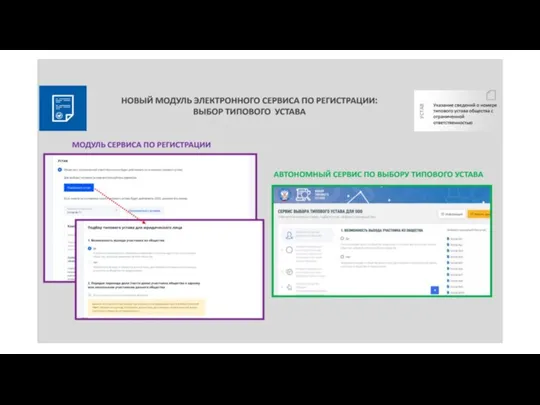

Библиотека конвертеров данных eCAD-КОМПАС Новый модуль электронного сервиса по регистрации: выбор типового устава

Новый модуль электронного сервиса по регистрации: выбор типового устава Разработка авторулевого для морских и речных судов

Разработка авторулевого для морских и речных судов Cети ЦВМ - системообразующий элемент сложных технических систем

Cети ЦВМ - системообразующий элемент сложных технических систем Нормализация баз данных

Нормализация баз данных Остросоциальные компьютерные игры

Остросоциальные компьютерные игры Создатели Viber

Создатели Viber Кибернетические системы. Лекция 3

Кибернетические системы. Лекция 3 Kurilka Gutenberga

Kurilka Gutenberga Мониторинг и статистика PS Core на основе Perfomance Report System (PRS)

Мониторинг и статистика PS Core на основе Perfomance Report System (PRS) Построение линейных базовых примитивов в AutoCAD

Построение линейных базовых примитивов в AutoCAD Конструирование информационного ресурса создание собственной альтернативной повестки

Конструирование информационного ресурса создание собственной альтернативной повестки Информационные носители

Информационные носители Изучение модели СМО с повторными заявками в Rockwell Arena

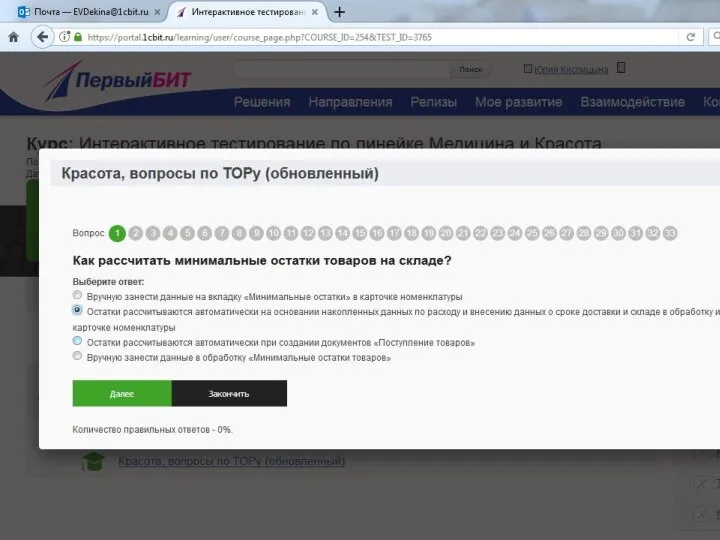

Изучение модели СМО с повторными заявками в Rockwell Arena Красота, вопросы по ТОРу. Правильные ответы

Красота, вопросы по ТОРу. Правильные ответы World Of Tanks. Мир танков

World Of Tanks. Мир танков JavaScript История развития

JavaScript История развития Проектирование системы сбора и корреляции событий информационной безопасности

Проектирование системы сбора и корреляции событий информационной безопасности Обчислювальні кластери в корпоративній мережі. Їх архітектура

Обчислювальні кластери в корпоративній мережі. Їх архітектура Кодирование информации

Кодирование информации Электронные таблицы

Электронные таблицы База данных Access

База данных Access Приложение Кошелёк: история борьбы с пластиком

Приложение Кошелёк: история борьбы с пластиком Информация и информационные процессы

Информация и информационные процессы Составление адреса URL из частей

Составление адреса URL из частей