Содержание

- 2. Глава 14: Оценочная и сравнительная классификация алгоритмов

- 3. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Введение

- 4. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Предпочтение

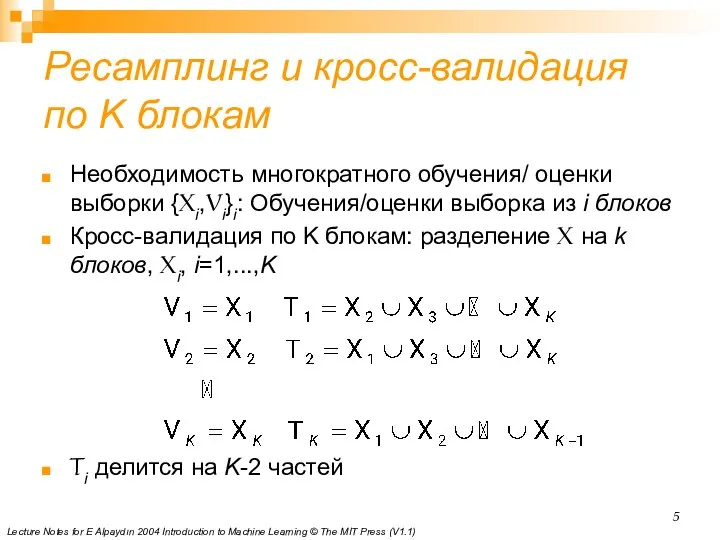

- 5. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Ресамплинг

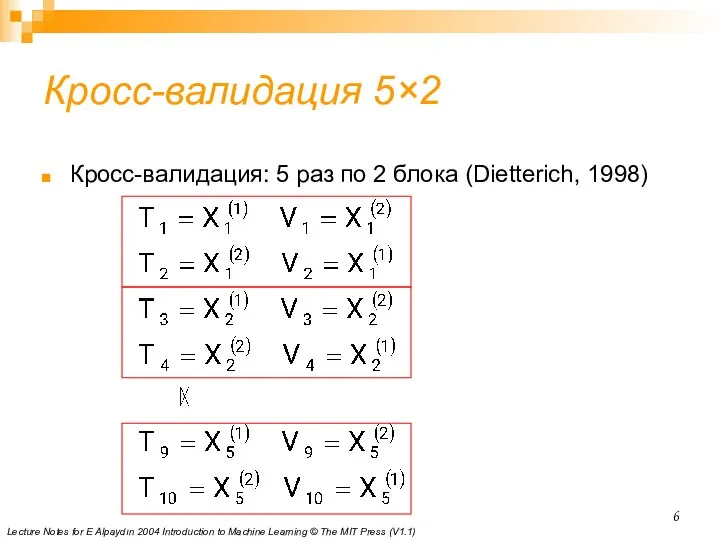

- 6. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Кросс-валидация

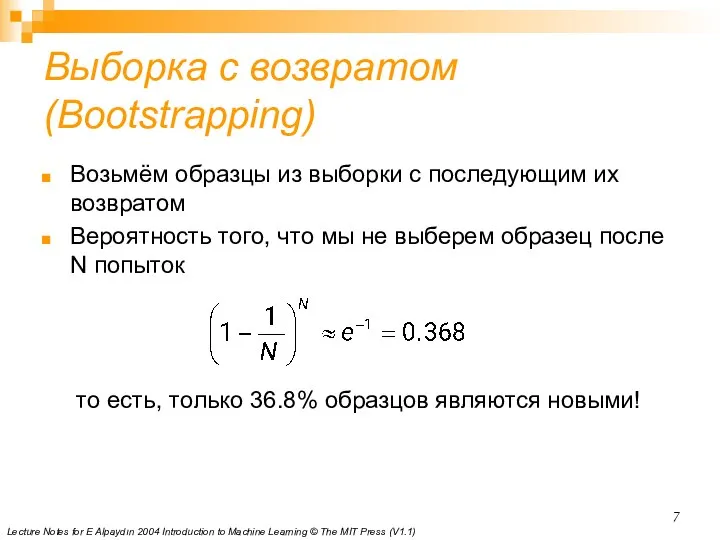

- 7. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Выборка

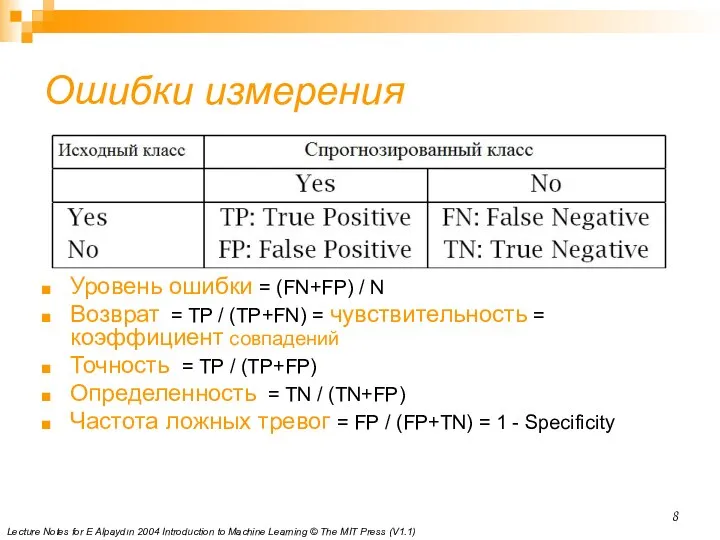

- 8. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Ошибки

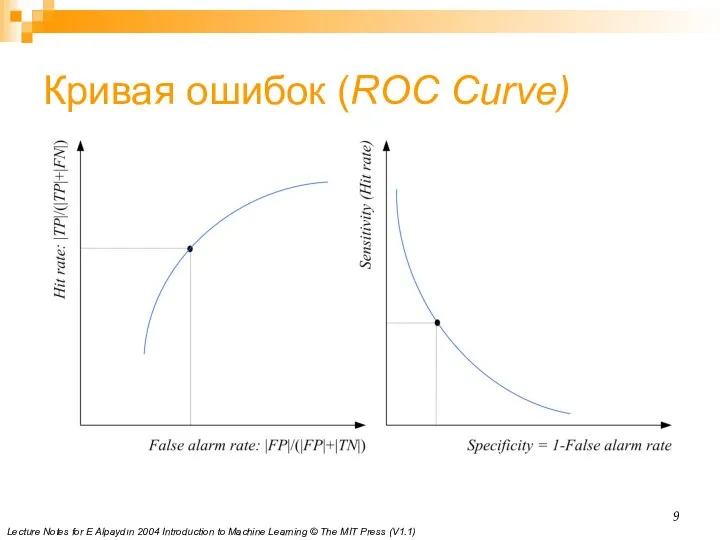

- 9. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Кривая

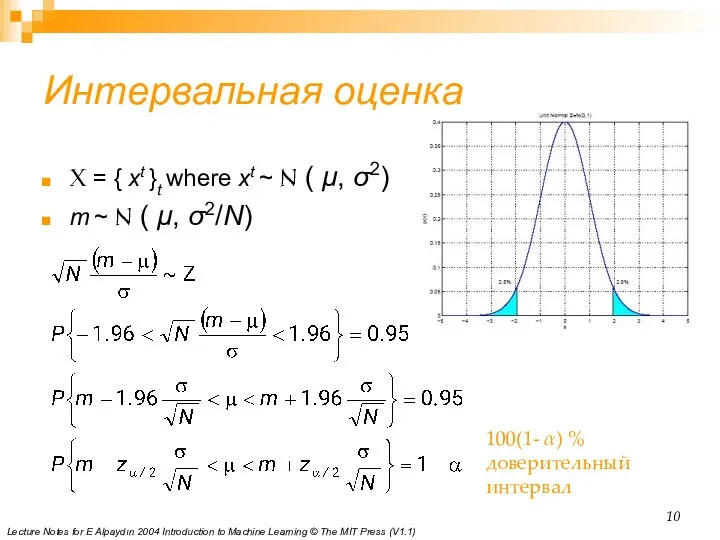

- 10. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Интервальная

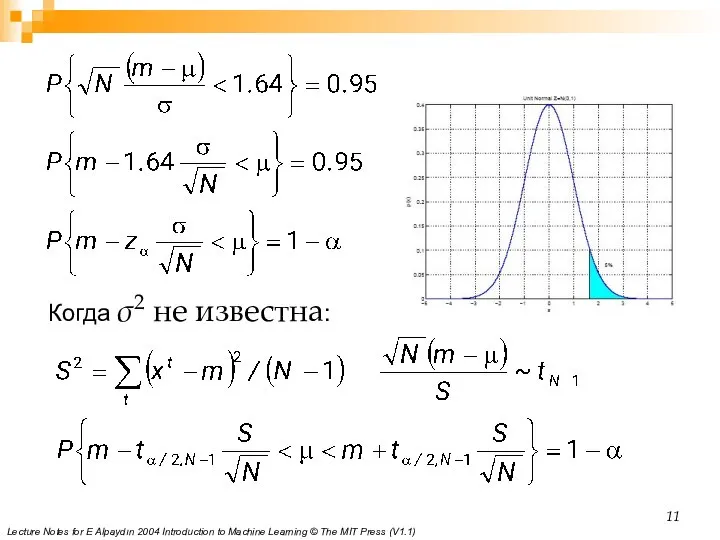

- 11. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Когда

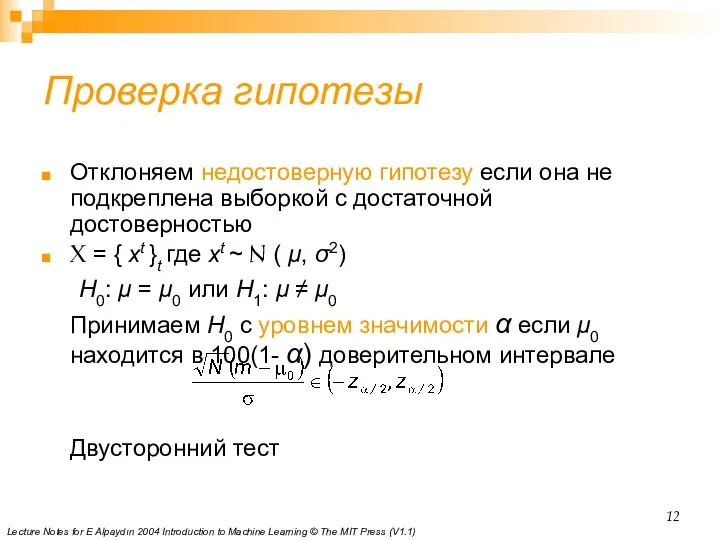

- 12. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Проверка

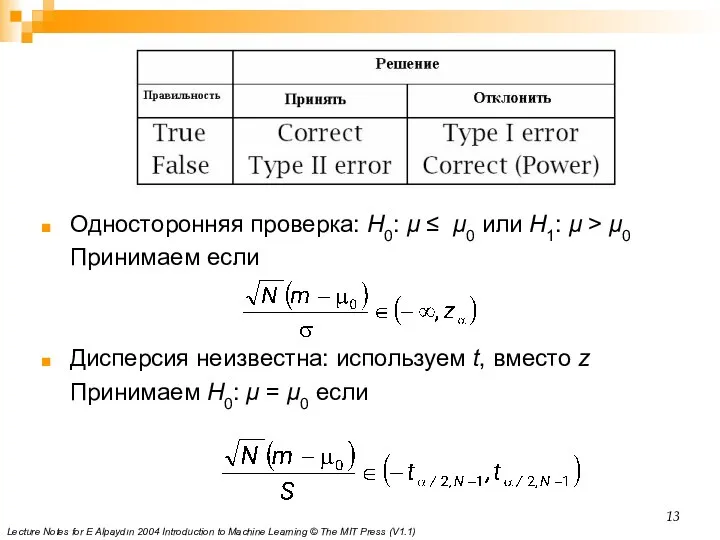

- 13. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Односторонняя

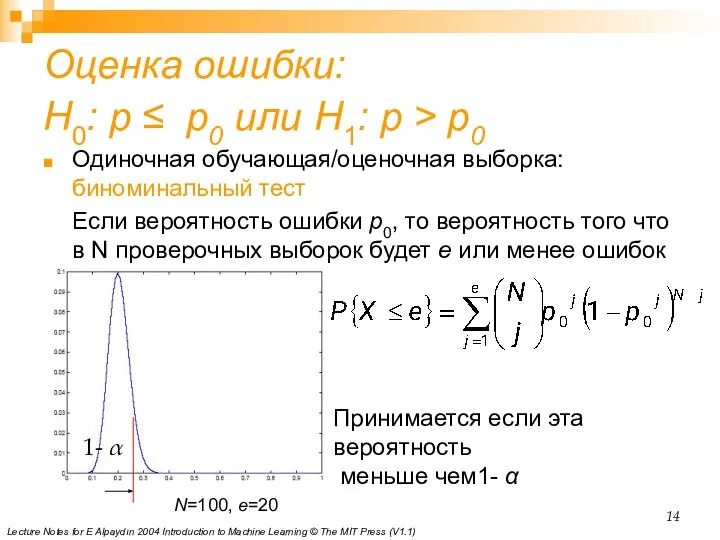

- 14. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Оценка

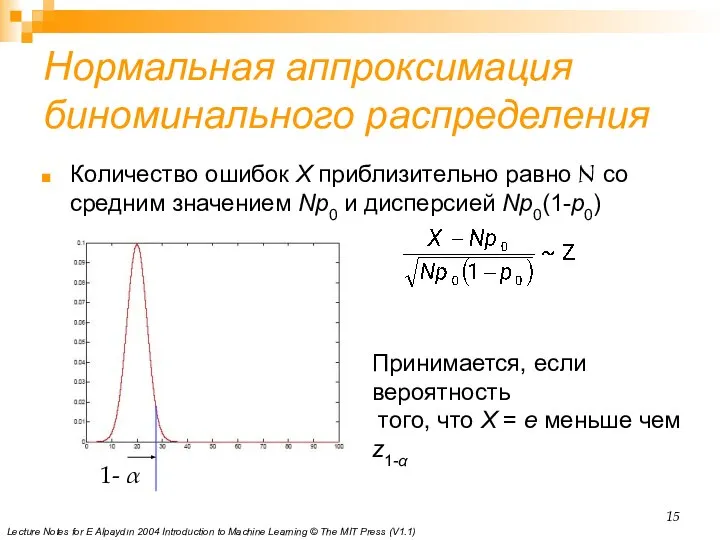

- 15. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Нормальная

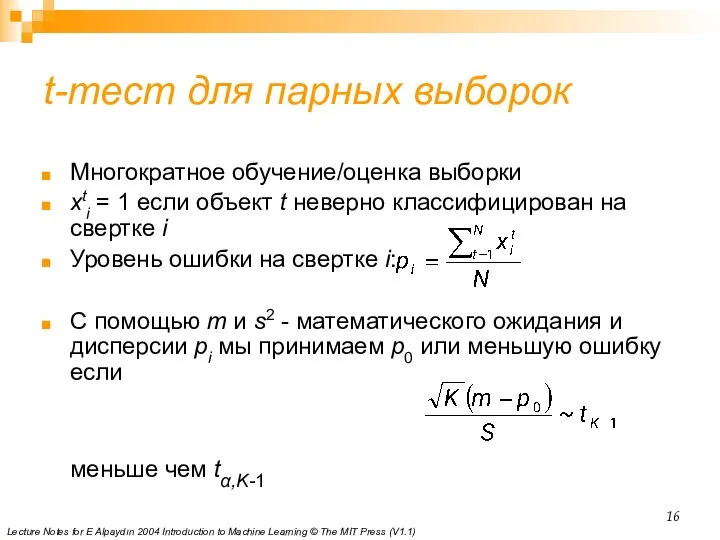

- 16. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) t-тест

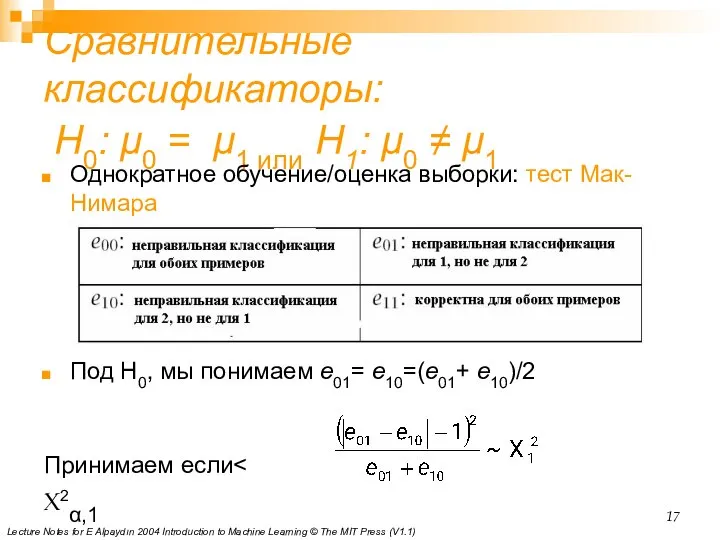

- 17. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Сравнительные

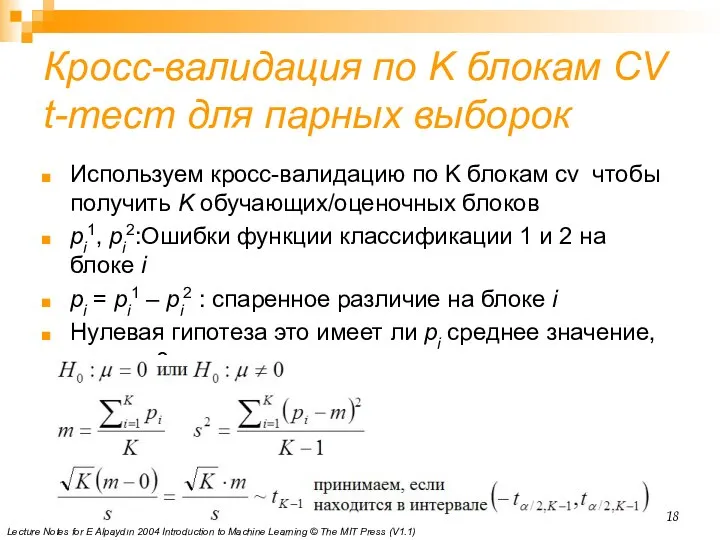

- 18. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Кросс-валидация

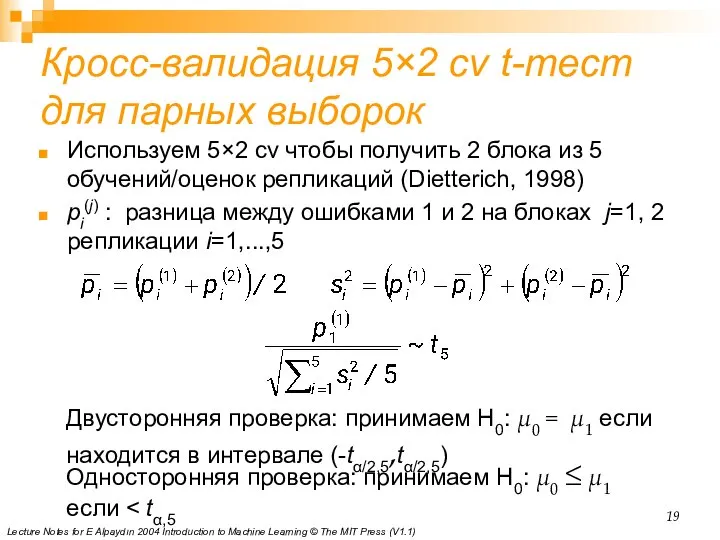

- 19. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Кросс-валидация

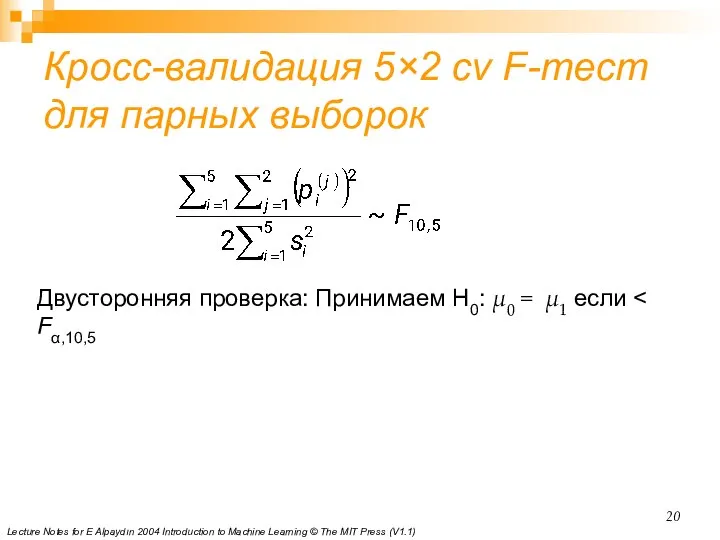

- 20. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Кросс-валидация

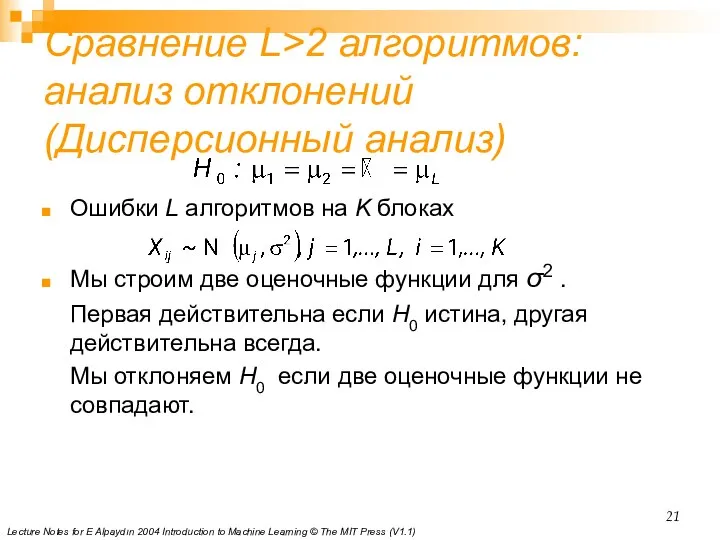

- 21. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1) Сравнение

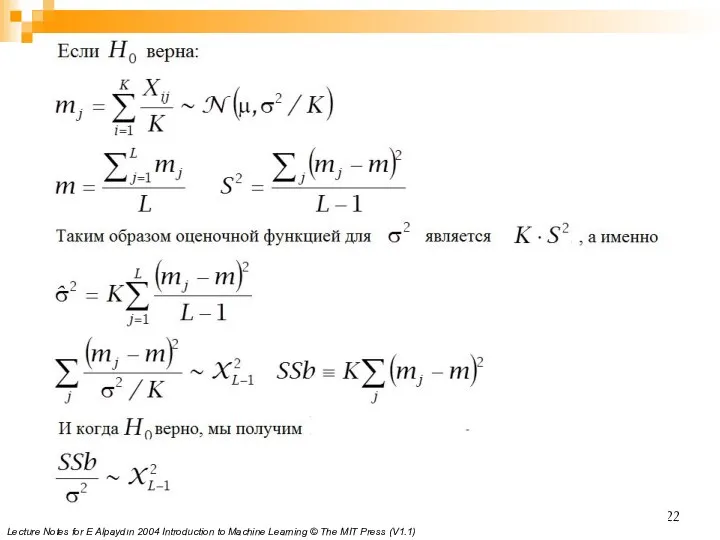

- 22. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1)

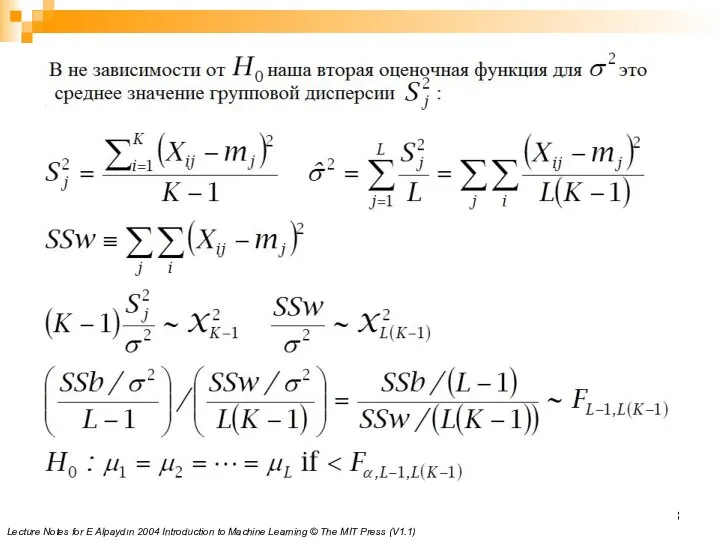

- 23. Lecture Notes for E Alpaydın 2004 Introduction to Machine Learning © The MIT Press (V1.1)

- 25. Скачать презентацию

Презентация на тему Методы решения неравенств с одной переменной

Презентация на тему Методы решения неравенств с одной переменной  Векторы в пространстве

Векторы в пространстве Математика и здоровый образ жизни

Математика и здоровый образ жизни Квадратные неравенства

Квадратные неравенства Крапки від 0 до 20

Крапки від 0 до 20 Тела вращения

Тела вращения Параллельные прямые и плоскости

Параллельные прямые и плоскости Взаимное расположение прямой и окружности (7 класс)

Взаимное расположение прямой и окружности (7 класс) Логика. Множества

Логика. Множества Площадь прямоугольника

Площадь прямоугольника Презентация на тему Сложение и вычитание трёхзначных чисел в столбик

Презентация на тему Сложение и вычитание трёхзначных чисел в столбик  VSM_mag_2-16

VSM_mag_2-16 Параллелограмм

Параллелограмм Плошадь многоугольников

Плошадь многоугольников Разминка для мозгов. Раунд 1

Разминка для мозгов. Раунд 1 КВМ: Здесь затеи и задачи

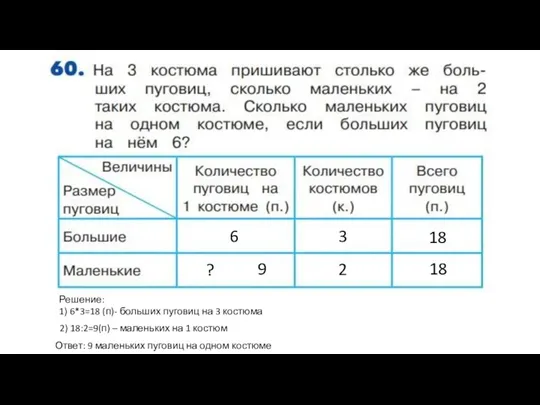

КВМ: Здесь затеи и задачи Задача о костюмах

Задача о костюмах Многогранники. Вершины, рёбра, грани многогранника. Развертка. Многогранные углы. Выпуклые многогранники. Теорема Эйлера

Многогранники. Вершины, рёбра, грани многогранника. Развертка. Многогранные углы. Выпуклые многогранники. Теорема Эйлера Вписанная окружность

Вписанная окружность Функция y = cosx её свойства и график

Функция y = cosx её свойства и график Сложение в столбик

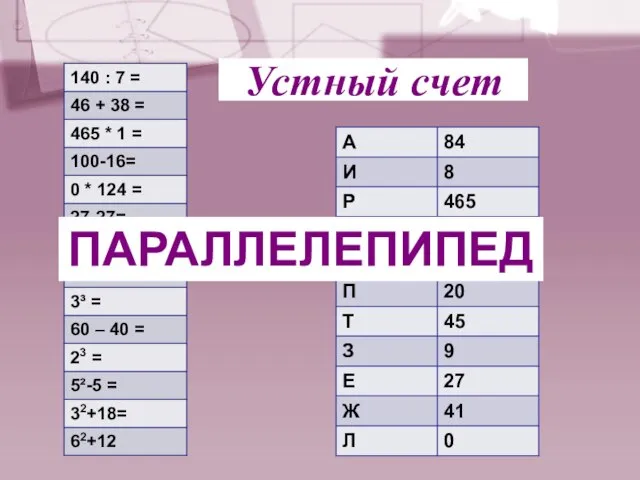

Сложение в столбик Презентация на тему Прямоугольный параллелепипед и его свойства

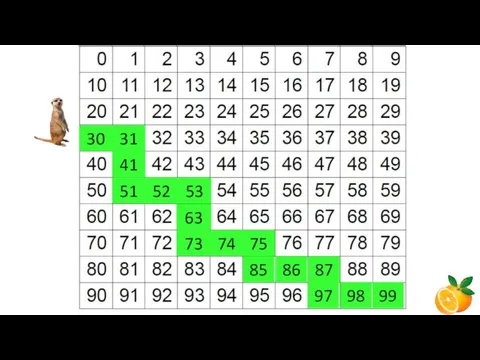

Презентация на тему Прямоугольный параллелепипед и его свойства  Цифры (дойти до апельсина)

Цифры (дойти до апельсина) Квадратные уравнения

Квадратные уравнения Единицы измерения времени

Единицы измерения времени Таблица умножения девяти. Тренажёр-раскраска

Таблица умножения девяти. Тренажёр-раскраска Презентация на тему Объем пирамиды

Презентация на тему Объем пирамиды  Учимся писать цифру 8

Учимся писать цифру 8