Содержание

- 2. 05.10.2006 СПбГУ ИТМО План доклада Основные определения Общая схема кластеризации Популярные алгоритмы Применения кластеризации

- 3. 05.10.2006 СПбГУ ИТМО Что такое кластеризация? Кластеризация – это автоматическое разбиение элементов некоторого множества (объекты, данные,

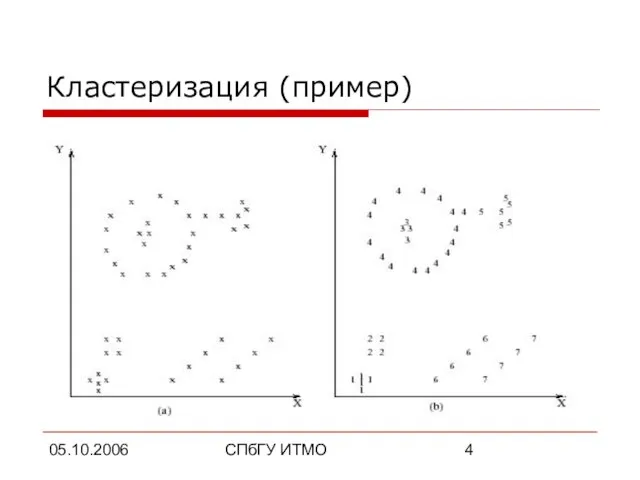

- 4. 05.10.2006 СПбГУ ИТМО Кластеризация (пример)

- 5. 05.10.2006 СПбГУ ИТМО Разница между кластеризацией и классификацией Кластеризация (unsupervised classification) разбивает множество объектов на группы,

- 6. 05.10.2006 СПбГУ ИТМО Зачем нужна кластеризация? Много практических применений в информатике и других областях: Анализ данных

- 7. 05.10.2006 СПбГУ ИТМО Формальные определения Вектор характеристик (объект) x – единица данных для алгоритма кластеризации. Обычно

- 8. 05.10.2006 СПбГУ ИТМО Формальные определения (продолжение) Множество объектов X = {x1, …, xn} – набор входных

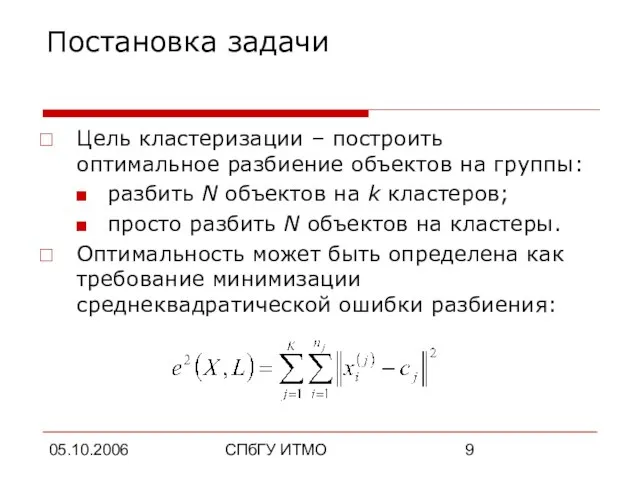

- 9. 05.10.2006 СПбГУ ИТМО Постановка задачи Цель кластеризации – построить оптимальное разбиение объектов на группы: разбить N

- 10. 05.10.2006 СПбГУ ИТМО План доклада Основные определения Общая схема кластеризации Популярные алгоритмы Применения кластеризации

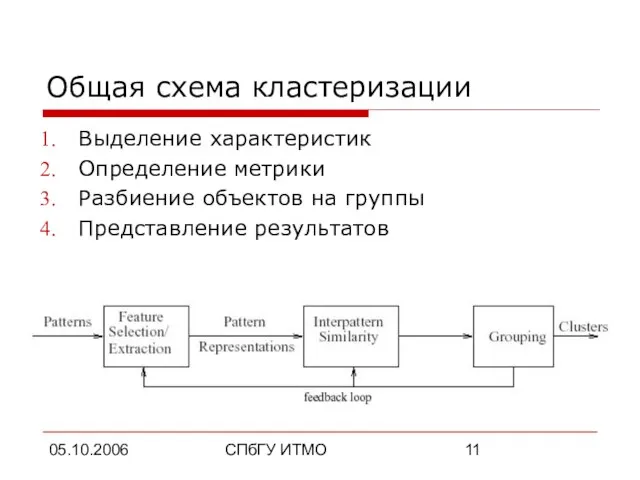

- 11. 05.10.2006 СПбГУ ИТМО Общая схема кластеризации Выделение характеристик Определение метрики Разбиение объектов на группы Представление результатов

- 12. 05.10.2006 СПбГУ ИТМО Выделение характеристик Выбор свойств, характеризующих объекты: количественные характеристики (координаты, интервалы…); качественные характеристики (цвет,

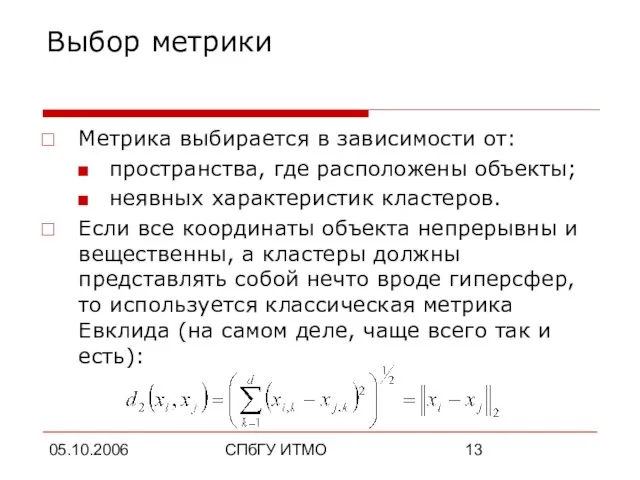

- 13. 05.10.2006 СПбГУ ИТМО Выбор метрики Метрика выбирается в зависимости от: пространства, где расположены объекты; неявных характеристик

- 14. 05.10.2006 СПбГУ ИТМО План доклада Основные определения Общая схема кластеризации Популярные алгоритмы Применения кластеризации

- 15. 05.10.2006 СПбГУ ИТМО Алгоритмы кластеризации Иерархические алгоритмы Минимальное покрывающее дерево k-Means алгоритм (алгоритм k-средних) Метод ближайшего

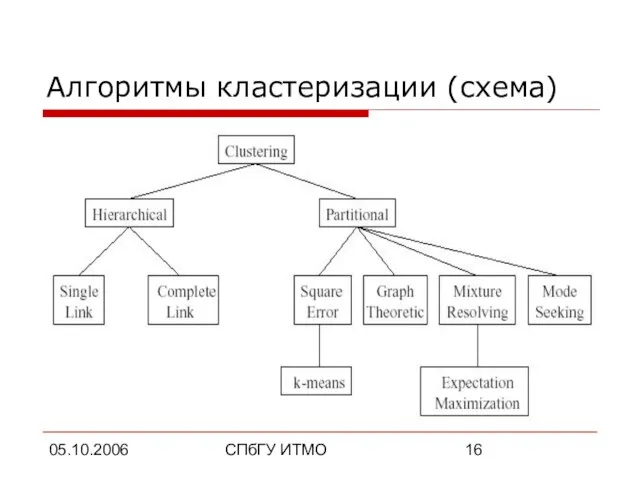

- 16. 05.10.2006 СПбГУ ИТМО Алгоритмы кластеризации (схема)

- 17. 05.10.2006 СПбГУ ИТМО Классификация алгоритмов Строящие «снизу-вверх» и «сверху-вниз» Монотетические и политетические Непересекающиеся и нечеткие Детерминированные

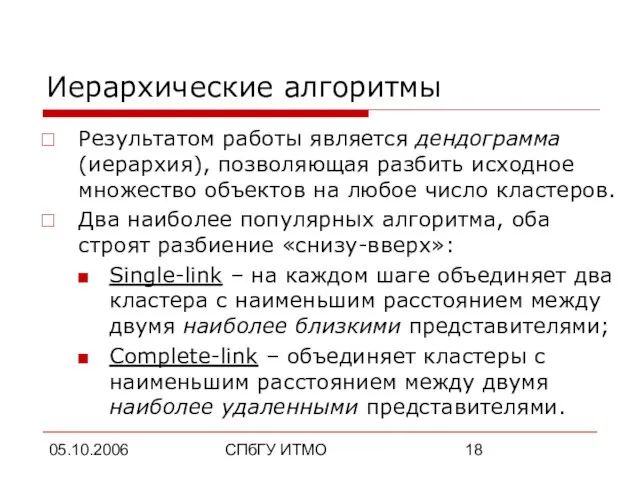

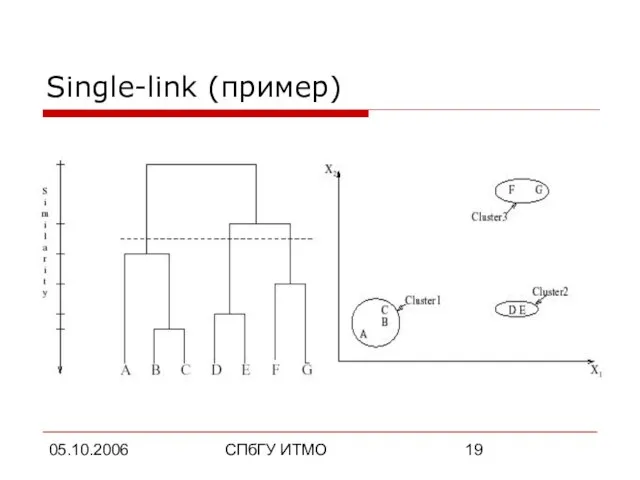

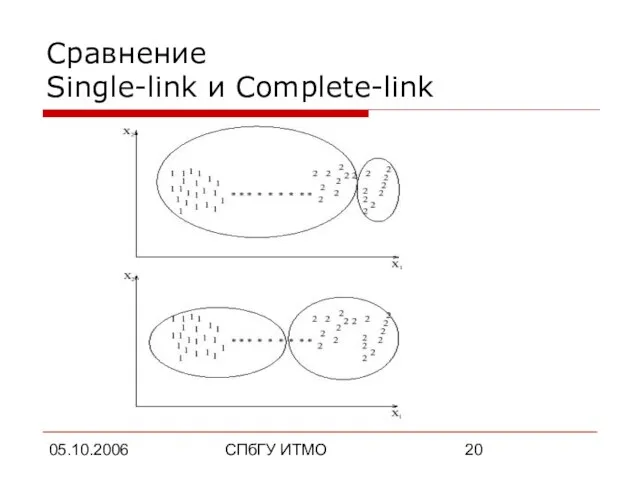

- 18. 05.10.2006 СПбГУ ИТМО Иерархические алгоритмы Результатом работы является дендограмма (иерархия), позволяющая разбить исходное множество объектов на

- 19. 05.10.2006 СПбГУ ИТМО Single-link (пример)

- 20. 05.10.2006 СПбГУ ИТМО Сравнение Single-link и Complete-link

- 21. 05.10.2006 СПбГУ ИТМО Минимальное покрывающее дерево Позволяет производить иерархическую кластеризацию «сверху-вниз»:

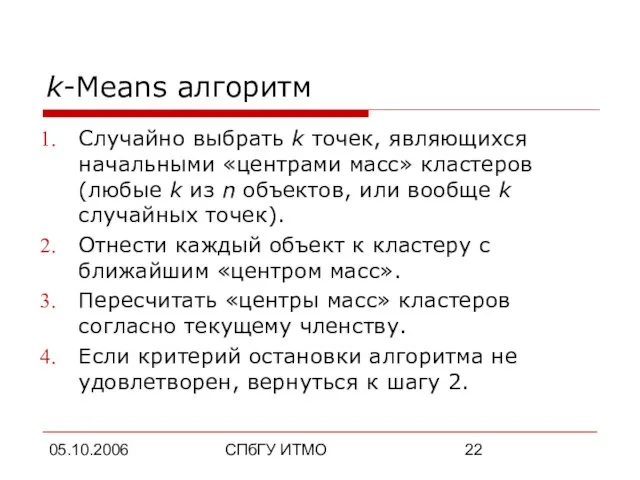

- 22. 05.10.2006 СПбГУ ИТМО k-Means алгоритм Случайно выбрать k точек, являющихся начальными «центрами масс» кластеров (любые k

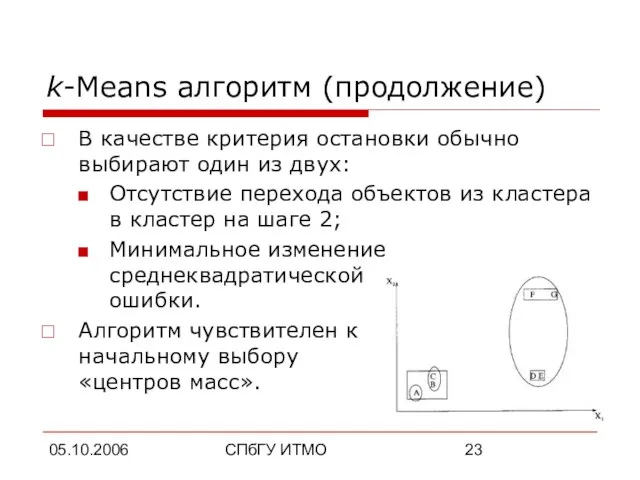

- 23. 05.10.2006 СПбГУ ИТМО k-Means алгоритм (продолжение) В качестве критерия остановки обычно выбирают один из двух: Отсутствие

- 24. 05.10.2006 СПбГУ ИТМО Метод ближайшего соседа Один из старейших (1978), простейших и наименее оптимальных алгоритмов: Пока

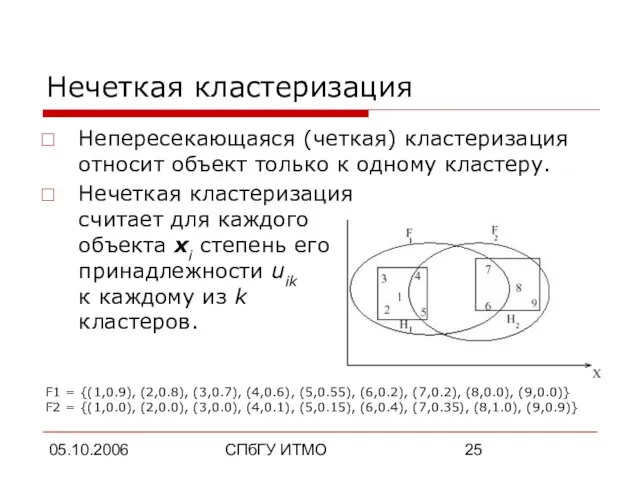

- 25. 05.10.2006 СПбГУ ИТМО Нечеткая кластеризация Непересекающаяся (четкая) кластеризация относит объект только к одному кластеру. Нечеткая кластеризация

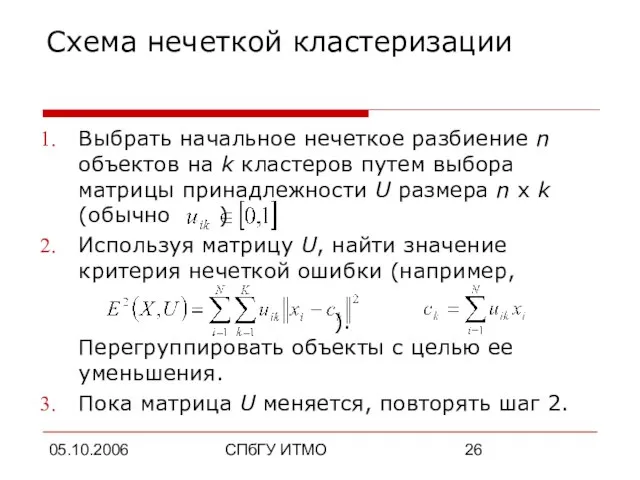

- 26. 05.10.2006 СПбГУ ИТМО Схема нечеткой кластеризации Выбрать начальное нечеткое разбиение n объектов на k кластеров путем

- 27. 05.10.2006 СПбГУ ИТМО Применение нейронных сетей Искусственные нейронные сети (ИНС) легко работают в распределенных системах в

- 28. 05.10.2006 СПбГУ ИТМО Генетические алгоритмы Выбрать начальную случайную популяцию для множества решений. Получить оценку качества для

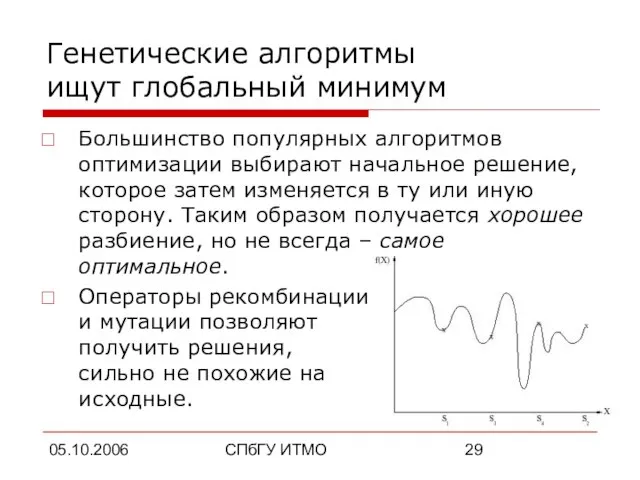

- 29. 05.10.2006 СПбГУ ИТМО Генетические алгоритмы ищут глобальный минимум Большинство популярных алгоритмов оптимизации выбирают начальное решение, которое

- 30. 05.10.2006 СПбГУ ИТМО Метод закалки Пытается найти глобальный оптимум, однако работает только с одним текущим решением.

- 31. 05.10.2006 СПбГУ ИТМО Какой алгоритм выбрать? Генетические алгоритмы и искусственные нейронные сети хорошо распараллеливаются. Генетические алгоритмы

- 32. 05.10.2006 СПбГУ ИТМО Какой алгоритм выбрать? (продолжение) k-Means быстро работает и прост в реализации, но создает

- 33. 05.10.2006 СПбГУ ИТМО Априорное использование природы кластеров в алгоритмах Неявное использование: выбор соответствующих характеристик объектов из

- 34. 05.10.2006 СПбГУ ИТМО Кластеризация больших объемов данных Обычно используют k-Means или его гибридные модификации. Если множество

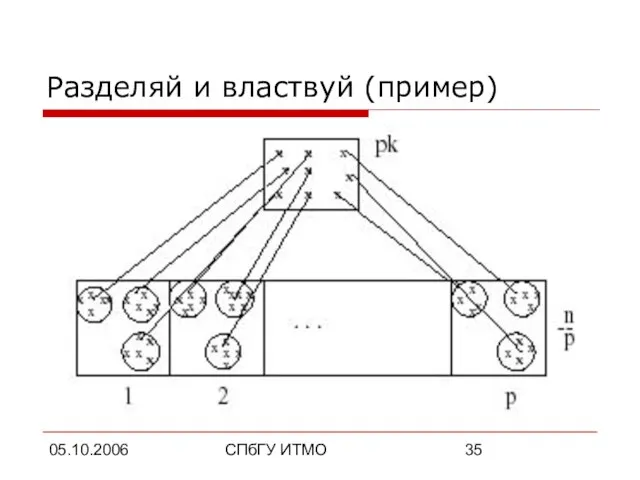

- 35. 05.10.2006 СПбГУ ИТМО Разделяй и властвуй (пример)

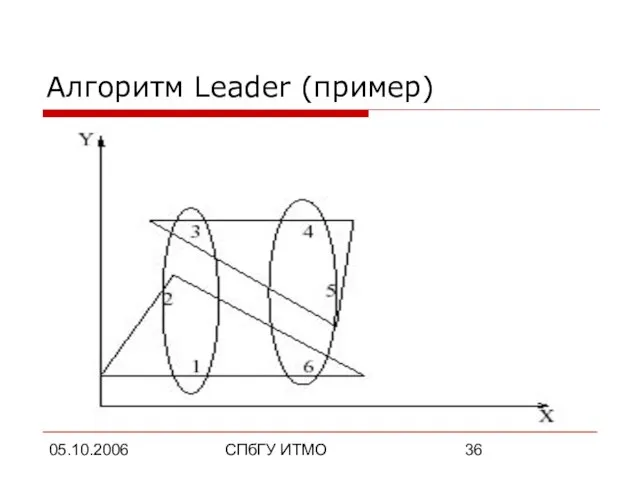

- 36. 05.10.2006 СПбГУ ИТМО Алгоритм Leader (пример)

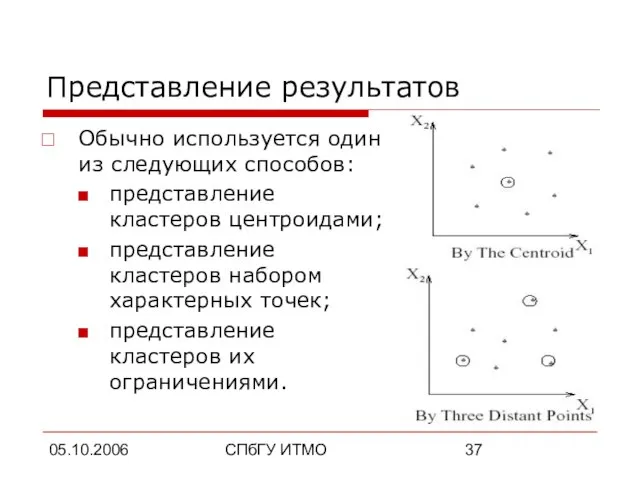

- 37. 05.10.2006 СПбГУ ИТМО Представление результатов Обычно используется один из следующих способов: представление кластеров центроидами; представление кластеров

- 38. 05.10.2006 СПбГУ ИТМО План доклада Основные определения Общая схема кластеризации Популярные алгоритмы Применения кластеризации

- 39. 05.10.2006 СПбГУ ИТМО Применения кластеризации Анализ данных (Data mining) Упрощение работы с информацией Визуализация данных Группировка

- 40. 05.10.2006 СПбГУ ИТМО Анализ данных (Data mining) Упрощение работы с информацией: достаточно работать только с k

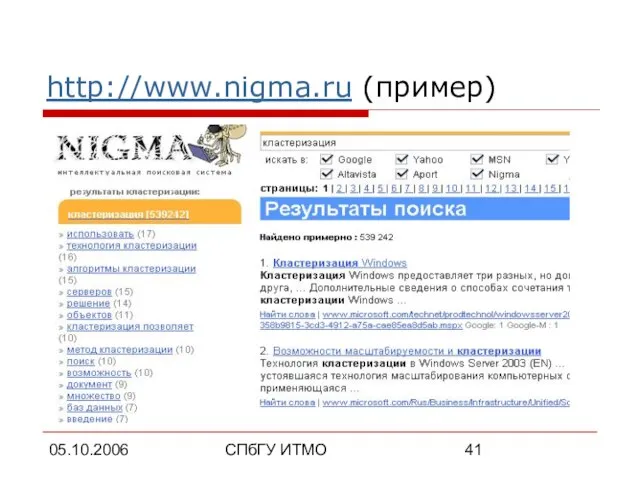

- 41. 05.10.2006 СПбГУ ИТМО http://www.nigma.ru (пример)

- 42. 05.10.2006 СПбГУ ИТМО Группировка и распознавание объектов Распознавание образов (OCR и др.): построение кластеров на основе

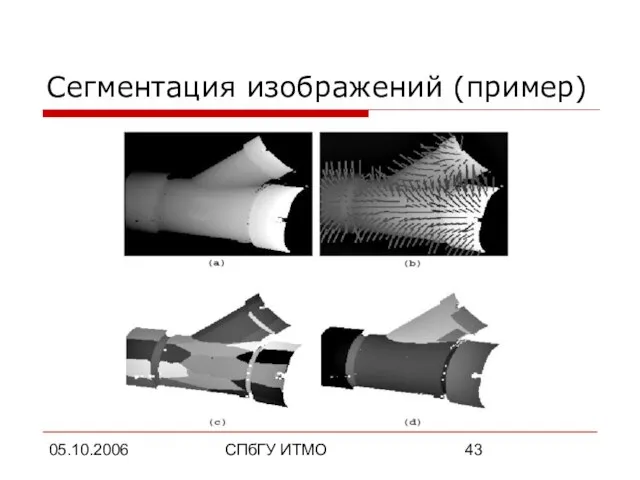

- 43. 05.10.2006 СПбГУ ИТМО Сегментация изображений (пример)

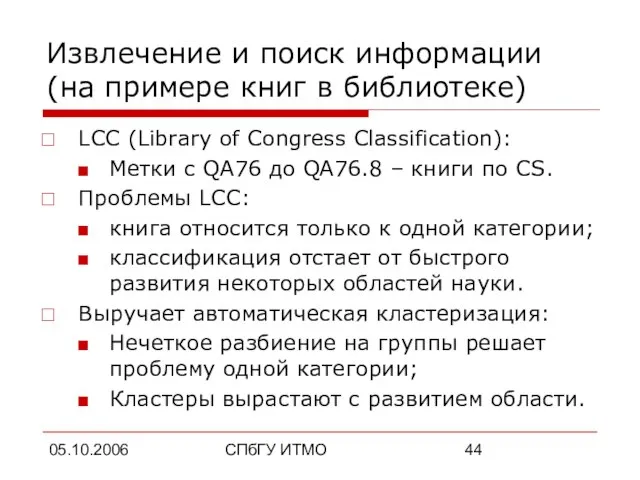

- 44. 05.10.2006 СПбГУ ИТМО Извлечение и поиск информации (на примере книг в библиотеке) LCC (Library of Congress

- 45. 05.10.2006 СПбГУ ИТМО Итого Кластеризация – это автоматическое разбиение множества объектов на группы по принципу схожести

- 47. Скачать презентацию

Из книжной сокровищницы Древней Руси

Из книжной сокровищницы Древней Руси Ур 5 (1)

Ур 5 (1) Искусство Европы рубежа 19-20 веков

Искусство Европы рубежа 19-20 веков Орнаментальные мотивы в художественном текстиле Индии. Часть 1

Орнаментальные мотивы в художественном текстиле Индии. Часть 1 Самоподготовка в школе полного дня

Самоподготовка в школе полного дня Мероприятия по ликвидации мест концентрации ДТП. Проект №3

Мероприятия по ликвидации мест концентрации ДТП. Проект №3 Федор Петрович Толстой (1783-1873). Натюрморт

Федор Петрович Толстой (1783-1873). Натюрморт Презентация без названия

Презентация без названия Полимеразная цепная реакция(ПЦР)

Полимеразная цепная реакция(ПЦР) Документознавство

Документознавство Рынок капитала

Рынок капитала Вкусный воскресный завтрак

Вкусный воскресный завтрак Несколько значений глаголов

Несколько значений глаголов Презентация на тему Три поросенка

Презентация на тему Три поросенка  Снайперские винтовки

Снайперские винтовки Презентация на тему Кошки

Презентация на тему Кошки Балансир Герасимова

Балансир Герасимова Кот-д’Ивуар

Кот-д’Ивуар Защита банковских карт

Защита банковских карт 656049, Алтайский край, г. Барнаул, ул. Ядринцева, 76 ?(385-2) 383684 @ sс

656049, Алтайский край, г. Барнаул, ул. Ядринцева, 76 ?(385-2) 383684 @ sс Презентация на тему: Внешнеэкономические связи ведущих развитых стран

Презентация на тему: Внешнеэкономические связи ведущих развитых стран Классы и объекты в Java

Классы и объекты в Java Технические открытия на рубеже XV-XVI вв

Технические открытия на рубеже XV-XVI вв Семя и проросток

Семя и проросток Сельское хозяйство России. Земледелие

Сельское хозяйство России. Земледелие Интергация детских деятельностей

Интергация детских деятельностей День биологического разнообразия

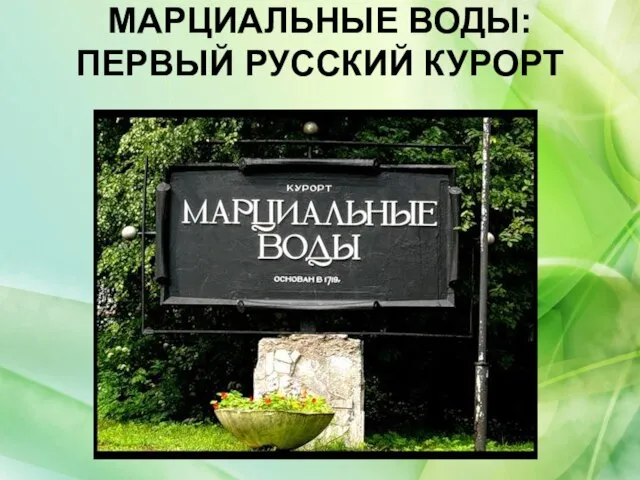

День биологического разнообразия Марциальные воды: первый русский курорт

Марциальные воды: первый русский курорт