Содержание

- 2. Рекомендуемая литература Ермолаев-Томин, О.Ю Математические методы в психологии. – М., 2013. – 511 с. Кутейников, А.Н.

- 3. Тема 1. Измерение в психологии История возникновения Предмет и назначение дисциплины Измерение в психологии. Взаимоотношение параметров,

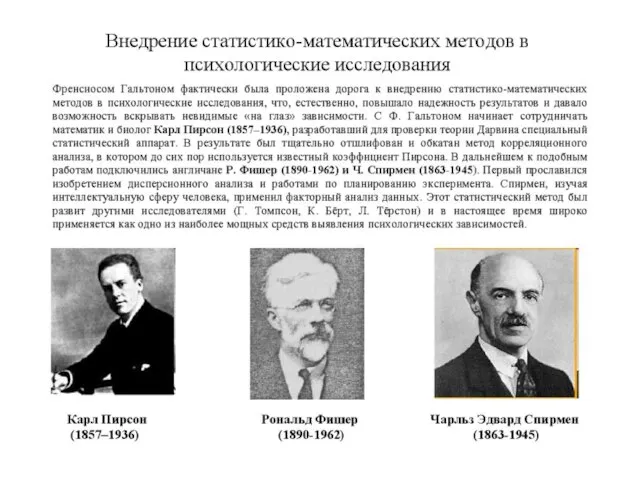

- 4. В первой четверти XIX в. философ И.Ф. Гербарт (1776-1841) провозгласил психологию наукой, которая должна основываться на

- 7. (William Sealy Gosset, 13 июня 1876, Кентербери — 16 октября 1937, Беконсфильд) — известный учёный-статистик, более

- 8. Определение статистики и связь с психологией и математикой Термин «статистика» имеет несколько значений: ∙ это совокупность

- 9. Слово «статистика» часто ассоциируется со словом «математика», и связывающее это понятие со сложными формулами, требующими высокого

- 10. Соотношение обыденного и научного познания

- 11. Основные задачи решаемые математическими методами в психологии Подтверждение экспериментальных данных Проверка валидности и надежности создаваемых методик

- 12. Анализ данных на компьютере. Использование MS Excel Статистические пакеты: SPSS, STATISTICA. Особенности подготовки данных для анализа

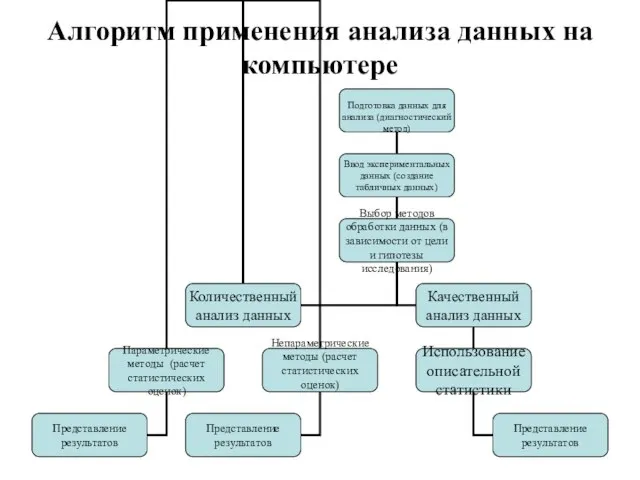

- 13. Алгоритм применения анализа данных на компьютере

- 14. Использование MS Excel Плюсы и минусы MC Excel В Microsoft Excel входит набор средств анализа данных

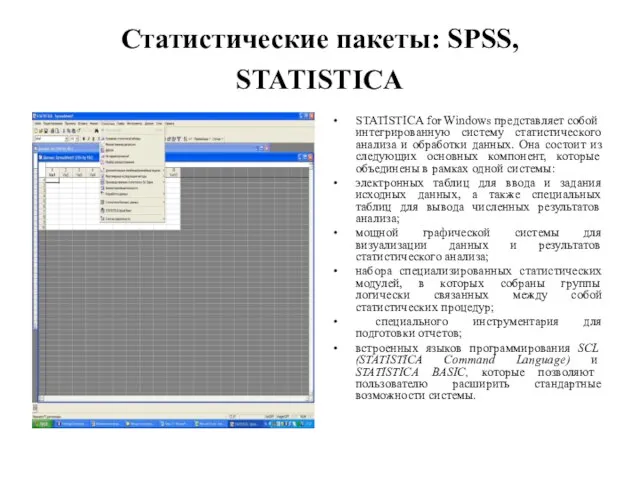

- 15. Статистические пакеты: SPSS, STATISTICA STATISTICA for Windows представляет собой интегрированную систему статистического анализа и обработки данных.

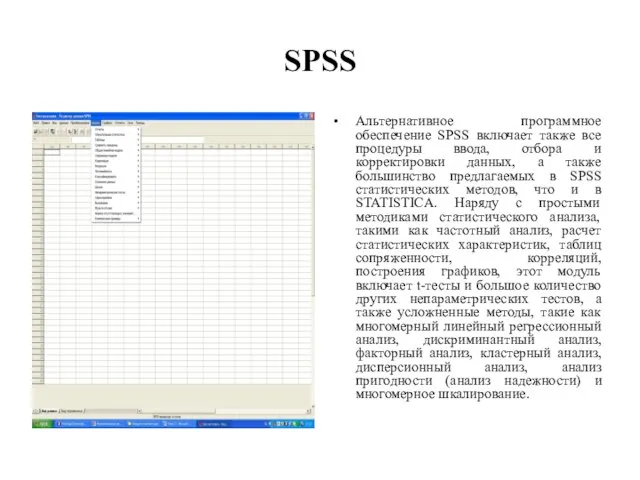

- 16. SPSS Альтернативное программное обеспечение SPSS включает также все процедуры ввода, отбора и корректировки данных, а также

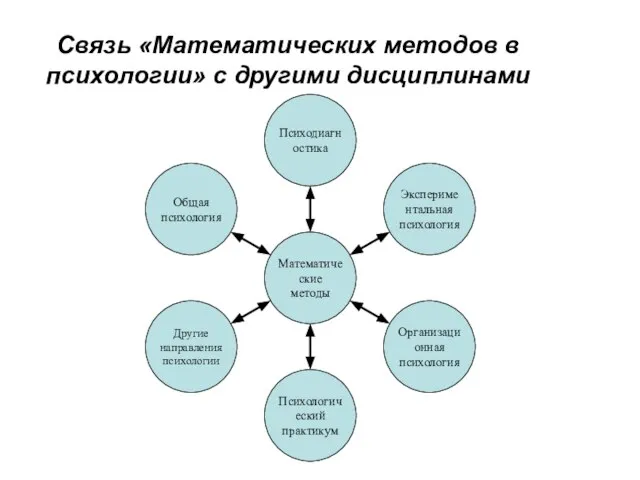

- 17. Связь «Математических методов в психологии» с другими дисциплинами

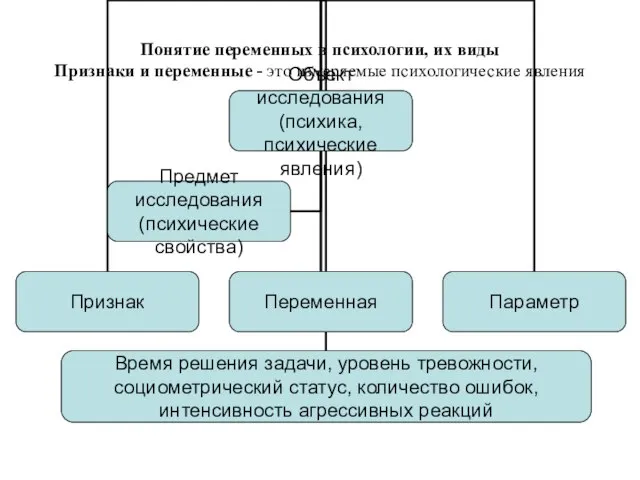

- 18. Понятие переменных в психологии, их виды Признаки и переменные - это измеряемые психологические явления

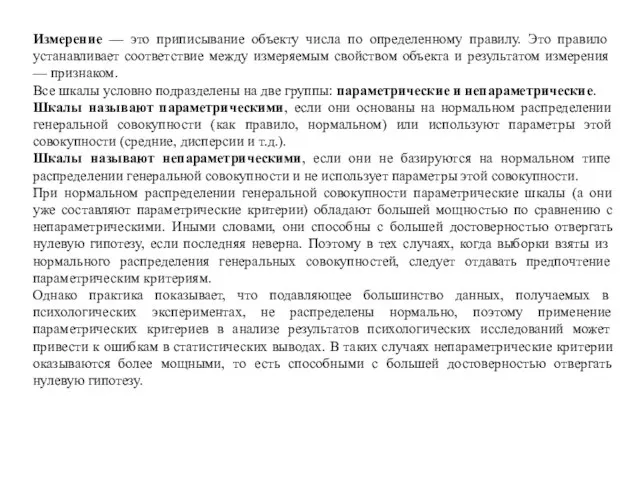

- 19. Измерение — это приписывание объекту числа по определенному правилу. Это правило устанавливает соответствие между измеряемым свойством

- 20. Шкалы по С. Стивенсу

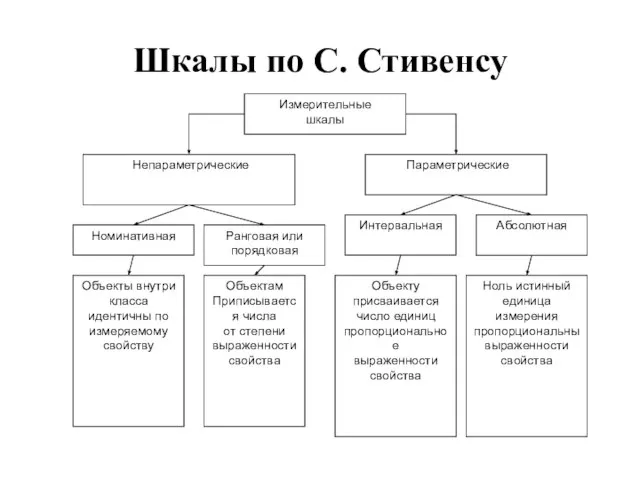

- 21. Сводка характеристик и примеры измерительных шкал

- 22. Типы данных

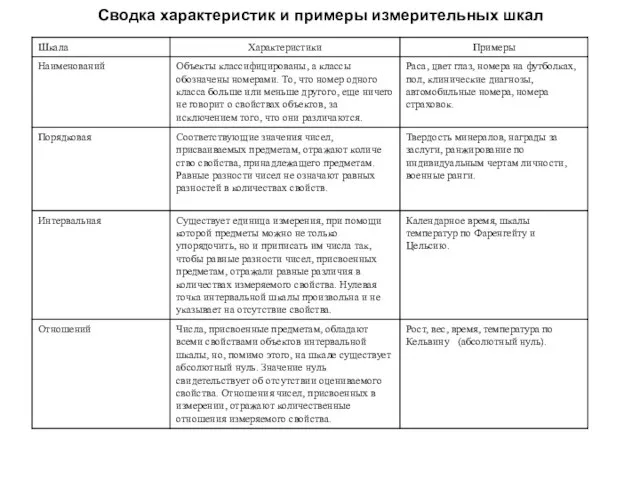

- 23. Наглядное представление данных

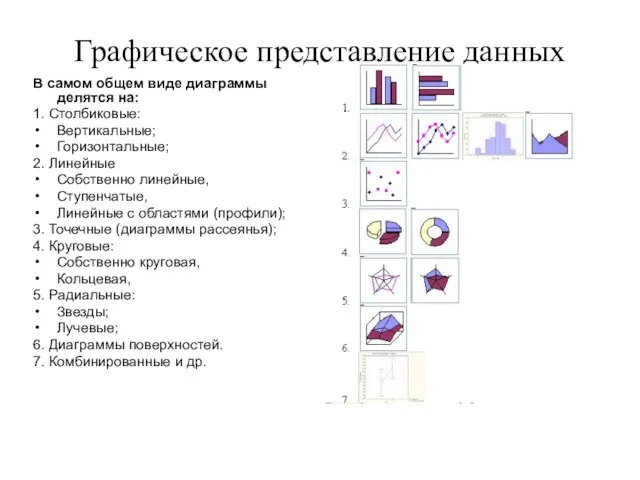

- 24. Графическое представление данных В самом общем виде диаграммы делятся на: 1. Столбиковые: Вертикальные; Горизонтальные; 2. Линейные

- 25. Правила графического оформления Вся структура графика предполагает его чтение слева направо, вертикальные шкалы — снизу вверх.

- 26. Правила табличного представления первичных данных Вся структура таблицы предполагает ее чтение слева направо. В первом столбце

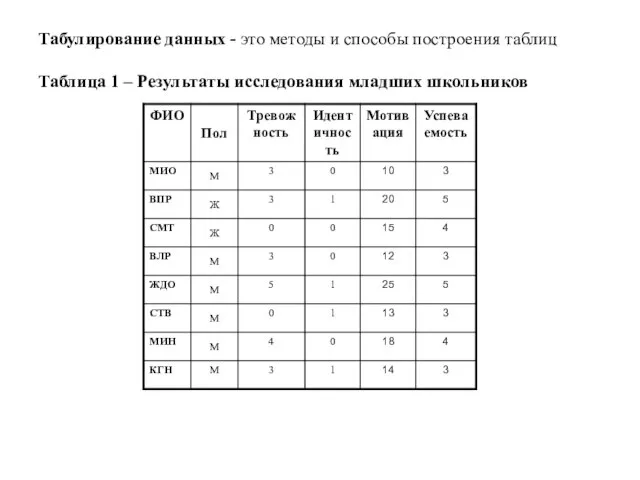

- 27. Табулирование данных - это методы и способы построения таблиц Таблица 1 – Результаты исследования младших школьников

- 28. Тема 2. Генеральная совокупность и выборка. Понятие генеральной совокупности и выборки Виды вероятностной выборки Зависимые и

- 29. Понятие генеральной совокупности и выборки Генеральной совокупностью – называется всякая большая (конечная или бесконечная) коллекция или

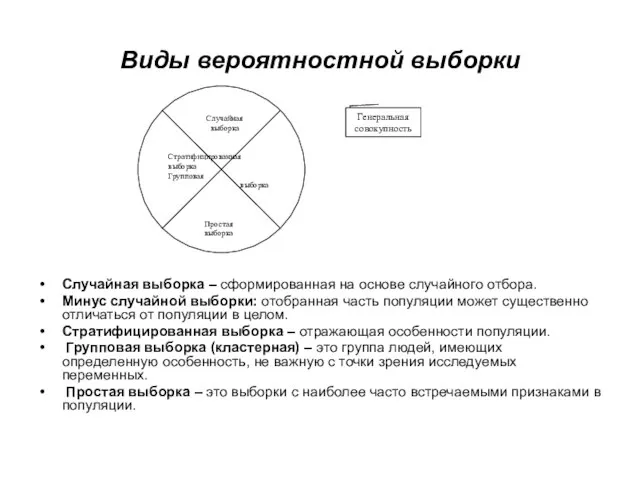

- 30. Виды вероятностной выборки Случайная выборка – сформированная на основе случайного отбора. Минус случайной выборки: отобранная часть

- 31. Зависимые и независимые выборки Независимые выборки – это разные группы (людей, характеристик или параметров). Характеризуются тем,

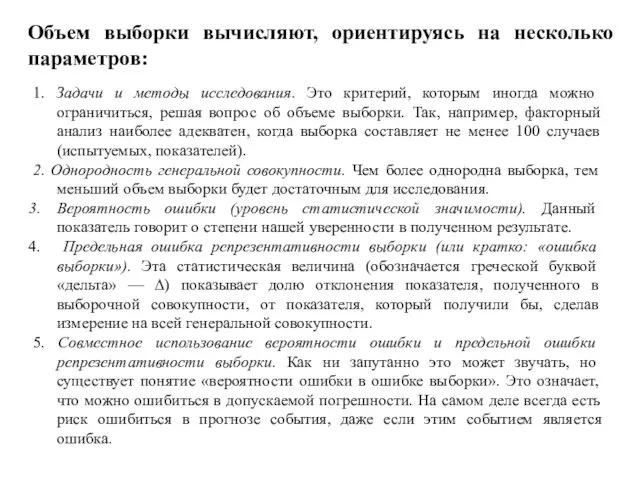

- 32. Объем выборки вычисляют, ориентируясь на несколько параметров: 1. Задачи и методы исследования. Это критерий, которым иногда

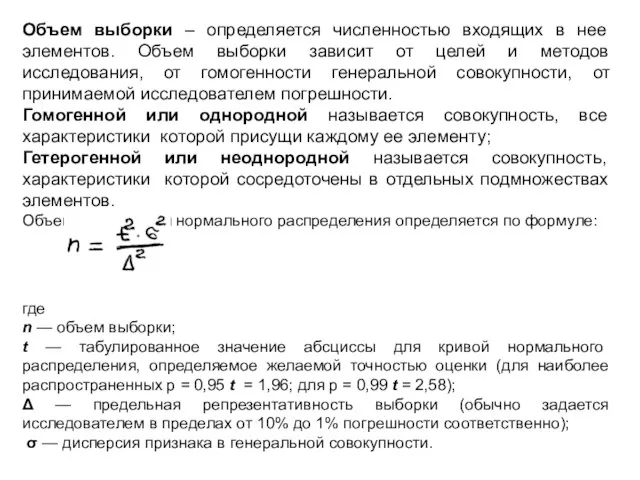

- 33. Объем выборки – определяется численностью входящих в нее элементов. Объем выборки зависит от целей и методов

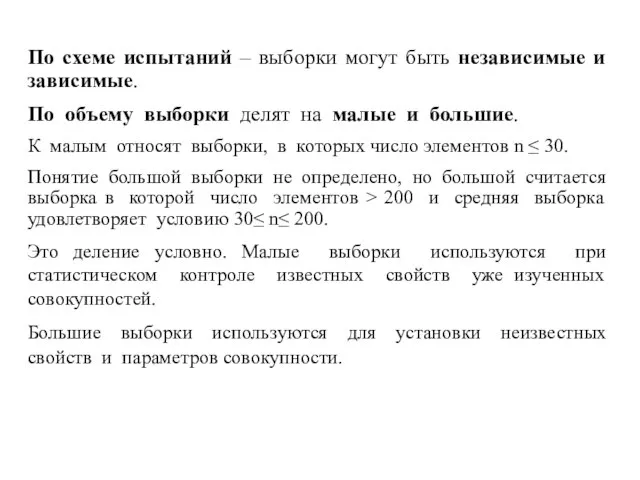

- 34. По схеме испытаний – выборки могут быть независимые и зависимые. По объему выборки делят на малые

- 35. Тема 3. Способы представления данных в психологии Представление данных. Понятие о квантилях. Понятие о рангах. Процедура

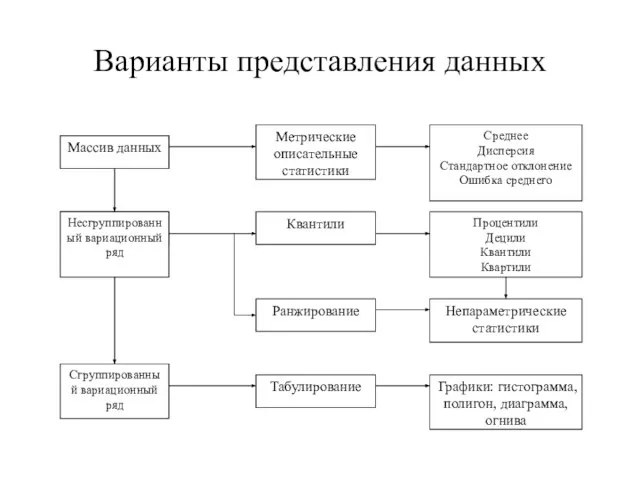

- 36. Представление данных в психологии бывает в виде: Массив данных – первичные результаты измерения искомых параметров сводятся

- 37. Варианты представления данных

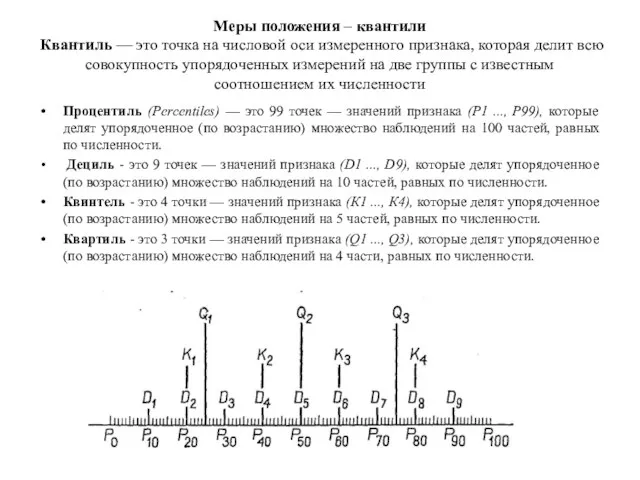

- 38. Меры положения – квантили Квантиль — это точка на числовой оси измеренного признака, которая делит всю

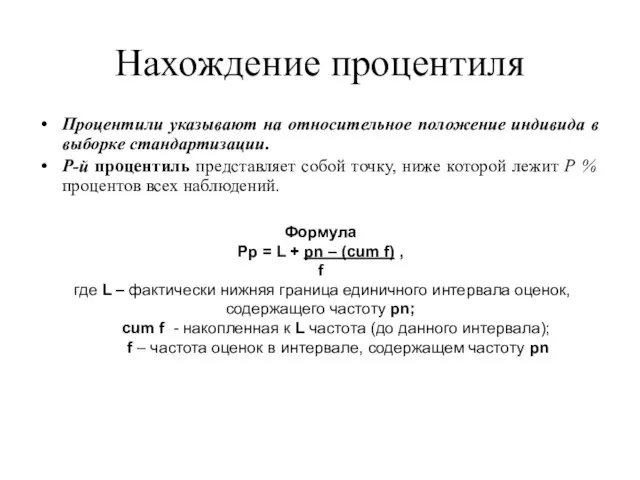

- 39. Нахождение процентиля Процентили указывают на относительное положение индивида в выборке стандартизации. Р-й процентиль представляет собой точку,

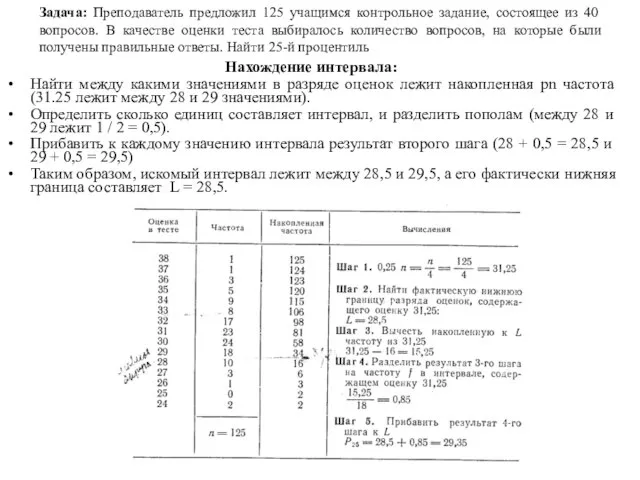

- 40. Задача: Преподаватель предложил 125 учащимся контрольное задание, состоящее из 40 вопросов. В качестве оценки теста выбиралось

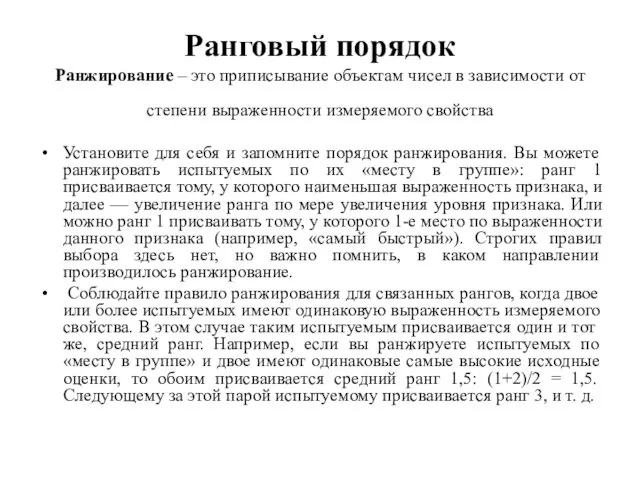

- 41. Ранговый порядок Ранжирование – это приписывание объектам чисел в зависимости от степени выраженности измеряемого свойства Установите

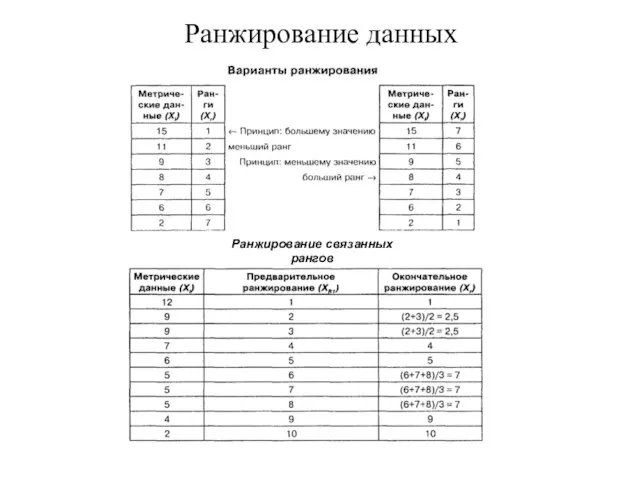

- 42. Ранжирование данных Ранжирование связанных рангов

- 43. Распределение частот Абсолютная частота распределения (fa ) - называется частота. указывающая, сколько раз встречается каждое значение

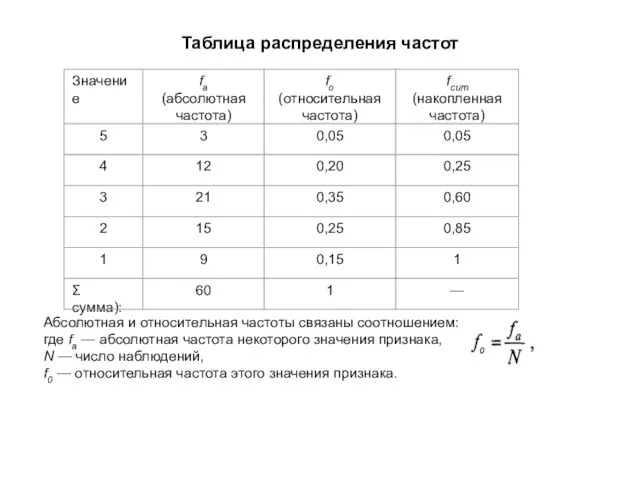

- 44. Таблица распределения частот Абсолютная и относительная частоты связаны соотношением: где fa — абсолютная частота некоторого значения

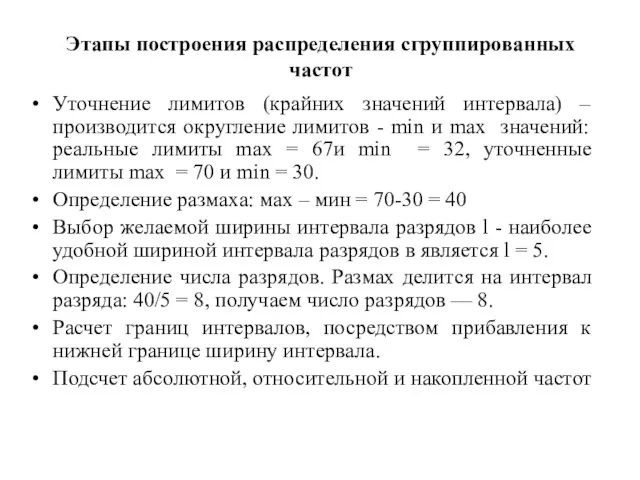

- 45. Этапы построения распределения сгруппированных частот Уточнение лимитов (крайних значений интервала) – производится округление лимитов - min

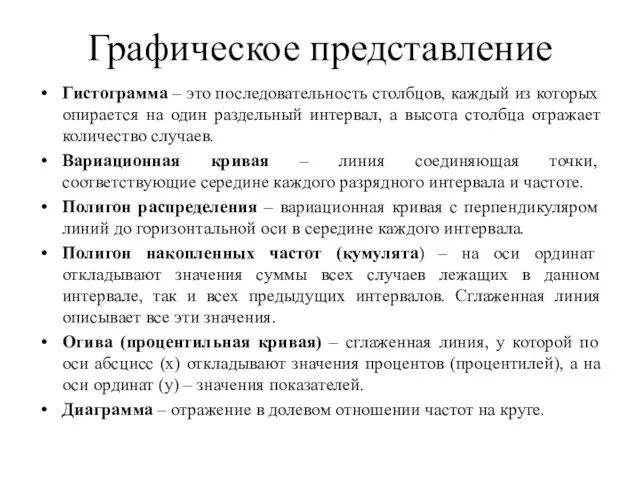

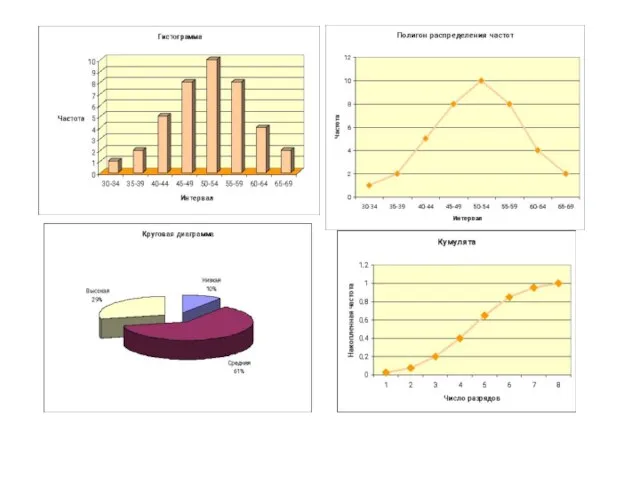

- 46. Графическое представление Гистограмма – это последовательность столбцов, каждый из которых опирается на один раздельный интервал, а

- 48. Тема 4. Меры центральной тенденции Определение меры центральной тенденции; Мода; Медиана; Среднее; Выбор и особенности мер

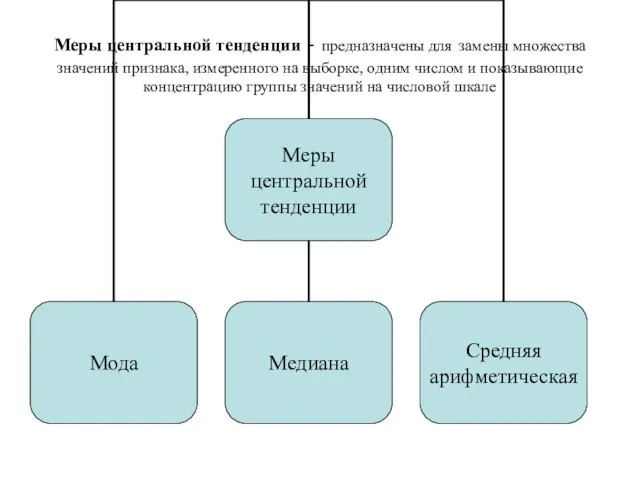

- 49. Меры центральной тенденции - предназначены для замены множества значений признака, измеренного на выборке, одним числом и

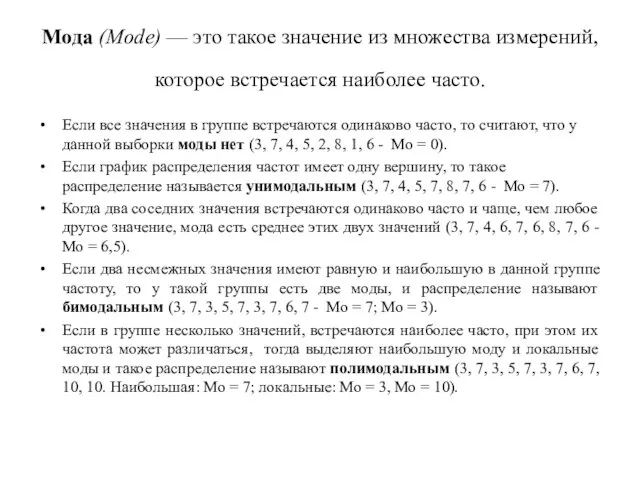

- 50. Мода (Mode) — это такое значение из множества измерений, которое встречается наиболее часто. Если все значения

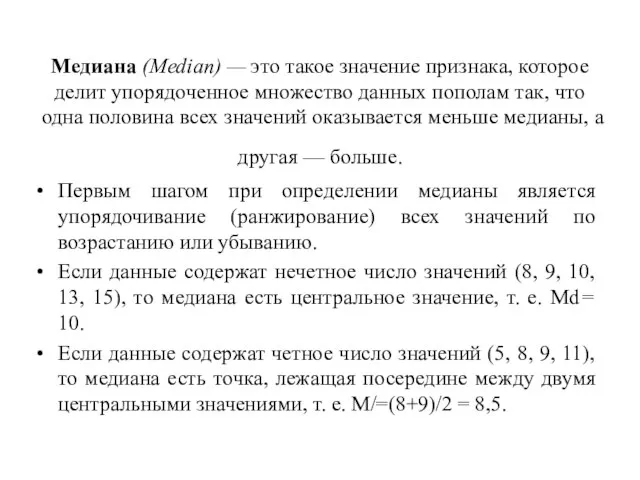

- 51. Медиана (Median) — это такое значение признака, которое делит упорядоченное множество данных пополам так, что одна

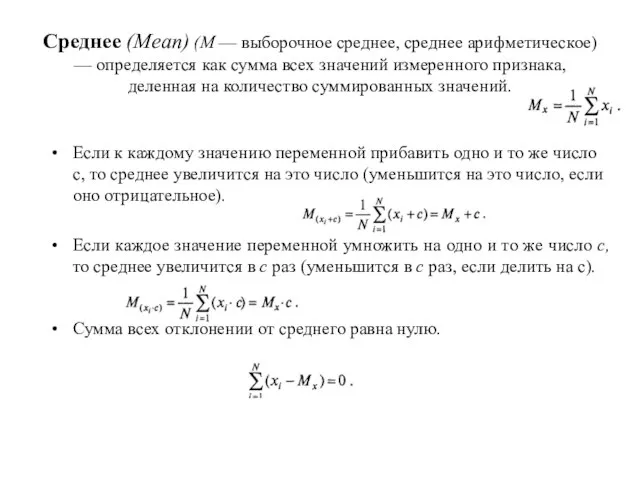

- 52. Среднее (Mean) (М — выборочное среднее, среднее арифметическое) — определяется как сумма всех значений измеренного признака,

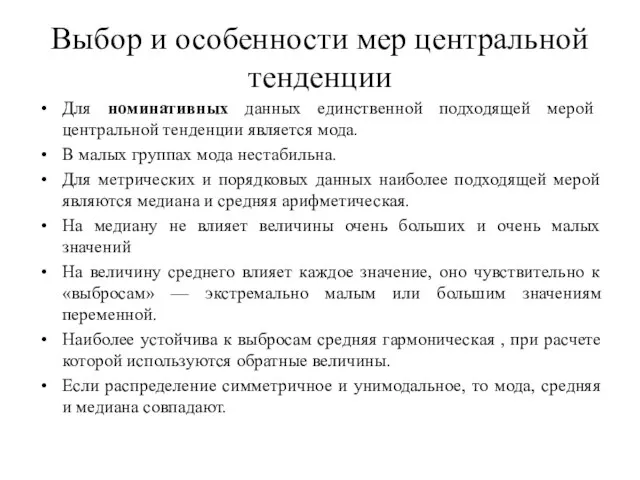

- 53. Выбор и особенности мер центральной тенденции Для номинативных данных единственной подходящей мерой центральной тенденции является мода.

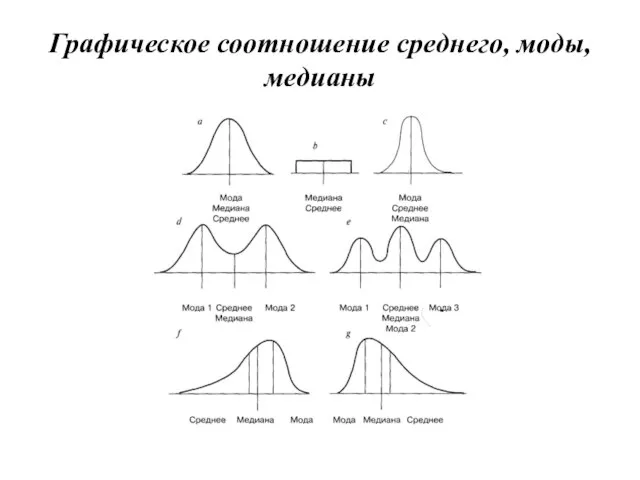

- 54. Графическое соотношение среднего, моды, медианы

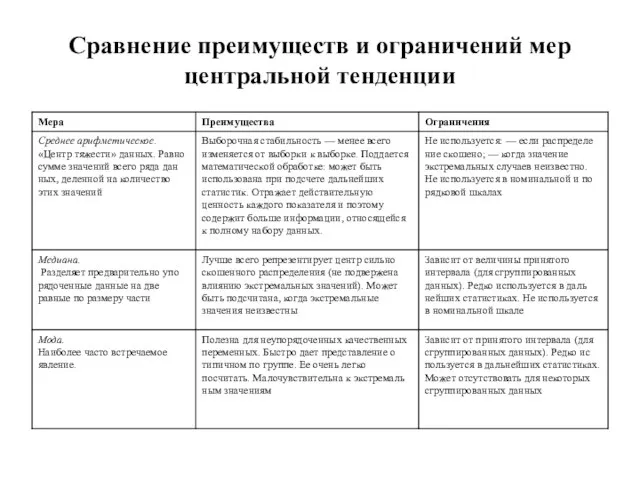

- 55. Сравнение преимуществ и ограничений мер центральной тенденции

- 56. Тема 5. Меры изменчивости Понятие меры изменчивости Лимиты. Размах вариации и его разновидности. Дисперсия и ее

- 57. Меры изменчивости

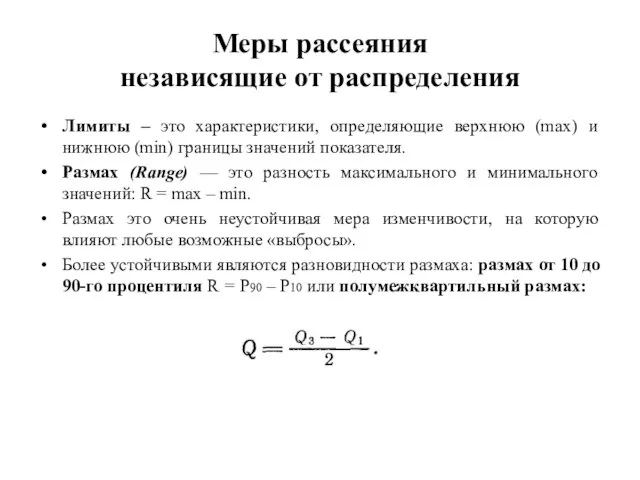

- 58. Меры рассеяния независящие от распределения Лимиты – это характеристики, определяющие верхнюю (max) и нижнюю (min) границы

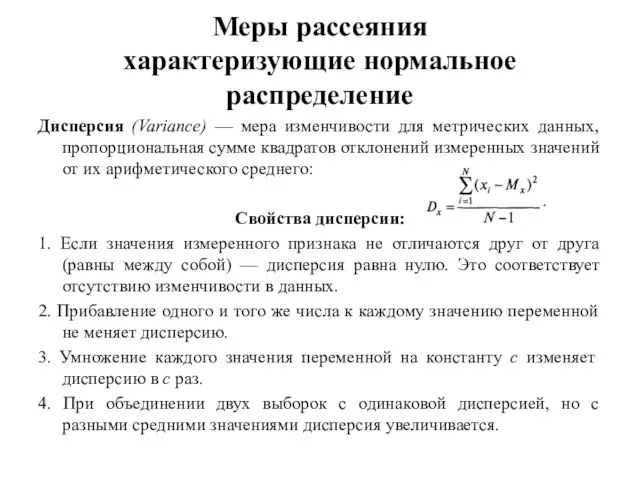

- 59. Меры рассеяния характеризующие нормальное распределение Дисперсия (Variance) — мера изменчивости для метрических данных, пропорциональная сумме квадратов

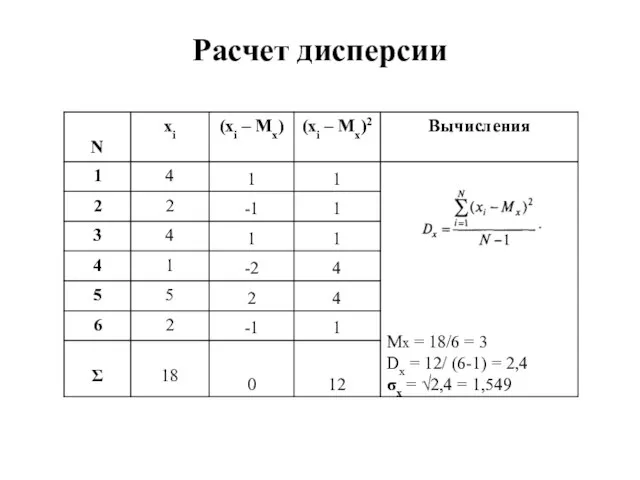

- 60. Расчет дисперсии

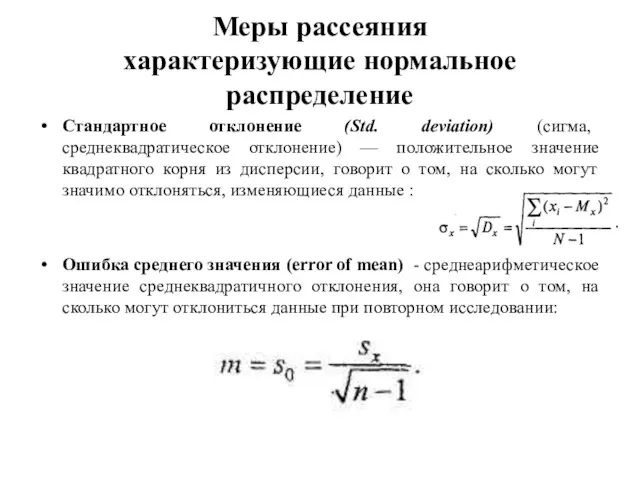

- 61. Меры рассеяния характеризующие нормальное распределение Стандартное отклонение (Std. deviation) (сигма, среднеквадратическое отклонение) — положительное значение квадратного

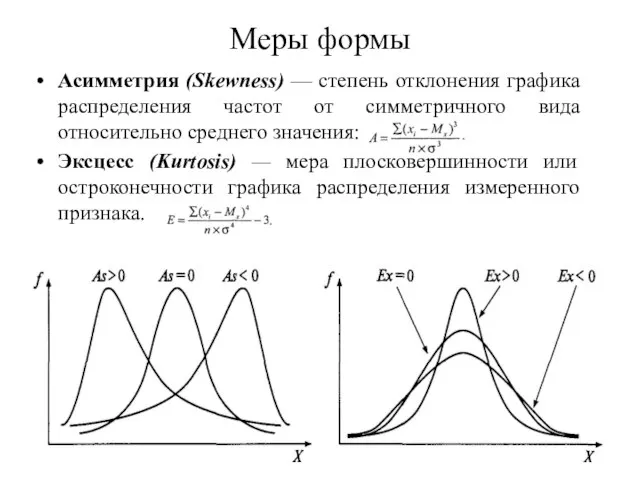

- 62. Меры формы Асимметрия (Skewness) — степень отклонения графика распределения частот от симметричного вида относительно среднего значения:

- 63. Тема 6. Стандартизация данных Понятие стандартизации данных. Основные формы стандартизации. z-преобразование данных.

- 64. Стандартизация (англ. standard нормальный) — унификация, приведение к единым нормативам процедуры и оценок теста. Различают две

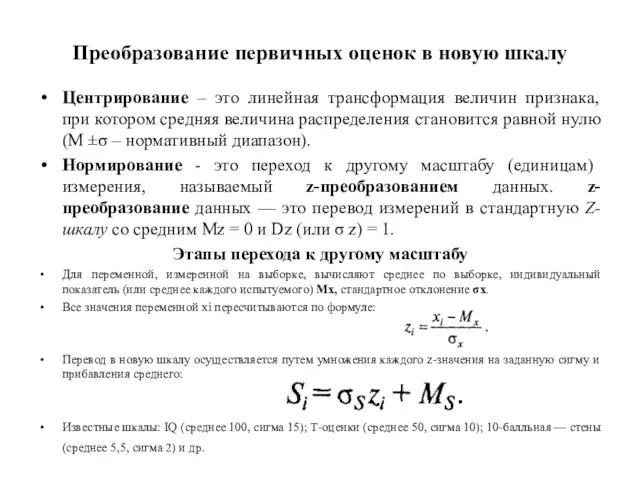

- 65. Преобразование первичных оценок в новую шкалу Центрирование – это линейная трансформация величин признака, при котором средняя

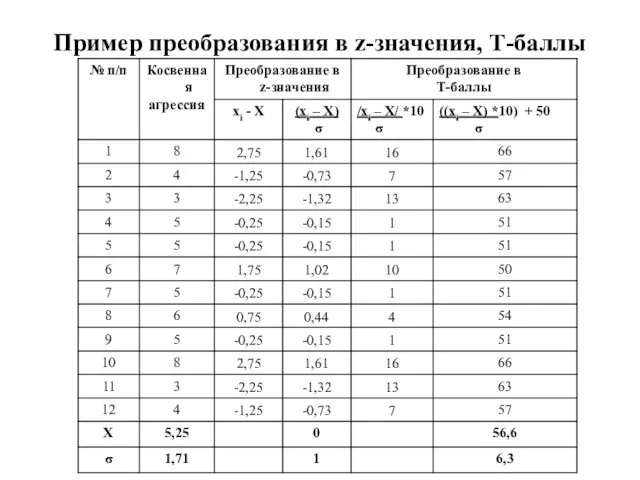

- 66. Пример преобразования в z-значения, Т-баллы

- 67. Тема 7. Теоретические распределения, используемые при статистических выводах Нормальное распределение Единичное нормальное распределение и его свойства

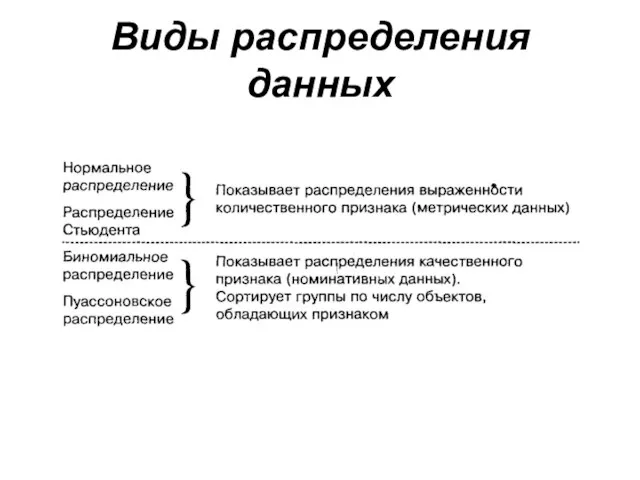

- 68. Виды распределения данных

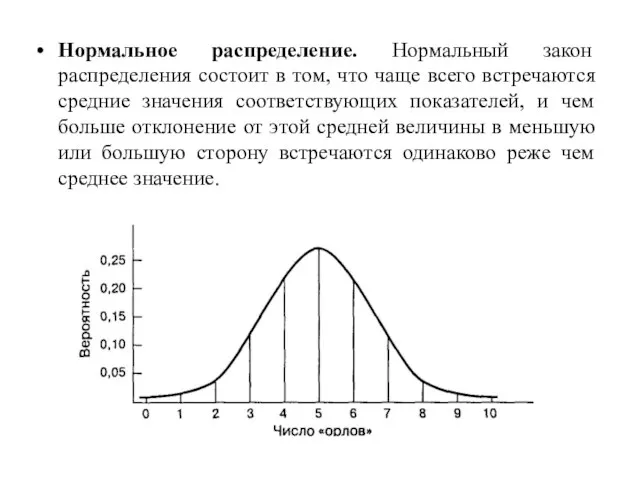

- 69. Нормальное распределение. Нормальный закон распределения состоит в том, что чаще всего встречаются средние значения соответствующих показателей,

- 70. Единичное нормальное распределение и его свойства Если применить z-преобразование ко всем возможным измерениям свойств, все многообразие

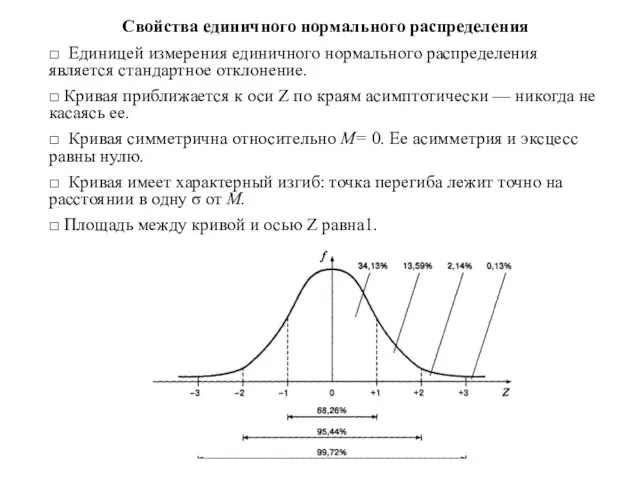

- 71. Свойства единичного нормального распределения □ Единицей измерения единичного нормального распределения является стандартное отклонение. □ Кривая приближается

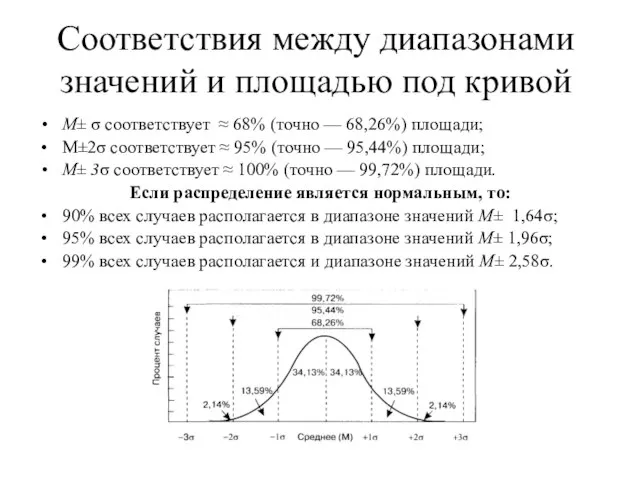

- 72. Соответствия между диапазонами значений и площадью под кривой М± σ соответствует ≈ 68% (точно — 68,26%)

- 73. Проверка нормальности распределения 1. Нормальность распределения результативного признака можно проверить путем расчета показателей асимметрии и эксцесса

- 74. 2. Еще одним из критериев проверки на нормальность - является критерий Колмагорова-Смирнова. Он позволяет оценить вероятность

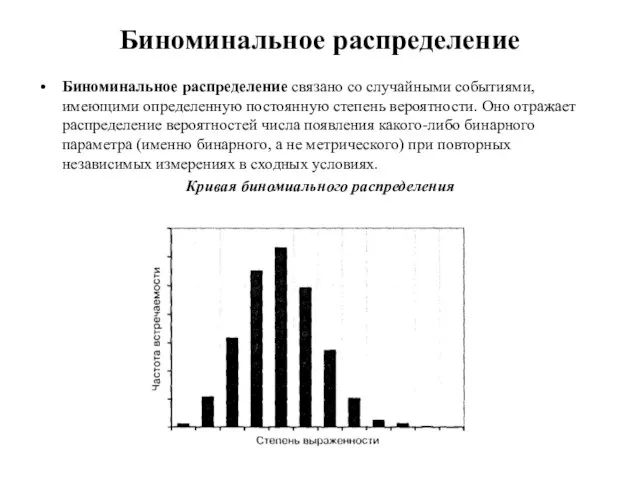

- 75. Биноминальное распределение Биноминальное распределение связано со случайными событиями, имеющими определенную постоянную степень вероятности. Оно отражает распределение

- 76. Распределение Пуассона Распределение Пуассона описывает случайные (редкие) события, вероятность появления которых в отдельных случаях мала, но

- 77. Тема 8. Статистическое оценивание и проверка гипотез Статистические гипотезы. Статистический вывод. Ошибки 1 и 2 рода.

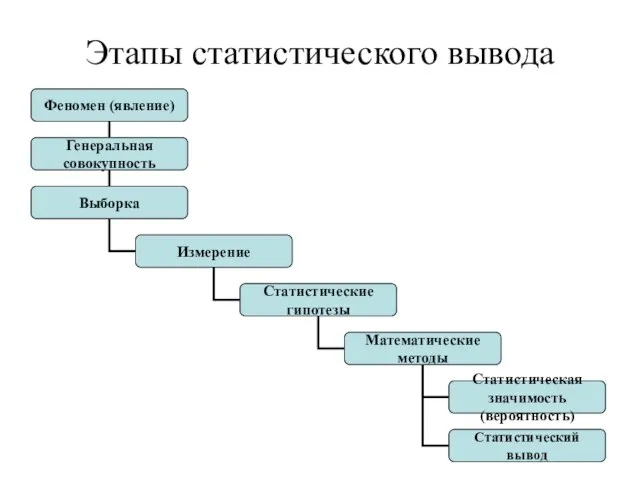

- 78. Этапы статистического вывода

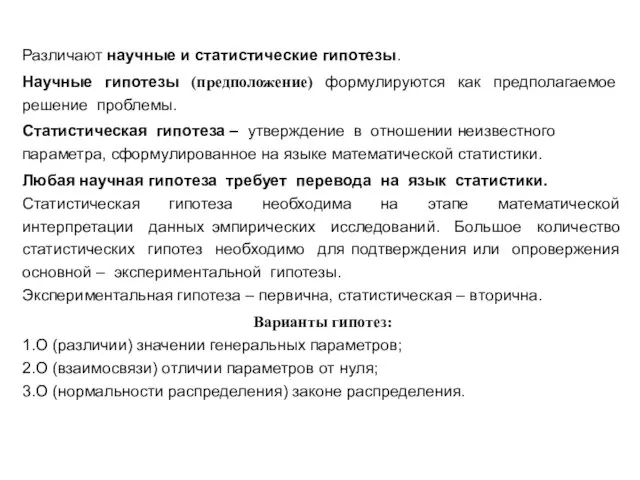

- 79. Различают научные и статистические гипотезы. Научные гипотезы (предположение) формулируются как предполагаемое решение проблемы. Статистическая гипотеза –

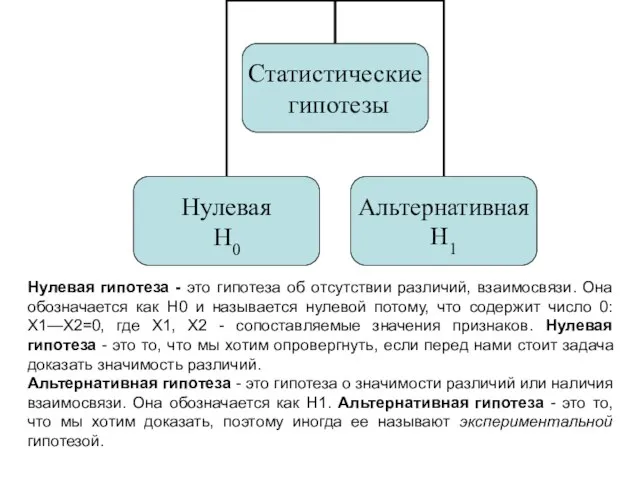

- 80. Нулевая гипотеза - это гипотеза об отсутствии различий, взаимосвязи. Она обозначается как H0 и называется нулевой

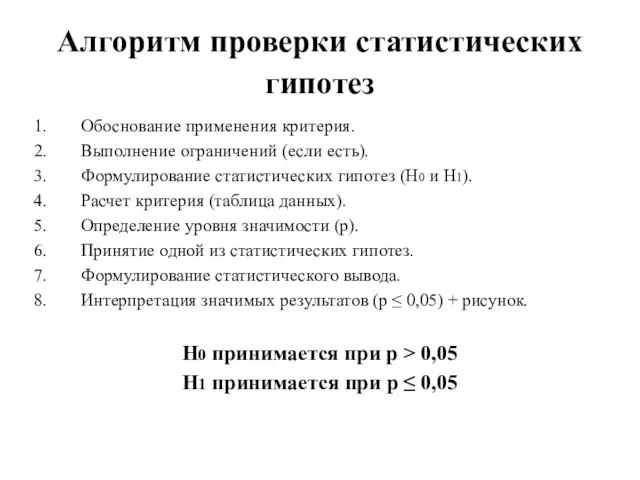

- 81. Алгоритм проверки статистических гипотез Обоснование применения критерия. Выполнение ограничений (если есть). Формулирование статистических гипотез (Н0 и

- 82. Статистическая значимость (Significant level, сокращенно Sig.), или р-уровень значимости (p-level). Величину называют статисти́чески зна́чимой, если мала

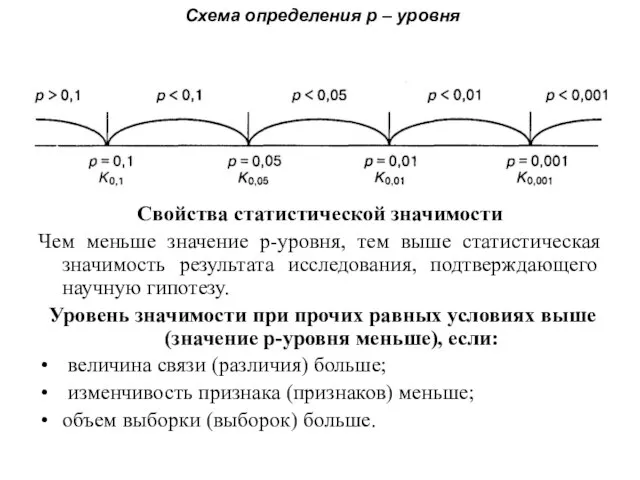

- 83. Схема определения р – уровня Свойства статистической значимости Чем меньше значение р-уровня, тем выше статистическая значимость

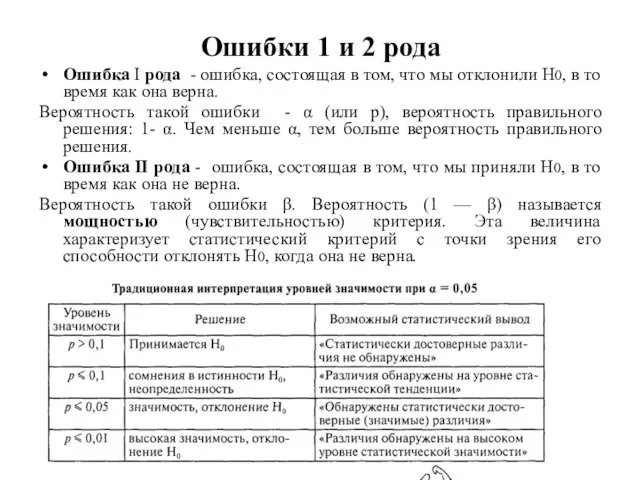

- 84. Ошибки 1 и 2 рода Ошибка I рода - ошибка, состоящая в том, что мы отклонили

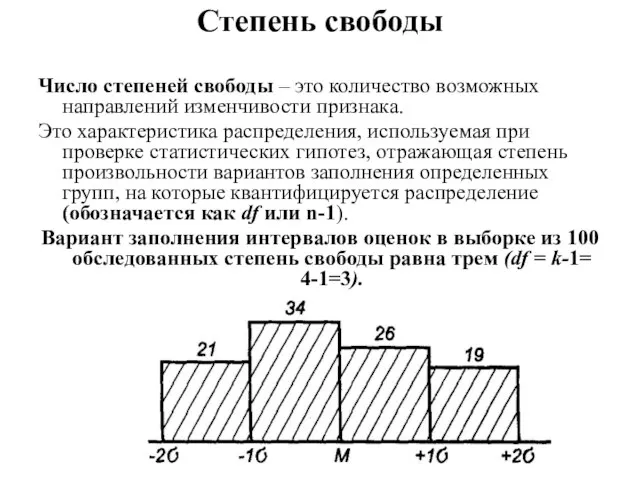

- 85. Степень свободы Число степеней свободы – это количество возможных направлений изменчивости признака. Это характеристика распределения, используемая

- 86. Показатели степеней свободы для зависимых и независимых выборок Если имеются две независимые выборки, то число степеней

- 87. Статистический критерий Статистический критерий – это решающее правило, обеспечивающее надежное поведение, т.е. принятие истинной и отклонение

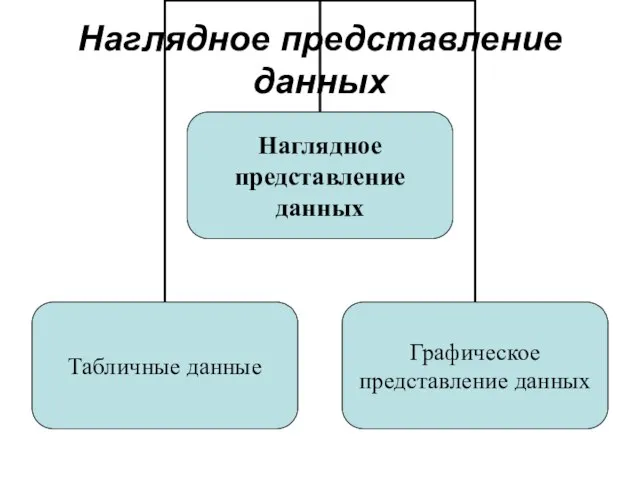

- 88. Параметрические и непараметрические критерии Параметрические критерии – это группа статистических критериев, которые включают в расчет параметры

- 89. Основание выбора критерия а) простота; б) более широкий диапазон использования (например, по отношению к данным, определенным

- 90. Алгоритм работы с критериями 1. Обоснование применения критерия. 2. Выполнение ограничений критерия (если они есть). 3.

- 91. Статистический вывод — это формулирование вывода на основе статистической значимости. Результатом статистического вывода является статистическое суждение,

- 92. Тема 9. Меры связи Понятие корреляции. Диаграмма рассеяния. Классификация коэффициентов корреляции. Корреляционные матрицы. Интерпретация коэффициентов корреляции.

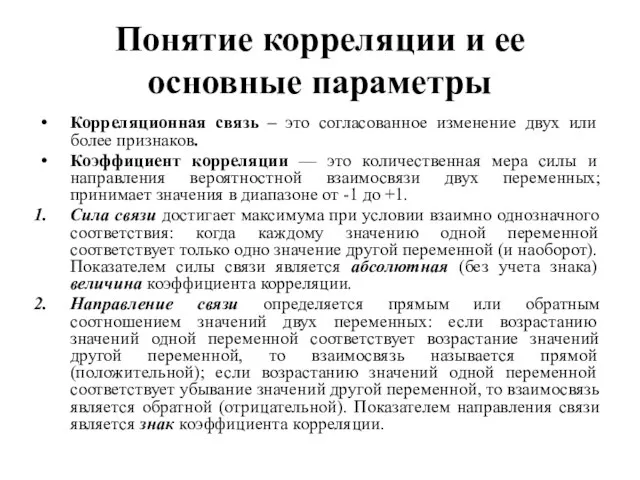

- 93. Понятие корреляции и ее основные параметры Корреляционная связь – это согласованное изменение двух или более признаков.

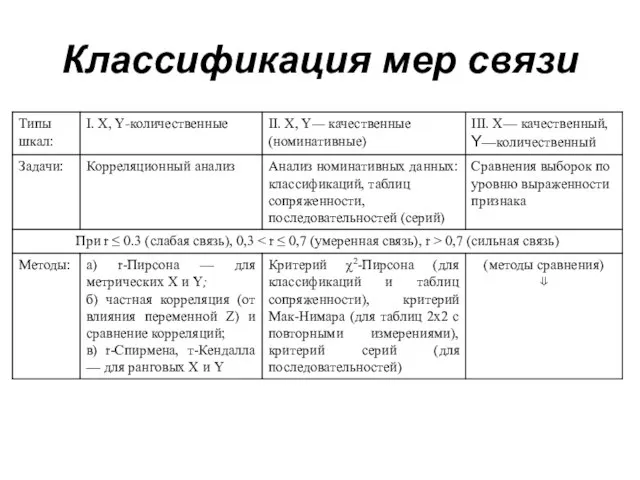

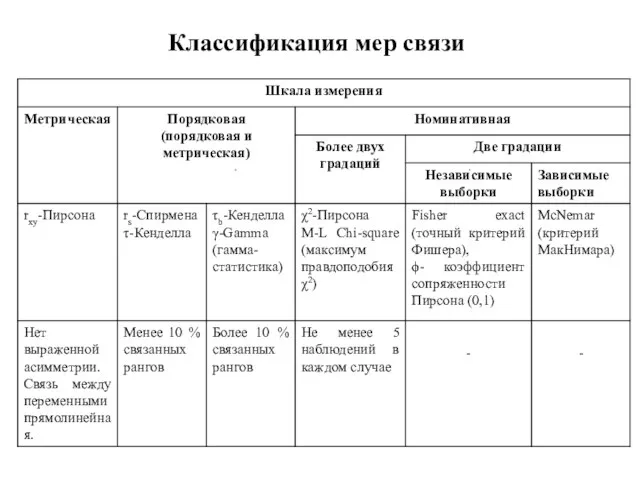

- 94. Классификация мер связи

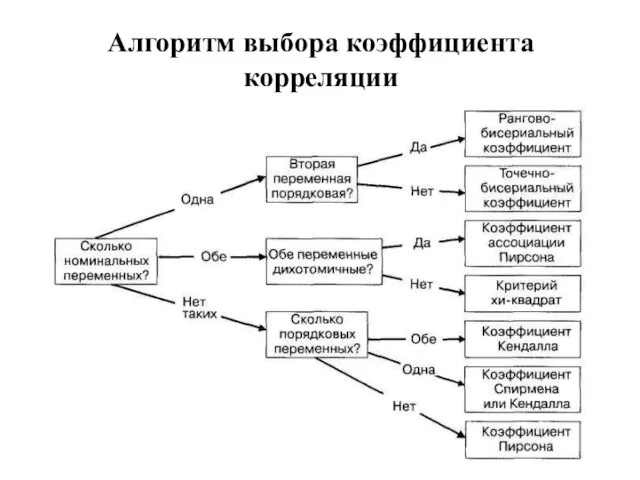

- 95. Алгоритм выбора коэффициента корреляции

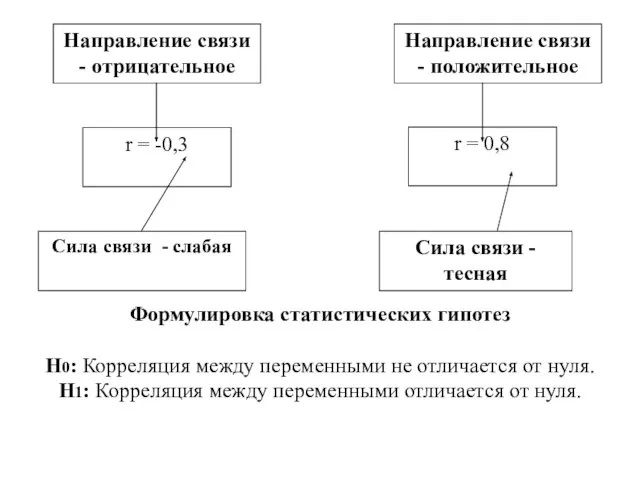

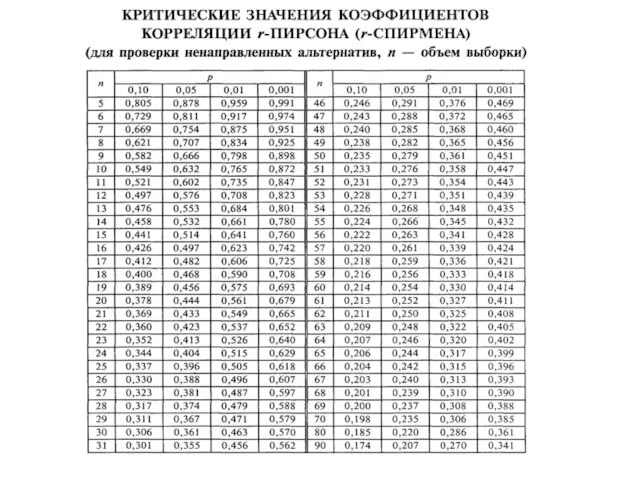

- 97. Формулировка статистических гипотез Н0: Корреляция между переменными не отличается от нуля. Н1: Корреляция между переменными отличается

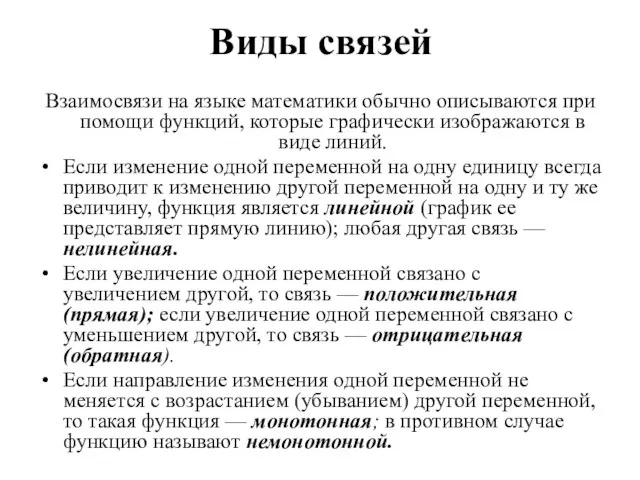

- 98. Виды связей Взаимосвязи на языке математики обычно описываются при помощи функций, которые графически изображаются в виде

- 99. Примеры графиков часто встречающихся функций

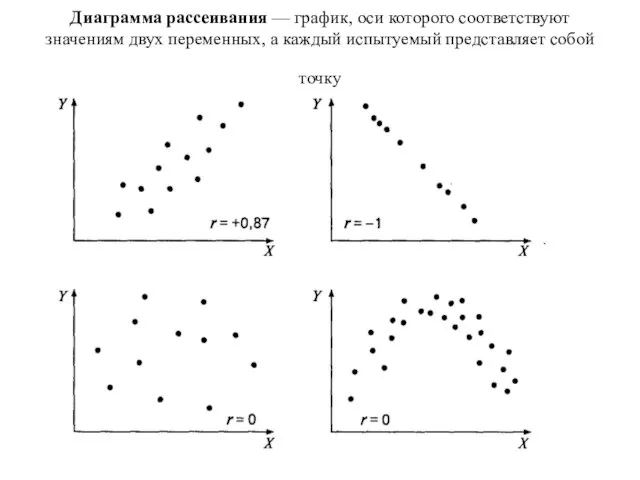

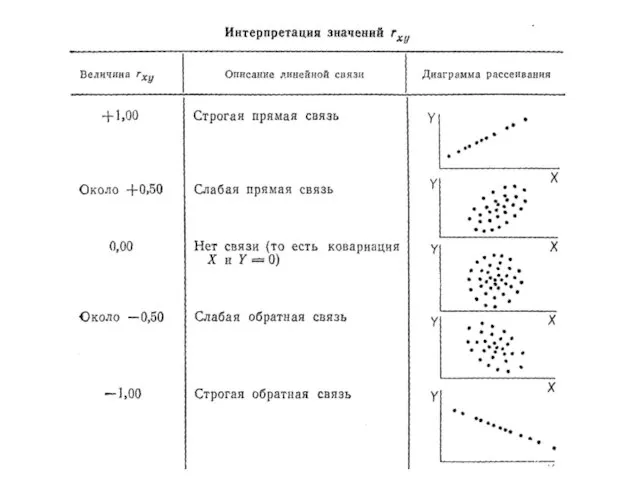

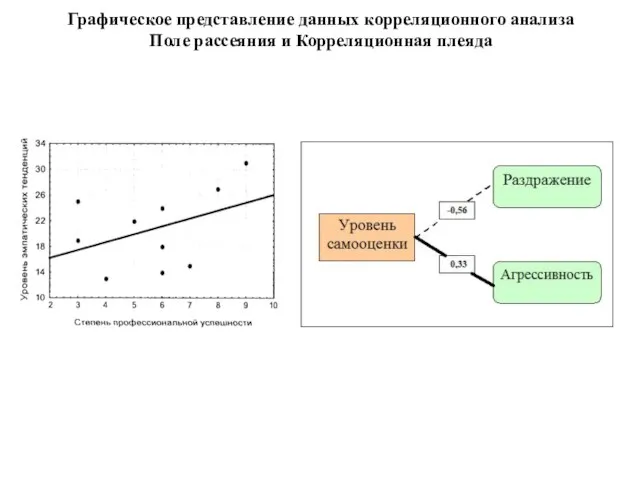

- 100. Диаграмма рассеивания — график, оси которого соответствуют значениям двух переменных, а каждый испытуемый представляет собой точку

- 102. Классификация мер связи

- 103. Графическое представление данных корреляционного анализа Поле рассеяния и Корреляционная плеяда

- 104. Представление данных корреляционного анализа Построение корреляционных матриц и их анализ 1 вид - Квадратная матрица 2

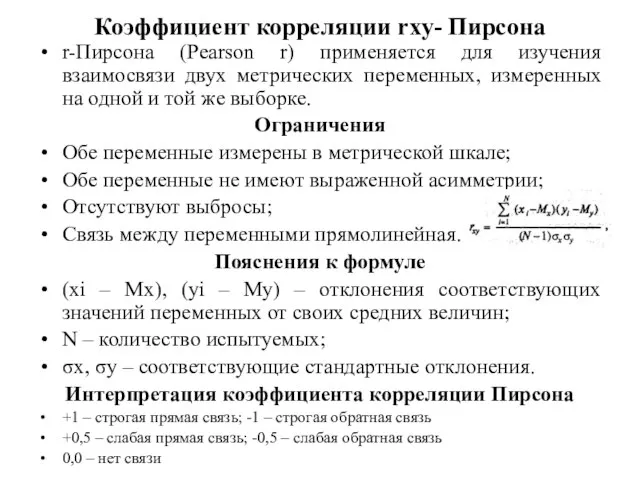

- 105. Коэффициент корреляции rxy- Пирсона r-Пирсона (Pearson r) применяется для изучения взаимосвязи двух метрических переменных, измеренных на

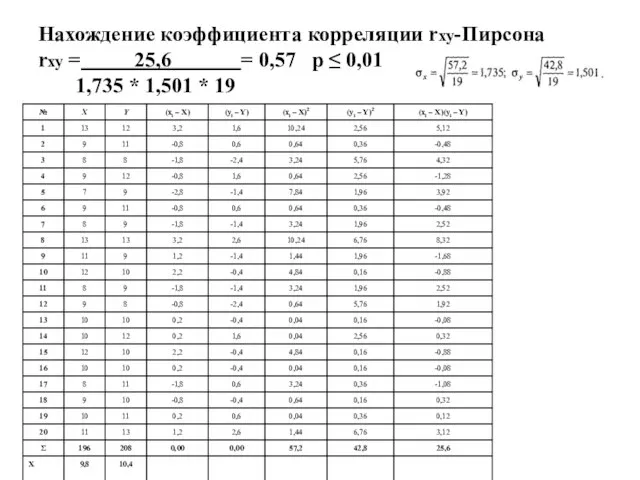

- 106. Нахождение коэффициента корреляции rxy-Пирсона rxy = 25,6 = 0,57 р ≤ 0,01 1,735 * 1,501 *

- 107. Поле рассеяния

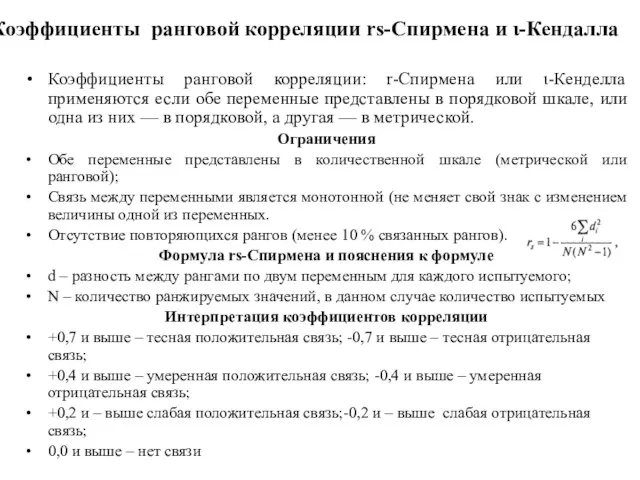

- 109. Коэффициенты ранговой корреляции rs-Спирмена и ι-Кендалла Коэффициенты ранговой корреляции: r-Спирмена или ι-Кенделла применяются если обе переменные

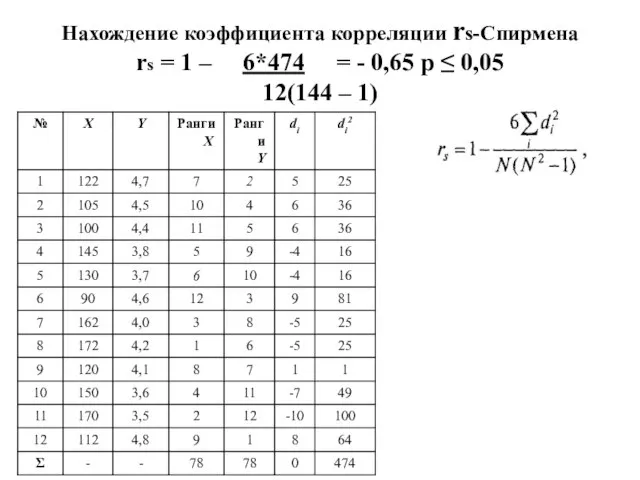

- 110. Нахождение коэффициента корреляции rs-Спирмена rs = 1 – 6*474 = - 0,65 р ≤ 0,05 12(144

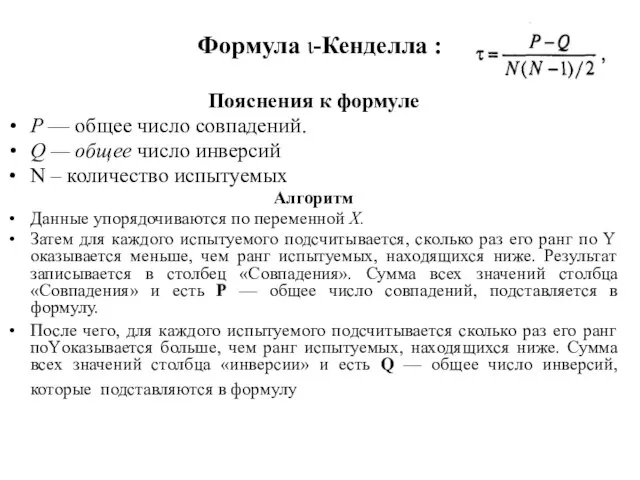

- 111. Формула ι-Кенделла : Пояснения к формуле Р — общее число совпадений. Q — общее число инверсий

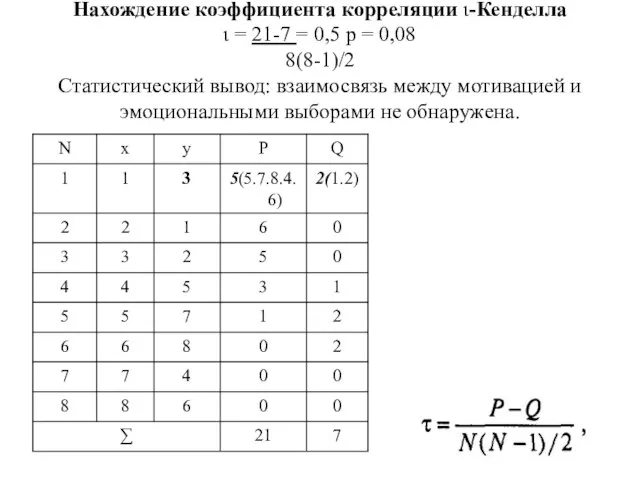

- 112. Нахождение коэффициента корреляции ι-Кенделла ι = 21-7 = 0,5 р = 0,08 8(8-1)/2 Статистический вывод: взаимосвязь

- 113. Тема 10. Анализ качественных признаков (номинативных данных) Корреляция номинативных данных критерий χ2-Пирсона Корреляция бинарных данных фи-коэффициент

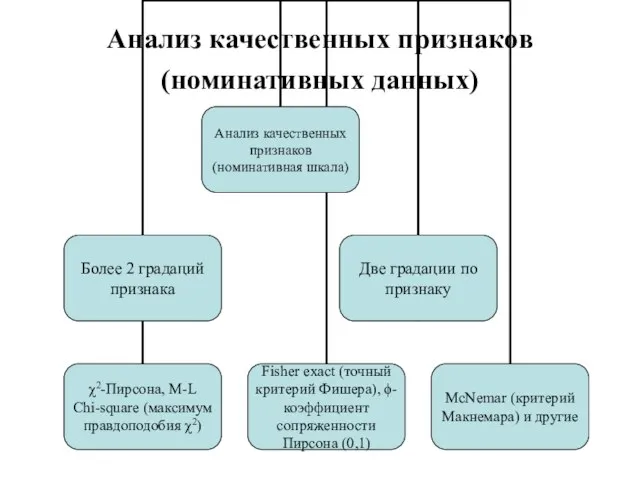

- 114. Анализ качественных признаков (номинативных данных)

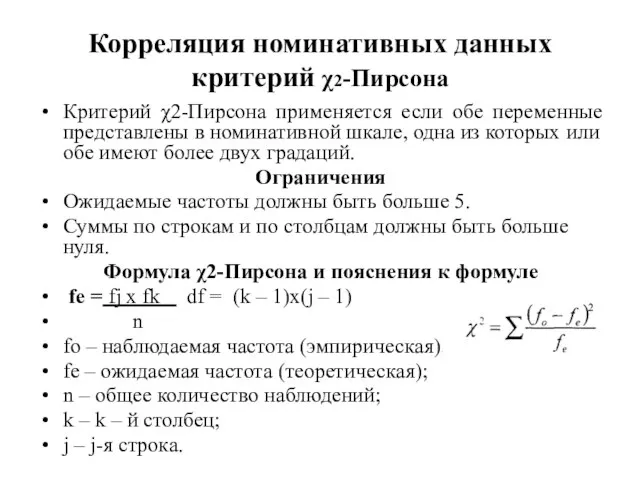

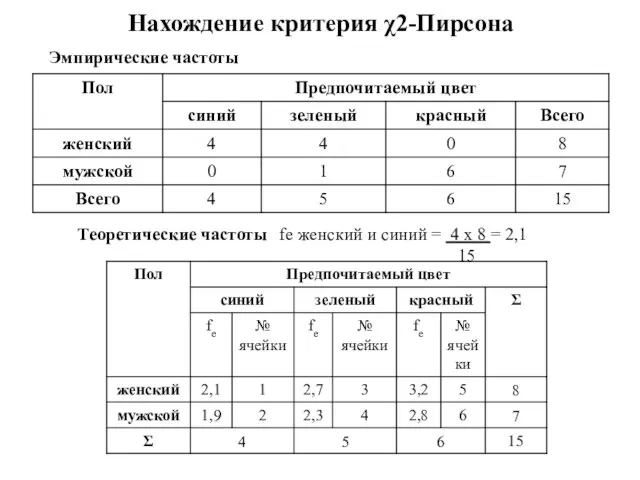

- 115. Корреляция номинативных данных критерий χ2-Пирсона Критерий χ2-Пирсона применяется если обе переменные представлены в номинативной шкале, одна

- 116. Нахождение критерия χ2-Пирсона Теоретические частоты fe женский и синий = 4 x 8 = 2,1 15

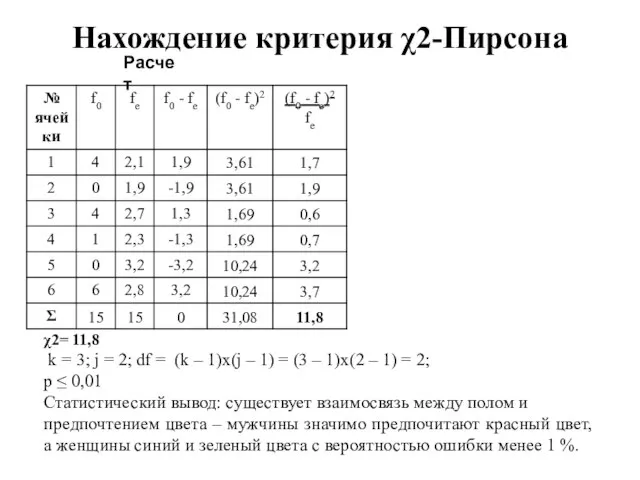

- 117. Нахождение критерия χ2-Пирсона Расчет χ2= 11,8 k = 3; j = 2; df = (k –

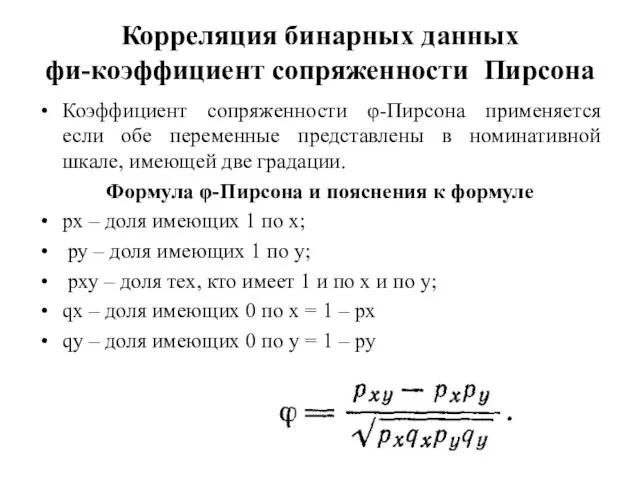

- 118. Корреляция бинарных данных фи-коэффициент сопряженности Пирсона Коэффициент сопряженности φ-Пирсона применяется если обе переменные представлены в номинативной

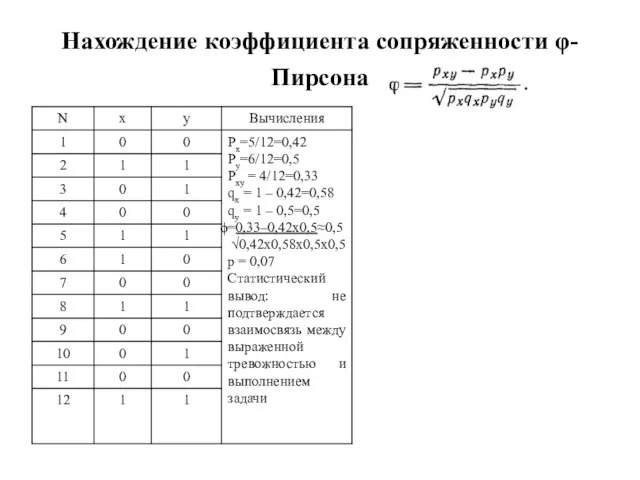

- 119. Нахождение коэффициента сопряженности φ-Пирсона

- 120. Тема 11. Анализ различий между 2 группами независимых выборок Классификация методов сравнения Представление данных сравнительного анализа

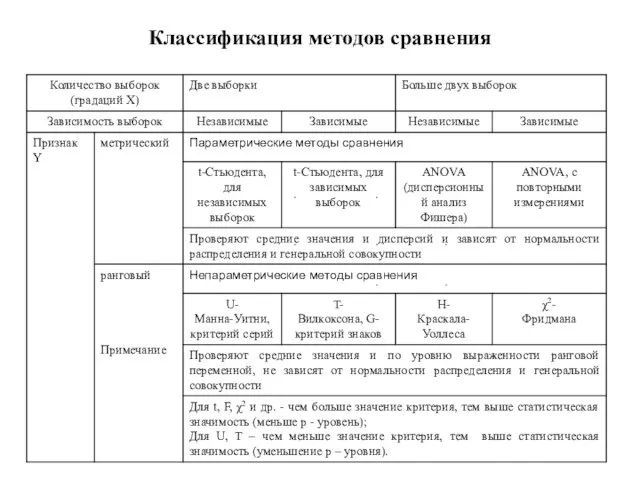

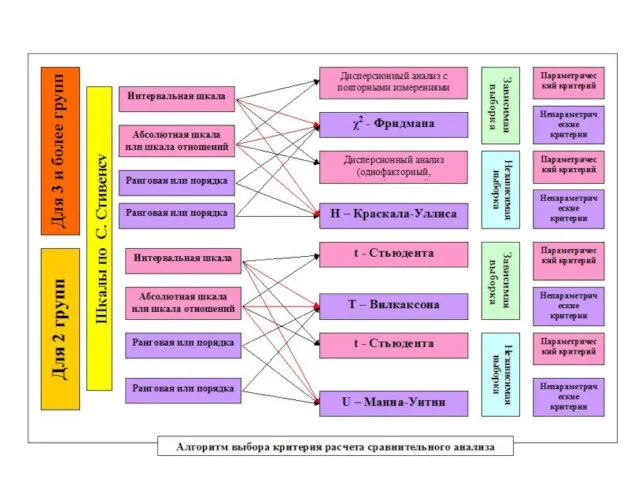

- 121. Классификация методов сравнения

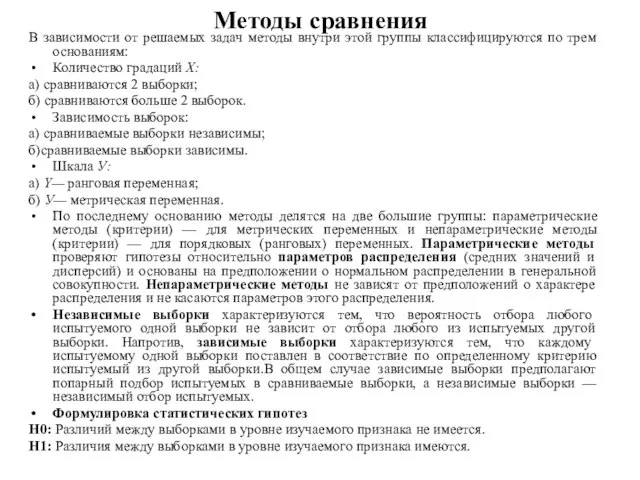

- 123. Методы сравнения В зависимости от решаемых задач методы внутри этой группы классифицируются по трем основаниям: Количество

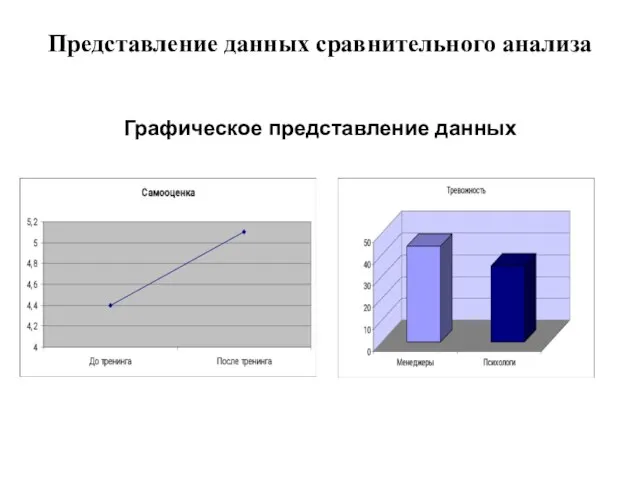

- 124. Представление данных сравнительного анализа Графическое представление данных

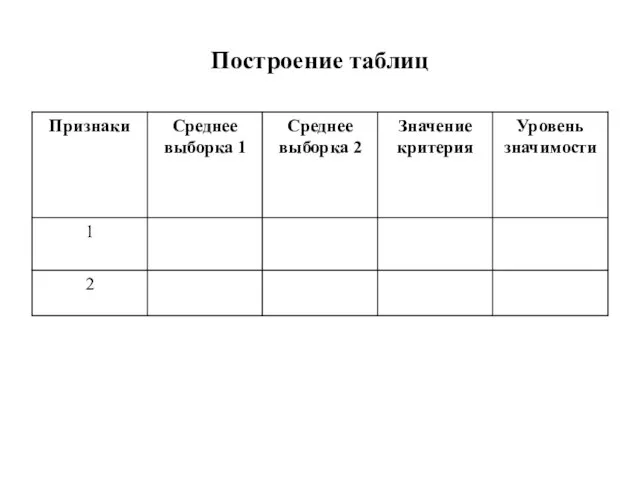

- 125. Построение таблиц

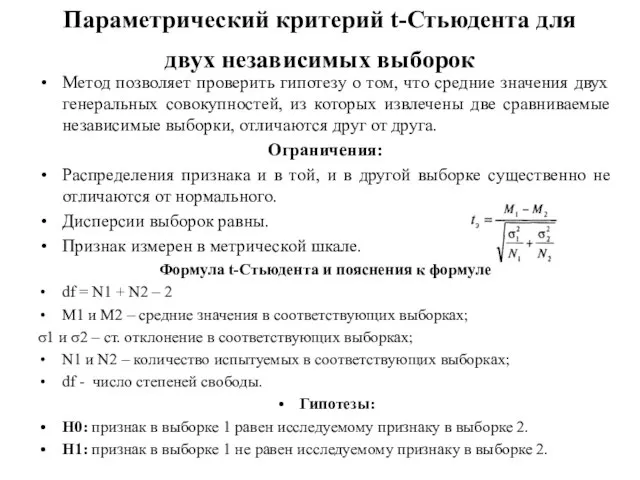

- 126. Параметрический критерий t-Стьюдента для двух независимых выборок Метод позволяет проверить гипотезу о том, что средние значения

- 127. Параметрический критерий сравнения 2 групп (зависимых и независимых) t-Стьюдента Данный критерий был разработан Уильямом Госсетом для

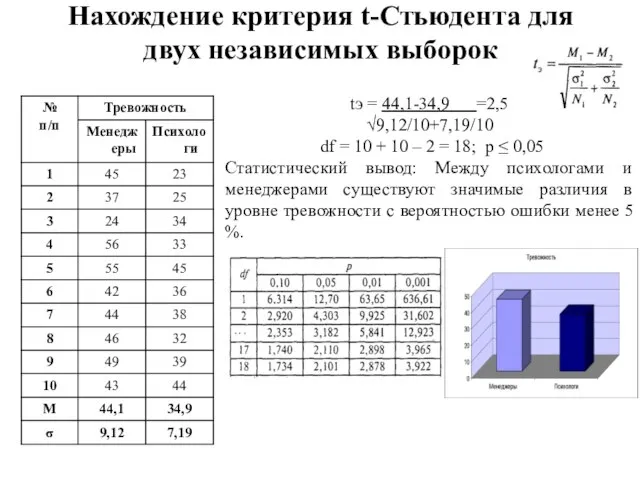

- 128. Нахождение критерия t-Стьюдента для двух независимых выборок tэ = 44,1-34,9 =2,5 √9,12/10+7,19/10 df = 10 +

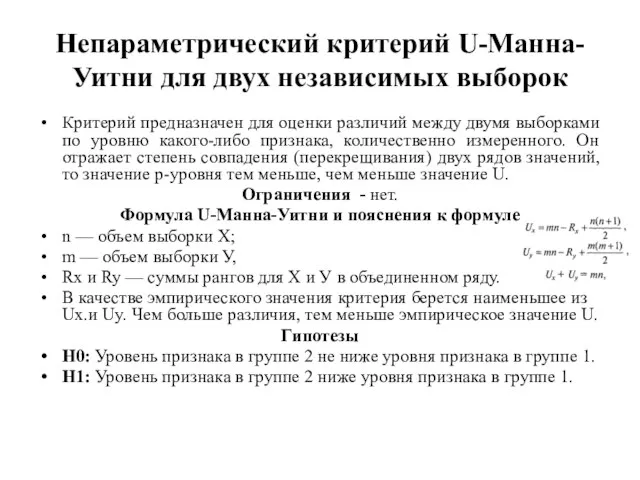

- 129. Непараметрический критерий U-Манна-Уитни для двух независимых выборок Критерий предназначен для оценки различий между двумя выборками по

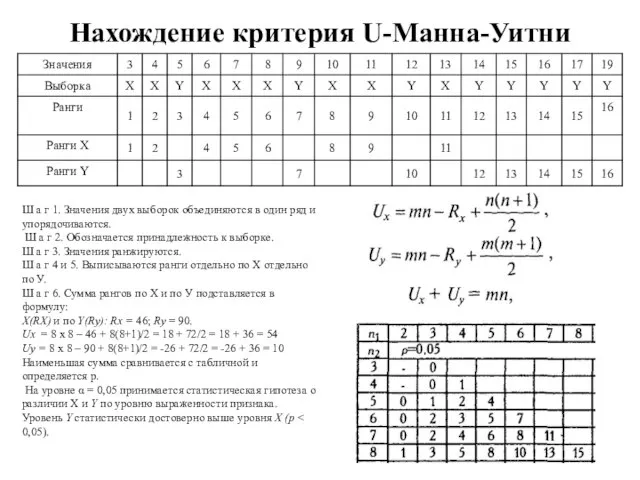

- 130. Нахождение критерия U-Манна-Уитни Ш а г 1. Значения двух выборок объединяются в один ряд и упорядочиваются.

- 131. Тема 12. Анализ различий между 2 группами зависимых выборок Параметрический критерий t-Стьюдента для двух зависимых выборок

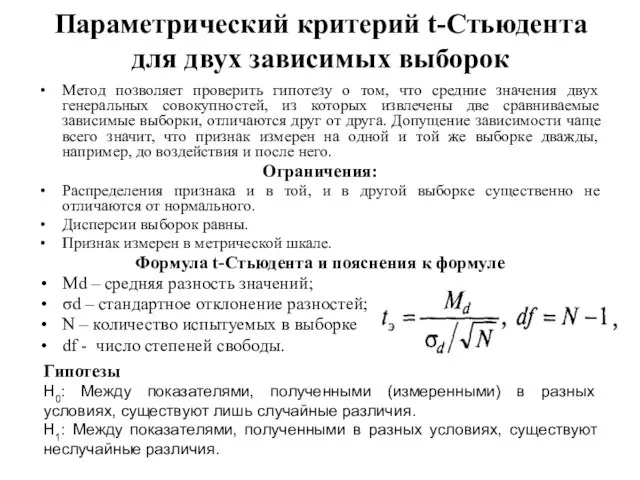

- 132. Параметрический критерий t-Стьюдента для двух зависимых выборок Метод позволяет проверить гипотезу о том, что средние значения

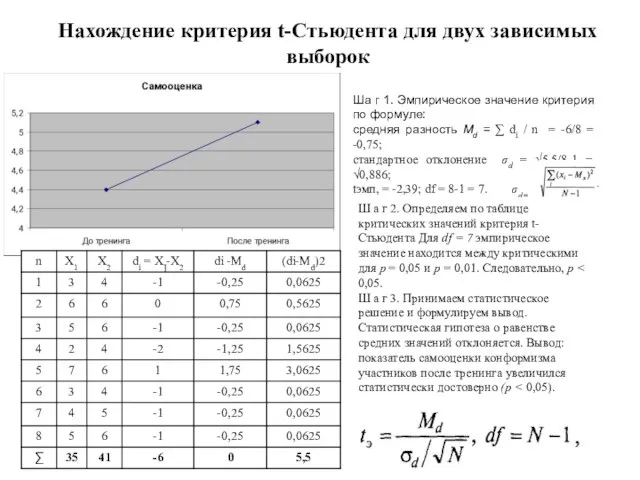

- 133. Нахождение критерия t-Стьюдента для двух зависимых выборок Ша г 1. Эмпирическое значение критерия по формуле: средняя

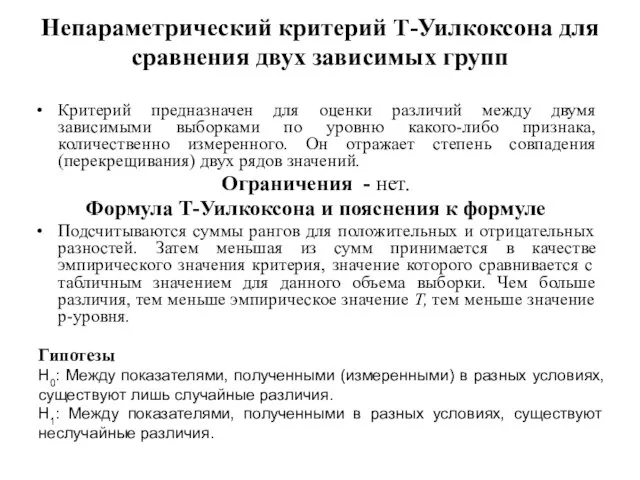

- 134. Непараметрический критерий Т-Уилкоксона для сравнения двух зависимых групп Критерий предназначен для оценки различий между двумя зависимыми

- 135. Нахождение непараметрического критерия Т-Уилкоксона Ш а г 1. Подсчитать разности значений для каждого объекта выборки (строка

- 136. Тема 13. Анализ различий между 3 и более группами независимых выборок Непараметрический критерий Н-Краскала-Уоллеса для сравнения

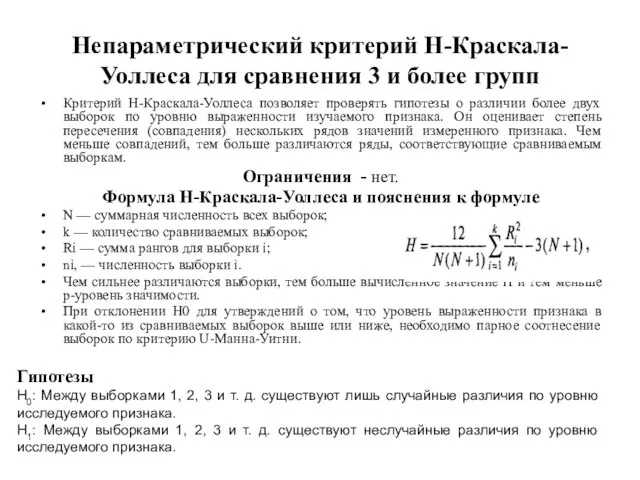

- 137. Непараметрический критерий Н-Краскала-Уоллеса для сравнения 3 и более групп Критерий Н-Краскала-Уоллеса позволяет проверять гипотезы о различии

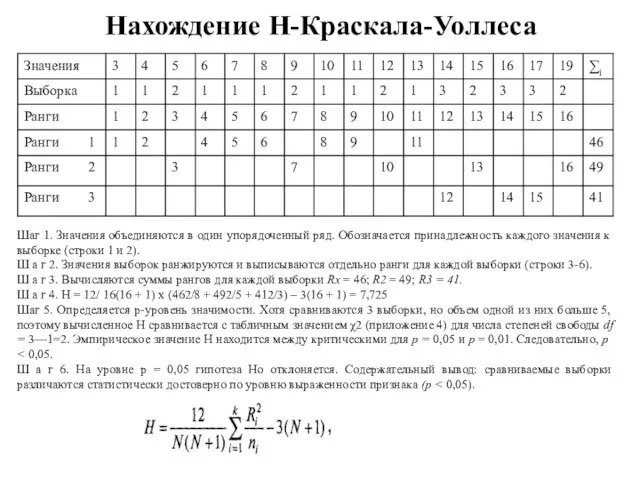

- 138. Нахождение Н-Краскала-Уоллеса Шаг 1. Значения объединяются в один упорядоченный ряд. Обозначается принадлежность каждого значения к выборке

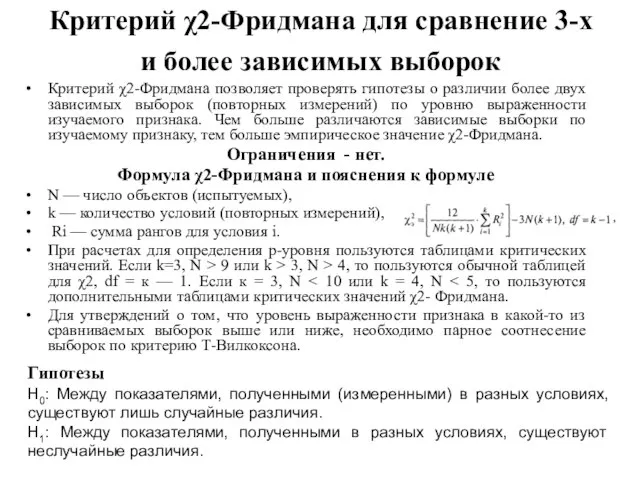

- 139. Критерий χ2-Фридмана для сравнение 3-х и более зависимых выборок Критерий χ2-Фридмана позволяет проверять гипотезы о различии

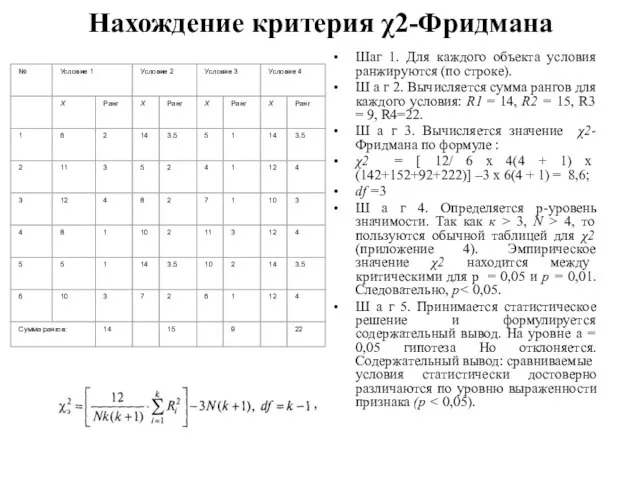

- 140. Нахождение критерия χ2-Фридмана Шаг 1. Для каждого объекта условия ранжируются (по строке). Ш а г 2.

- 141. Тема 14. Дисперсионный анализ (ANOVA) Однофакторный дисперсионный анализ ANOVA Методы множественного сравнения

- 142. Дисперсионный анализ ANOVA (от англоязычного ANalysis Of VАriance) Анализ предназначен для изучения различий у трех и

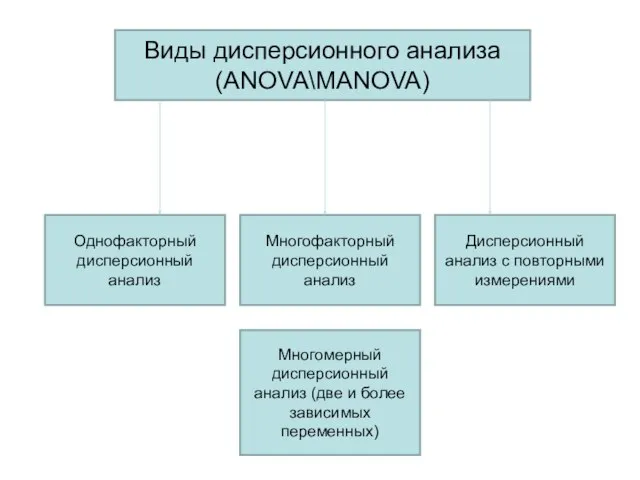

- 143. Виды дисперсионного анализа (ANOVA\MANOVA) Однофакторный дисперсионный анализ Многофакторный дисперсионный анализ Дисперсионный анализ с повторными измерениями Многомерный

- 144. Метод однофакторного дисперсионного анализа применяется в тех случаях, когда исследуются изменения результативного признака под влиянием изменяющихся

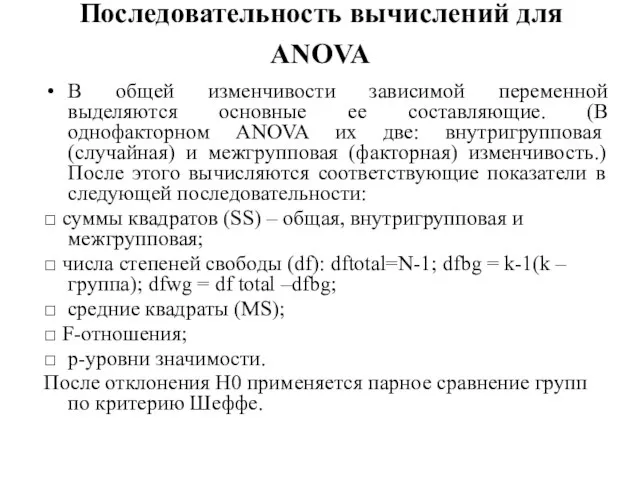

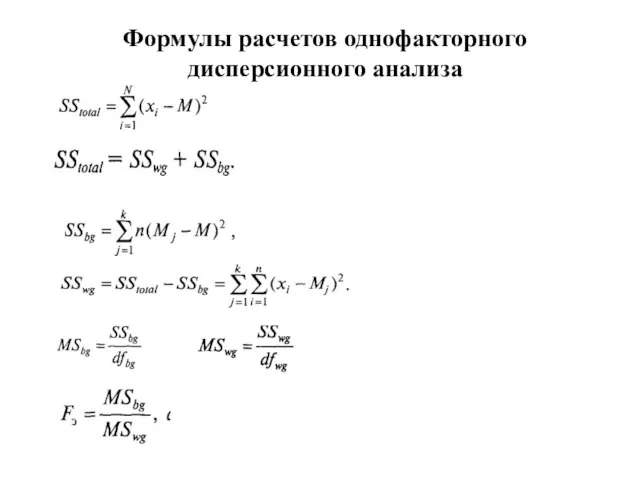

- 145. Последовательность вычислений для ANOVA В общей изменчивости зависимой переменной выделяются основные ее составляющие. (В однофакторном ANOVA

- 146. Формулы расчетов однофакторного дисперсионного анализа

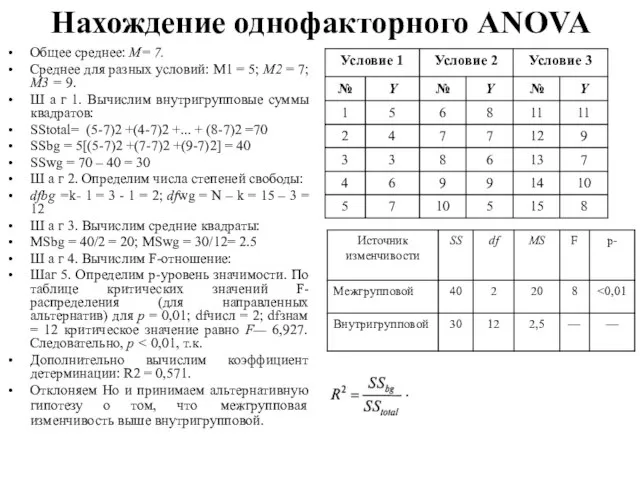

- 147. Нахождение однофакторного ANOVA Общее среднее: М= 7. Среднее для разных условий: М1 = 5; М2 =

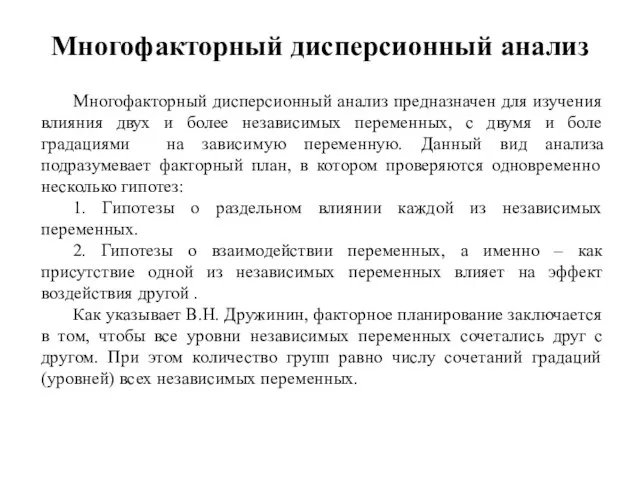

- 148. Многофакторный дисперсионный анализ Многофакторный дисперсионный анализ предназначен для изучения влияния двух и более независимых переменных, с

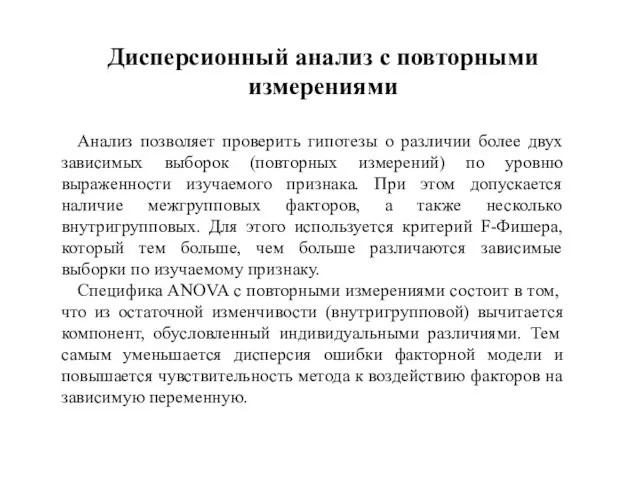

- 149. Дисперсионный анализ с повторными измерениями Анализ позволяет проверить гипотезы о различии более двух зависимых выборок (повторных

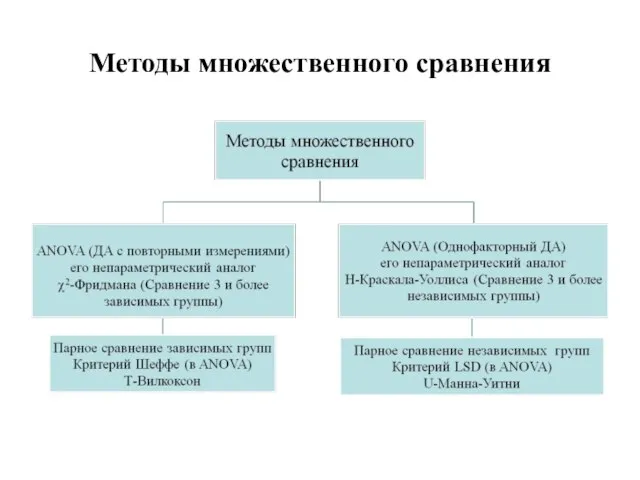

- 150. Методы множественного сравнения

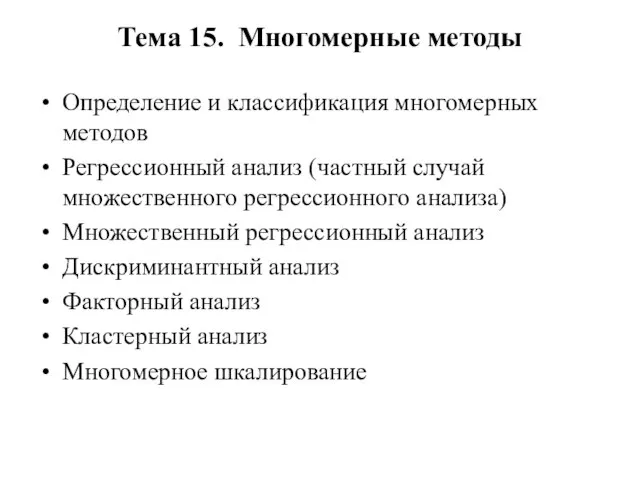

- 151. Тема 15. Многомерные методы Определение и классификация многомерных методов Регрессионный анализ (частный случай множественного регрессионного анализа)

- 152. Многомерные методы - это математические модели в отношении многостороннего (многомерного) описания изучаемых явлений. ММ воспроизводят мыслительные

- 153. Классификация многомерных методов

- 154. Регрессионный анализ (частный случай множественного регрессионного анализа) Регрессионный анализ — основан на коэффициенте детерминации. Регрессионный анализ

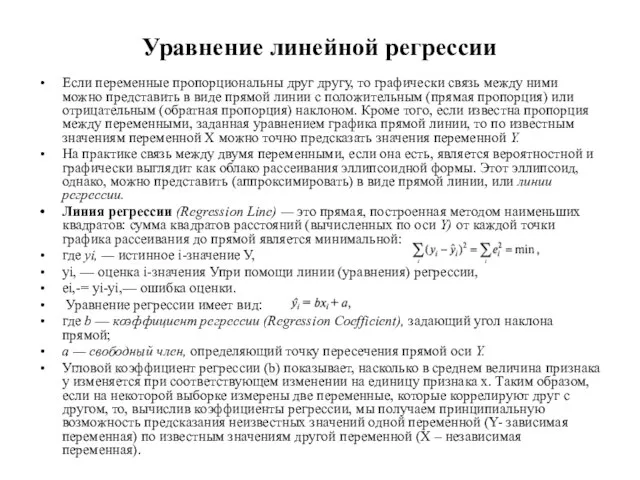

- 155. Уравнение линейной регрессии Если переменные пропорциональны друг другу, то графически связь между ними можно представить в

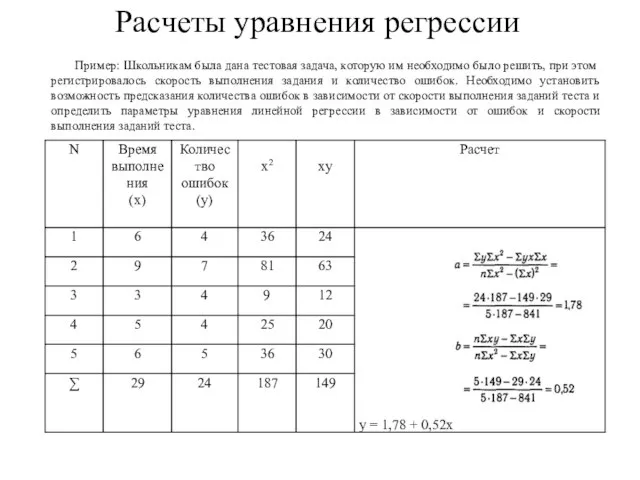

- 156. Расчеты уравнения регрессии Пример: Школьникам была дана тестовая задача, которую им необходимо было решить, при этом

- 157. Множественный регрессионный анализ Множественный регрессионный анализ (МРА) предназначен для изучения взаимосвязи одной переменной (зависимой, результирующей -

- 158. Основными целями МРА являются Определение того, в какой мере «зависимая» переменная связана с совокупностью «независимых» переменных,

- 159. Дискриминантный анализ Предназначен для изучения взаимосвязи одной переменной (зависимой, результирующей - у) и нескольких других переменных

- 160. Основные результаты дискриминантного анализа Определение статистической значимости различения классов при помощи данного набора дискриминантных переменных. Показатели

- 161. Факторный анализ Главная цель факторного анализа — уменьшение размерности исходных данных. Результатом факторного анализа является переход

- 162. Основные этапы факторного анализа Выбор исходных данных. Предварительное решение проблемы числа факторов: используются критерий отсеивания Р.

- 163. Кластерный анализ Кластерный анализ — это процедура упорядочивания объектов в сравнительно однородные классы на основе попарного

- 164. Этапы кластерного анализа 1. Отбор объектов для кластеризации. Объектами могут быть, в зависимости от цели исследования:

- 165. Многомерное шкалирование Основная цель многомерного шкалирования (МШ) — выявление структуры исследуемого множества объектов Главная задача МШ

- 166. Основные этапы многомерного шкалирования Определение величины стресса (φ-Stress), который является показателем точности - наиболее приемлемый для

- 167. Тема 16. Математическое моделирование в психологии Системные подходы. Теория функциональных систем. Становление кибернетики. Системный анализ. Теория

- 168. Моделирование Моделирование — это претендующее на адекватность построение и описание образа или символа действительности, некоторого аспекта

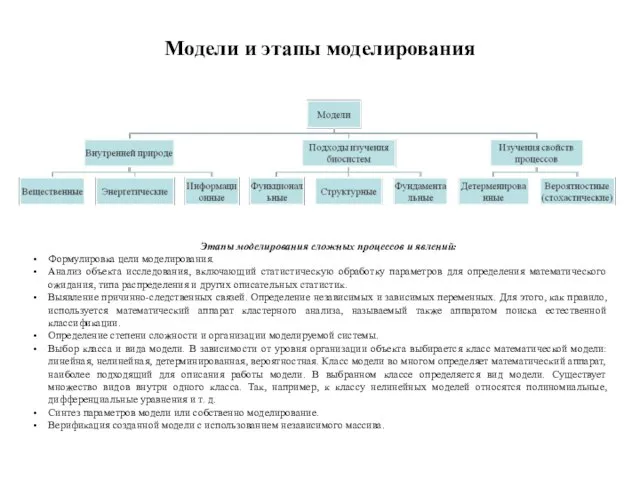

- 169. Модели и этапы моделирования Этапы моделирования сложных процессов и явлений: Формулировка цели моделирования. Анализ объекта исследования,

- 170. Психологические модели Модель И.П. Павлова И.П. Павлов выделяет целостный механизм анализатора включающий: периферическое, промежуточное и центральное

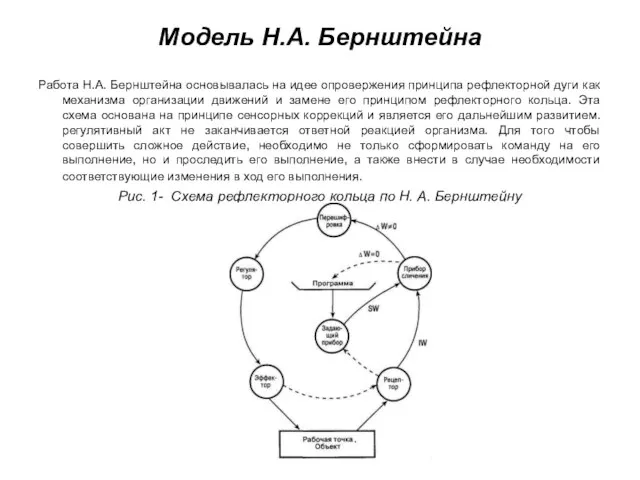

- 171. Модель Н.А. Бернштейна Работа Н.А. Бернштейна основывалась на идее опровержения принципа рефлекторной дуги как механизма организации

- 172. Модель К. Халла Американский ученый К. Халл рассматривал живой организм как саморегулируемую систему со специфическими механизмами

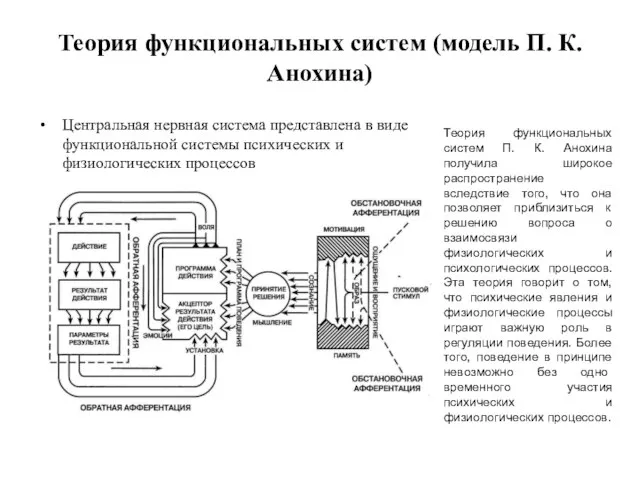

- 173. Теория функциональных систем (модель П. К. Анохина) Центральная нервная система представлена в виде функциональной системы психических

- 174. Модель А.Р. Лурии Так, А. Р. Лурия предложил выделить анатомически относительно автономные блоки головного мозга, обеспечивающие

- 175. Системный подход Система - множество элементов, находящихся в отношениях и связях друг с другом, которое образует

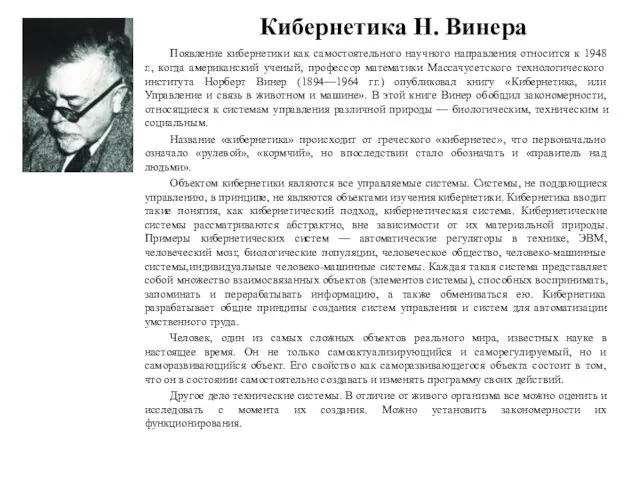

- 176. Кибернетика Н. Винера Появление кибернетики как самостоятельного научного направления относится к 1948 г., когда американский ученый,

- 177. Теория сигналов является центральной в кибернетике. Ее основными понятиями являются управляющий контур и информация. Управляющий контур

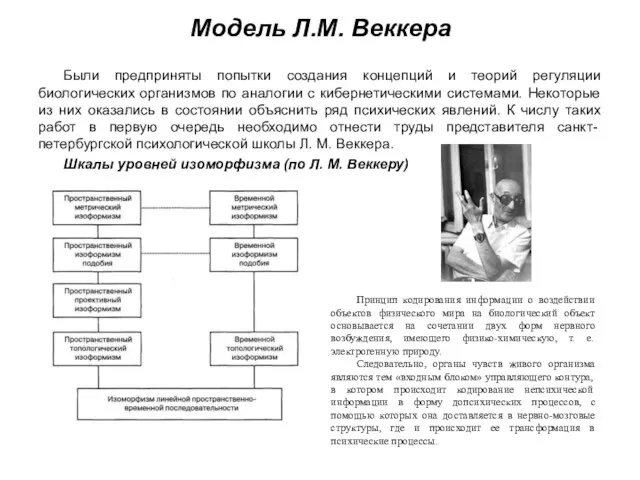

- 178. Модель Л.М. Веккера Были предприняты попытки создания концепций и теорий регуляции биологических организмов по аналогии с

- 179. Синергетика (Г. Хакена) Хакен Герман (Hermann Haken, род. 12 июля 1927 г.) — немецкий физик-теоретик, основатель

- 180. Общая теория систем Л. Фон Берталанфи Карл Людвиг фон Берталанфи (англ. Ludwig von Bertalanffy; 19 сентября

- 181. Теория развития И.Р. Пригожина Илья́ Рома́нович Приго́жин (фр. Ilya Prigogine; (12) 25 января 1917, Москва —

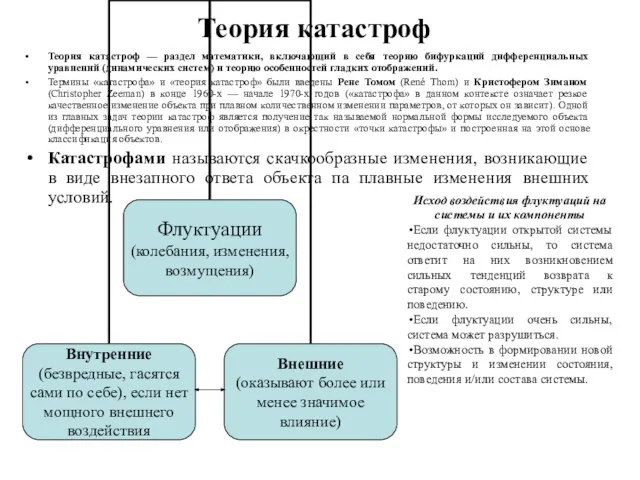

- 182. Теория катастроф Теория катастроф — раздел математики, включающий в себя теорию бифуркаций дифференциальных уравнений (динамических систем)

- 183. Системный анализ Системный анализ - научная дисциплина, разрабатывающая общие принципы исследования сложных объектов с учетом их

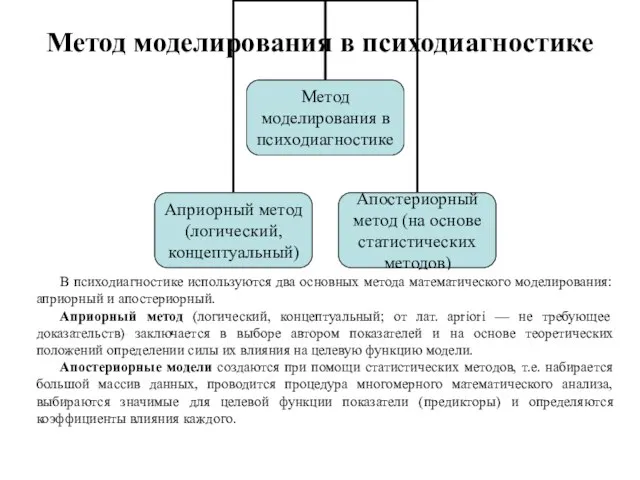

- 184. Метод моделирования в психодиагностике В психодиагностике используются два основных метода математического моделирования: априорный и апостериорный. Априорный

- 186. Скачать презентацию

Презентация на тему История герба России

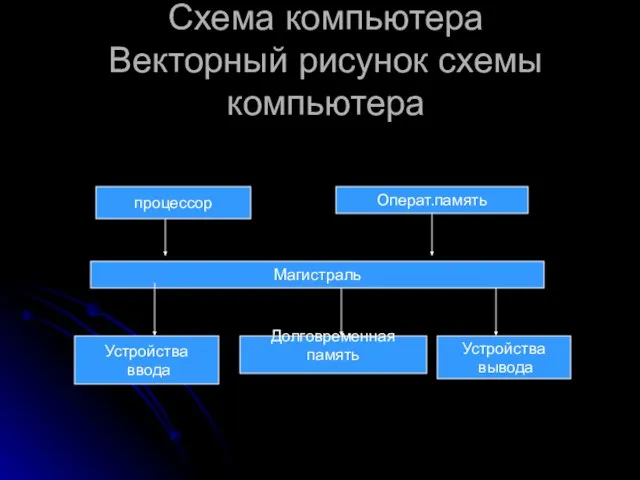

Презентация на тему История герба России Схема компьютера Векторный рисунок схемы компьютера

Схема компьютера Векторный рисунок схемы компьютера История Масленицы

История Масленицы Президент Российской Федерации (функции и полномочия по Конституции РФ)

Президент Российской Федерации (функции и полномочия по Конституции РФ) www.seo.euvva.com

www.seo.euvva.com Роль отраслевой дипломатии в обеспечении энергетической безопасности

Роль отраслевой дипломатии в обеспечении энергетической безопасности Плотность

Плотность Воспитательная деятельность учителя

Воспитательная деятельность учителя Отработка навыков турпроектирования на основе ценностных ориентиров потребителей

Отработка навыков турпроектирования на основе ценностных ориентиров потребителей Проект «Здоровый образ жизни»

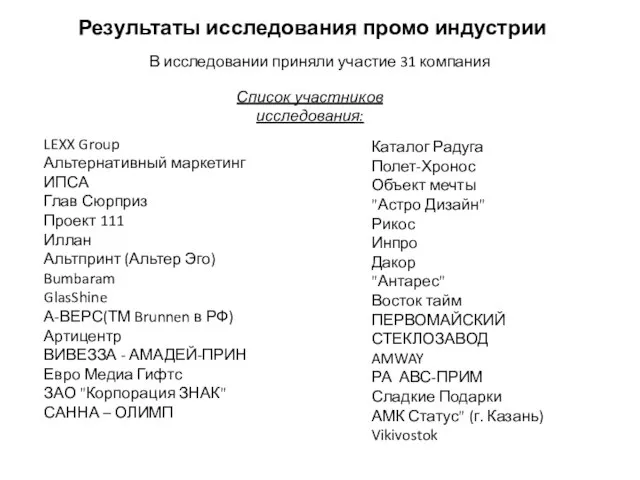

Проект «Здоровый образ жизни» Результаты исследования промо индустрии

Результаты исследования промо индустрии Новый год в открытках Алексея Исакова

Новый год в открытках Алексея Исакова КОКЛЮШ семинар Методические рекомендации по организации профилактических и противоэпидемических мероприятий по коклюшу

КОКЛЮШ семинар Методические рекомендации по организации профилактических и противоэпидемических мероприятий по коклюшу Языковые особенности в Квебеке

Языковые особенности в Квебеке ОРГАНИЗАЦИЯ ИССЛЕДОВАТЕЛЬСКОЙ ДЕЯТЕЛЬНОСТИДЕТЕЙ СТАРШЕГО ДОШКОЛЬНОГО ВОЗРАСТА

ОРГАНИЗАЦИЯ ИССЛЕДОВАТЕЛЬСКОЙ ДЕЯТЕЛЬНОСТИДЕТЕЙ СТАРШЕГО ДОШКОЛЬНОГО ВОЗРАСТА Подготовка к сочинению М. Ю. Лермонтов Мцыри

Подготовка к сочинению М. Ю. Лермонтов Мцыри Видеоадаптеры современных компьютеров

Видеоадаптеры современных компьютеров Планирование и исполнение расходов местных бюджетов РФ (на примере ЗАТО г. Островной Мурманской области)

Планирование и исполнение расходов местных бюджетов РФ (на примере ЗАТО г. Островной Мурманской области) Презентация на тему«Дельфы»

Презентация на тему«Дельфы» Громыко Алексей Олегович Компьютерное моделирование кинематики манипулятора промышленного робота Руководитель: доктор физ.-м

Громыко Алексей Олегович Компьютерное моделирование кинематики манипулятора промышленного робота Руководитель: доктор физ.-м Каша - пища наша

Каша - пища наша Понятие и признаки несостоятельности (банкротства)

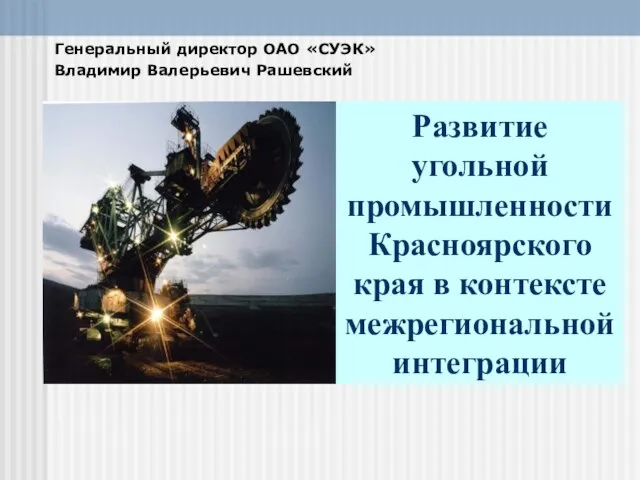

Понятие и признаки несостоятельности (банкротства) Развитие угольной промышленности Красноярского края в контексте межрегиональной интеграции

Развитие угольной промышленности Красноярского края в контексте межрегиональной интеграции Фабрика санитарно-гигиенических изделийКрупнейший производитель бумажной санитарно-гигиенической продукции в УкраинеТМ «Неж

Фабрика санитарно-гигиенических изделийКрупнейший производитель бумажной санитарно-гигиенической продукции в УкраинеТМ «Неж Оформим буклет

Оформим буклет Уважаемые Дамы и Господа! Холдинг «Западно-Европейский Финансовый Союз» - динамично развивающаяся группа компаний, предоставляющ

Уважаемые Дамы и Господа! Холдинг «Западно-Европейский Финансовый Союз» - динамично развивающаяся группа компаний, предоставляющ Направление Контроля

Направление Контроля Radical Chic создал платки по мотивам картин Верещагина. Интернет-магазин Третьяковской галереи

Radical Chic создал платки по мотивам картин Верещагина. Интернет-магазин Третьяковской галереи