Содержание

- 2. ПРОБЛЕМА БЫСТРОДЕЙСТВИЯ Фундаментальная задача современной науки и техники - достижение быстродействия компьютеров 1012 ÷1016 Flops и

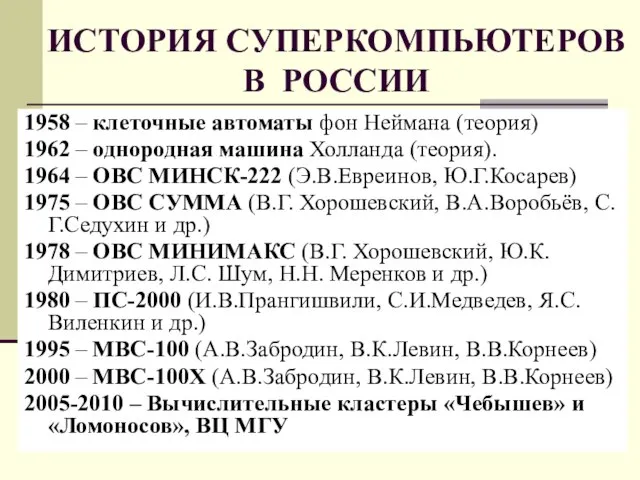

- 3. ИСТОРИЯ СУПЕРКОМПЬЮТЕРОВ В РОССИИ 1958 – клеточные автоматы фон Неймана (теория) 1962 – однородная машина Холланда

- 4. ПУТИ ПОВЫШЕНИЯ БЫСТРОДЕЙСТВИЯ 1. БУФЕРИЗАЦИЯ, обеспечивающая сглаживание потоков команд и данных. Буферизация применяется, в первую очередь,

- 5. ПУТИ ПОВЫШЕНИЯ БЫСТРОДЕЙСТВИЯ 2. КОНВЕЙЕРИЗАЦИЯ, позволяющая ускорить исполнение повторяющихся последовательностей действий при приемлемом увеличении оборудования. Наиболее

- 6. ПУТИ ПОВЫШЕНИЯ БЫСТРОДЕЙСТВИЯ 3. СТРУКТУРНАЯ РЕАЛИЗАЦИЯ, позволяющая настроить аппаратуру специально для решения данной задачи. Структурная (аппаратурная)

- 7. ПУТИ ПОВЫШЕНИЯ БЫСТРОДЕЙСТВИЯ 4. РАСПАРАЛЛЕЛИВАНИЕ, позволяющее максимально использовать естественный параллелизм вычислений и привлечь к вычислениям большое

- 8. ПУТИ ПОВЫШЕНИЯ БЫСТРОДЕЙСТВИЯ 5. БАЛАНСИРОВКА НАГРУЗКИ, то есть такое планирование работ, при котором вся аппаратура загружается

- 9. ИСТОЧНОКИ ПАРАЛЛЕЛИЗМА Существует два источника параллелизма 1. Независимые операторы алгоритма. 2. Независимые вычисления над разными данными.

- 10. СИЛА ПАРАЛЛЕЛИЗМА Пусть происходит умножение матриц C=A∙B размера (N×N). Тогда в каждом витке ijk-цикла выполняется cij

- 11. СИЛА ПАРАЛЛЕЛИЗМА 1. Работу всех N ² вычислителей над общей памятью. 2. Хранение в памяти каждого

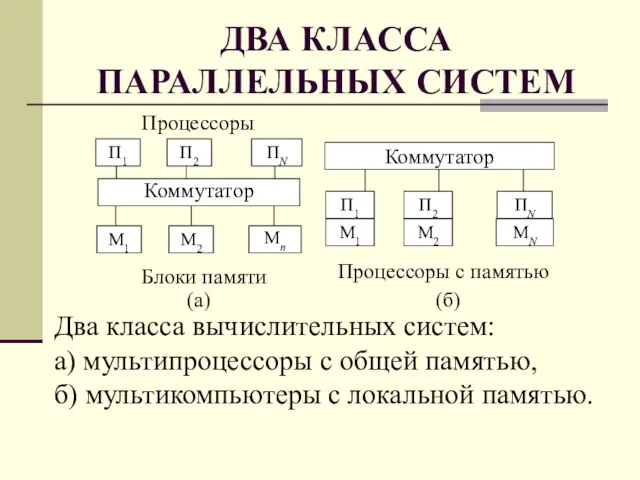

- 12. ДВА КЛАССА ПАРАЛЛЕЛЬНЫХ СИСТЕМ

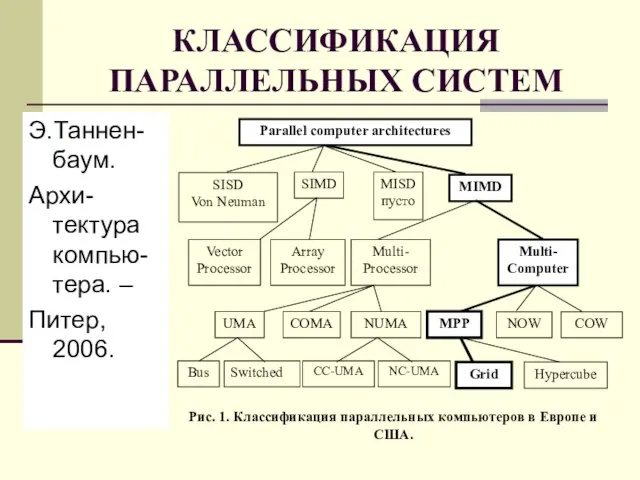

- 13. КЛАССИФИКАЦИЯ ПАРАЛЛЕЛЬНЫХ СИСТЕМ Э.Таннен-баум. Архи-тектура компью-тера. – Питер, 2006.

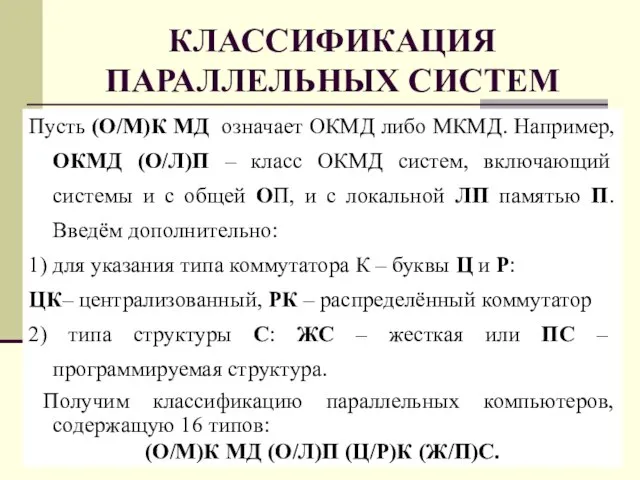

- 14. КЛАССИФИКАЦИЯ ПАРАЛЛЕЛЬНЫХ СИСТЕМ Пусть (О/М)К МД означает ОКМД либо МКМД. Например, ОКМД (О/Л)П – класс ОКМД

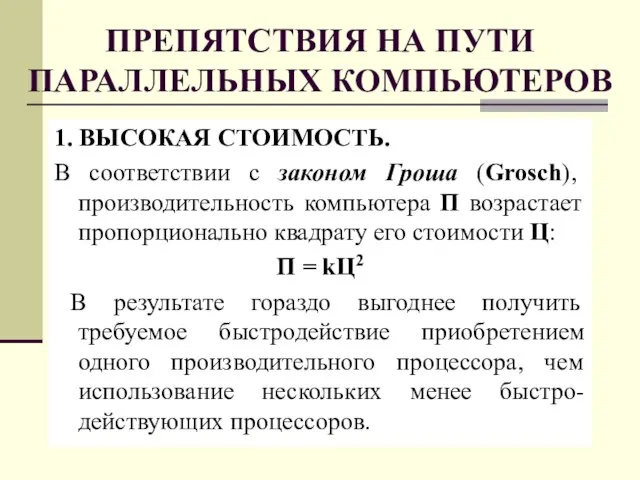

- 15. ПРЕПЯТСТВИЯ НА ПУТИ ПАРАЛЛЕЛЬНЫХ КОМПЬЮТЕРОВ 1. ВЫСОКАЯ СТОИМОСТЬ. В соответствии с законом Гроша (Grosch), производительность компьютера

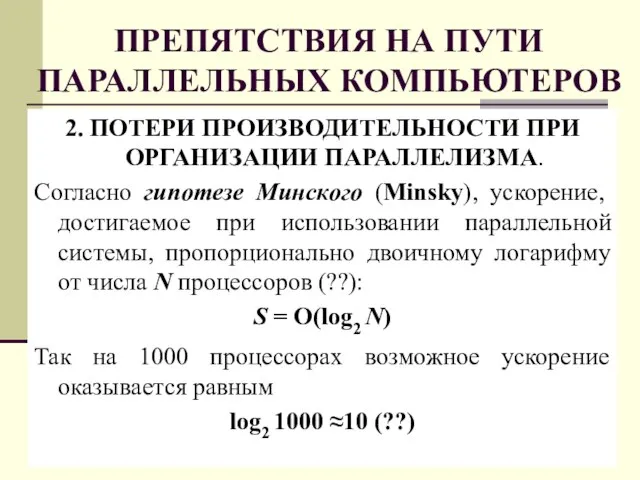

- 16. ПРЕПЯТСТВИЯ НА ПУТИ ПАРАЛЛЕЛЬНЫХ КОМПЬЮТЕРОВ 2. ПОТЕРИ ПРОИЗВОДИТЕЛЬНОСТИ ПРИ ОРГАНИЗАЦИИ ПАРАЛЛЕЛИЗМА. Согласно гипотезе Минского (Minsky), ускорение,

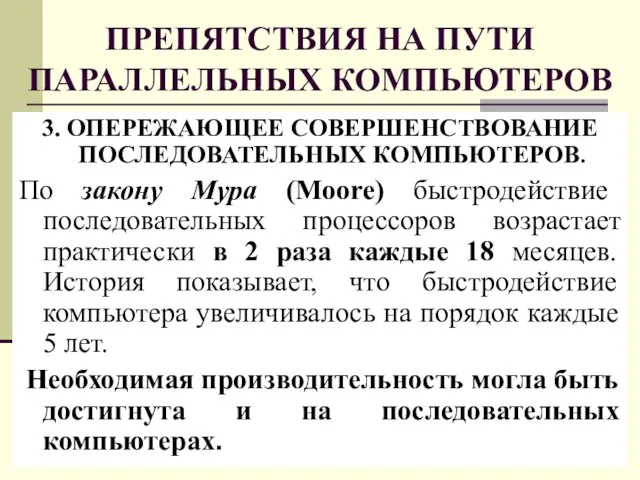

- 17. ПРЕПЯТСТВИЯ НА ПУТИ ПАРАЛЛЕЛЬНЫХ КОМПЬЮТЕРОВ 3. ОПЕРЕЖАЮЩЕЕ СОВЕРШЕНСТВОВАНИЕ ПОСЛЕДОВАТЕЛЬНЫХ КОМПЬЮТЕРОВ. По закону Мура (Moore) быстродействие последовательных

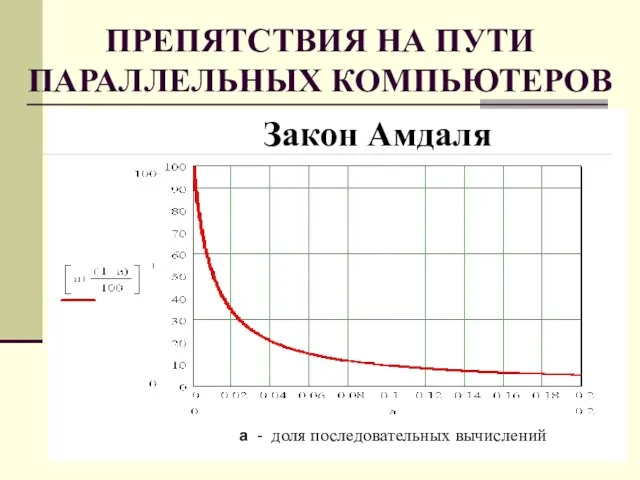

- 18. ПРЕПЯТСТВИЯ НА ПУТИ ПАРАЛЛЕЛЬНЫХ КОМПЬЮТЕРОВ 4. НЕИЗБЕЖНОСТЬ ПОСЛЕДОВАТЕЛЬНЫХ ВЫЧИСЛЕНИЙ. В соответствии с законом Амдаля (Amdahl) ускорение

- 19. ПРЕПЯТСТВИЯ НА ПУТИ ПАРАЛЛЕЛЬНЫХ КОМПЬЮТЕРОВ Закон Амдаля а - доля последовательных вычислений

- 20. ПРЕПЯТСТВИЯ НА ПУТИ ПАРАЛЛЕЛЬНЫХ КОМПЬЮТЕРОВ 5. ЗАВИСИМОСТЬ ЭФФЕКТИВНОСТИ ОТ СТРУКТУРЫ СИСТЕМЫ Параллельные системы отличаются существенным разнообразием

- 21. ПРЕПЯТСТВИЯ НА ПУТИ ПАРАЛЛЕЛЬНЫХ КОМПЬЮТЕРОВ 6. ОТСУТСТВИЕ ЭФФЕКТИВНОГО ПРОГРАММНОГО ОБЕСПЕЧЕНИЯ. Существующее программное обеспечение ориентировано, в основном,

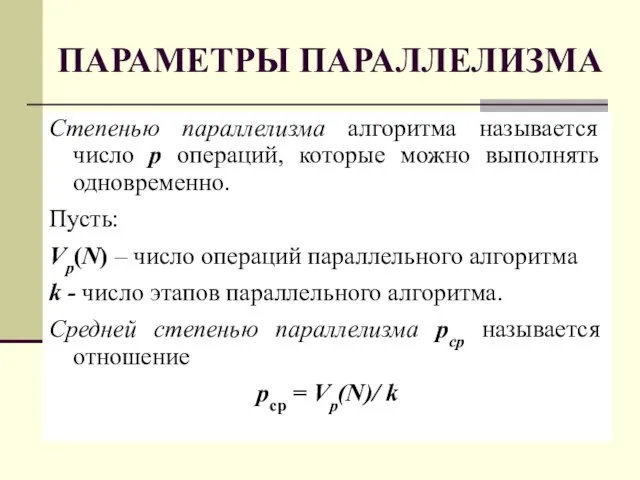

- 22. ПАРАМЕТРЫ ПАРАЛЛЕЛИЗМА Степенью параллелизма алгоритма называется число p операций, которые можно выполнять одновременно. Пусть: Vp(N) –

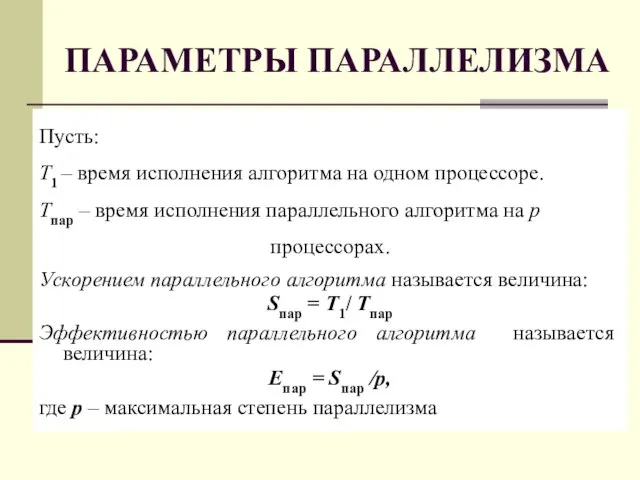

- 23. ПАРАМЕТРЫ ПАРАЛЛЕЛИЗМА Пусть: Т1 – время исполнения алгоритма на одном процессоре. Tпар – время исполнения параллельного

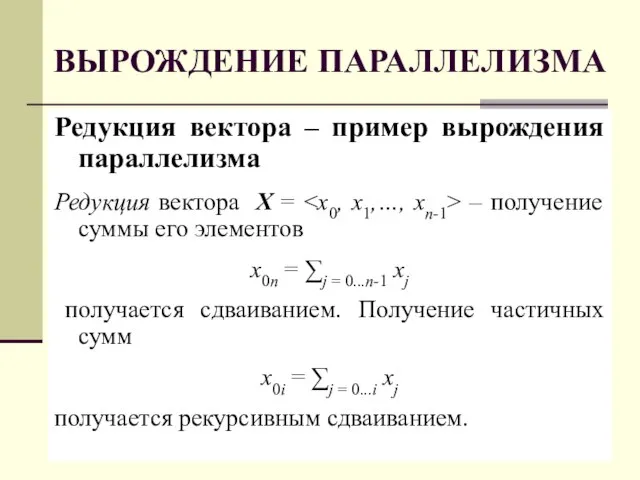

- 24. ВЫРОЖДЕНИЕ ПАРАЛЛЕЛИЗМА Редукция вектора – пример вырождения параллелизма Редукция вектора X = – получение суммы его

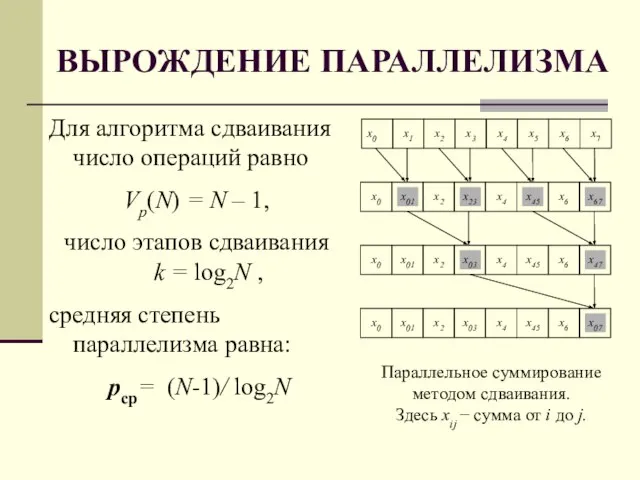

- 25. ВЫРОЖДЕНИЕ ПАРАЛЛЕЛИЗМА Для алгоритма сдваивания число операций равно Vp(N) = N – 1, число этапов сдваивания

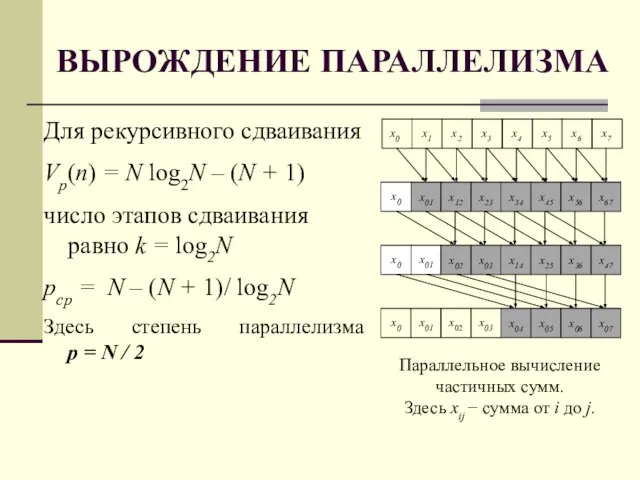

- 26. ВЫРОЖДЕНИЕ ПАРАЛЛЕЛИЗМА Для рекурсивного сдваивания Vp(n) = N log2N – (N + 1) число этапов сдваивания

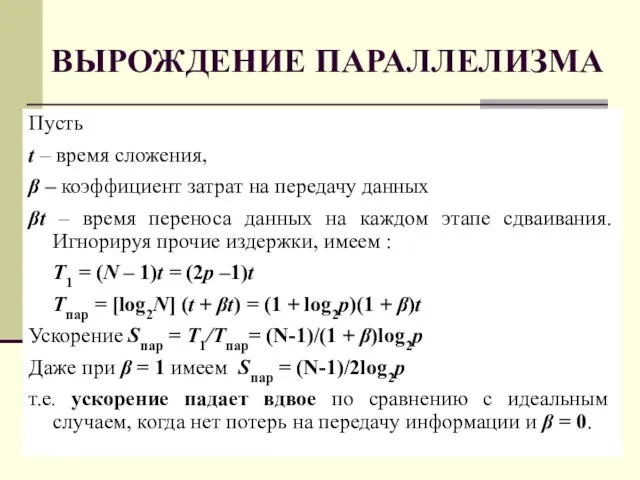

- 27. ВЫРОЖДЕНИЕ ПАРАЛЛЕЛИЗМА Пусть t – время сложения, β – коэффициент затрат на передачу данных βt –

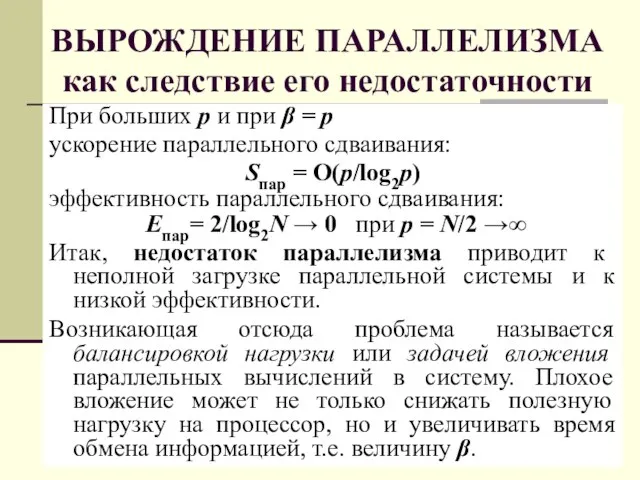

- 28. ВЫРОЖДЕНИЕ ПАРАЛЛЕЛИЗМА как следствие его недостаточности При больших p и при β = p ускорение параллельного

- 29. ФУНДАМЕНТАЛЬНЫЕ ПРЕДЕЛЫ ПРОИЗВОДИТЕЛЬНОСТИ Наблюдение за развитием современной вычислительной техники говорит о достижении ФУНДАМЕНТАЛЬНЫХ ПРЕДЕЛОВ роста производительности

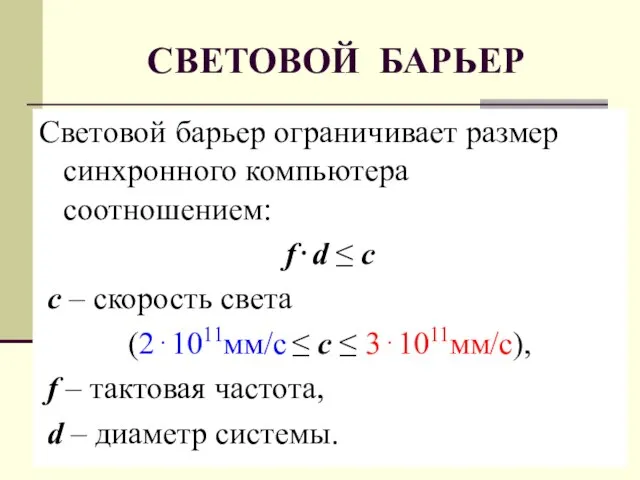

- 30. СВЕТОВОЙ БАРЬЕР Световой барьер ограничивает размер синхронного компьютера соотношением: f⋅d ≤ c с – скорость света

- 31. СВЕТОВОЙ И ТЕПЛОВОЙ БАРЬЕРЫ ТРИ НАПРАВЛЕНИЯ развития параллельных вычислительных систем: 1. Классическое 2. Технологическое 3. Релятивистское

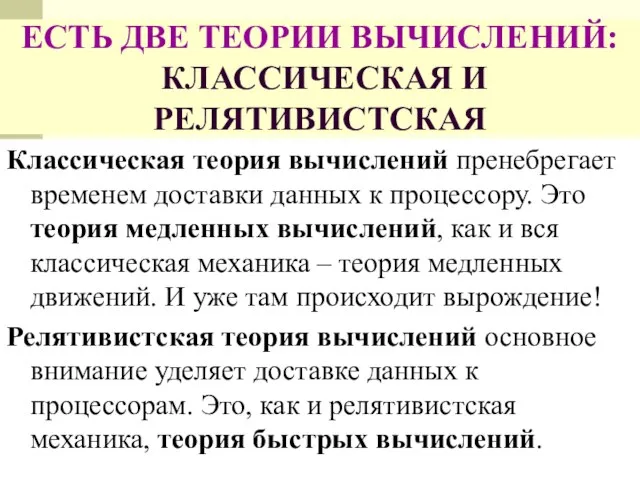

- 32. ЕСТЬ ДВЕ ТЕОРИИ ВЫЧИСЛЕНИЙ: КЛАССИЧЕСКАЯ И РЕЛЯТИВИСТСКАЯ Классическая теория вычислений пренебрегает временем доставки данных к процессору.

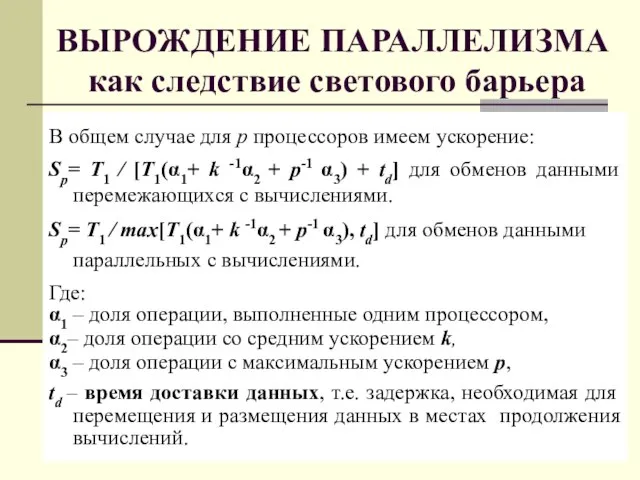

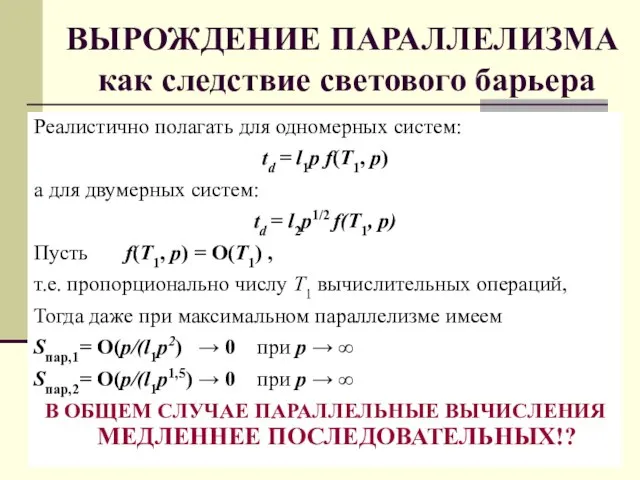

- 33. ВЫРОЖДЕНИЕ ПАРАЛЛЕЛИЗМА как следствие светового барьера В общем случае для p процессоров имеем ускорение: Sp= T1

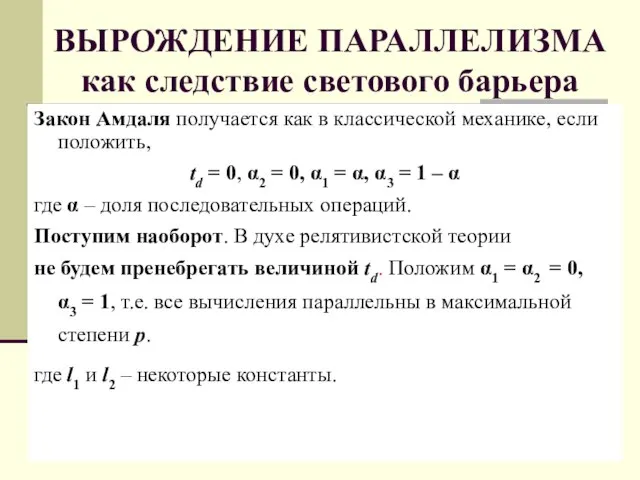

- 34. ВЫРОЖДЕНИЕ ПАРАЛЛЕЛИЗМА как следствие светового барьера Закон Амдаля получается как в классической механике, если положить, td

- 35. ВЫРОЖДЕНИЕ ПАРАЛЛЕЛИЗМА как следствие светового барьера Реалистично полагать для одномерных систем: td = l1p f(T1, p)

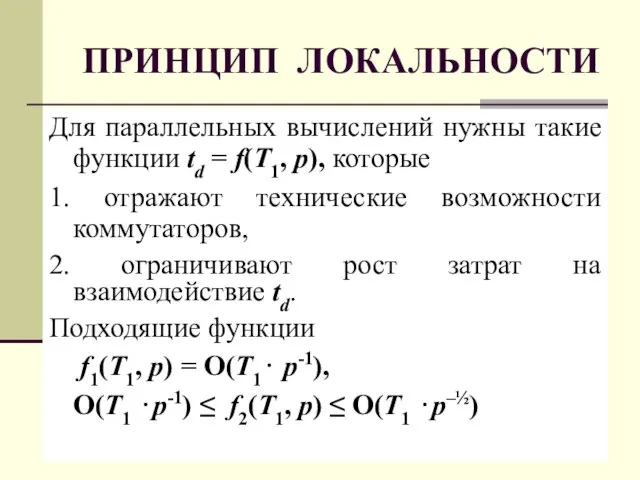

- 36. ПРИНЦИП ЛОКАЛЬНОСТИ Для параллельных вычислений нужны такие функции td = f(T1, p), которые 1. отражают технические

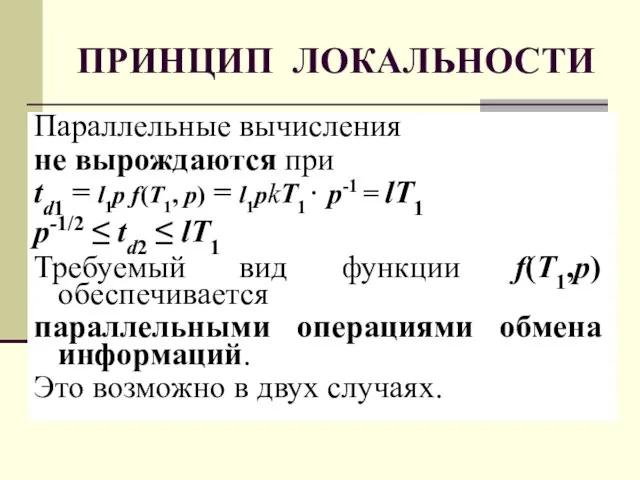

- 37. ПРИНЦИП ЛОКАЛЬНОСТИ Параллельные вычисления не вырождаются при td1 = l1p f(T1, p) = l1pkT1⋅ p-1 =

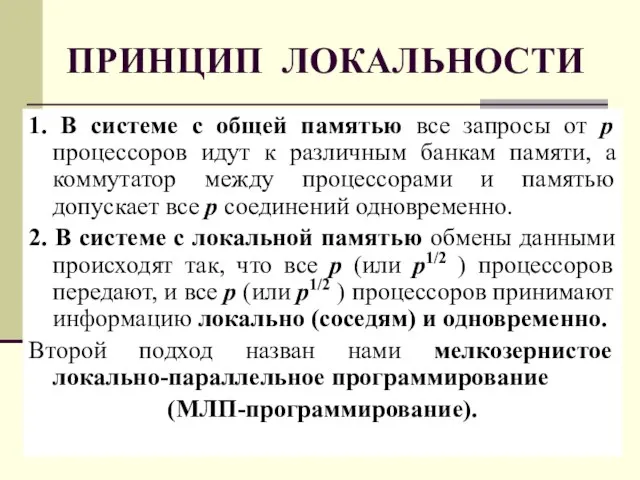

- 38. ПРИНЦИП ЛОКАЛЬНОСТИ 1. В системе с общей памятью все запросы от p процессоров идут к различным

- 39. КЛАССИЧЕСКИЕ КОММУТАТОРЫ Коммутатор – схема обеспечивающая соединение p входов и q выходов. Рис. 1 – разделённый

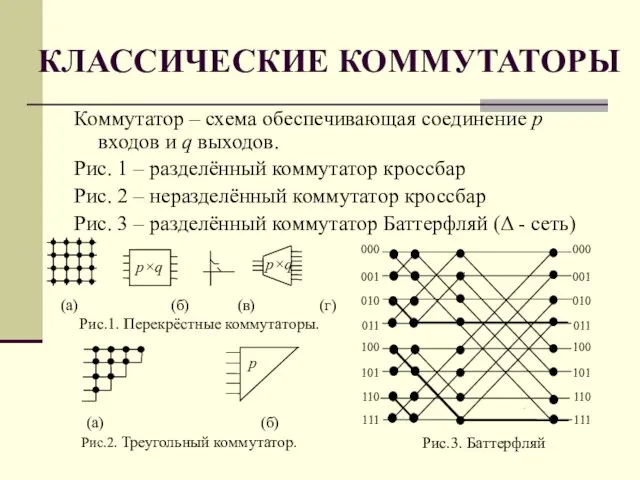

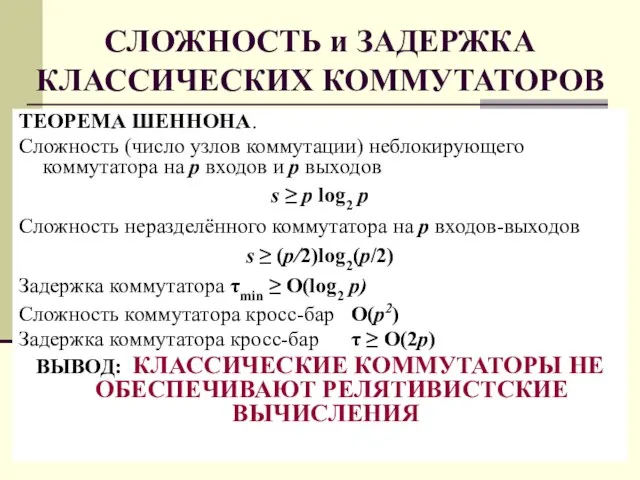

- 40. СЛОЖНОСТЬ и ЗАДЕРЖКА КЛАССИЧЕСКИХ КОММУТАТОРОВ ТЕОРЕМА ШЕННОНА. Сложность (число узлов коммутации) неблокирующего коммутатора на p входов

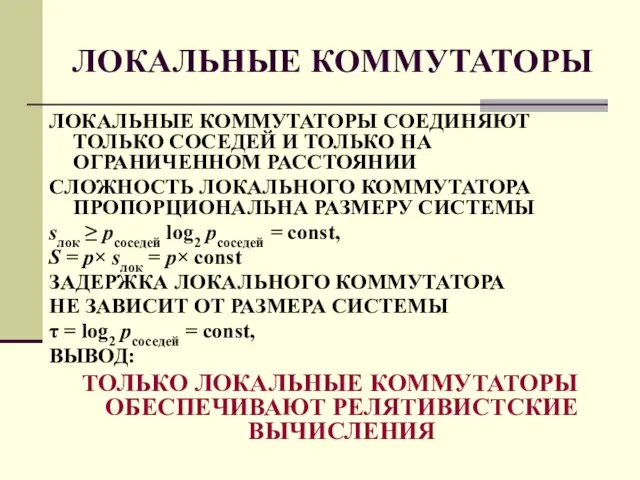

- 41. ЛОКАЛЬНЫЕ КОММУТАТОРЫ ЛОКАЛЬНЫЕ КОММУТАТОРЫ СОЕДИНЯЮТ ТОЛЬКО СОСЕДЕЙ И ТОЛЬКО НА ОГРАНИЧЕННОМ РАССТОЯНИИ СЛОЖНОСТЬ ЛОКАЛЬНОГО КОММУТАТОРА ПРОПОРЦИОНАЛЬНА

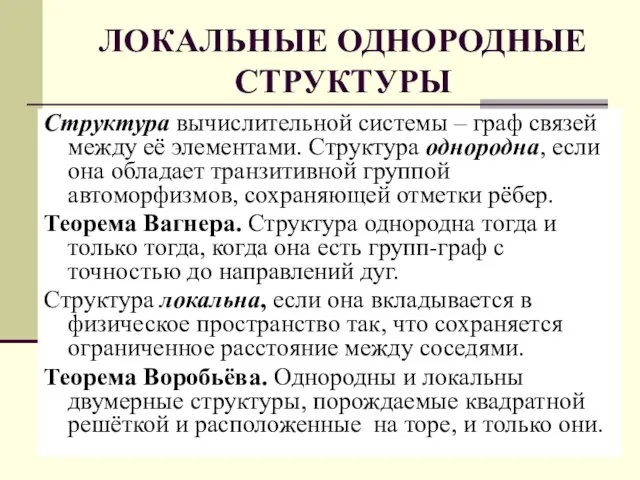

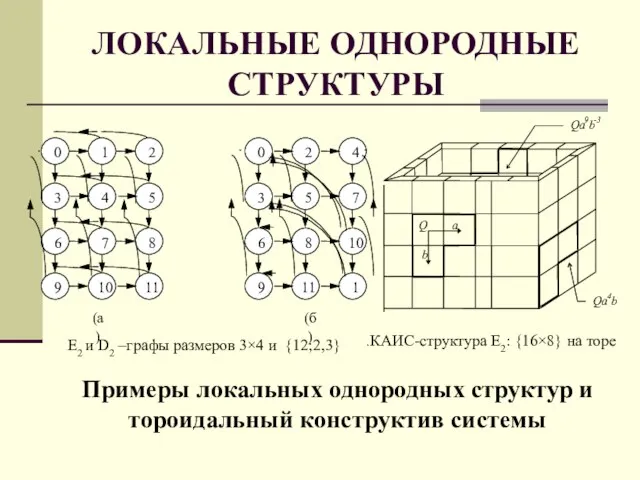

- 42. ЛОКАЛЬНЫЕ ОДНОРОДНЫЕ СТРУКТУРЫ Структура вычислительной системы – граф связей между её элементами. Структура однородна, если она

- 43. ЛОКАЛЬНЫЕ ОДНОРОДНЫЕ СТРУКТУРЫ Примеры локальных однородных структур и тороидальный конструктив системы Qa 4 b Qa 9

- 44. ПРОБЛЕМА РЕЛЯТИВИСТСКОГО КОМПЬЮТЕРА Релятивистский компьютер технически возможен поскольку: 1. Существуют локальные однородные структуры связей с линейной

- 45. РЕЛЯТИВИСТСКАЯ Однородная Вычислительная Система Архитектура ОВС на Неразрезных Процессорных Матрицах СБИС ПК - Мониторная подсистема на

- 46. РЕШАЮЩЕЕ ПОЛЕ – НЕРАЗРЕЗНАЯ ПРОЦЕССОРНАЯ МАТРИЦА СБИС Современная НАНОТЕХНОЛОГИЯ позволяет вплотную подойти к изготовлению неразрезных процессорных

- 47. КЛАССИЧЕСКАЯ ПАРАДИГМА ОТКАЗОУСТОЙЧИВОСТИ 1. Контролируемое и диагностируемое устройство присутствует в системе в единственном экземпляре. 2. Это

- 48. 1. Невозможность замены отказавших элементов; 2. Отказы не только процессорных элементов, но и связей между ними;

- 49. Указанные особенности СБИС создают принципиальные сложности и фундаментальные ограничения при производстве и обеспечения отказоустойчивости НПМ СБИС.

- 50. 1. Отказавшие ПЭ следует обходить, используя резервные элементы 2. Отказавшие связи следует заменять резервными связями. 3.

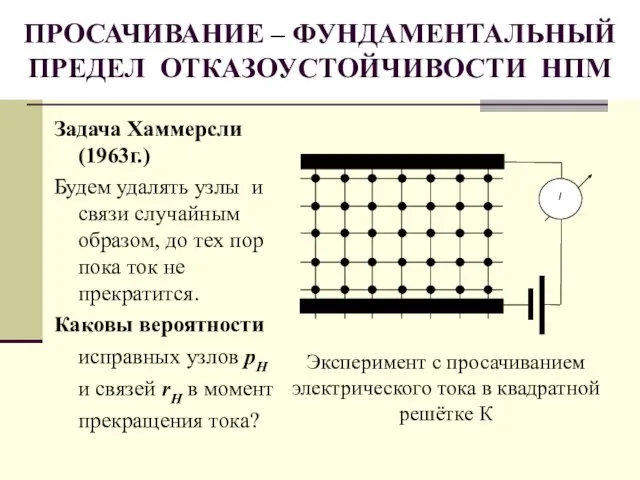

- 51. ПРОСАЧИВАНИЕ – ФУНДАМЕНТАЛЬНЫЙ ПРЕДЕЛ ОТКАЗОУСТОЙЧИВОСТИ НПМ Задача Хаммерсли (1963г.) Будем удалять узлы и связи случайным образом,

- 52. КРИТЕРИЙ ПРОСАЧИВАНИЯ (ПЕРКОЛЯЦИИ) Пусть на множестве локальных однородных структур одного типа, вложенных в R2 с абсолютно

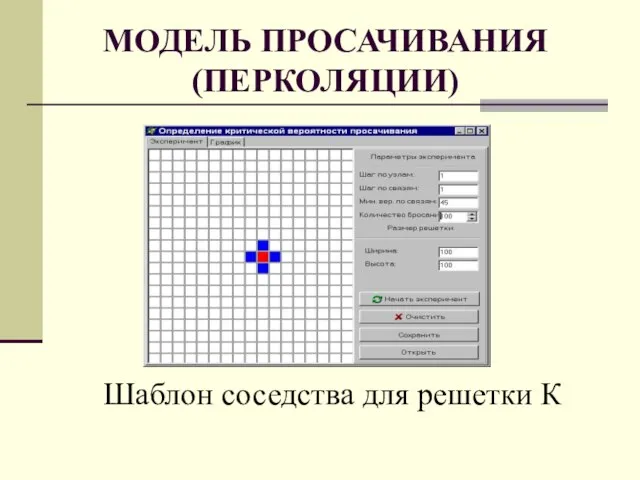

- 53. МОДЕЛЬ ПРОСАЧИВАНИЯ (ПЕРКОЛЯЦИИ) Шаблон соседства для решетки К

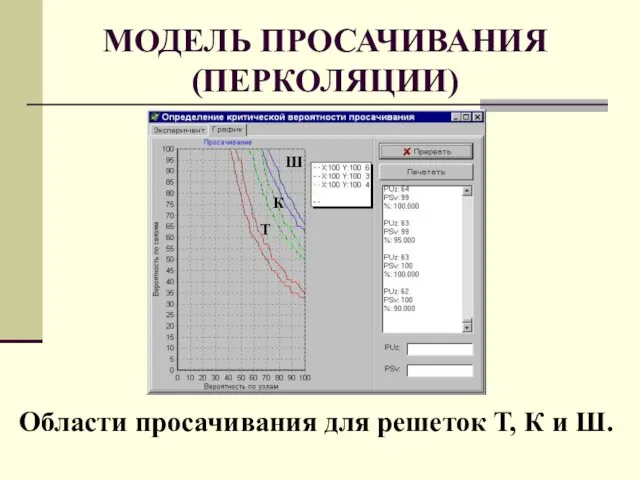

- 54. МОДЕЛЬ ПРОСАЧИВАНИЯ (ПЕРКОЛЯЦИИ)

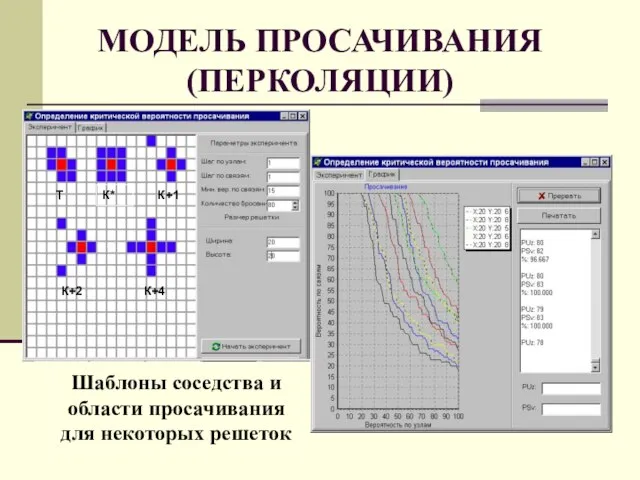

- 55. МОДЕЛЬ ПРОСАЧИВАНИЯ (ПЕРКОЛЯЦИИ) Шаблоны соседства и области просачивания для некоторых решеток

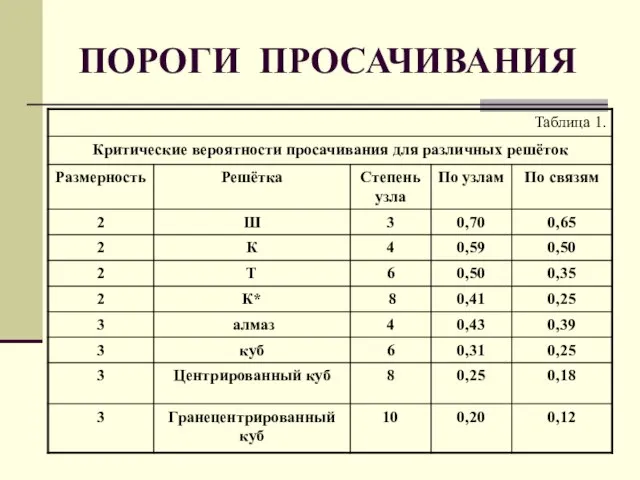

- 56. ПОРОГИ ПРОСАЧИВАНИЯ

- 57. ДИНАМИЧЕСКАЯ МОДЕЛЬ ОТКАЗОУСТОЙЧИВОСТИ НПМ Пусть время безотказного функционирования ЭМ распределено по экспоненциальному закону с параметром α

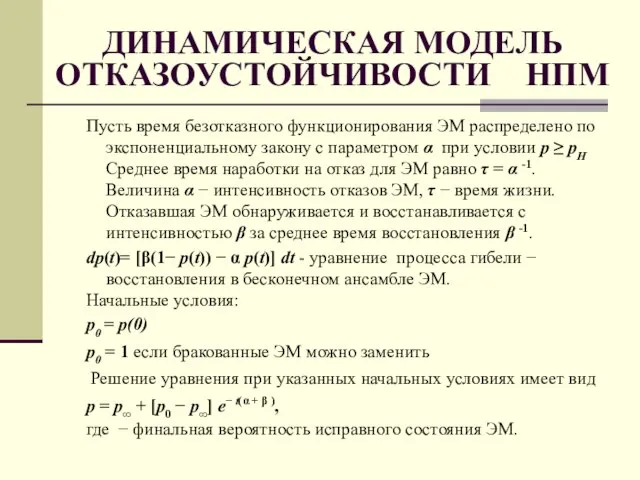

- 58. ОТКАЗОУСТОЙЧИВОСТЬ НПМ БЕЗ ВОССТАНОВЛЕНИЯ Утверждение 2. Время существования бесконечного исправного кластера в локальной однородной структуре без

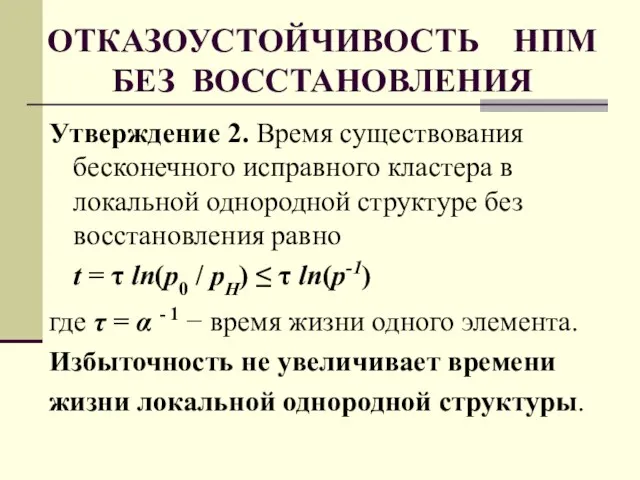

- 59. РЕКОНФИГУРАЦИЯ НПМ по САМИ и СТЕФАНЕЛЛИ Сами и Стефанелли предложили несколько алгоритмов реконфигурации НПМ для обхода

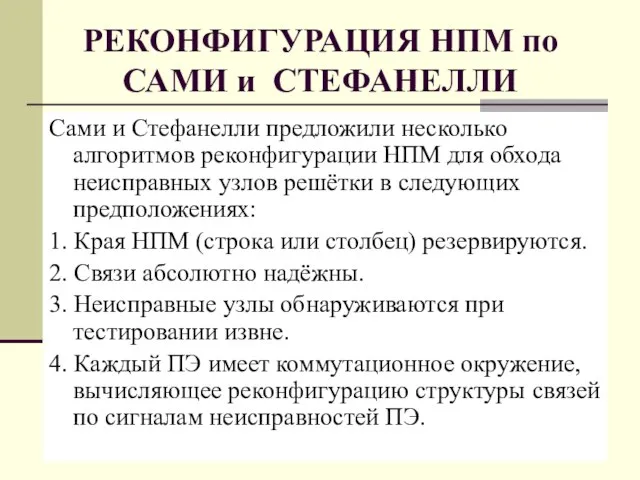

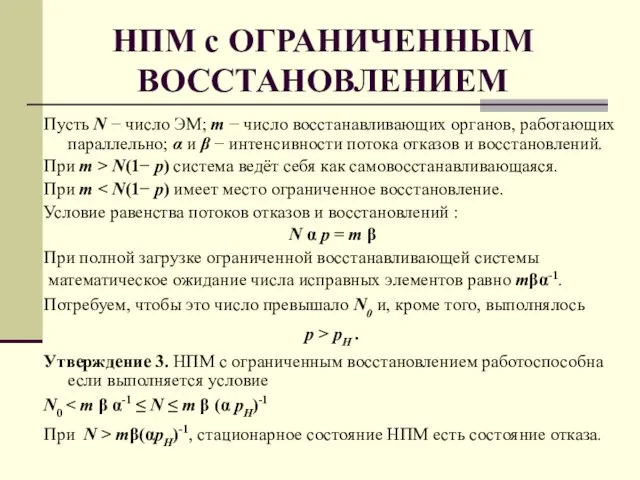

- 60. НПМ с ОГРАНИЧЕННЫМ ВОССТАНОВЛЕНИЕМ Пусть N − число ЭМ; m − число восстанавливающих органов, работающих параллельно;

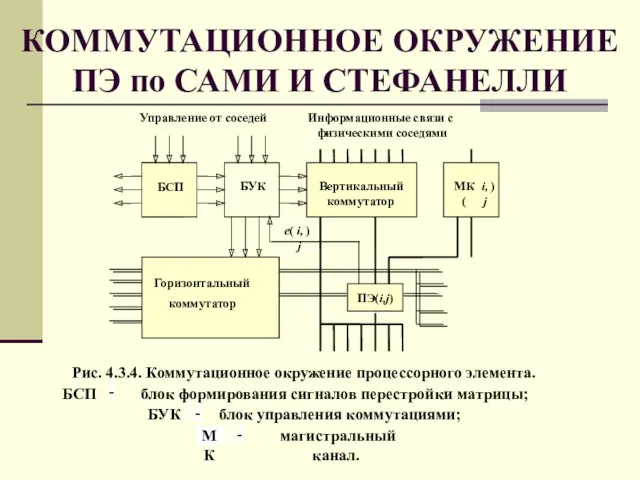

- 61. КОММУТАЦИОННОЕ ОКРУЖЕНИЕ ПЭ по САМИ И СТЕФАНЕЛЛИ

- 62. РЕЗЕРВНЫЕ СВЯЗИ ПЭ по Сами и Стефанелли

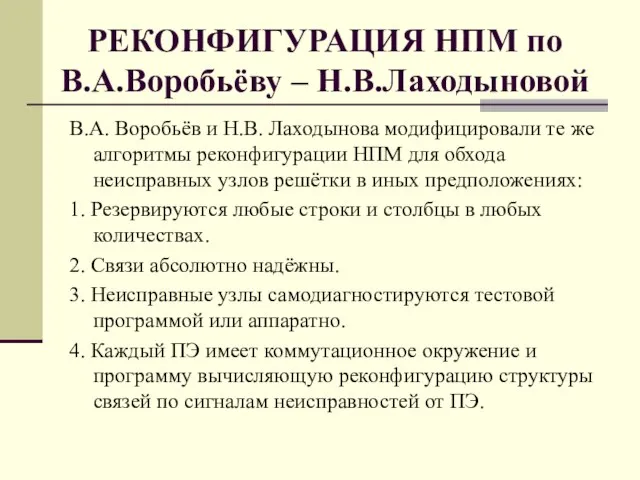

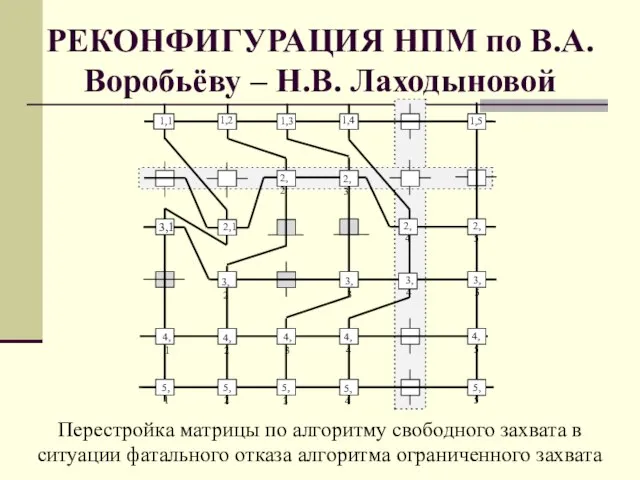

- 63. РЕКОНФИГУРАЦИЯ НПМ по В.А.Воробьёву – Н.В.Лаходыновой В.А. Воробьёв и Н.В. Лаходынова модифицировали те же алгоритмы реконфигурации

- 64. КОММУТАЦИОННОЕ ОКРУЖЕНИЕ по В.А.Воробьёву– Н.В.Лаходыновой

- 65. РЕКОНФИГУРАЦИЯ НПМ по В.А. Воробьёву – Н.В. Лаходыновой

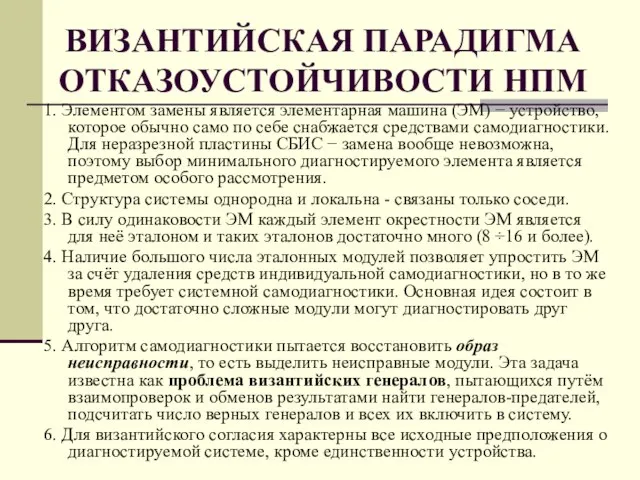

- 66. ВИЗАНТИЙСКАЯ ПАРАДИГМА ОТКАЗОУСТОЙЧИВОСТИ НПМ 1. Элементом замены является элементарная машина (ЭМ) − устройство, которое обычно само

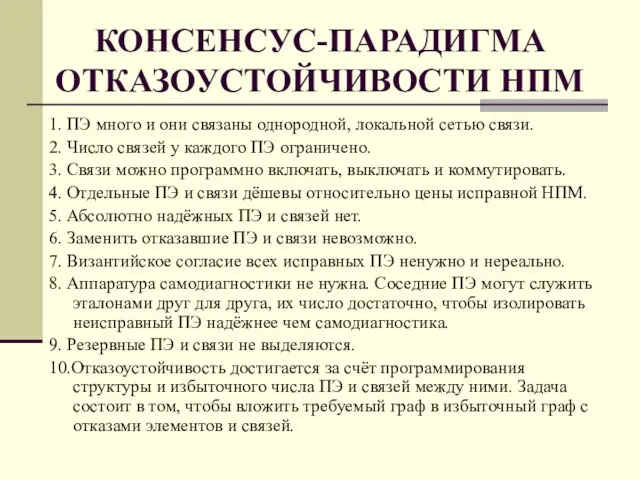

- 67. КОНСЕНСУС-ПАРАДИГМА ОТКАЗОУСТОЙЧИВОСТИ НПМ 1. ПЭ много и они связаны однородной, локальной сетью связи. 2. Число связей

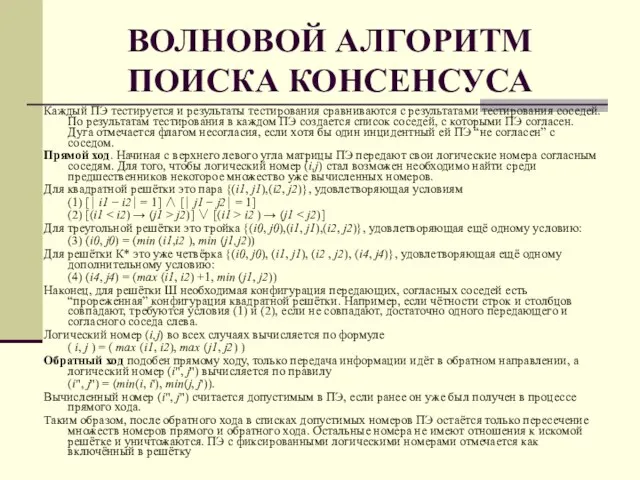

- 68. ВОЛНОВОЙ АЛГОРИТМ ПОИСКА КОНСЕНСУСА Каждый ПЭ тестируется и результаты тестирования сравниваются с результатами тестирования соседей. По

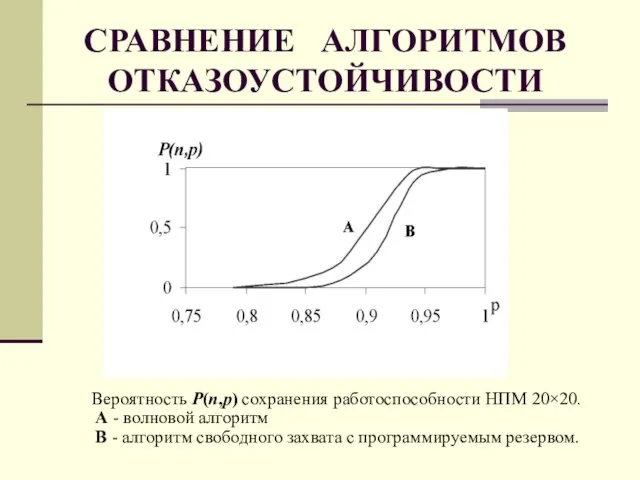

- 69. СРАВНЕНИЕ АЛГОРИТМОВ ОТКАЗОУСТОЙЧИВОСТИ Вероятность P(n,p) сохранения работоспособности НПМ 20×20. А - волновой алгоритм В - алгоритм

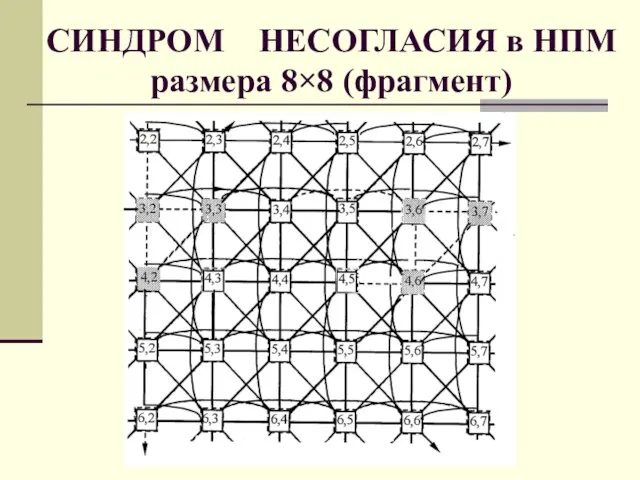

- 70. СИНДРОМ НЕСОГЛАСИЯ в НПМ размера 8×8 (фрагмент)

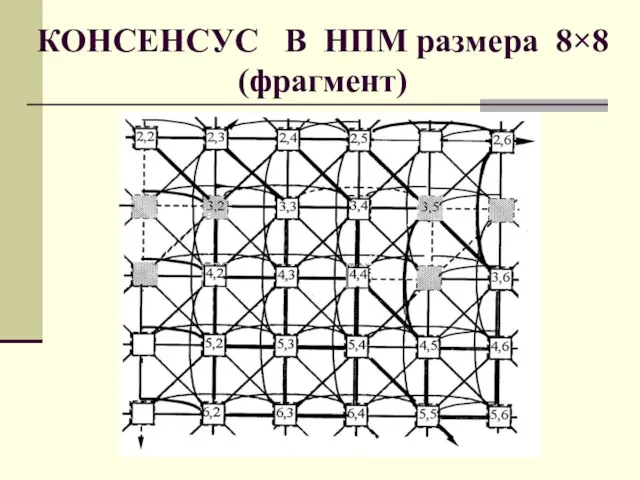

- 71. КОНСЕНСУС В НПМ размера 8×8 (фрагмент)

- 72. 1. Выполняется на локальных однородных структурах 2. Параллелизм максимален 3. Объём данных и вычислений в ЭМ

- 73. суммирует параллельно N строк за время Nt с ускорением (N−1) и эффективностью (N −1)/N →1 при

- 74. МЛП-УМНОЖЕНИЕ МАТРИЦ Одним из примеров мелкозернистого распараллеливания может служить умножение матриц размера n2 при использовании n2

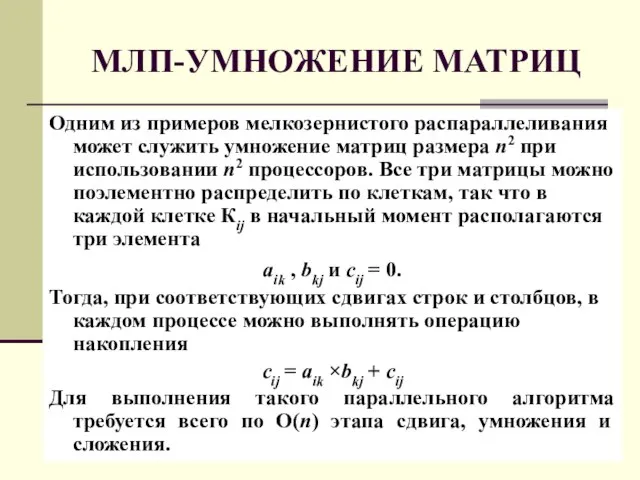

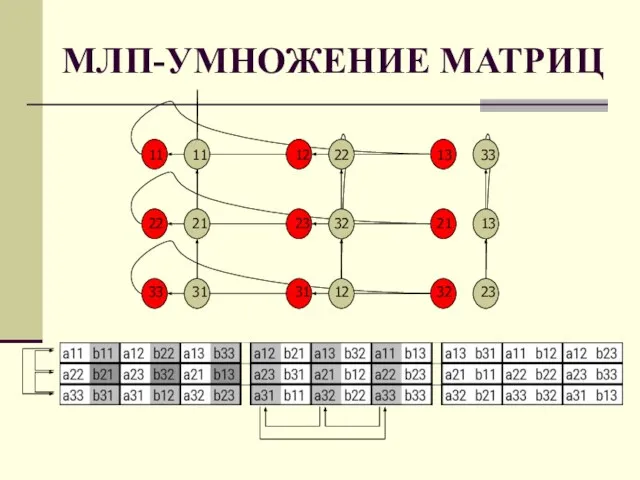

- 75. МЛП-УМНОЖЕНИЕ МАТРИЦ

- 76. ОЦЕНКА МЛП-умножения матриц Сложность параллельного алгоритма O(n). Процесс вычислений состоит из 3-х команд: 1. пересылка исходных

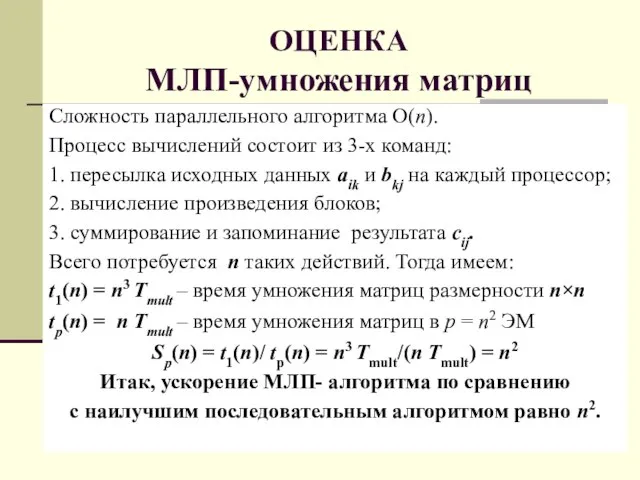

- 78. Скачать презентацию

Презентация на тему Моё солнышко

Презентация на тему Моё солнышко Проект по теме Россия в первой половине 19 века

Проект по теме Россия в первой половине 19 века Начальная военная подготовка. Занятие 1

Начальная военная подготовка. Занятие 1 Здоровье – это вершина, на которую каждый должен подняться сам

Здоровье – это вершина, на которую каждый должен подняться сам ЗОНА УЧАЩИХСЯ ЗОНА УЧИТЕЛЕЙ ЗОНА РОДИТЕЛЕЙ ИНФОРМАЦИОННАЯ ЗОНА.

ЗОНА УЧАЩИХСЯ ЗОНА УЧИТЕЛЕЙ ЗОНА РОДИТЕЛЕЙ ИНФОРМАЦИОННАЯ ЗОНА. Риторическая компетенция как ведущее средство образования

Риторическая компетенция как ведущее средство образования Управление ассортиментом яиц, реализуемых в торговом предприятии

Управление ассортиментом яиц, реализуемых в торговом предприятии "Счастливый случай"

"Счастливый случай" Кой се страхува от сладката овчица?

Кой се страхува от сладката овчица? Подготовка к Крещению 2022

Подготовка к Крещению 2022 Twitter и геоинформационные сервисы – неиспользованные возможности

Twitter и геоинформационные сервисы – неиспользованные возможности A city of great opportunities

A city of great opportunities Задача создания инновационных кластеров в Санкт-Петербурге в контексте зарубежного опыта

Задача создания инновационных кластеров в Санкт-Петербурге в контексте зарубежного опыта Реализация пилотного проекта Цифровой РЭС – Крымэнерго

Реализация пилотного проекта Цифровой РЭС – Крымэнерго 8608_1_0

8608_1_0 Презентация на тему Старинные меры длины и веса

Презентация на тему Старинные меры длины и веса  Планирование. Приступаем к планированию

Планирование. Приступаем к планированию Анализ информации в изображении

Анализ информации в изображении Технология автоматической векторизации рельефа средствами ArcGIS при создании цифровой модели рельефа для ЦБКММ (на примере района

Технология автоматической векторизации рельефа средствами ArcGIS при создании цифровой модели рельефа для ЦБКММ (на примере района  Появление инея в природе

Появление инея в природе Презентация на тему Аутоиммунитет

Презентация на тему Аутоиммунитет  Компьютерная память

Компьютерная память Воздушный транспорт

Воздушный транспорт Назначение керамики

Назначение керамики Этикет. Правила этикета

Этикет. Правила этикета НАШИ ПЕРНАТЫЕ ДРУЗЬЯ

НАШИ ПЕРНАТЫЕ ДРУЗЬЯ Бюджет для граждан МО город Узловая

Бюджет для граждан МО город Узловая Валютные отношения и валютные системы

Валютные отношения и валютные системы