Содержание

- 2. Вызовы: ● Сложность создаваемых систем (авиационная и космическая промышленность, атомная энергетика, кораблестроение, автомобильная промышленность и др.)

- 3. Традиционный научно-технический подход: 1) Разработка теории или проектирование на бумаге 2) Поставить эксперименты или построить систему

- 4. Пример: Глобальное предсказание погоды Территория России 17,075,200 км2. Пусть атмосфера над территорией России разделена на ячейки

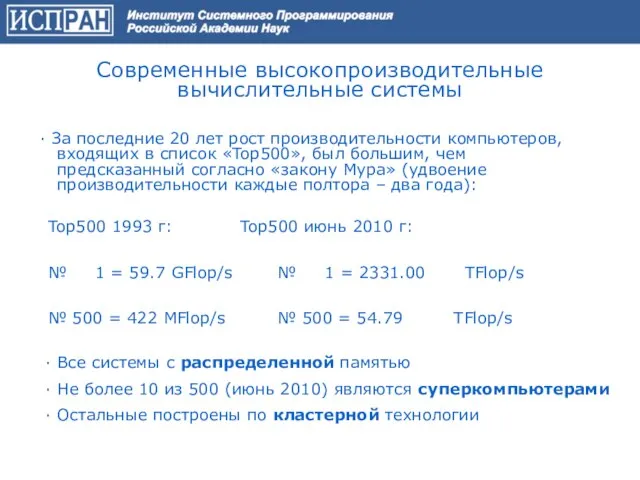

- 5. Современные высокопроизводительные вычислительные системы ∙ За последние 20 лет рост производительности компьютеров, входящих в список «Top500»,

- 6. Высокопроизводительный кластер (I)

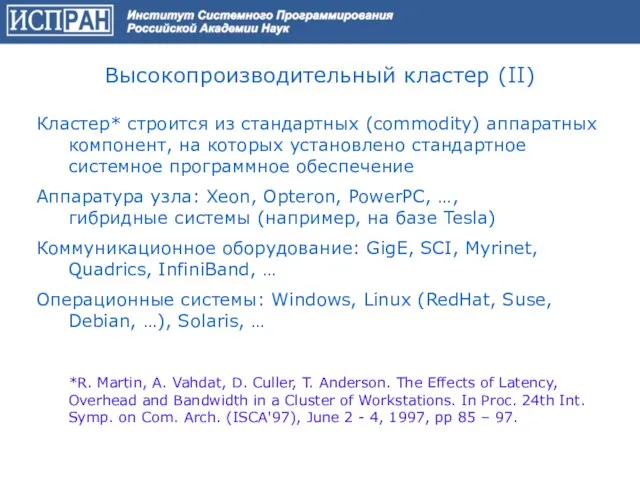

- 7. Кластер* строится из стандартных (commodity) аппаратных компонент, на которых установлено стандартное системное программное обеспечение Аппаратура узла:

- 8. Высокопроизводительный кластер (III) За счет чего достигается рост производительности: ● рост производительности узлов ● развитие сети

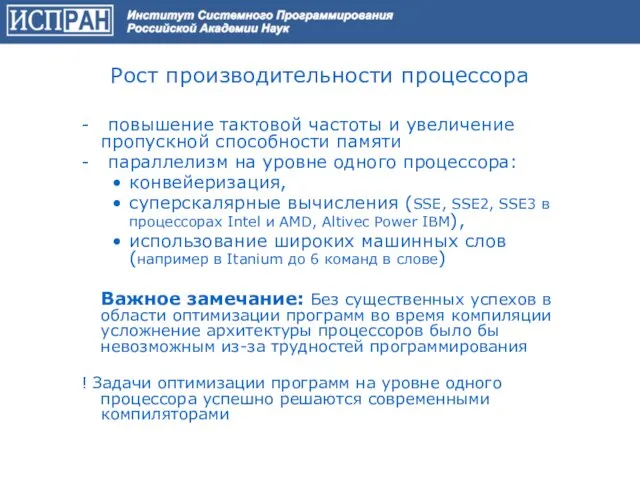

- 9. Рост производительности процессора - повышение тактовой частоты и увеличение пропускной способности памяти - параллелизм на уровне

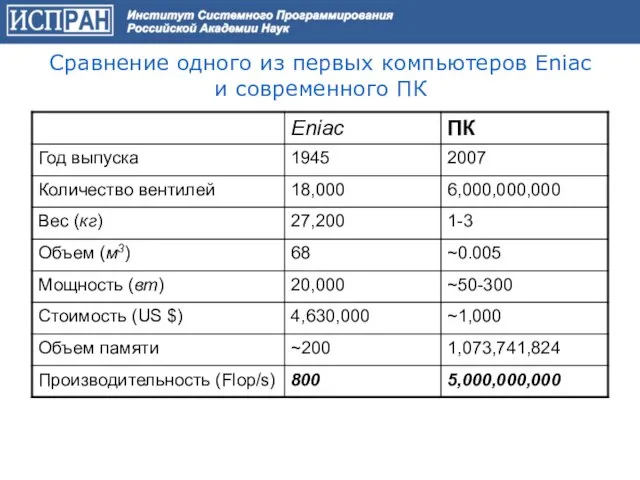

- 10. Сравнение одного из первых компьютеров Eniac и современного ПК

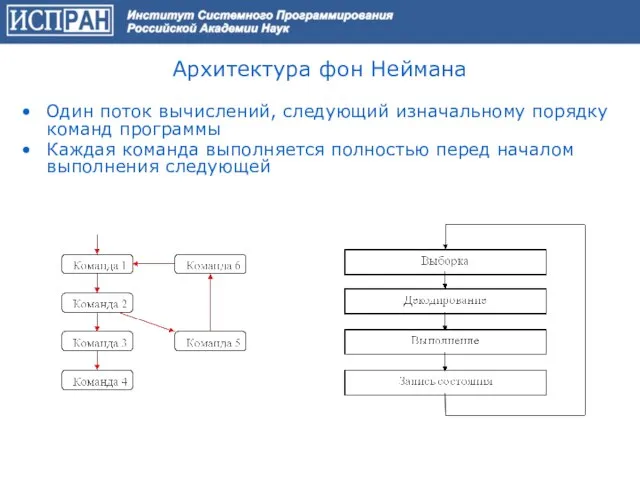

- 11. Архитектура фон Неймана Один поток вычислений, следующий изначальному порядку команд программы Каждая команда выполняется полностью перед

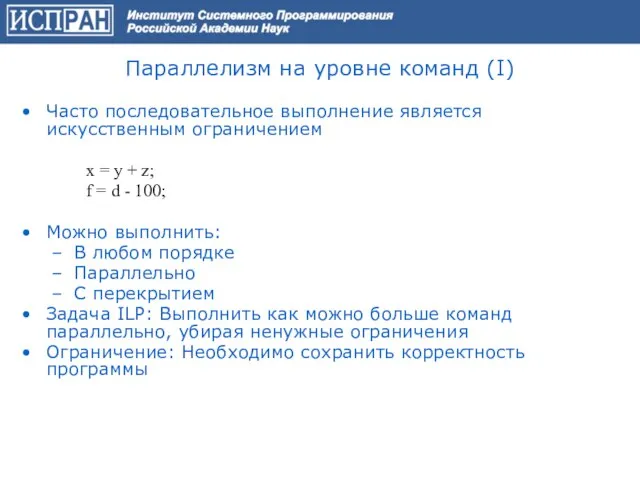

- 12. Параллелизм на уровне команд (I) Часто последовательное выполнение является искусственным ограничением x = y + z;

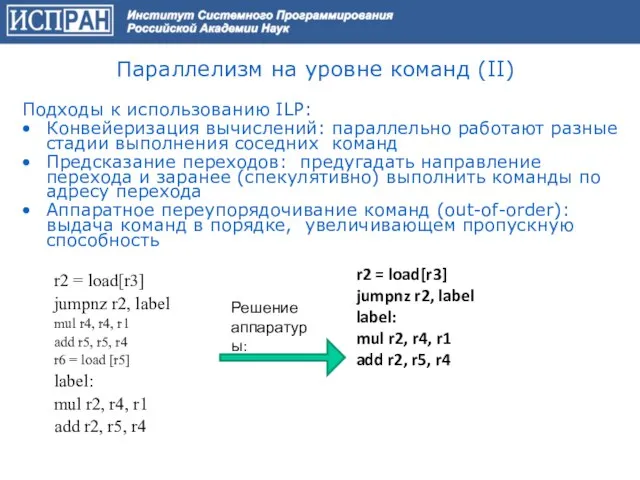

- 13. Параллелизм на уровне команд (II) Подходы к использованию ILP: Конвейеризация вычислений: параллельно работают разные стадии выполнения

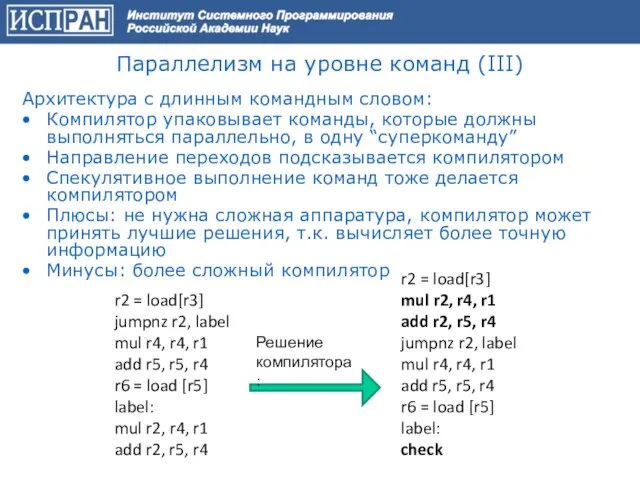

- 14. Параллелизм на уровне команд (III) Архитектура с длинным командным словом: Компилятор упаковывает команды, которые должны выполняться

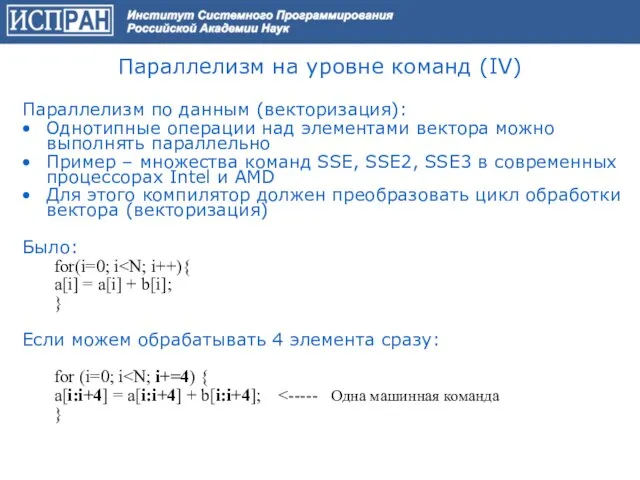

- 15. Параллелизм на уровне команд (IV) Параллелизм по данным (векторизация): Однотипные операции над элементами вектора можно выполнять

- 16. Параллелизм на уровне команд (V) Возможности использования параллелизма на уровне команд достигли предела! Улучшение компилятора/архитектуры не

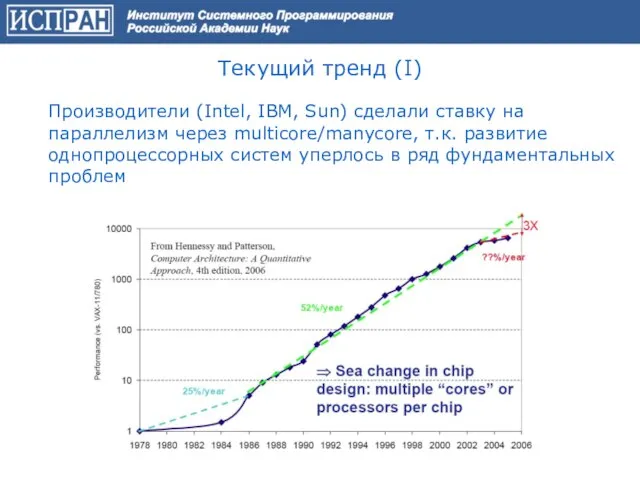

- 17. Текущий тренд (I) Производители (Intel, IBM, Sun) сделали ставку на параллелизм через multicore/manycore, т.к. развитие однопроцессорных

- 18. Текущий тренд (II) Фундаментальные проблемы: ● Было: энергия дешева, транзисторы дороги Стало: транзисторы дешевы, энергия дорога

- 19. Текущий тренд (III) ● Расширение спектра задач решаемых с использованием графических акселераторов (Nebulae, Китай - 2-е

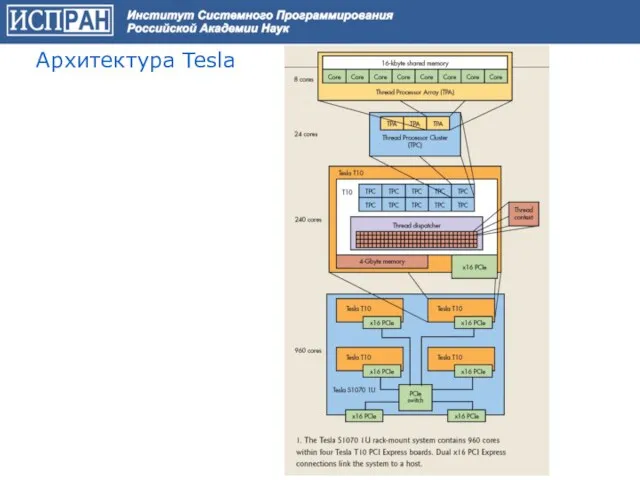

- 20. Архитектура Tesla

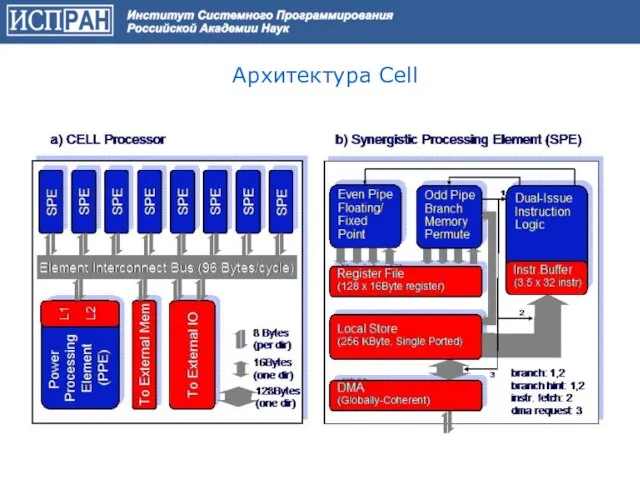

- 21. Архитектура Cell

- 22. Проблема: обеспечение высокопродуктивных вычислений (компромисс между стоимостью разработки и сопровождения и эффективностью выполнения) Мечта! Создание языка

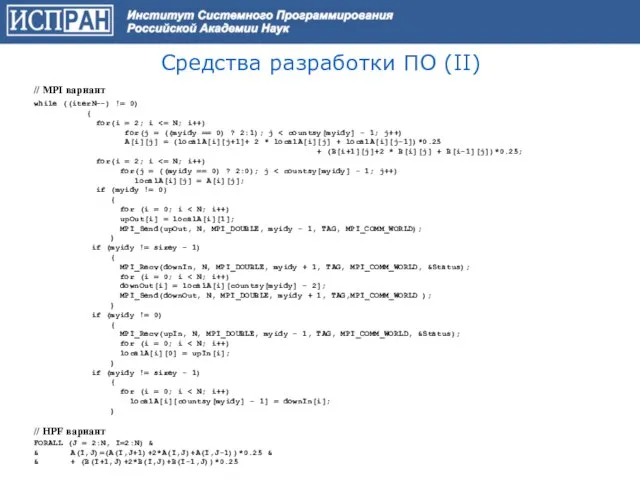

- 23. // MPI вариант while ((iterN--) != 0) { for(i = 2; i for(j = ((myidy ==

- 24. Средства разработки ПО (III) Почему HPF не оправдал надежд: отсутствие компиляторных технологий, позволяющих генерировать эффективный параллельный

- 25. В настоящее время фактическим языковым стандартом разработки промышленных прикладных программ является использование одного из языков программирования

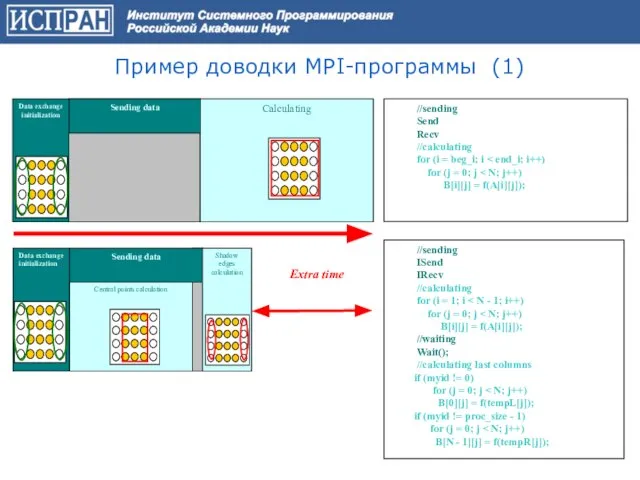

- 26. Пример доводки MPI-программы (1) //sending Send Recv //calculating for (i = beg_i; i for (j =

- 27. Пример доводки MPI-программы (2)

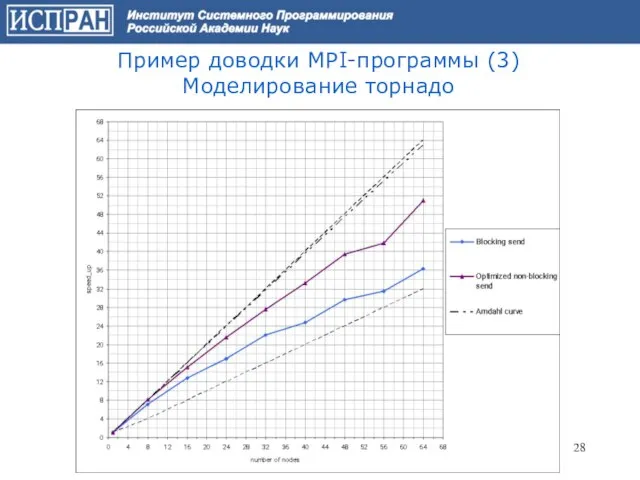

- 28. Пример доводки MPI-программы (3) Моделирование торнадо

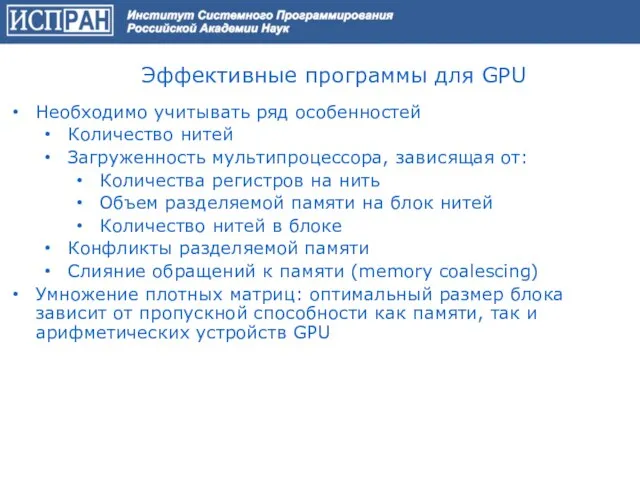

- 29. Эффективные программы для GPU Необходимо учитывать ряд особенностей Количество нитей Загруженность мультипроцессора, зависящая от: Количества регистров

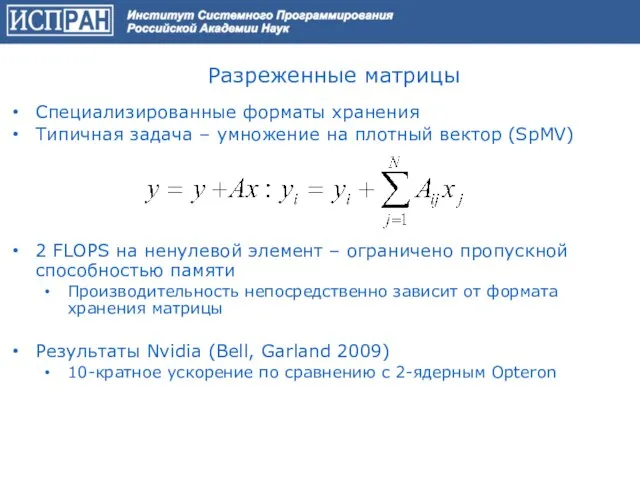

- 30. Разреженные матрицы Специализированные форматы хранения Типичная задача – умножение на плотный вектор (SpMV) 2 FLOPS на

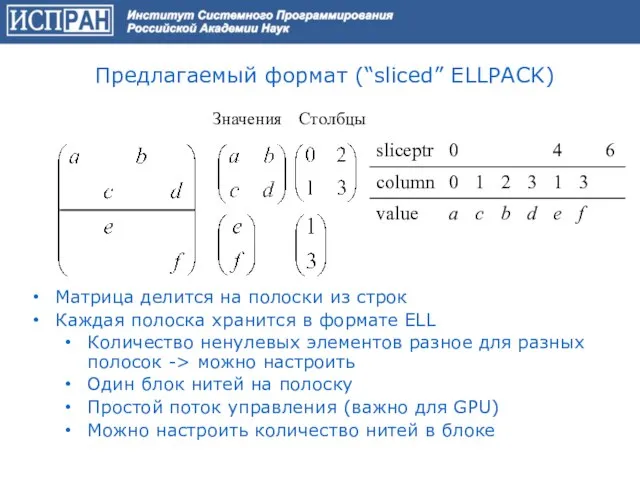

- 31. Предлагаемый формат (“sliced” ELLPACK) Матрица делится на полоски из строк Каждая полоска хранится в формате ELL

- 32. Улучшения алгоритма (I) Переупорядочивание строк Хочется расположить рядом строки с одинаковым количеством ненулевых элементов Дорогая оптимизация,

- 33. Улучшения алгоритма (II) Параметры реализации: Зависящие от устройства Количество строк на полоску Количество нитей на блок

- 34. Результаты тестирования Варианты алгоритма сравниваются с реализацией от NVIDIA как базовой Тесты – набор матриц, использующийся

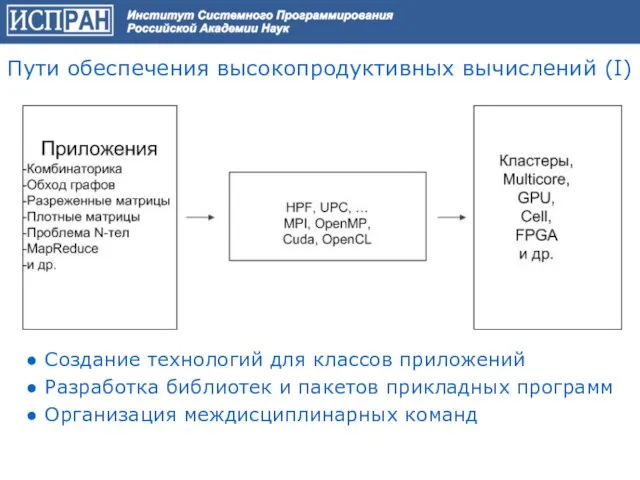

- 35. ● Создание технологий для классов приложений ● Разработка библиотек и пакетов прикладных программ ● Организация междисциплинарных

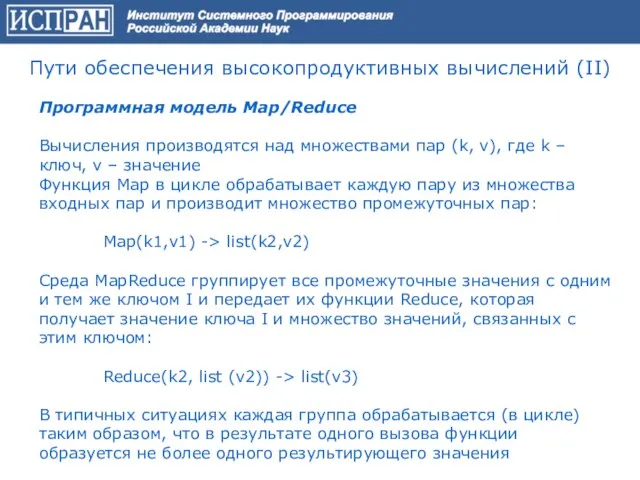

- 36. Программная модель Map/Reduce Вычисления производятся над множествами пар (k, v), где k – ключ, v –

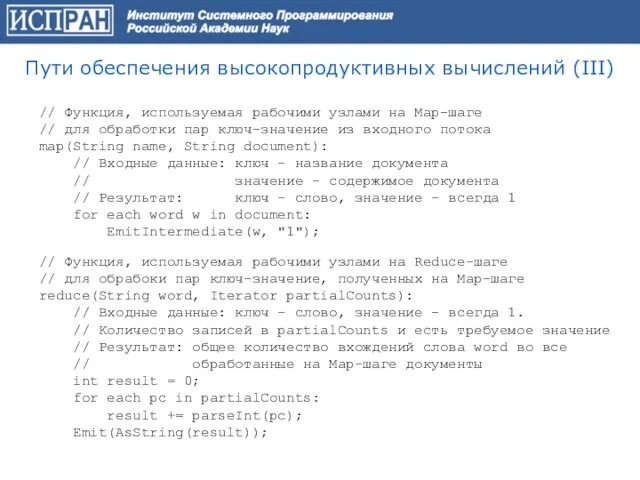

- 37. // Функция, используемая рабочими узлами на Map-шаге // для обработки пар ключ-значение из входного потока map(String

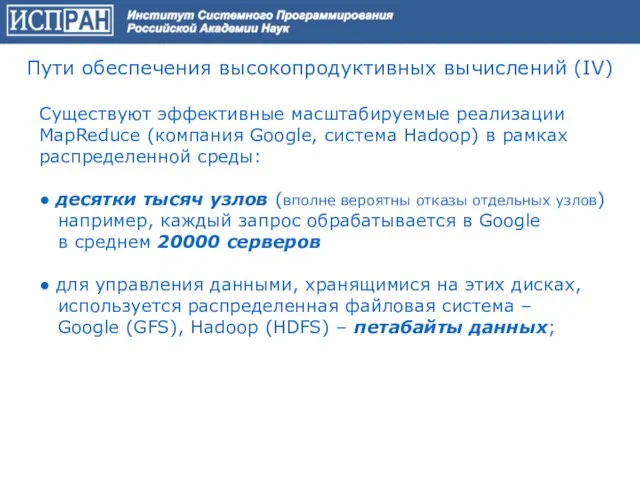

- 38. Существуют эффективные масштабируемые реализации MapReduce (компания Google, система Hadoop) в рамках распределенной среды: ● десятки тысяч

- 39. ● Системы автоматизации инженерного анализа (CAE системы) ANSYS, CFX, LS_DYNA, ICEM CFD, STAR-CD, FLUENT, Diffpack, COMET/Acoustics,

- 40. Цели Grid* Обеспечение возможности решения крупномасштабных научно-технических задач Организация работы распределенных (административно и географически) коллективов Оптимизация

- 41. Проект CERN

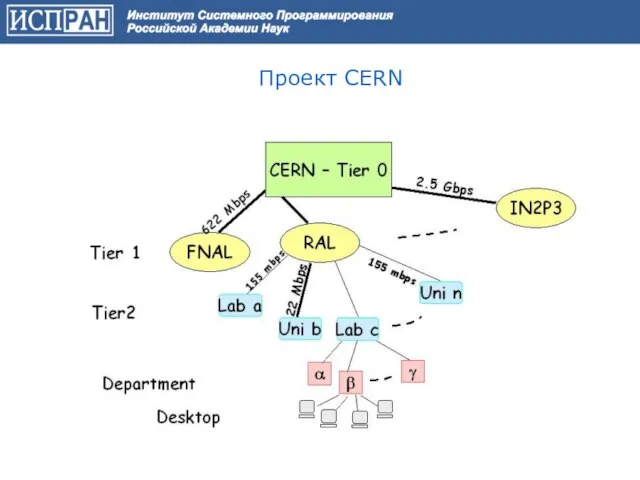

- 42. Globus Toolkit Реализует стандарт OGSI Реализует аутентификацию на основе стандарта X.509 Содержит контейнер Grid служб Содержит

- 43. Пример стенда – TeraGrid

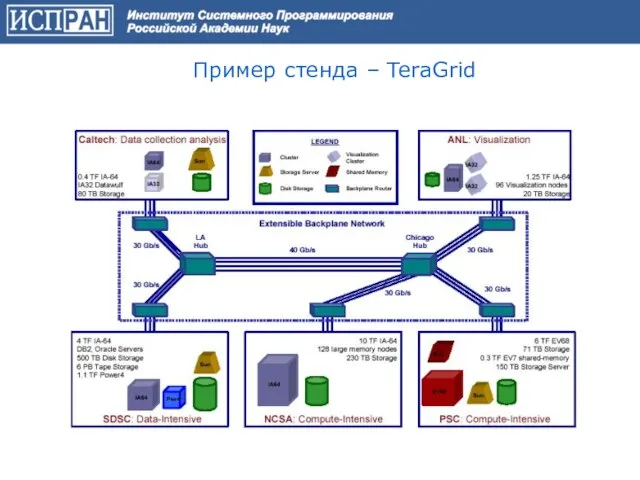

- 44. Концепция «Облачных вычислений» ∙ Все есть сервис (XaaS) − AaaS: приложения как сервис − PaaS: платформа

- 45. Компании предлагающие «Облачные» решения (небольшая выборка) Ожидаемый рост рынка облачных вычислений к 2015 г. до 200

- 46. Примеры внедрения «Облачных» решений ? Nebula – «облачная» платформа NASA ? RACE – частное облако для

- 47. Правительственные инициативы по «Облачным» решениям ? G-Cloud – Правительственное облако Великобритании, которое опирается на инициативу: «Deliver

- 48. NEBULA Cloud Computing Platform Nebula (туманность) – это проект который разрабатывается в Исследовательском центре Эймс а

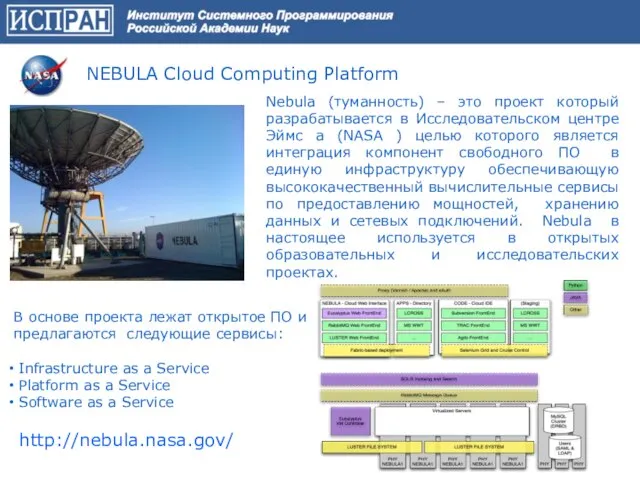

- 49. Свободное ПО и «Облачные вычисления» Одно из основных направлений развития ? Стандартный стек системного ПО ?

- 50. Почему сейчас? Создание чрезвычайно крупномасштабных центров обработки данных - в ~10 раз снижение стоимости (использование систем

- 51. Примеры применения ◊ Конвертирование большого количества файлов из одного формата в другой (пакетная обработка) Washington post:

- 52. Неиспользуемые ресурсы Преимущества «облачного» ЦОДа ◊ Гибкость предоставления ресурсов может обеспечить беспрецедентную экономию – минимум неиспользуемых

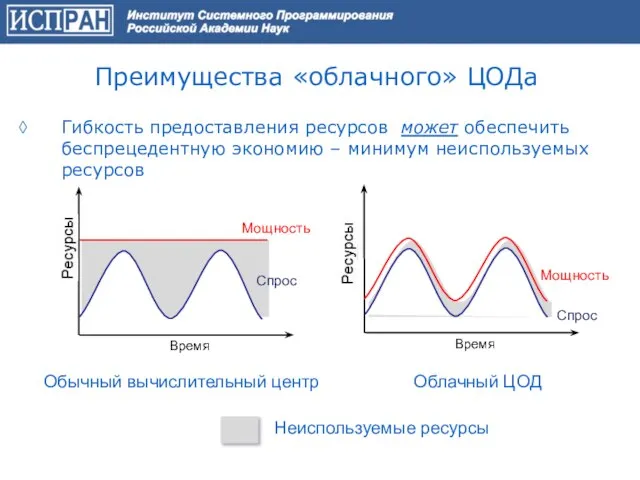

- 53. «Облачные вычисления» в науке и образовании (1) Возможность создания web-ориентированных лабораторий (хабов) в конкретных предметных областях

- 54. «Облачные вычисления» в науке и образовании (2) ◊ Принципиально новые возможности для исследователей по организации доступа,

- 55. Общая схема организации «хаба»

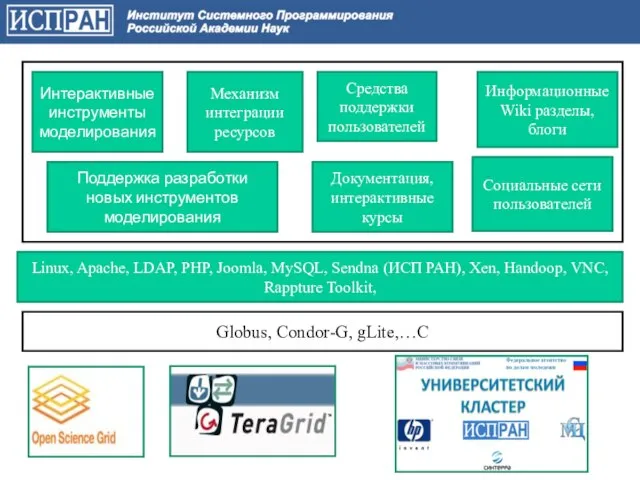

- 56. Globus, Condor-G, gLite,…C Linux, Apache, LDAP, PHP, Joomla, MySQL, Sendna (ИСП РАН), Xen, Handoop, VNC, Rappture

- 57. «Университетский кластер» (1) Программа учреждена 4 сентября 2008 года Российской академией наук (ИСП РАН и МСЦ

- 58. «Университетский кластер» (2) Для достижения целей Программы решаются следующие задачи: - построение, развитие и поддержка вычислительной

- 59. «Университетский кластер» (3) Инфраструктура включает в себя современные аппаратные, программные, сетевые технологии, а также компетенцию передовых

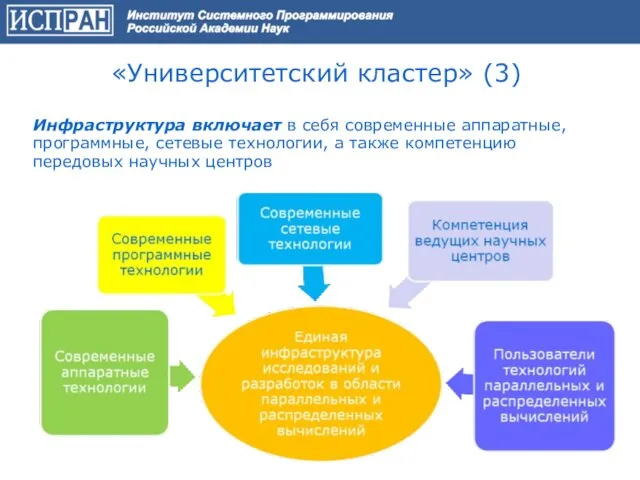

- 60. «Университетский кластер» (4)

- 61. «Университетский кластер». Проект OpenCirrus OpenCirrus был основан компаниями НР, Intel и Yahoo Цель – создание открытого

- 62. OpenCirrus – география проекта

- 63. «Университетский кластер». Текущее состояние (1) Реализованы базовые сетевые службы VPN «Университетский кластер» (служба доменных имен DNS,

- 64. «Университетский кластер». Текущее состояние (2) ИСП РАН совместно с РНЦ «Курчатовский институт» и компанией HP, на

- 65. Пакетизация идет с конца 80-х гг. Универсальные пакеты – PHOENICS, ANSYS, Nastran, FIDAP, StarCD, FIRE, FLUENT,

- 66. Свободное Программное Обеспечение

- 67. Основные этапы и модули при решении задач МСС

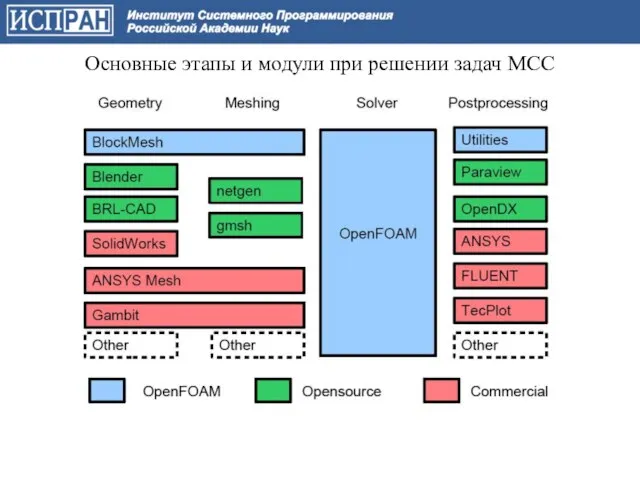

- 68. Salome (EDF, CEA, OpenCASCADE) Salome - является бесплатным программным обеспечением, которое предоставляет платформу для Пре и

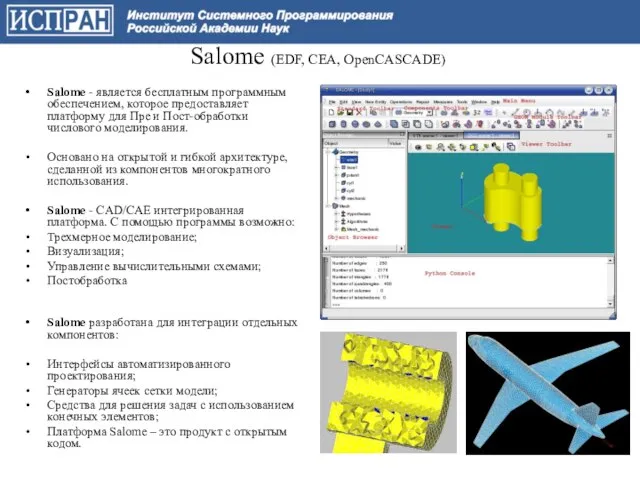

- 69. ОpenFOAM — свободно распространяемое программное обеспечение для проведения численных расчетов. OpenFOAM — объектно-ориентированная платформа, реализованная на

- 70. Paraview (ARL,ASC, Los Alamos NL, Kitware, Sandia NL,Kitware) Multi-view support Quantitative analysis Undo/redo Python scripting Time

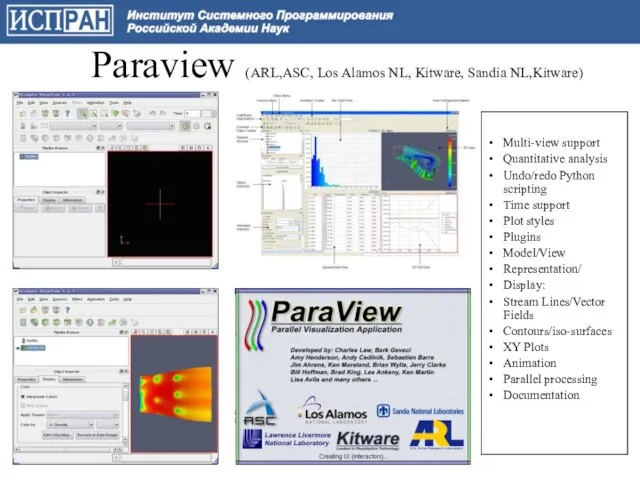

- 72. Скачать презентацию

Talk for a minute

Talk for a minute Литературная игра для младших школьников по произведениям Н.Н.Носова «Затейники и фантазёры»

Литературная игра для младших школьников по произведениям Н.Н.Носова «Затейники и фантазёры» L`italiano è facile

L`italiano è facile Коммуникации. Техника 3-х касаний

Коммуникации. Техника 3-х касаний Муниципальное образовательное учреждение "Ковылкинская средняя общеобразовательная школа № 1"

Муниципальное образовательное учреждение "Ковылкинская средняя общеобразовательная школа № 1" Грант 2013г

Грант 2013г Тема урока: «Бунташный век».

Тема урока: «Бунташный век». History & Mystery of the English language

History & Mystery of the English language Внутренняя среда организма. Кровеносная система

Внутренняя среда организма. Кровеносная система Современные средства поражений

Современные средства поражений ПЕРСПЕКТИВНАЯ НАЧАЛЬНАЯШКОЛА

ПЕРСПЕКТИВНАЯ НАЧАЛЬНАЯШКОЛА lecture_1

lecture_1 Тукай начал изучать русский язык

Тукай начал изучать русский язык История праздника Новый Год

История праздника Новый Год Проект: видеоблог

Проект: видеоблог Расчет теплоусвоения внутренней поверхности полов

Расчет теплоусвоения внутренней поверхности полов ЭФФЕКТ КАЗИМИРА: ОТ НАНОТЕХНОЛОГИЙ ДО ФИЗИКИ ВСЕЛЕННОЙ

ЭФФЕКТ КАЗИМИРА: ОТ НАНОТЕХНОЛОГИЙ ДО ФИЗИКИ ВСЕЛЕННОЙ Цифровые права

Цифровые права Сетевой маркетинг

Сетевой маркетинг культура и достопримечательности Греции

культура и достопримечательности Греции Мектеп бітірушілердің психологиялық-физиологиялық жағдайын ескере отырып қобалжу деңгейін төмендету

Мектеп бітірушілердің психологиялық-физиологиялық жағдайын ескере отырып қобалжу деңгейін төмендету Решение текстовых задач. Закрепление пройденного

Решение текстовых задач. Закрепление пройденного Традиционная реклама

Традиционная реклама Saint Patricks day

Saint Patricks day КОМПЬЮТЕРНАЯ ДОЛИНА

КОМПЬЮТЕРНАЯ ДОЛИНА Литературная игра по творчеству А.С. Пушкина

Литературная игра по творчеству А.С. Пушкина Презентация на тему Семейство Губоцветные

Презентация на тему Семейство Губоцветные ФИЗИЧЕСКАЯ КУЛЬТУРА

ФИЗИЧЕСКАЯ КУЛЬТУРА