Содержание

- 2. 2 основных вида CART (Classification and Regression Tree) – это алгоритм построения бинарного дерева решений. Каждый

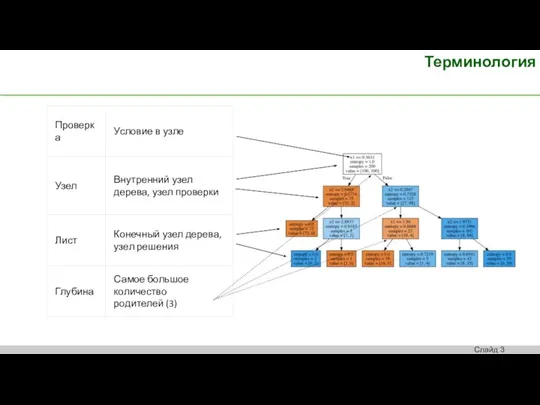

- 3. Терминология

- 4. Жадные: «берут все, что дают, не отдают» Большинство из известных алгоритмов являются "жадными алгоритмами". Перебирают все

- 5. Алгоритм Первое множество (корень) : есть ли такие два подмножества, которые улучшат предсказания? Подмножества определим по

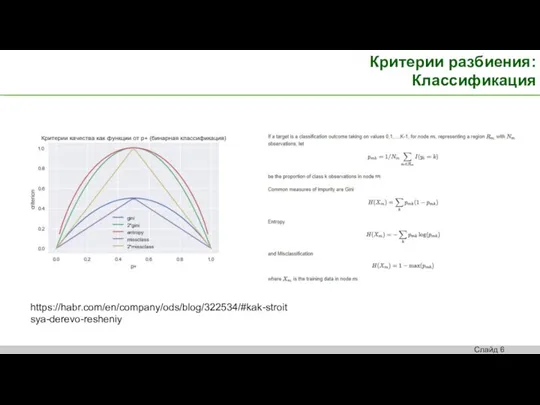

- 6. Критерии разбиения: Классификация https://habr.com/en/company/ods/blog/322534/#kak-stroitsya-derevo-resheniy

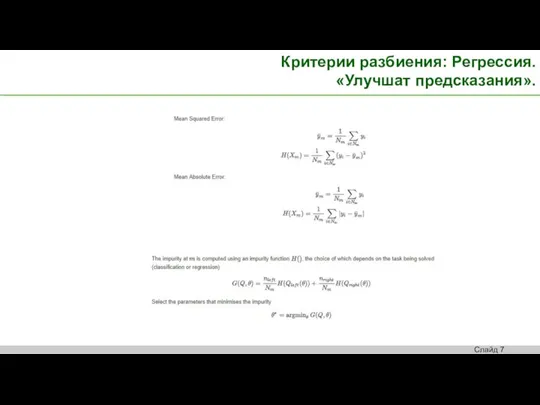

- 7. Критерии разбиения: Регрессия. «Улучшат предсказания».

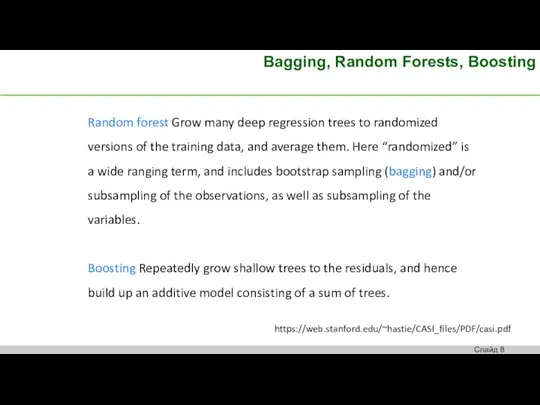

- 8. Bagging, Random Forests, Boosting Random forest Grow many deep regression trees to randomized versions of the

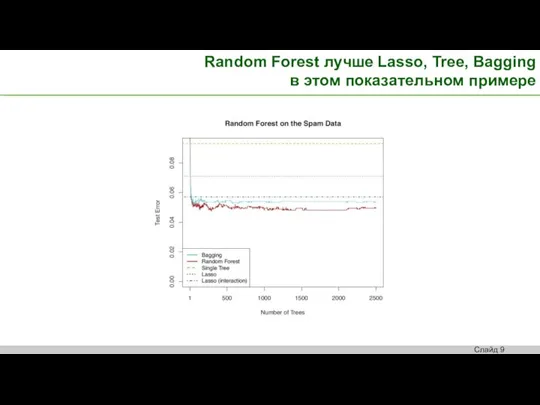

- 9. Random Forest лучше Lasso, Tree, Bagging в этом показательном примере

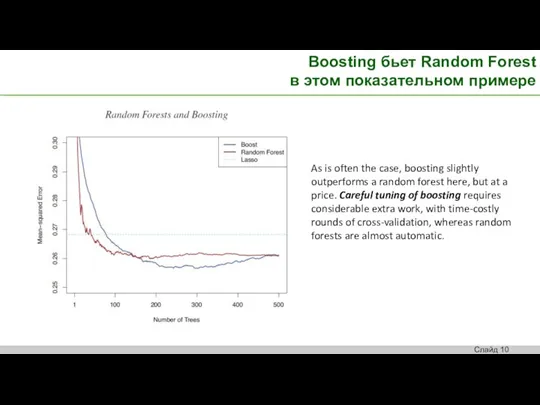

- 10. Boosting бьет Random Forest в этом показательном примере As is often the case, boosting slightly outperforms

- 12. Скачать презентацию

Интерактивный интернет-ресурс спортивных прогнозов и аналитики

Интерактивный интернет-ресурс спортивных прогнозов и аналитики Антиква старого стиля или ренессансная антиква

Антиква старого стиля или ренессансная антиква Оценка модуль F

Оценка модуль F Цифровые образовательные платформы

Цифровые образовательные платформы Технологии беспроводной связи

Технологии беспроводной связи Prezentatsia_Instrumenty_vydelenia_Adobe_Photoshop

Prezentatsia_Instrumenty_vydelenia_Adobe_Photoshop Многопоточные вычисления на БД

Многопоточные вычисления на БД Растровая и векторная графика. Знаки и символы

Растровая и векторная графика. Знаки и символы Личный блог, блог компании, блог от третьего лица

Личный блог, блог компании, блог от третьего лица Основы программирования. Функции С/С++

Основы программирования. Функции С/С++ Дед Мороз. Рисуем в Paint

Дед Мороз. Рисуем в Paint Уровневая модель ISO

Уровневая модель ISO Методы сортировки. Алгоритмы методов простого выбора, пузырька, сортировки расческой, быстрой сортировки

Методы сортировки. Алгоритмы методов простого выбора, пузырька, сортировки расческой, быстрой сортировки Мобильное программирование

Мобильное программирование Доступные инструкции как пользоваться Сбербанк Онлайн для ваших близких старшего поколения

Доступные инструкции как пользоваться Сбербанк Онлайн для ваших близких старшего поколения Браузеры. Разработка браузеров

Браузеры. Разработка браузеров Изменение размера и шрифта текста в документе Microsoft Word. Урок 4

Изменение размера и шрифта текста в документе Microsoft Word. Урок 4 Мейнфреймы

Мейнфреймы Лекция 6-7 Семиуровневая модель OSI

Лекция 6-7 Семиуровневая модель OSI Telegram-бот Медицинский консультант

Telegram-бот Медицинский консультант Online-курсы Платформа Открытое образование

Online-курсы Платформа Открытое образование Программное обеспечение компьютера

Программное обеспечение компьютера Одномерные массивы

Одномерные массивы Технические средства информационных технологий

Технические средства информационных технологий Работа протоколов стека TCP/IP

Работа протоколов стека TCP/IP История компьютерных вирусов до 2000-х годов

История компьютерных вирусов до 2000-х годов Основы программирования (Паскаль)

Основы программирования (Паскаль) Программы для ЭВМ

Программы для ЭВМ