Содержание

- 2. Содержательный подход к измерению информации Для человека информация — это знания человека. Рассмотрим вопрос с этой

- 3. Информативность сообщения Но для того чтобы сообщение было информативно оно должно еще быть понятно. Быть понятным,

- 4. Единица измерения информации Очевидно, различать лишь две ситуации: «нет информации» — «есть информация» для измерения информации

- 5. Пример: После сдачи зачета или выполнения контрольной работы ученик мучается неопределенностью, он не знает, какую оценку

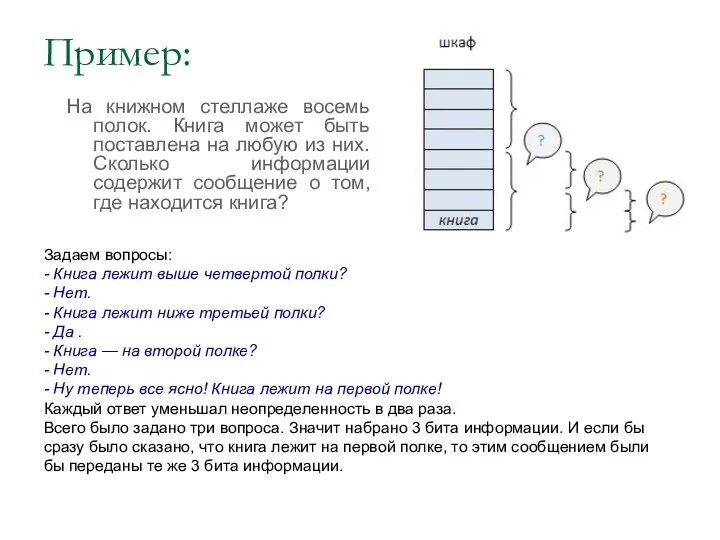

- 6. Пример: На книжном стеллаже восемь полок. Книга может быть поставлена на любую из них. Сколько информации

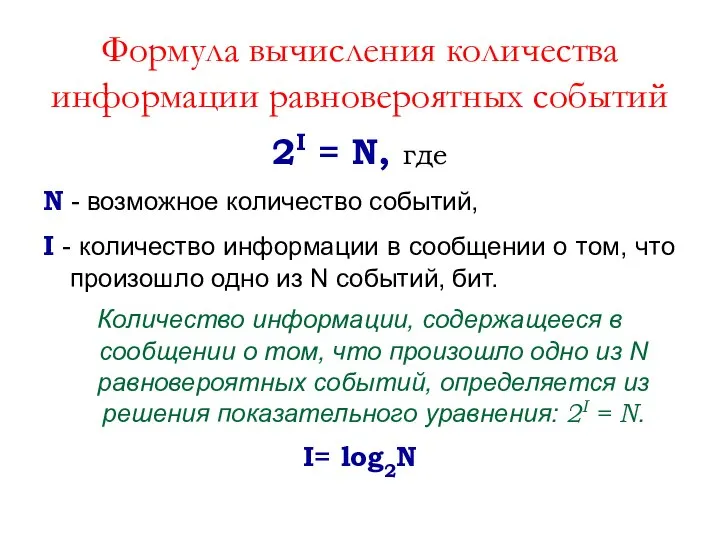

- 7. Формула вычисления количества информации равновероятных событий 2I = N, где N - возможное количество событий, I

- 8. Пример 1: Сколько информации содержит сообщение о том, что из колоды карт достали король пик?

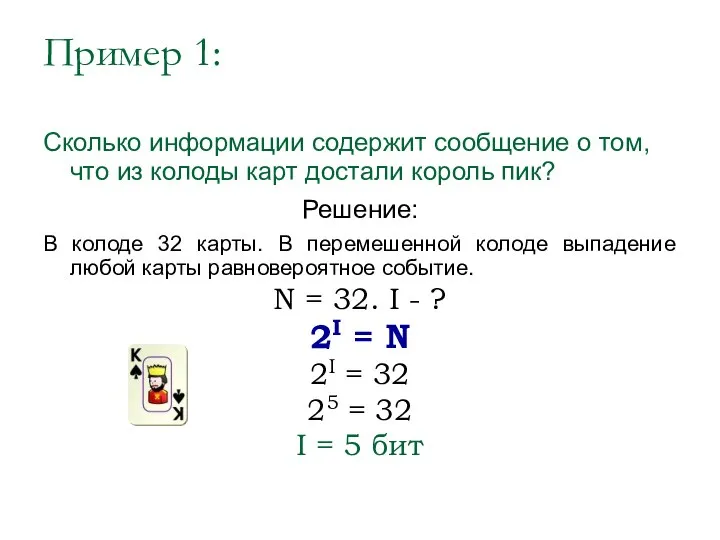

- 9. Пример 1: Сколько информации содержит сообщение о том, что из колоды карт достали король пик? Решение:

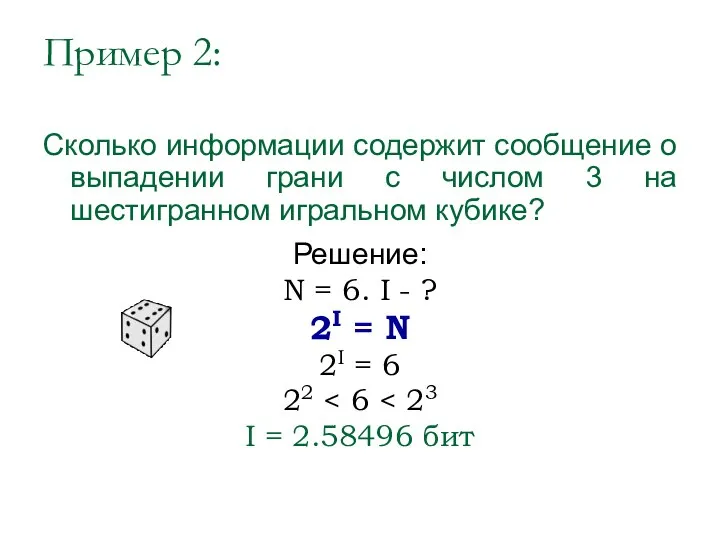

- 10. Пример 2: Сколько информации содержит сообщение о выпадении грани с числом 3 на шестигранном игральном кубике?

- 11. Пример 2: Сколько информации содержит сообщение о выпадении грани с числом 3 на шестигранном игральном кубике?

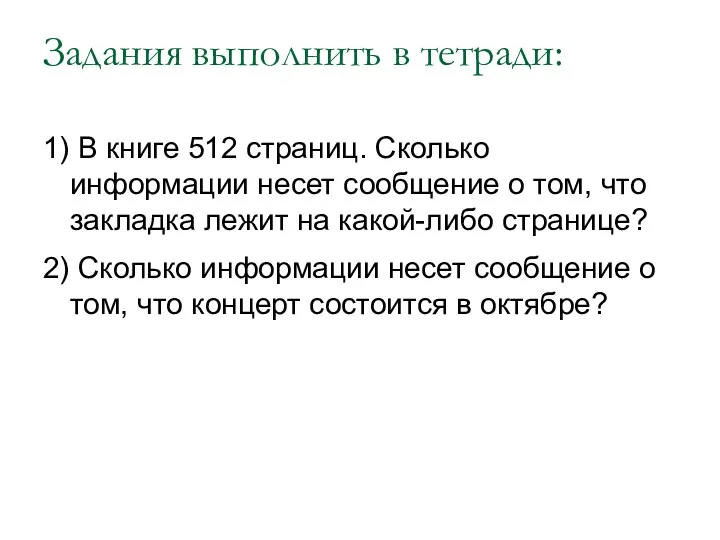

- 12. Задания выполнить в тетради: 1) В книге 512 страниц. Сколько информации несет сообщение о том, что

- 13. Вероятностный подход к определению количества информации. Формула Шеннона

- 14. Количество информации в сообщении о неравновероятном событии: I=log2(1/p), где I – это количество информации, бит р

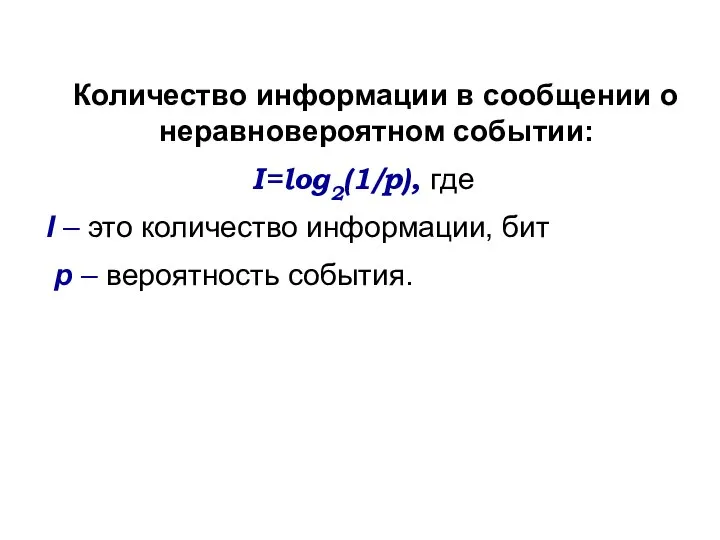

- 15. Вероятность события выражается в долях единицы и вычисляется по формуле: р=K/N где К – величина, показывающая

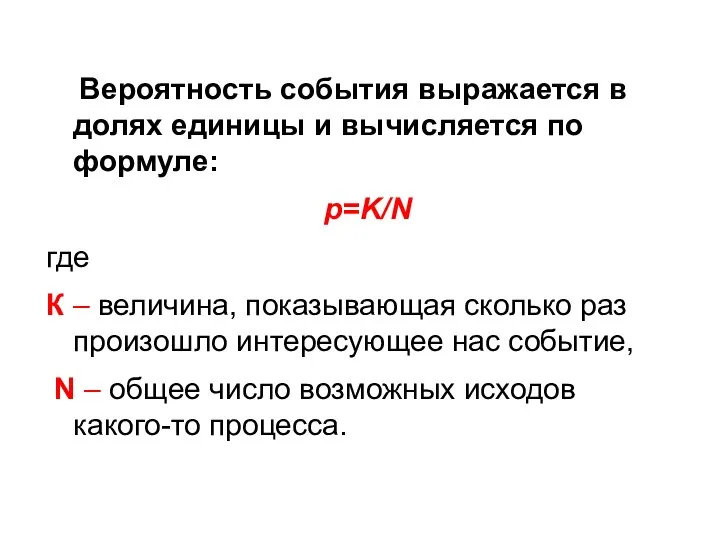

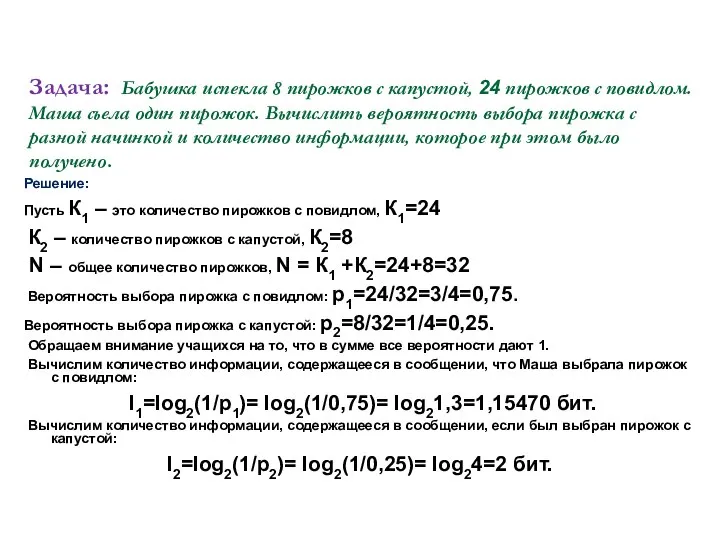

- 16. Задача: Бабушка испекла 8 пирожков с капустой, 24 пирожков с повидлом. Маша съела один пирожок. Вычислить

- 17. Качественную связь между вероятностью события и количеством информации в сообщении об этом событии можно выразить так:

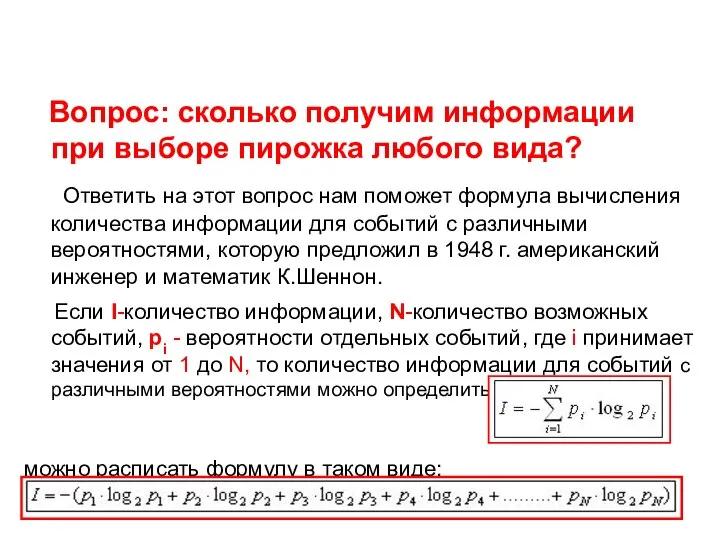

- 18. Вопрос: сколько получим информации при выборе пирожка любого вида? Ответить на этот вопрос нам поможет формула

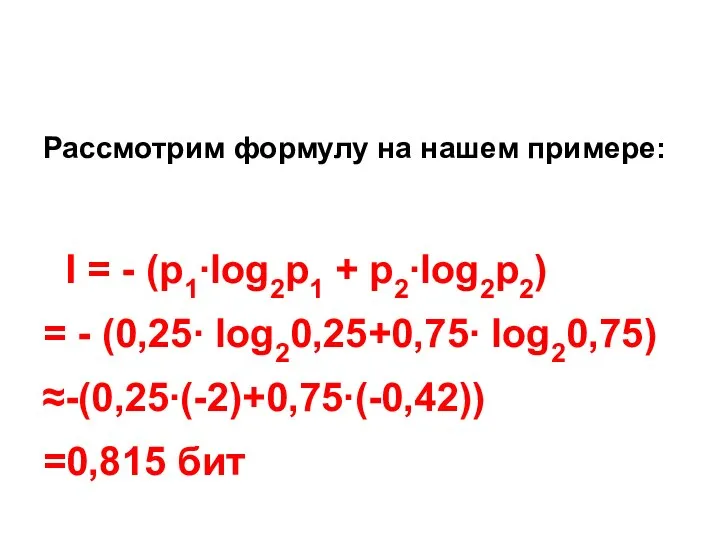

- 19. Рассмотрим формулу на нашем примере: I = - (р1∙log2p1 + р2∙log2p2) = - (0,25∙ log20,25+0,75∙ log20,75)

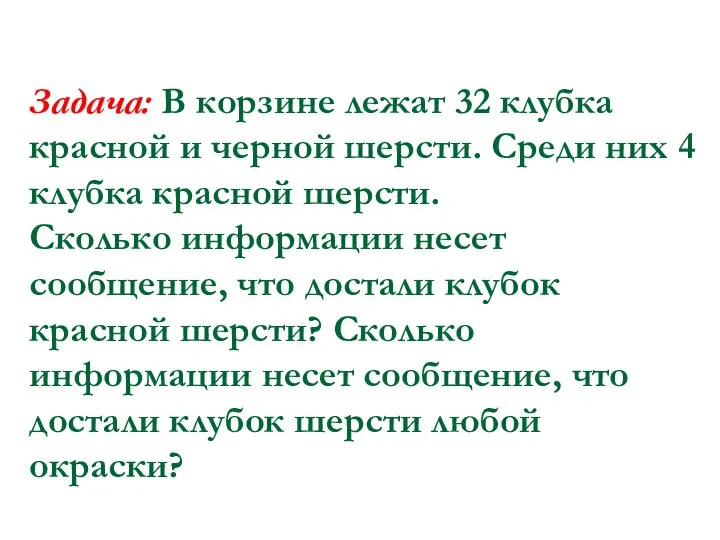

- 20. Задача: В корзине лежат 32 клубка красной и черной шерсти. Среди них 4 клубка красной шерсти.

- 22. Скачать презентацию

Сумська обласна наукова медична бібліотека

Сумська обласна наукова медична бібліотека Свойства логических операций

Свойства логических операций Конвертация файлов с цифровой информацией в другие форматы

Конвертация файлов с цифровой информацией в другие форматы Проекты FMCG 2020

Проекты FMCG 2020 Систематизация и представление информации в виде сайта

Систематизация и представление информации в виде сайта Язык программирования C# 6.0

Язык программирования C# 6.0 Структура программы С#. Переменные, операции и выражения

Структура программы С#. Переменные, операции и выражения Класифікація перестановок зі спеціальними властивостями та оцінка потужності класів

Класифікація перестановок зі спеціальними властивостями та оцінка потужності класів Потоки. Работа с потоками

Потоки. Работа с потоками Надстройка Пакет анализа в Excel

Надстройка Пакет анализа в Excel История развития информатики

История развития информатики Проект Большая перемена и технологии

Проект Большая перемена и технологии Мобильные вирусы: миф или угроза

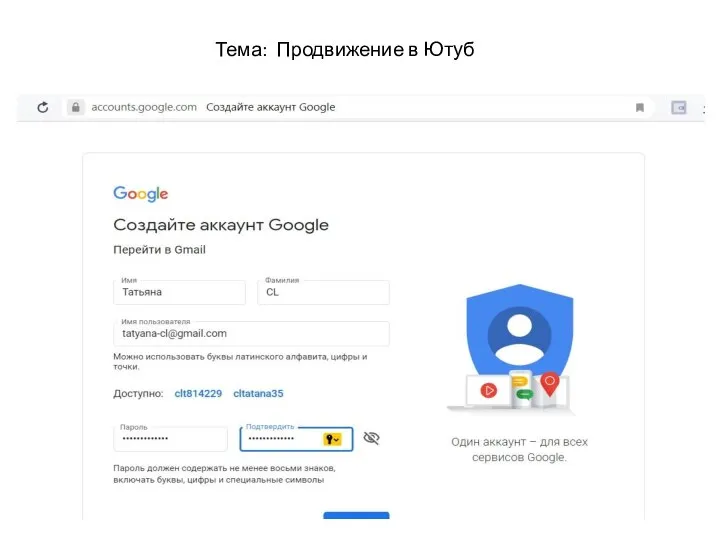

Мобильные вирусы: миф или угроза Продвижение в Ютуб

Продвижение в Ютуб Обработка ошибок

Обработка ошибок Электронные технологии в обучении: создание интеллекткарты Эволюция живой природы

Электронные технологии в обучении: создание интеллекткарты Эволюция живой природы Вводная информация по работе с сервисным порталом TPV

Вводная информация по работе с сервисным порталом TPV 7-1-5

7-1-5 Сайт ИК для студентов

Сайт ИК для студентов App that change adventures

App that change adventures База данных Видеопрокат

База данных Видеопрокат Тренируемся в определении перьев птиц с использованием on-line определителя

Тренируемся в определении перьев птиц с использованием on-line определителя Цикл с параметром в Pascal. Lazarus

Цикл с параметром в Pascal. Lazarus Развитие экспорта медицинских услуг (Волгоградская область)

Развитие экспорта медицинских услуг (Волгоградская область) Развитие персонажей

Развитие персонажей Инструкция для регистрации на портале

Инструкция для регистрации на портале Как работает компьютерный иммунитет?

Как работает компьютерный иммунитет? Юные блогеры

Юные блогеры