Содержание

- 2. Случайное событие – означает отсутствие полной уверенности в его наступлении. Пусть опыт имеет n равновероятных исходов.

- 3. f(1) = 0, если n = 1 исход опыта не является случайным и неопределенность отсутствует; f(n)

- 4. Пусть α и β независимые опыты. nα, nβ - число равновероятных исходов. Рассмотрим сложный опыт, который

- 5. f(nα ∙ nβ) - мера неопределенности сложного опыта. α и β – независимы, т.е. в сложном

- 6. f(1) = 0 f(n) возрастает с ростом n f(nα ∙ nβ)= f(nα) + f(nβ) Этим свойствам

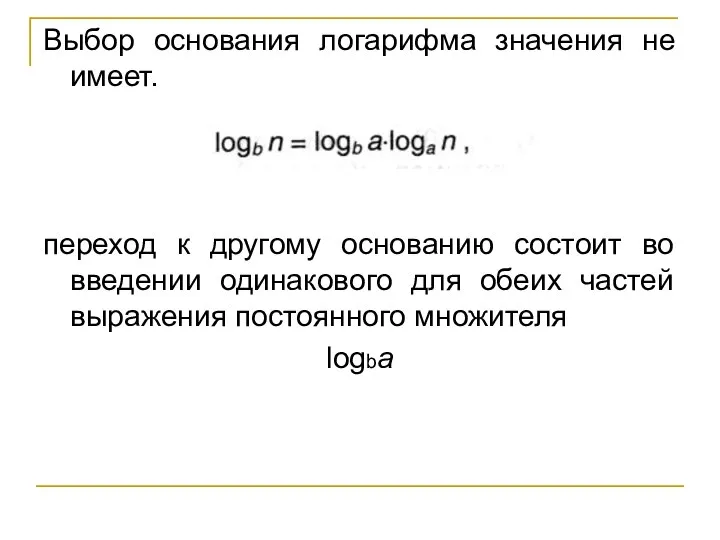

- 7. Выбор основания логарифма значения не имеет. переход к другому основанию состоит во введении одинакового для обеих

- 8. Удобно, основание 2. За единицу измерения принимается неопределенность, содержащаяся в опыте, имеющем лишь два равновероятных исхода,

- 9. Определение. Мера неопределенности опыта, имеющего n равновероятных исходов равна f(n)=log2(n). (4.1) Эта величина – энтропия, обозначается

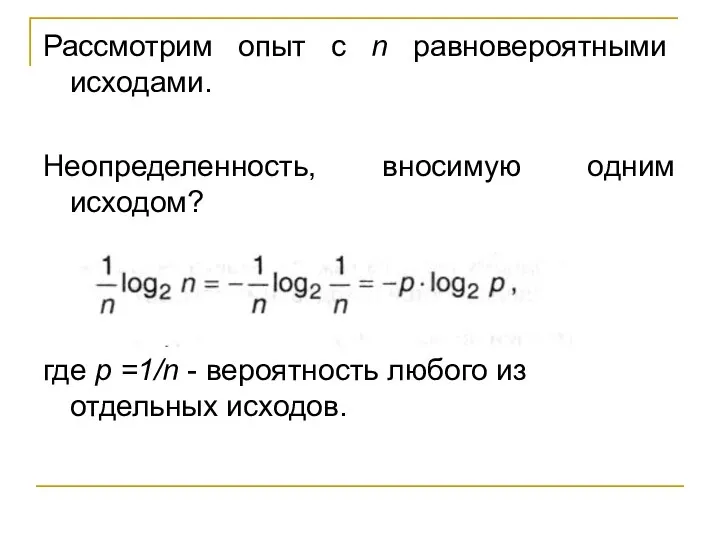

- 10. Рассмотрим опыт с n равновероятными исходами. Неопределенность, вносимую одним исходом? где р =1/n - вероятность любого

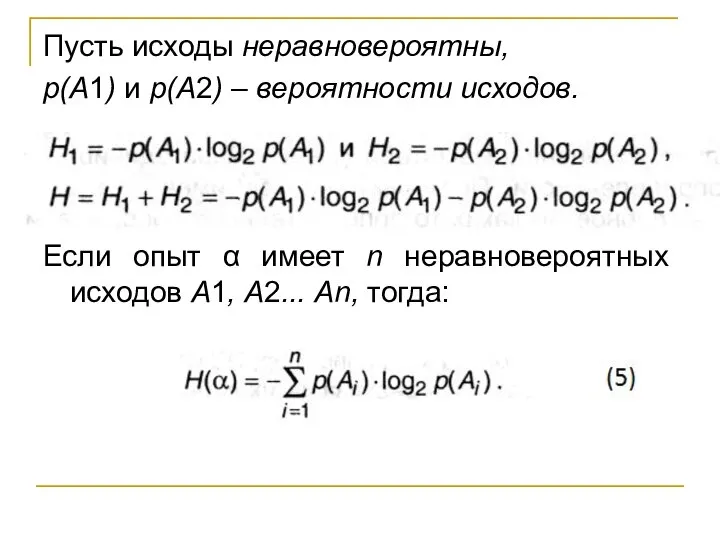

- 11. Пусть исходы неравновероятны, р(А1) и р(А2) – вероятности исходов. Если опыт α имеет n неравновероятных исходов

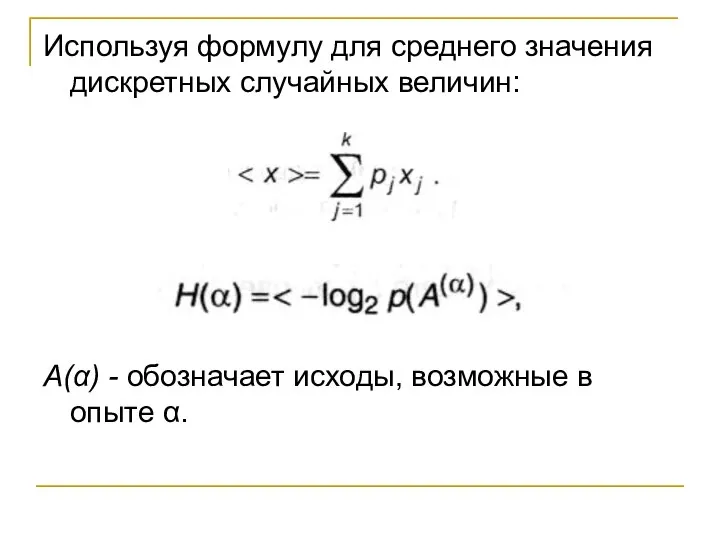

- 12. Используя формулу для среднего значения дискретных случайных величин: А(α) - обозначает исходы, возможные в опыте α.

- 13. Определение. Энтропия является мерой неопределенности опыта, в котором проявляются случайные события, и равна средней неопределенности всех

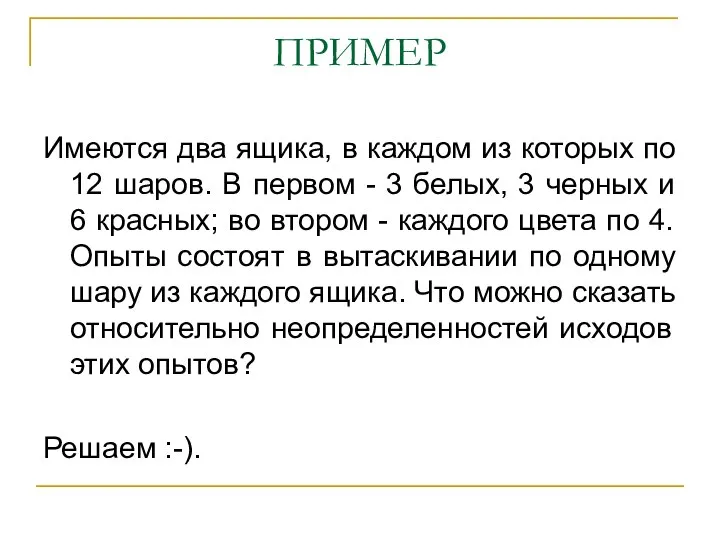

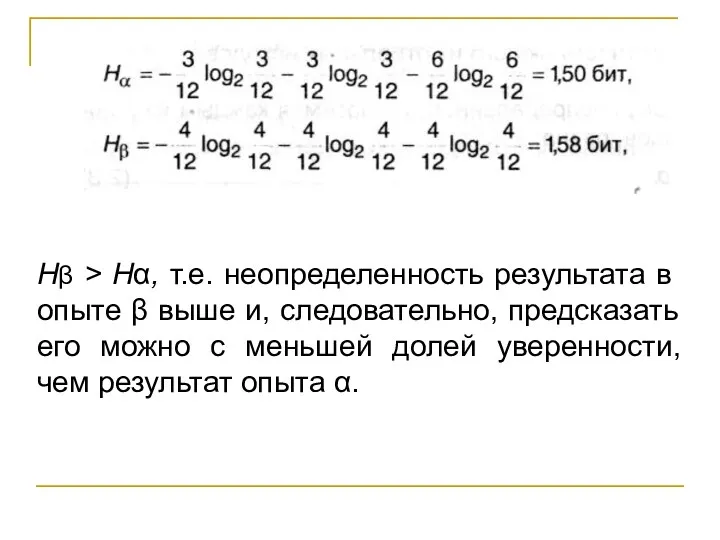

- 14. ПРИМЕР Имеются два ящика, в каждом из которых по 12 шаров. В первом - 3 белых,

- 15. Нβ > Нα, т.е. неопределенность результата в опыте β выше и, следовательно, предсказать его можно с

- 16. Свойства энтропии 1) Н > 0. Н = 0 в двух случаях: (а) если p(Aj) =

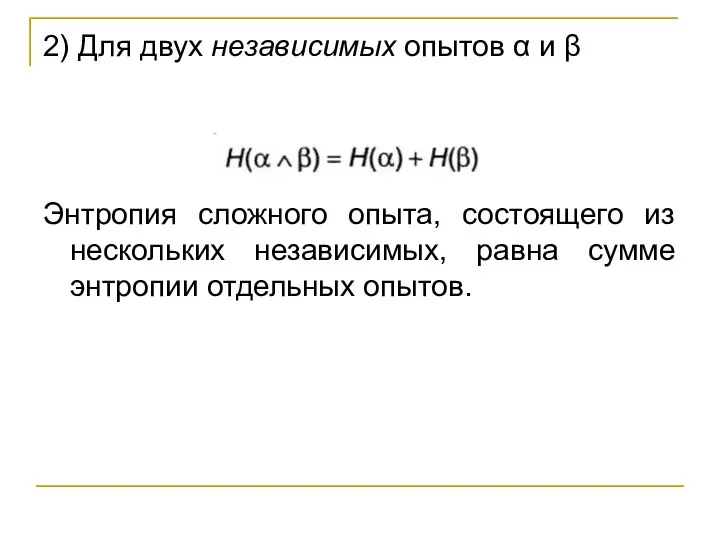

- 17. 2) Для двух независимых опытов α и β Энтропия сложного опыта, состоящего из нескольких независимых, равна

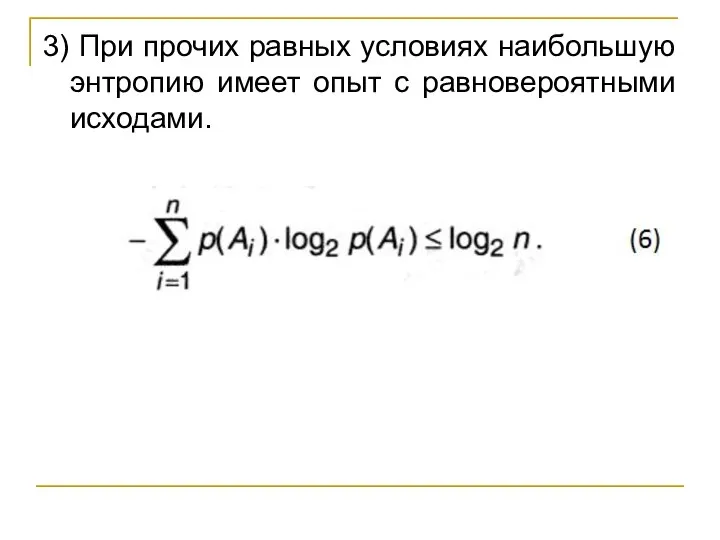

- 18. 3) При прочих равных условиях наибольшую энтропию имеет опыт с равновероятными исходами.

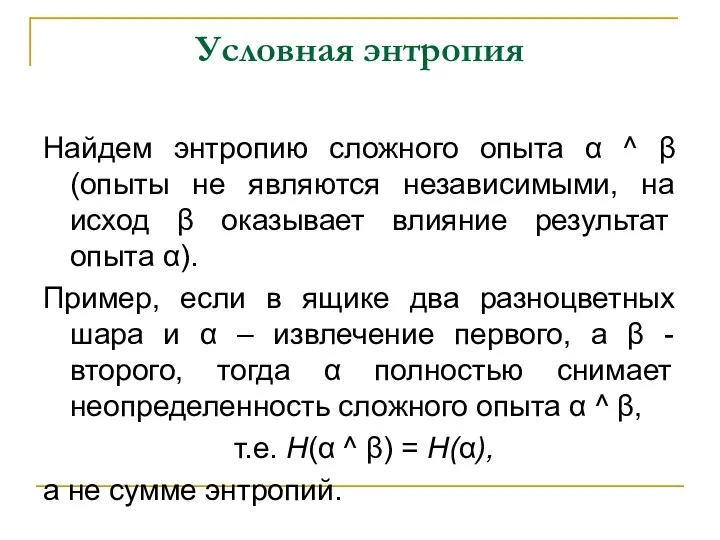

- 19. Условная энтропия Найдем энтропию сложного опыта α ^ β (опыты не являются независимыми, на исход β

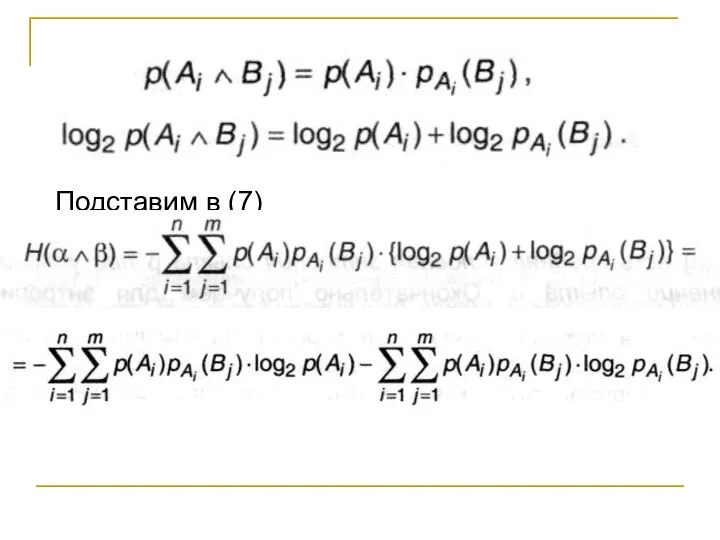

- 20. Подставим в (7)

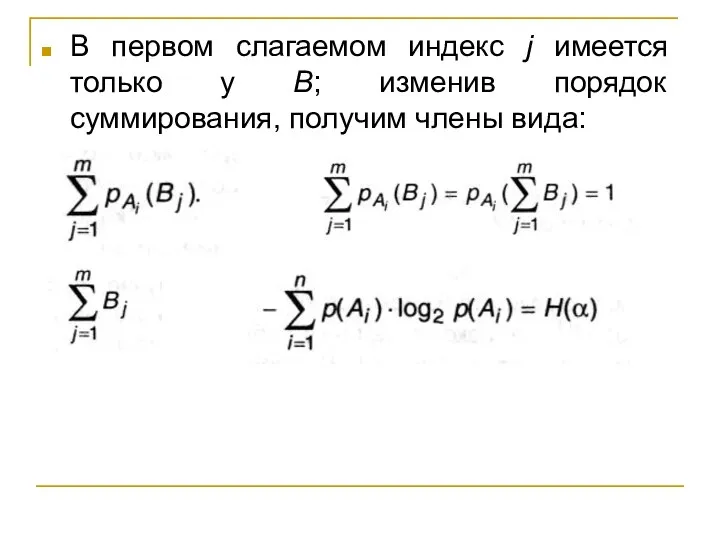

- 21. В первом слагаемом индекс j имеется только у B; изменив порядок суммирования, получим члены вида:

- 22. Свойства условной энтропии 1. Условная энтропия является величиной неотрицательной. Hα(β) = 0, если любой исход α

- 23. Пример 2.2. В ящике имеются 2 белых шара и 4 черных. Из ящика извлекают последовательно два

- 24. Задача 2.3. Имеется три тела с одинаковыми внешними размерами, но с разными массами х1, х2 и

- 25. 2.2. Энтропия и информация Определение. I - информацией относительно опыта β, содержащейся в опыте α I(α,β)=H

- 26. Следствие 1. Единицы измерения количество информации – бит. Следствие 2. Пусть опыт α = β, тогда

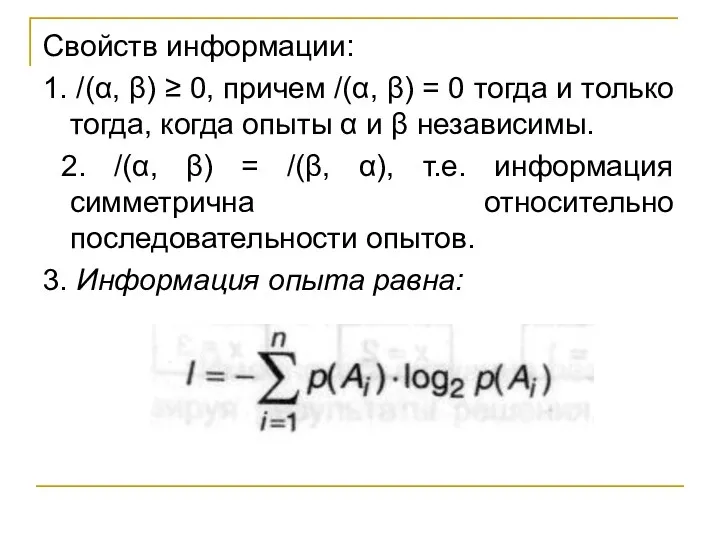

- 27. Свойств информации: 1. /(α, β) ≥ 0, причем /(α, β) = 0 тогда и только тогда,

- 28. Пример 2.4. Какое количество информации требуется, чтобы узнать исход броска монеты? Пример 2.5. Виктор Сергеевич задумал

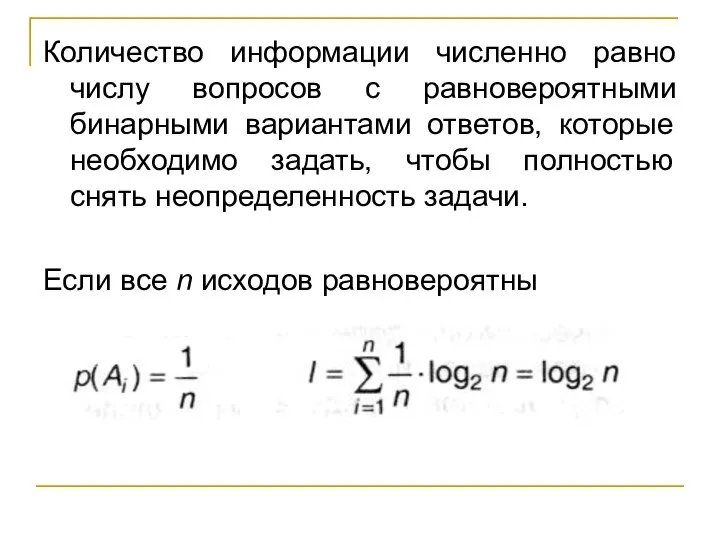

- 30. Количество информации численно равно числу вопросов с равновероятными бинарными вариантами ответов, которые необходимо задать, чтобы полностью

- 31. Формула Хартли (1928). 30.11.1888 - 1.05.1970 (81). США

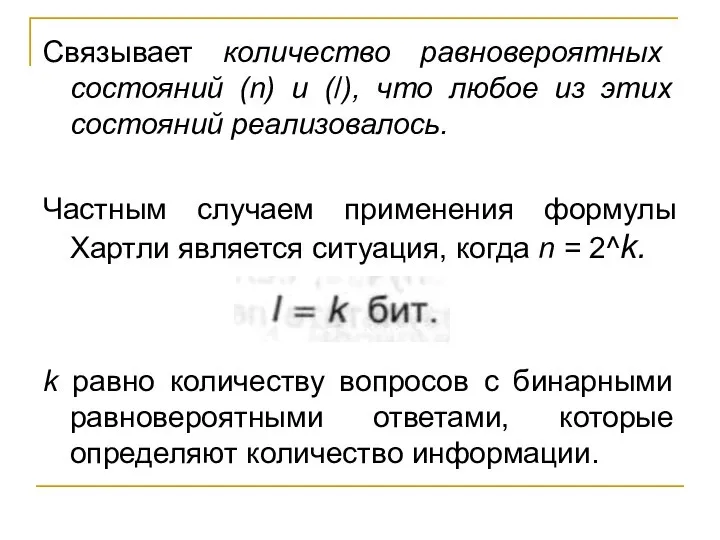

- 32. Cвязывает количество равновероятных состояний (n) и (/), что любое из этих состояний реализовалось. Частным случаем применения

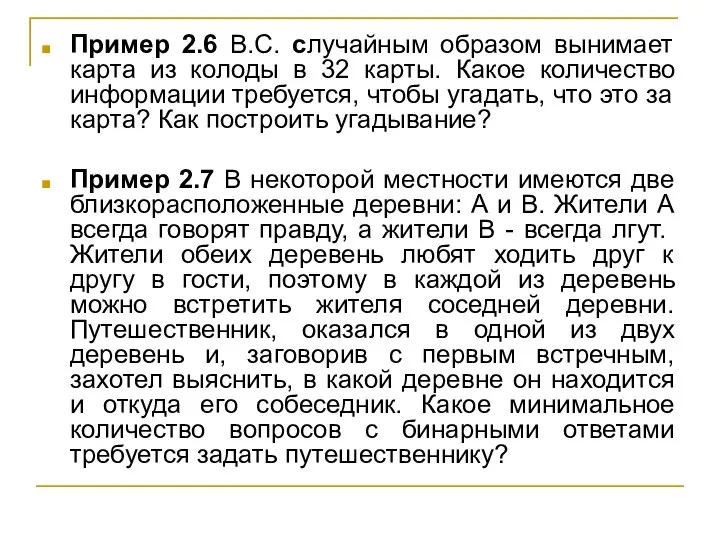

- 33. Пример 2.6 В.С. случайным образом вынимает карта из колоды в 32 карты. Какое количество информации требуется,

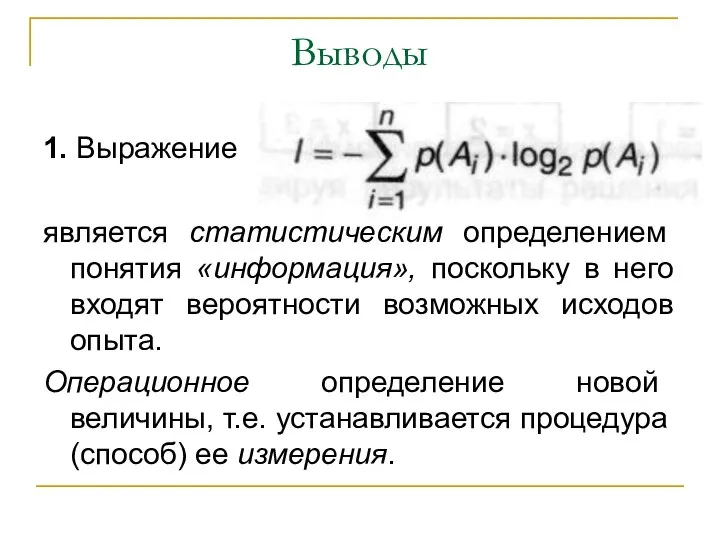

- 34. Выводы 1. Выражение является статистическим определением понятия «информация», поскольку в него входят вероятности возможных исходов опыта.

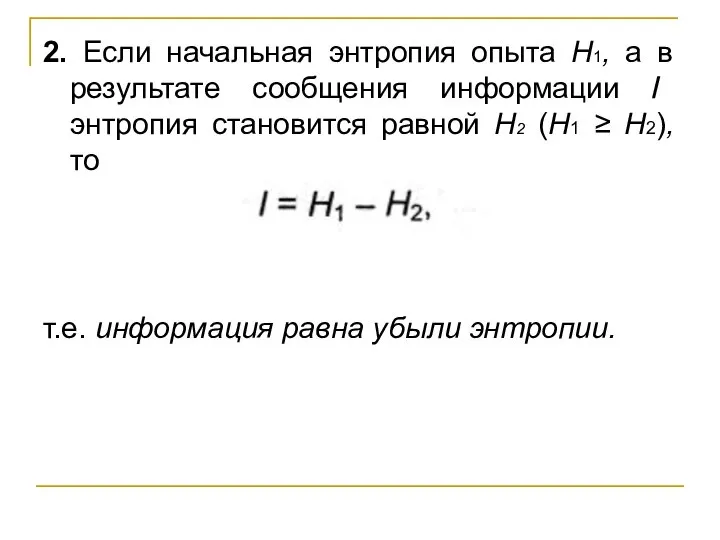

- 35. 2. Если начальная энтропия опыта Н1, а в результате сообщения информации / энтропия становится равной Н2

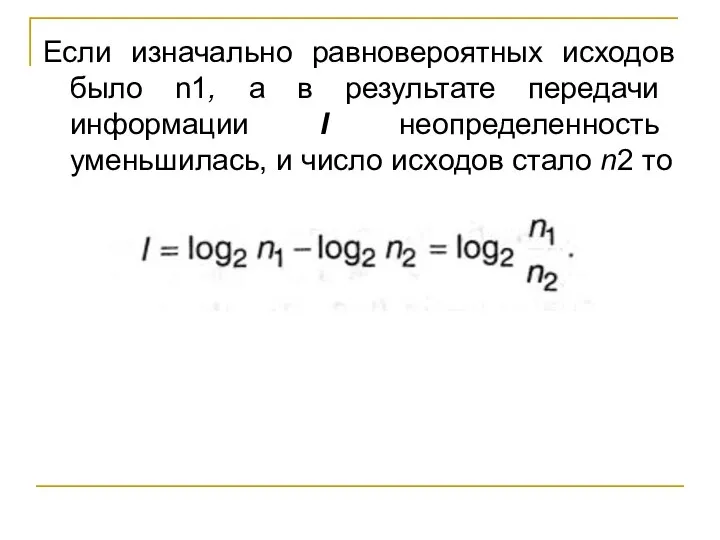

- 36. Если изначально равновероятных исходов было n1, а в результате передачи информации I неопределенность уменьшилась, и число

- 37. Определение. Информация - это содержание сообщения, понижающего неопределенность некоторого опыта с неоднозначным исходом; убыль связанной с

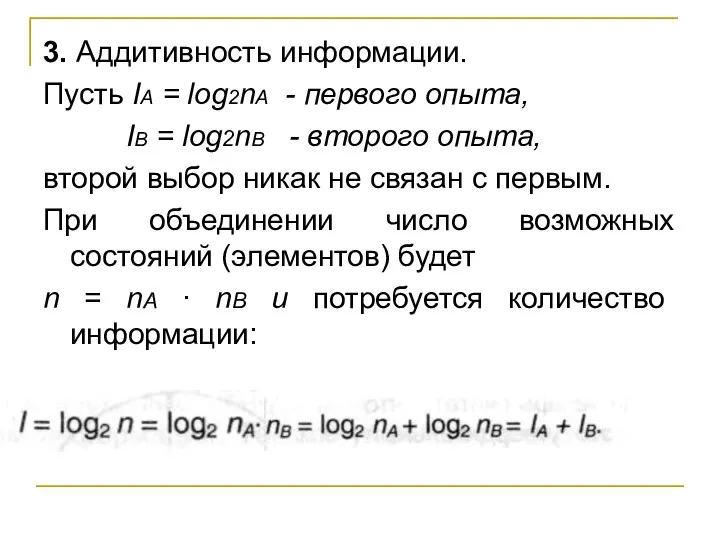

- 38. 3. Аддитивность информации. Пусть IА = log2nA - первого опыта, IB = log2nB - второго опыта,

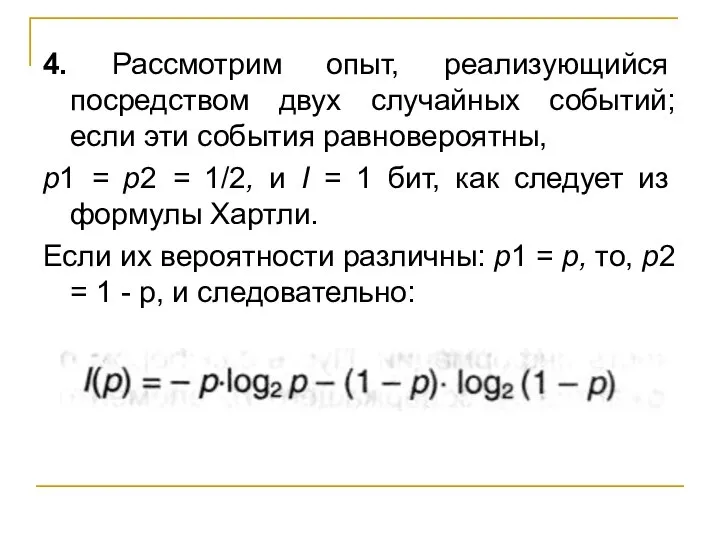

- 39. 4. Рассмотрим опыт, реализующийся посредством двух случайных событий; если эти события равновероятны, р1 = р2 =

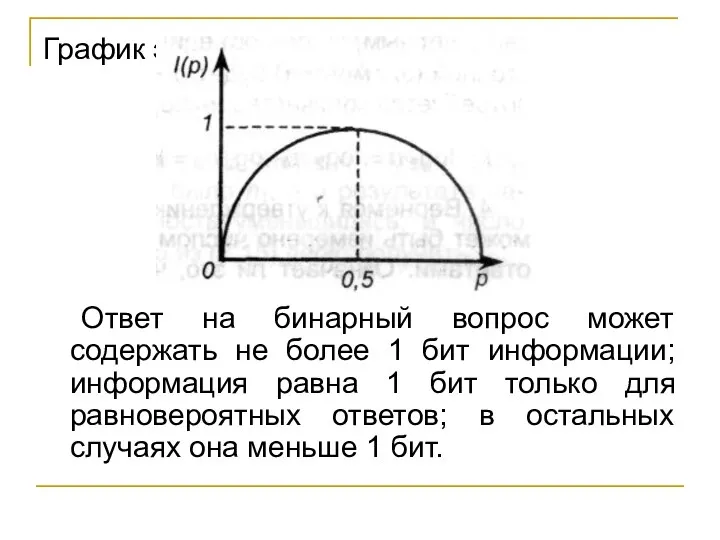

- 40. График этой функции Ответ на бинарный вопрос может содержать не более 1 бит информации; информация равна

- 41. Пример 2.8. При угадывании результата броска игральной кости задается вопрос «Выпало 6?». Какое количество информации содержит

- 42. На бытовом уровне, «информация» отождествляется с «информированностью», т.е. человеческим знанием. В «теории информации» информация является мерой

- 43. Глава 3. Кодирование символьной информации 3.1. Постановка задачи кодирования. Первая теорема Шеннона 3.2. Способы построения двоичных

- 44. 3.1. Постановка задачи кодирования. Первая теорема Шеннона Код (1) правило, описывающее соответствие знаков или их сочетаний

- 45. Декодирование - операция, обратная кодированию, т.е. восстановление информации в первичном алфавите по полученной последовательности кодов. Кодер

- 46. Источник представляет информацию в форме дискретного сообщения, используя для этого алфавит - первичным. Далее сообщение попадает

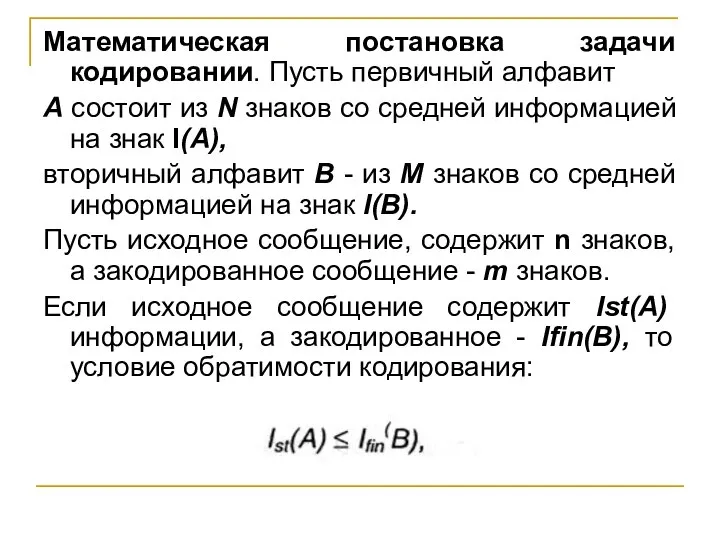

- 47. Математическая постановка задачи кодировании. Пусть первичный алфавит А состоит из N знаков со средней информацией на

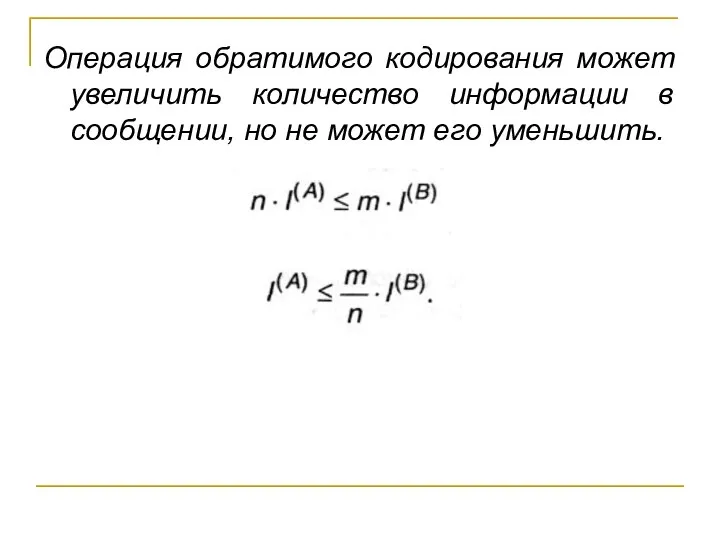

- 48. Операция обратимого кодирования может увеличить количество информации в сообщении, но не может его уменьшить.

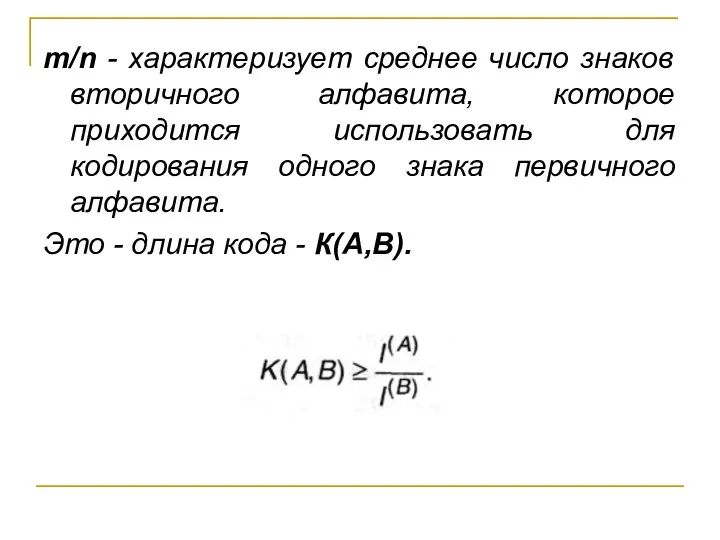

- 49. т/n - характеризует среднее число знаков вторичного алфавита, которое приходится использовать для кодирования одного знака первичного

- 50. Обычно N > М и I(А) > I(В), откуда К(А,В) > 1, т.е. один знак первичного

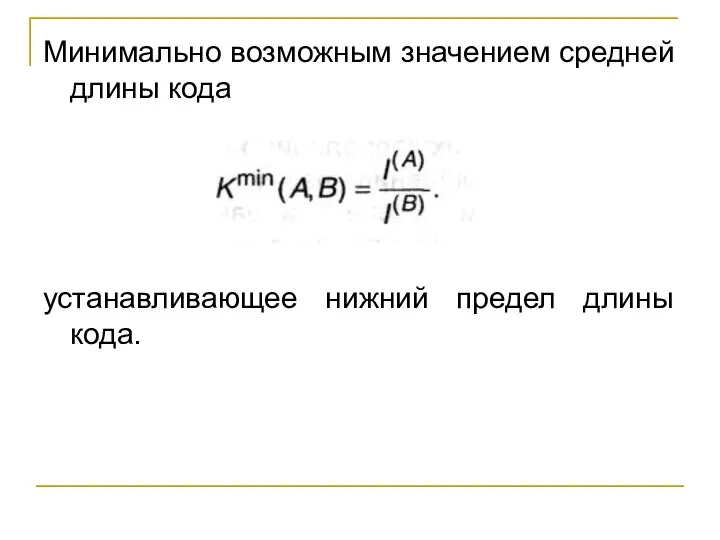

- 51. Минимально возможным значением средней длины кода устанавливающее нижний предел длины кода.

- 52. Первая теорема Шеннона (основная теорема о кодировании при отсутствии помех). 1. При отсутствии помех всегда возможен

- 53. Смысл теоремы: теорема открывает принципиальную возможность оптимального кодирования, т.е. построения кода со средней длиной Кmin(А,В).

- 54. Два пути сокращения Кmin(А,В): 1. уменьшение числителя - если при кодировании учесть различие частот появления разных

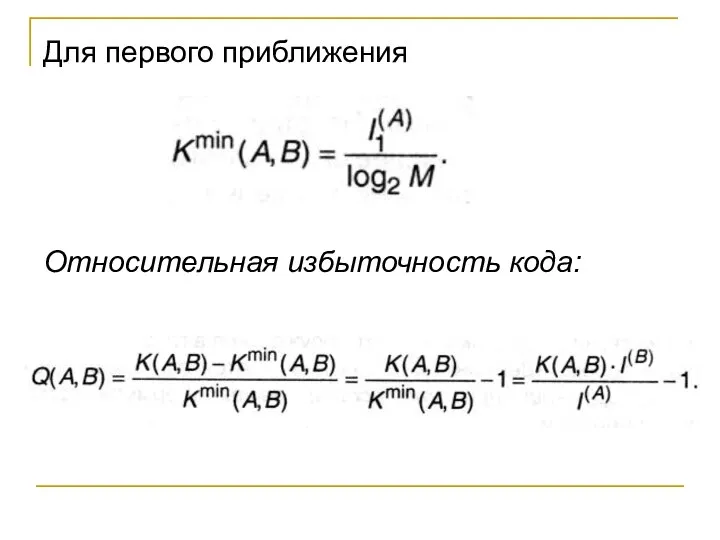

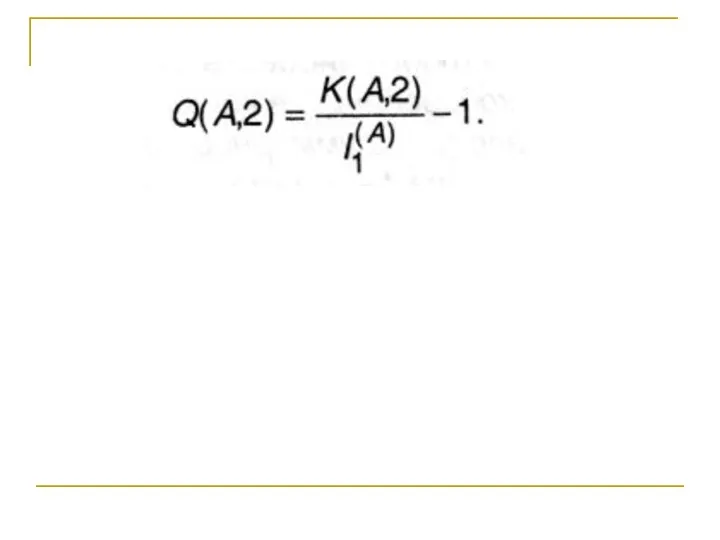

- 55. Для первого приближения Относительная избыточность кода:

- 56. Данная величина показывает, насколько операция кодирования увеличила длину исходного сообщения. Q(A,B) → 0 при К(А,В) →

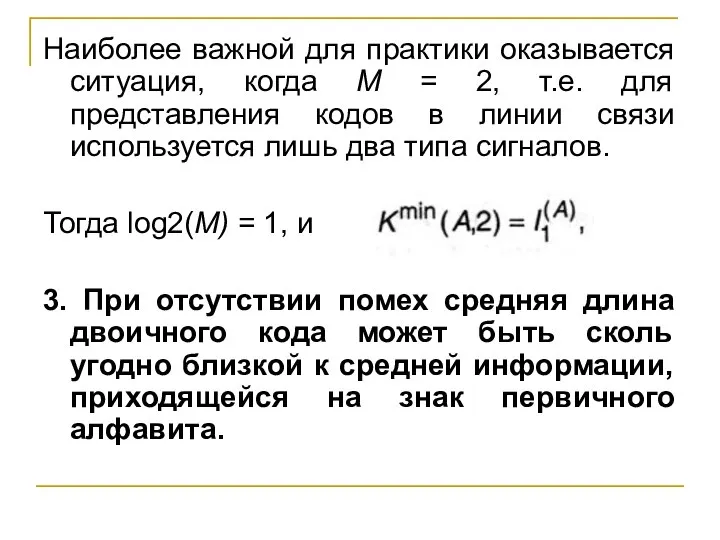

- 57. Наиболее важной для практики оказывается ситуация, когда М = 2, т.е. для представления кодов в линии

- 59. 3.2. Способы построения двоичных кодов

- 60. Возможны следующие особенности вторичного алфавита: элементарные сигналы (0 и 1) могут иметь одинаковые длительности (to=t1) или

- 61. 3.2.1. Алфавитное неравномерное двоичное кодирование сигналами равной длительности. Префиксные коды

- 62. знаки первичного алфавита (например, русского) кодируются комбинациями символов двоичного алфавита (т.е. 0 и 1). длина кодов

- 63. Для передачи информации, в среднем приходящейся на знак первичного алфавита, необходимо время T=K(A,2) ∙t Построить такую

- 64. Решение: коды знаков первичного алфавита, вероятность появления которых в сообщении выше, следует строить из возможно меньшего

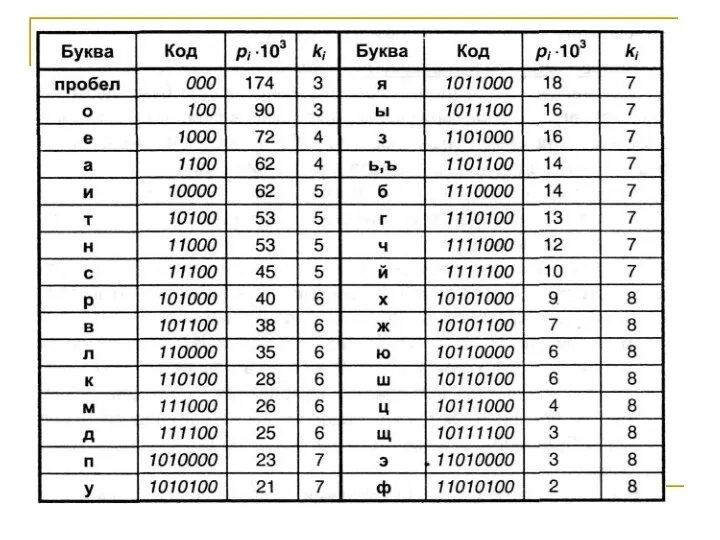

- 65. А) Неравномерный код с разделителем Разделителем отдельных кодов букв будет последовательность 00. Разделителем слов-слов – 000.

- 66. Правила построения кодов: код признака конца знака может быть включен в код буквы (т.е. коды всех

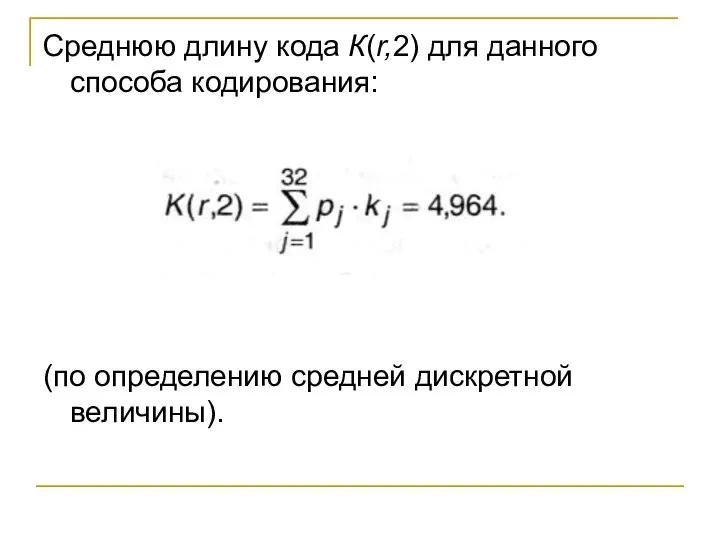

- 68. Среднюю длину кода К(r,2) для данного способа кодирования: (по определению средней дискретной величины).

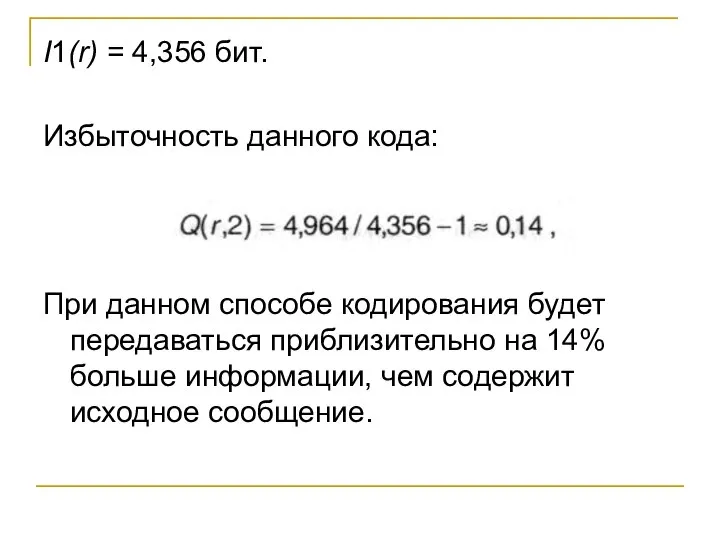

- 69. I1(r) = 4,356 бит. Избыточность данного кода: При данном способе кодирования будет передаваться приблизительно на 14%

- 70. Рассмотрев один из вариантов двоичного неравномерного кодирования, возникают вопросы: 1) Возможно ли такое кодирование без использования

- 71. Неравномерный код может быть однозначно декодирован, если никакой из кодов не совпадает с началом (префиксом) какого-либо

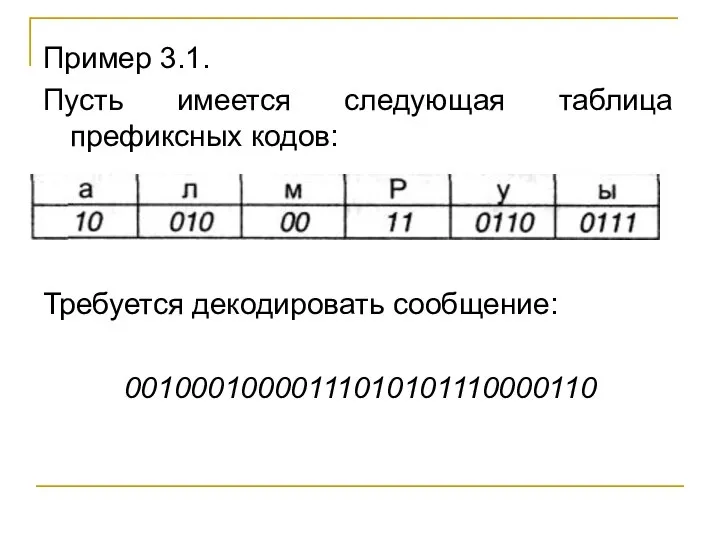

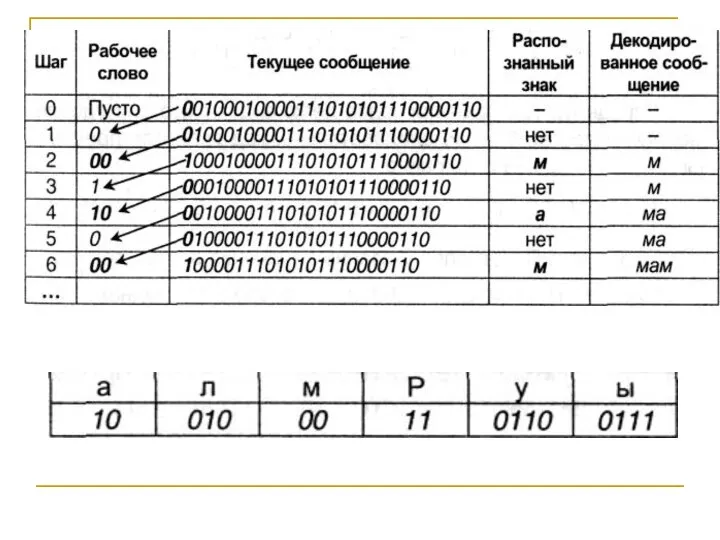

- 72. Пример 3.1. Пусть имеется следующая таблица префиксных кодов: Требуется декодировать сообщение: 00100010000111010101110000110

- 73. Декодирование производится циклически 1. отрезать от текущего сообщения крайний левый символ, присоединить справа к рабочему кодовому

- 75. Таким образом, использование префиксного кодирования позволяет делать сообщение более коротким. Условие Фано не устанавливает способа формирования

- 76. В) Префиксный код Шеннона-Фано. Данный вариант кодирования был предложен в 1948-1949 гг. независимо Р. Фано и

- 77. Пусть имеется первичный алфавит А, состоящий из шести знаков а1 ...а6 с вероятностями появления в сообщении,

- 79. Средняя длина кода равна: I1(A) = 2,390 бит. избыточность кода Q(A,2) = 0,0249, т.е. около 2,5%.

- 80. Данный код нельзя считать оптимальным, поскольку вероятности появления 0 и 1 неодинаковы (6/17=0,35 и 11/17=0,65, соответственно).

- 81. С) Префиксный код Хаффмана

- 82. Способ оптимального префиксного двоичного кодирования был предложен Д. Хаффманом. Построение кодов Хаффмана рассмотрим на том же

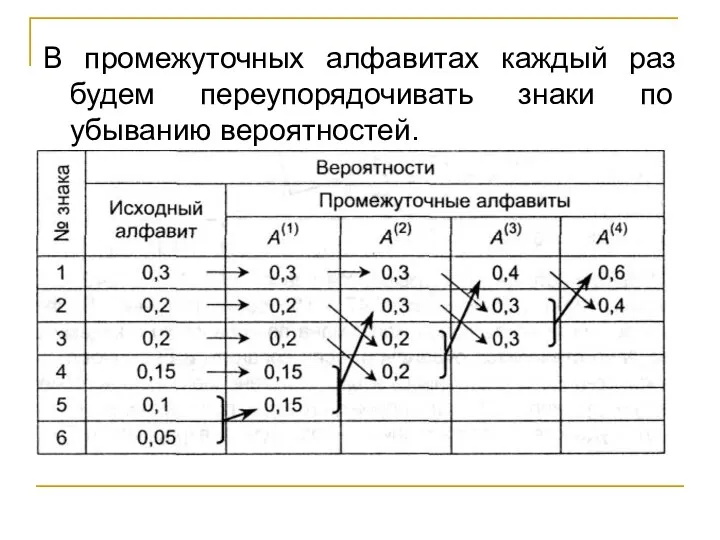

- 83. Аналогично продолжим создавать новые алфавиты, пока в последнем не останется два знака. Количество таких шагов будет

- 84. В промежуточных алфавитах каждый раз будем переупорядочивать знаки по убыванию вероятностей.

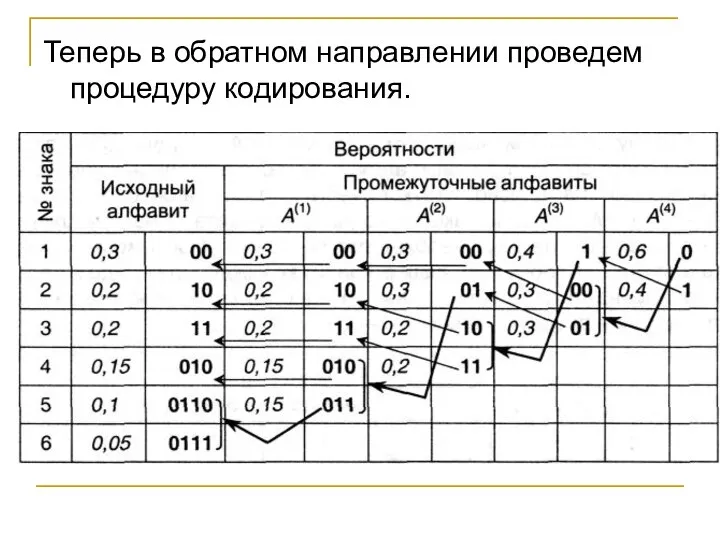

- 85. Теперь в обратном направлении проведем процедуру кодирования.

- 86. К(А,2) = 0,3 ∙ 2 + 0,2 ∙ 2 + 0,2 ∙ 2 +0,15 ∙ 3

- 87. Код Хаффмана важен в теоретическом отношении, поскольку можно доказать, что он является самым экономичным из всех

- 88. Метод Хаффмана и его модификация - метод адаптивного кодирования (динамическое кодирование Хаффмана) - нашли широчайшее применение

- 90. Скачать презентацию

Анализ информационных моделей

Анализ информационных моделей Общение в Skype

Общение в Skype Архитектура ПК

Архитектура ПК Как строить карьеру в третьем десятилетии XXI века

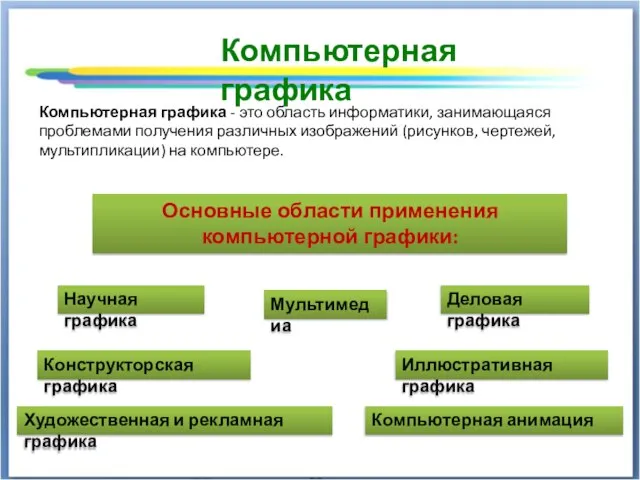

Как строить карьеру в третьем десятилетии XXI века Компьютерная графика. Создание 3D модели

Компьютерная графика. Создание 3D модели Разработка требований для АО XXX

Разработка требований для АО XXX Дети и Интернет

Дети и Интернет Система управления базами данных. Моделирование и формализация. 9 класс

Система управления базами данных. Моделирование и формализация. 9 класс Виды информации и способы предоставления ее в ЭВМ

Виды информации и способы предоставления ее в ЭВМ Интернет – телевидение (IPTV)

Интернет – телевидение (IPTV) Создание презентации для выступления

Создание презентации для выступления Пакет подготовки презентаций

Пакет подготовки презентаций Программное обеспечение (ПО) компьютера

Программное обеспечение (ПО) компьютера Создание программы для рисования

Создание программы для рисования Консалтинг по правовым ресурсам интернета. Мы - избиратели XXI века

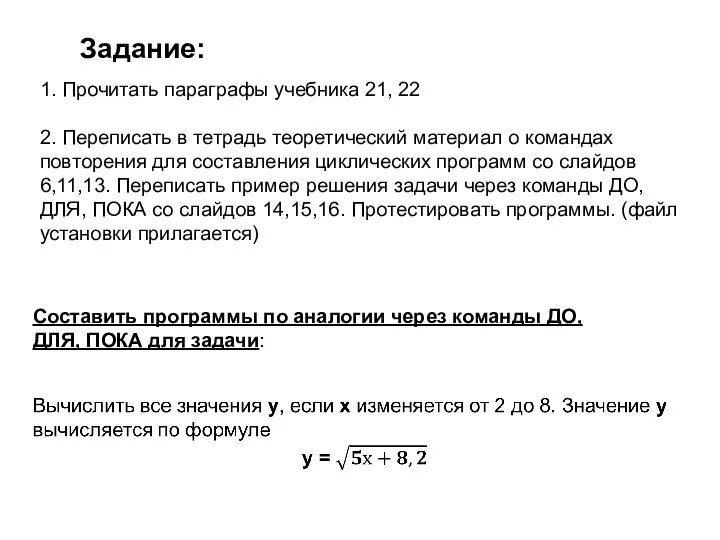

Консалтинг по правовым ресурсам интернета. Мы - избиратели XXI века Циклы Паскаль

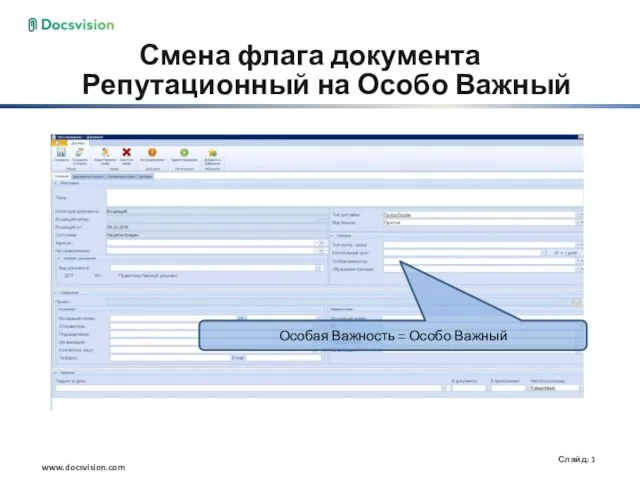

Циклы Паскаль Смена флага документа репутационный на особо важный

Смена флага документа репутационный на особо важный Язык программирования Python

Язык программирования Python Аппаратное и программное обеспечение ЭВМ

Аппаратное и программное обеспечение ЭВМ Глобальные сети, Интернет (1)

Глобальные сети, Интернет (1) WHILE … WEND ЦИКЛ

WHILE … WEND ЦИКЛ ANY_SOURCE и ANY_TAG

ANY_SOURCE и ANY_TAG Понятие об электронной таблице

Понятие об электронной таблице Smart Elections (Умные выборы)

Smart Elections (Умные выборы) 1_3_1_4_Представление_данных_и_операции_Дружинская

1_3_1_4_Представление_данных_и_операции_Дружинская Инструкция по регистрации в программе лояльности Continental 2021

Инструкция по регистрации в программе лояльности Continental 2021 Frontend. Основные теги

Frontend. Основные теги Использование программ в режиме удаленного пользования. Изготовление электронной почты

Использование программ в режиме удаленного пользования. Изготовление электронной почты