Содержание

- 2. Проблематика Где нужна вычислительная мощность: - Ускорение вычислений - Переход в реальное время - Разгрузка CPU

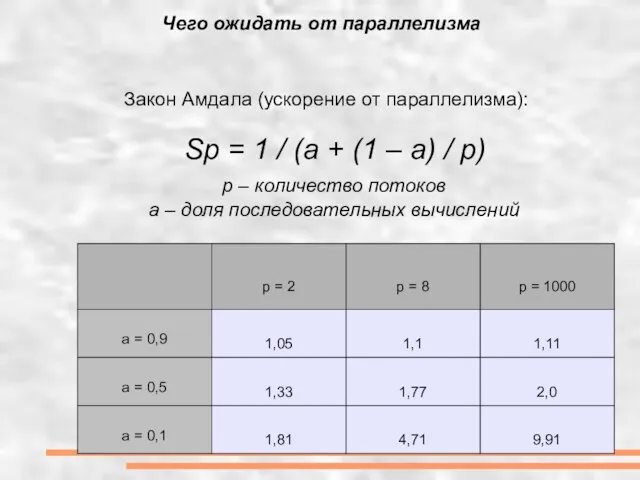

- 3. Чего ожидать от параллелизма Закон Амдала (ускорение от параллелизма): Sp = 1 / (a + (1

- 4. - Параллелизм данных, DPL: MMX, SSE, и т. д. - Параллелизм кода, IPL: спекулятивные вычисления и

- 5. Предыстория к GPGPU 1990 1995 2000 2005 2010 Сопроцессор Видео- ускоритель Шейдеры GPU

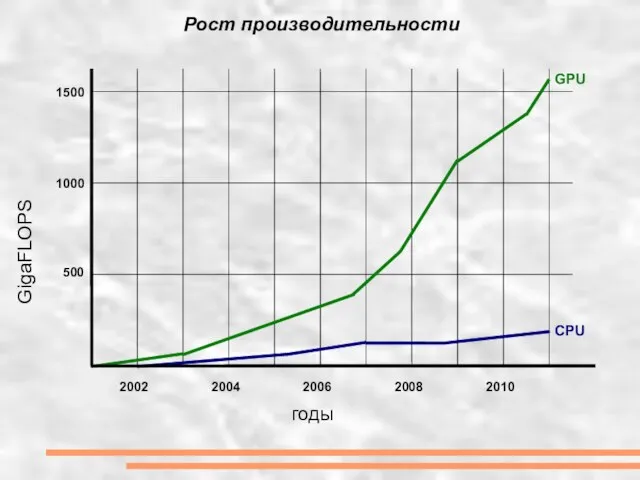

- 6. Рост производительности GigaFLOPS годы 500 1000 1500 2002 2004 2006 2008 2010 GPU CPU

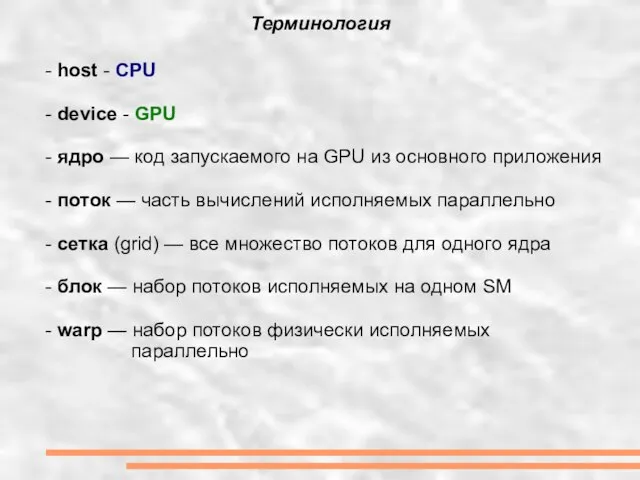

- 7. Терминология - host - CPU - device - GPU - ядро — код запускаемого на GPU

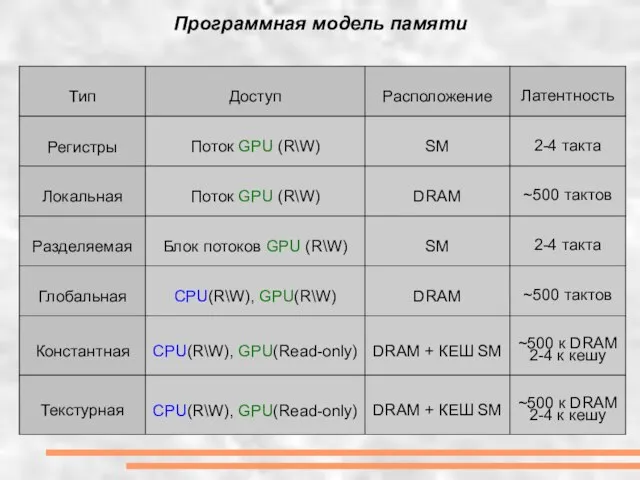

- 8. Программная модель памяти

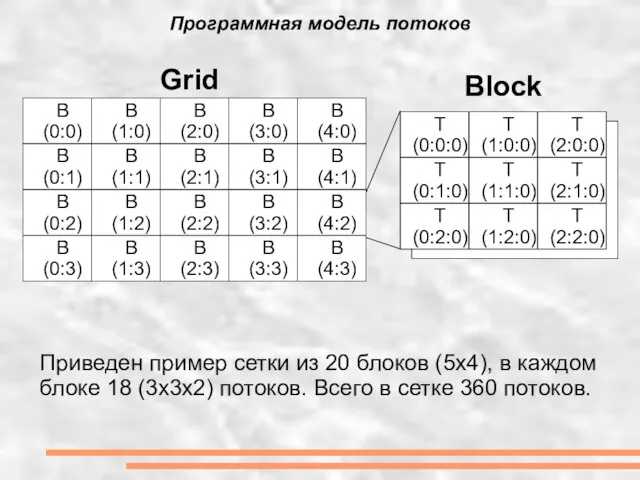

- 9. Программная модель потоков B (0:0) B (0:1) B (0:2) B (0:3) B (1:0) B (1:1) B

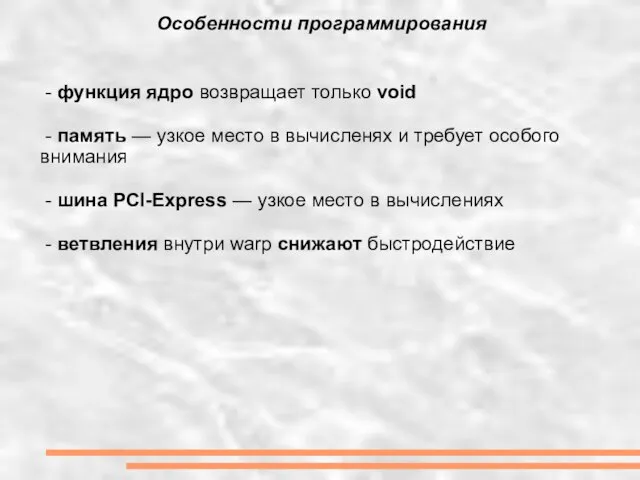

- 10. Особенности программирования - функция ядро возвращает только void - память — узкое место в вычисленях и

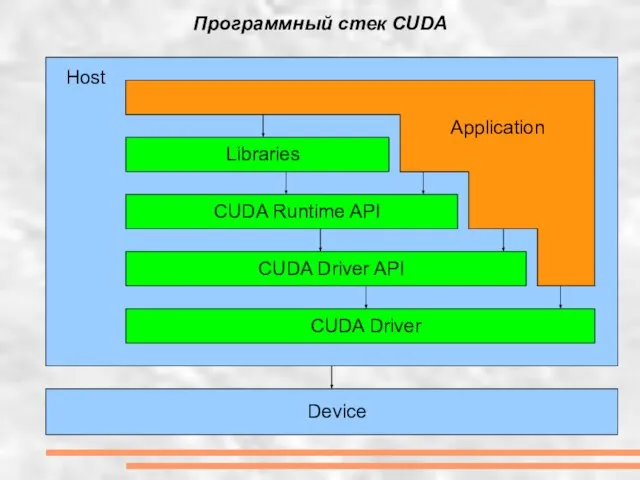

- 11. Программный стек CUDA Device Host CUDA Driver CUDA Driver API CUDA Runtime API Libraries Application

- 12. Последняя версия CUDA Toolkit 4.0 RC2 - https://nvdeveloper.nvidia.com Состав: - Драйвер для разработчиков - GPU Computing

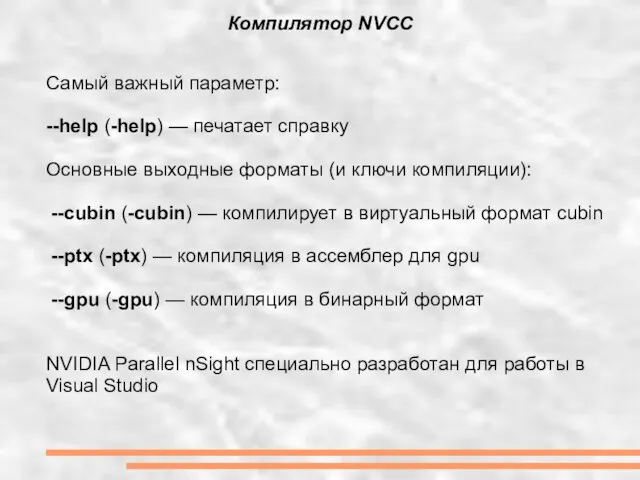

- 13. Самый важный параметр: --help (-help) — печатает справку Основные выходные форматы (и ключи компиляции): --cubin (-cubin)

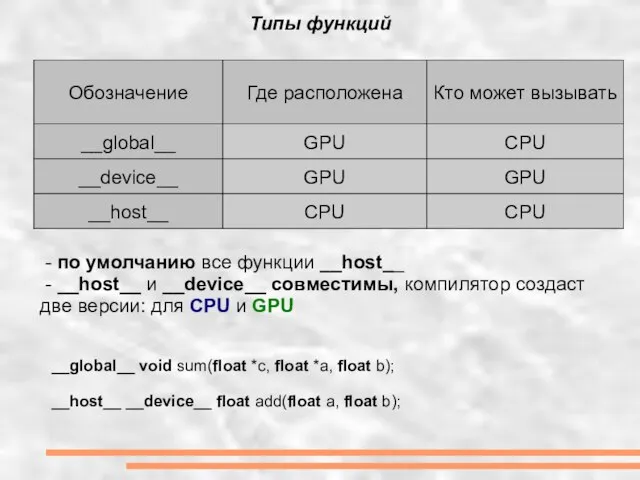

- 14. Типы функций - по умолчанию все функции __host__ - __host__ и __device__ совместимы, компилятор создаст две

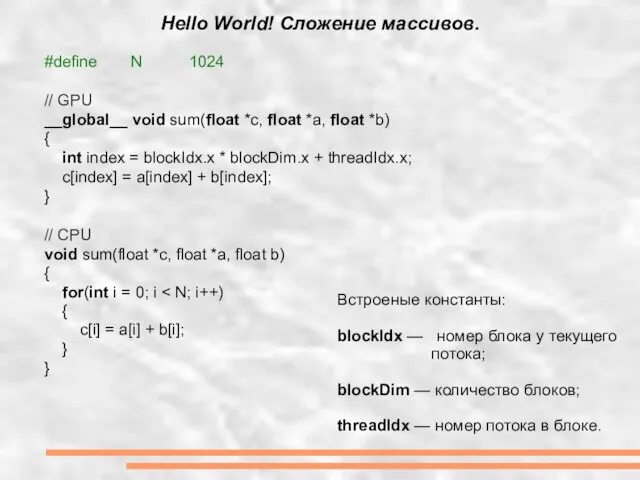

- 15. Hello World! Сложение массивов. #define N 1024 // GPU __global__ void sum(float *c, float *a, float

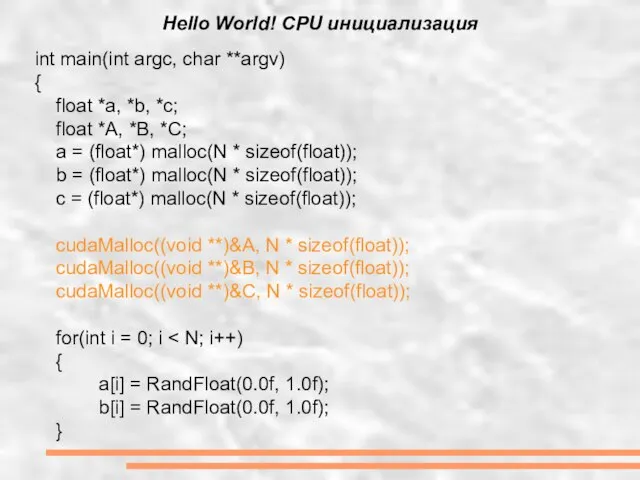

- 16. Hello World! CPU инициализация int main(int argc, char **argv) { float *a, *b, *c; float *A,

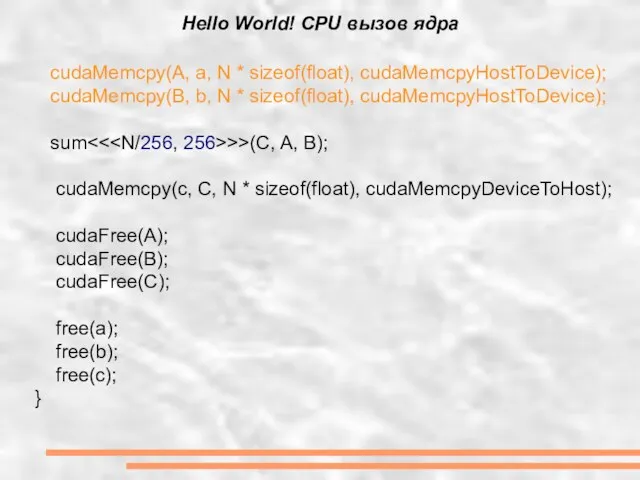

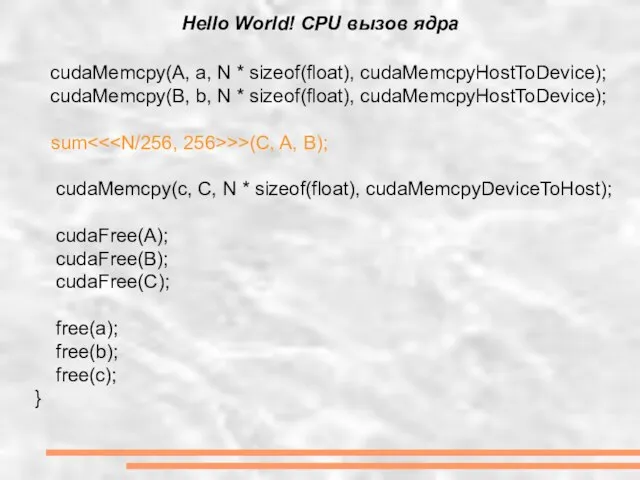

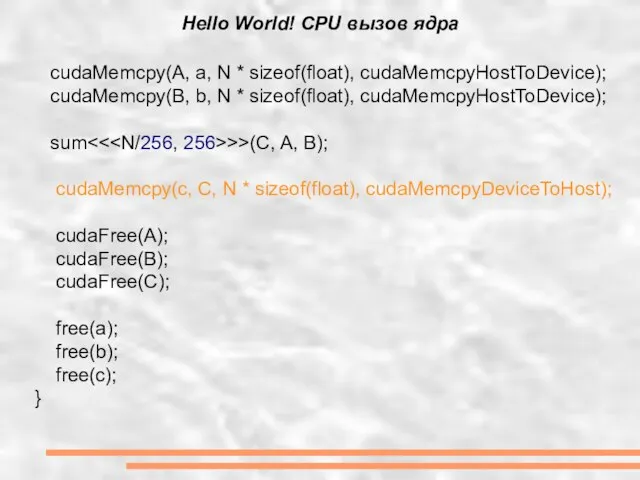

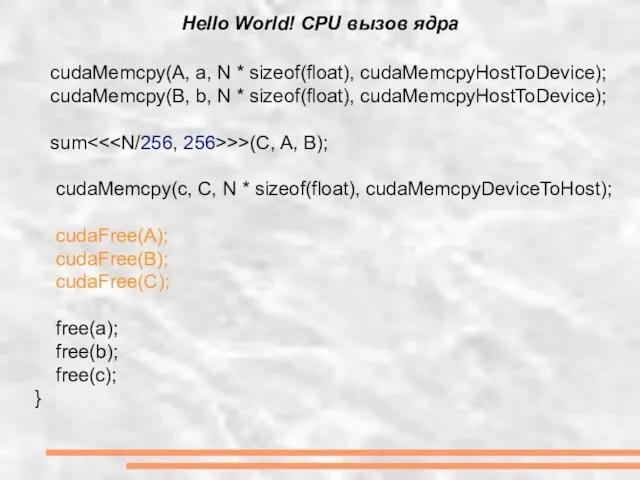

- 17. Hello World! CPU вызов ядра cudaMemcpy(A, a, N * sizeof(float), cudaMemcpyHostToDevice); cudaMemcpy(B, b, N * sizeof(float),

- 18. Hello World! CPU вызов ядра cudaMemcpy(A, a, N * sizeof(float), cudaMemcpyHostToDevice); cudaMemcpy(B, b, N * sizeof(float),

- 19. Hello World! CPU вызов ядра cudaMemcpy(A, a, N * sizeof(float), cudaMemcpyHostToDevice); cudaMemcpy(B, b, N * sizeof(float),

- 20. Hello World! CPU вызов ядра cudaMemcpy(A, a, N * sizeof(float), cudaMemcpyHostToDevice); cudaMemcpy(B, b, N * sizeof(float),

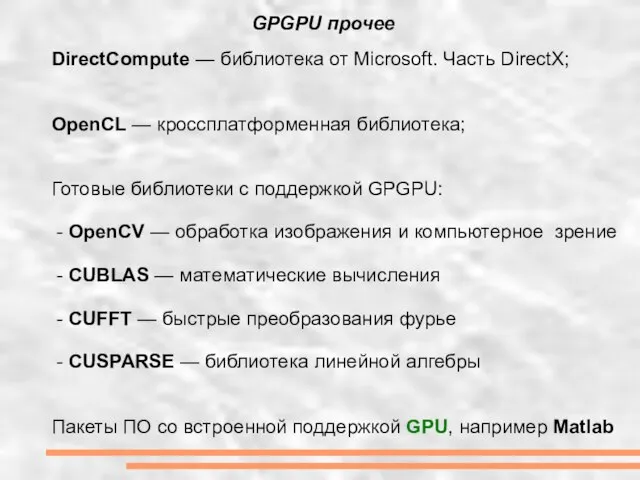

- 21. GPGPU прочее DirectCompute — библиотека от Microsoft. Часть DirectX; OpenCL — кроссплатформенная библиотека; Готовые библиотеки с

- 22. OpenCV #include #include "opencv2/opencv.hpp" #include "opencv2/gpu/gpu.hpp" int main (int argc, char* argv[]) { cv::gpu::GpuMat dst, src

- 24. Скачать презентацию

![OpenCV #include #include "opencv2/opencv.hpp" #include "opencv2/gpu/gpu.hpp" int main (int argc, char* argv[])](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/474589/slide-21.jpg)

Колледжи и техникумы Челябинска 2020

Колледжи и техникумы Челябинска 2020 Красота человека (мужской образ)

Красота человека (мужской образ) В системе комплексной физкультурно-оздоровительной работы. Плавание как одно из средств закаливания

В системе комплексной физкультурно-оздоровительной работы. Плавание как одно из средств закаливания План застройки г. Бежецк, развитие общественного центра

План застройки г. Бежецк, развитие общественного центра Наш 8«Б»

Наш 8«Б» Режим дня Режим – это распорядок дел в течение дня. При составлении режима дня необходимо соблюдать правила: 1. Учёбу и труд сочетат

Режим дня Режим – это распорядок дел в течение дня. При составлении режима дня необходимо соблюдать правила: 1. Учёбу и труд сочетат Основные аспекты применения специального налогового режима Налог на профессиональный доход

Основные аспекты применения специального налогового режима Налог на профессиональный доход «Современные формы и содержание работы образовательного учреждения по повышению педагогической культуры родителей, совместная

«Современные формы и содержание работы образовательного учреждения по повышению педагогической культуры родителей, совместная  Меры по развитию конкуренции на торгах на право заключения концессионных соглашений

Меры по развитию конкуренции на торгах на право заключения концессионных соглашений Презентация на тему Давление газа (7 класс)

Презентация на тему Давление газа (7 класс) Բոլոր երկրները ԱՄՆ Բարի գալուստ

Բոլոր երկրները ԱՄՆ Բարի գալուստ Общие сведения о США

Общие сведения о США Дельфины

Дельфины Готовим всей семьёй

Готовим всей семьёй Диффузия

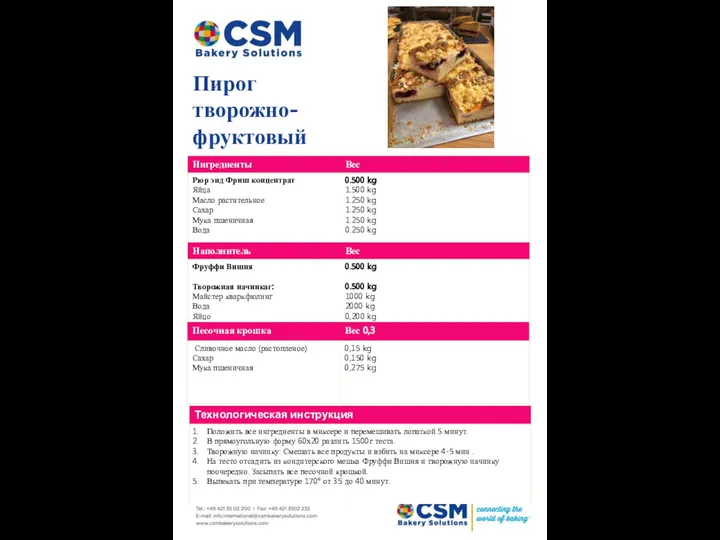

Диффузия Пирог творожно-фруктовый

Пирог творожно-фруктовый Философия древней греции

Философия древней греции Презентация на тему Вид глагола

Презентация на тему Вид глагола Древняя Индия и Китай

Древняя Индия и Китай XIII Международная конференция "Маркетинг в России" Сообщение: «ОСОБЕННОСТИ ОНЛАЙН ИССЛЕДОВАНИЙ В РОССИИ» Александр Шашкин (Online Market

XIII Международная конференция "Маркетинг в России" Сообщение: «ОСОБЕННОСТИ ОНЛАЙН ИССЛЕДОВАНИЙ В РОССИИ» Александр Шашкин (Online Market  Сообщение Приемы воспитания силы воли или Программа самовоспитания

Сообщение Приемы воспитания силы воли или Программа самовоспитания Работа с детьми группы риска

Работа с детьми группы риска Права и обязанности сторон в период действия договора страхования и при наступлении страхового случая Белоглазова Юлия, Белоголо

Права и обязанности сторон в период действия договора страхования и при наступлении страхового случая Белоглазова Юлия, Белоголо Коллективно-творческое дело Удмуртский код

Коллективно-творческое дело Удмуртский код Презентация на тему Библиотечный урок

Презентация на тему Библиотечный урок Презентация на тему Теорема Пифагора и её применение

Презентация на тему Теорема Пифагора и её применение  Одежда говорит о человеке

Одежда говорит о человеке Коллекционные монеты – Древние города России

Коллекционные монеты – Древние города России