Содержание

- 2. Москва, 2008 г. Параллельное программирование с OpenMP: Введение © Бахтин В.А. из 32 Содержание Тенденции развития

- 3. В течение нескольких десятилетий развитие ЭВМ сопровождалось удвоением их быстродействия каждые 1.5-2 года. Это обеспечивалось и

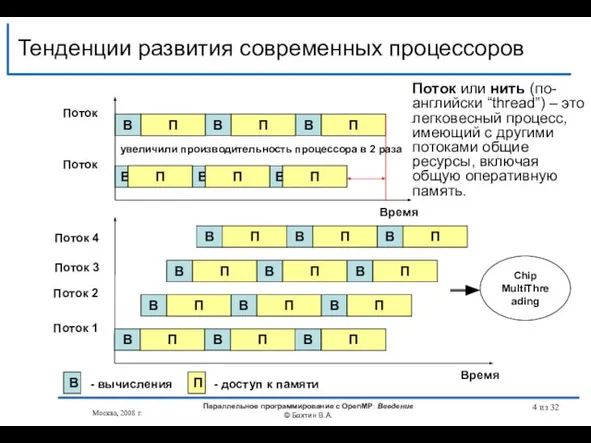

- 4. Время Тенденции развития современных процессоров В П В П В П В П В П В

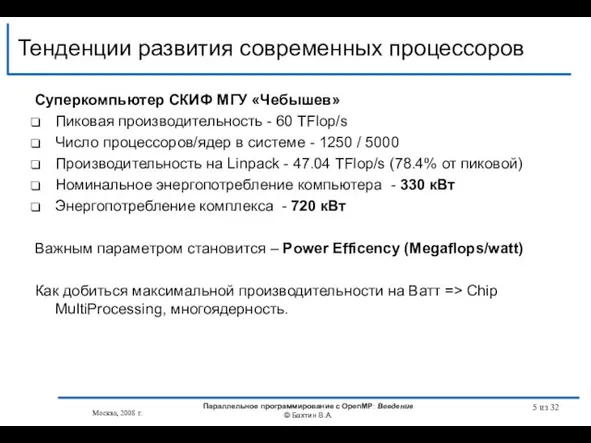

- 5. Тенденции развития современных процессоров Суперкомпьютер СКИФ МГУ «Чебышев» Пиковая производительность - 60 TFlop/s Число процессоров/ядер в

- 6. Тенденции развития современных процессоров Quad-Core AMD Opteron 4 ядра встроенный контроллер памяти (2 канала памяти DDR2

- 7. Тенденции развития современных процессоров Intel Core i7 (архитектура Nehalem ) 4 ядра 8 потоков с технологией

- 8. Тенденции развития современных процессоров SUN UltraSPARC T2 Processor (Niagara 2) 8 ядер 64 потоков 4 контроллера

- 9. из 32 Тенденции развития современных процессоров Темпы уменьшения латентности памяти гораздо ниже темпов ускорения процессоров +

- 10. Существующие подходы для создания параллельных программ Автоматическое распараллеливание Библиотеки нитей Win32 API POSIX Библиотеки передачи сообщений

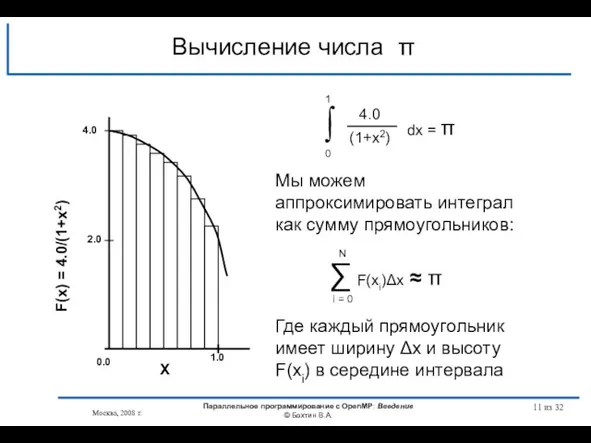

- 11. Вычисление числа π Москва, 2008 г. Параллельное программирование с OpenMP: Введение © Бахтин В.А. из 32

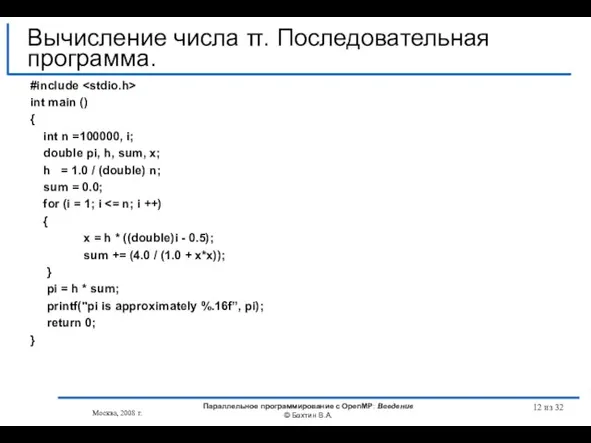

- 12. из 32 #include int main () { int n =100000, i; double pi, h, sum, x;

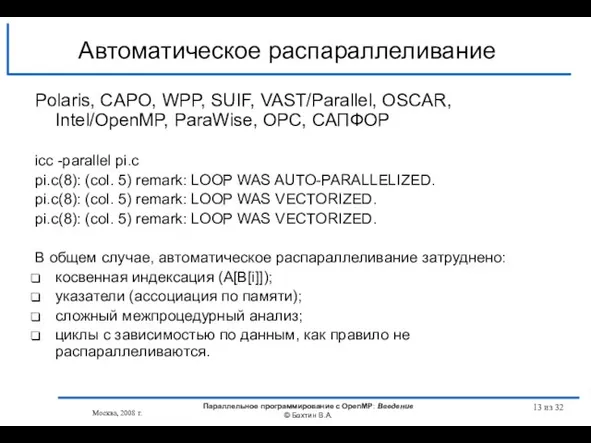

- 13. Автоматическое распараллеливание Polaris, CAPO, WPP, SUIF, VAST/Parallel, OSCAR, Intel/OpenMP, ParaWise, ОРС, САПФОР icc -parallel pi.c pi.c(8):

- 14. из 32 #include "mpi.h" #include int main (int argc, char *argv[]) { int n =100000, myid,

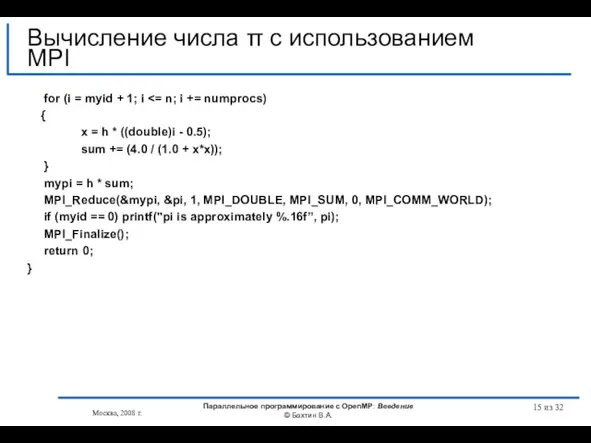

- 15. из 32 for (i = myid + 1; i { x = h * ((double)i -

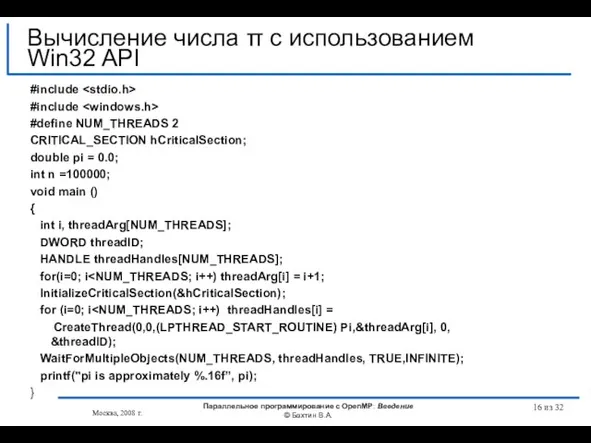

- 16. из 32 #include #include #define NUM_THREADS 2 CRITICAL_SECTION hCriticalSection; double pi = 0.0; int n =100000;

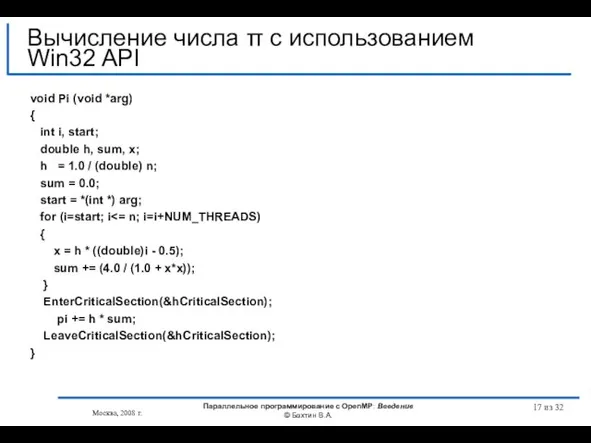

- 17. из 32 void Pi (void *arg) { int i, start; double h, sum, x; h =

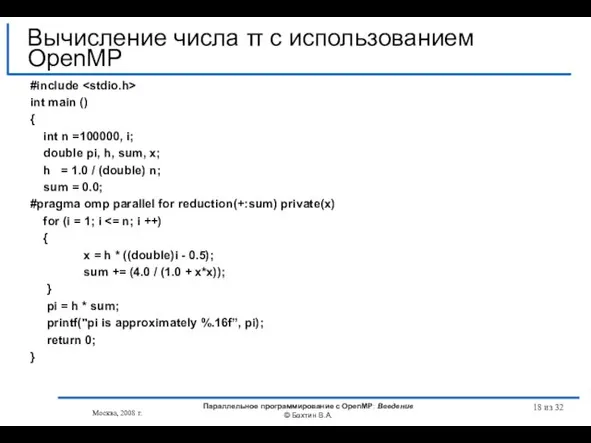

- 18. из 32 #include int main () { int n =100000, i; double pi, h, sum, x;

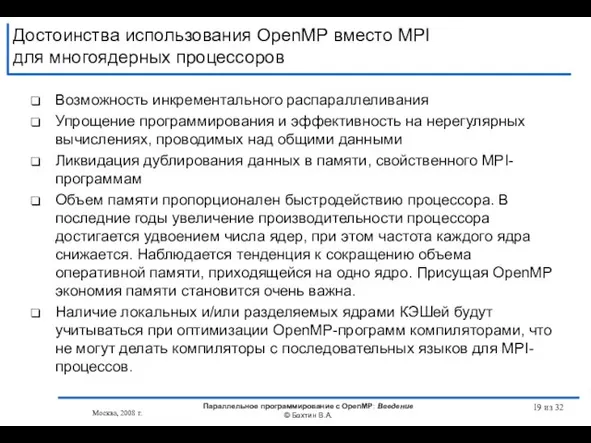

- 19. Достоинства использования OpenMP вместо MPI для многоядерных процессоров Возможность инкрементального распараллеливания Упрощение программирования и эффективность на

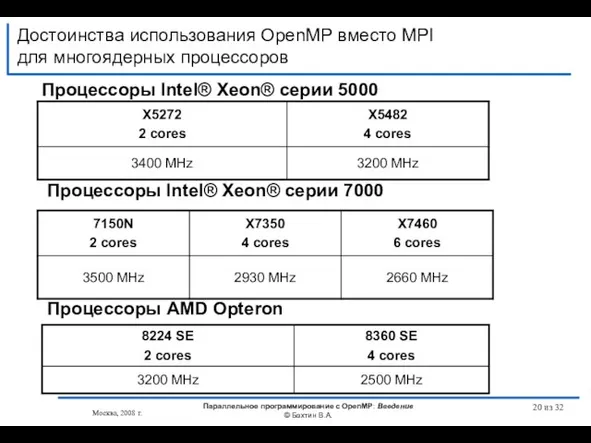

- 20. Достоинства использования OpenMP вместо MPI для многоядерных процессоров Процессоры Intel® Xeon® серии 5000 Процессоры Intel® Xeon®

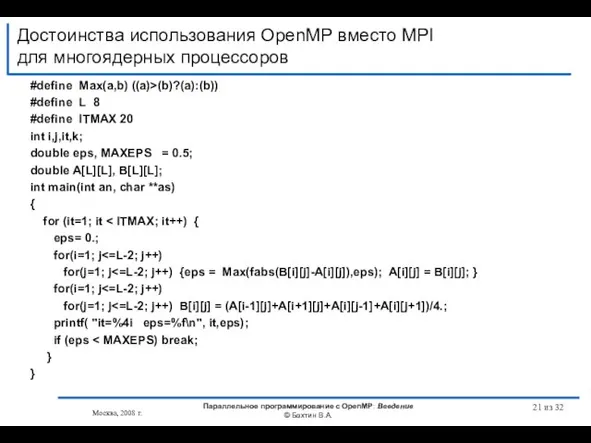

- 21. Достоинства использования OpenMP вместо MPI для многоядерных процессоров #define Max(a,b) ((a)>(b)?(a):(b)) #define L 8 #define ITMAX

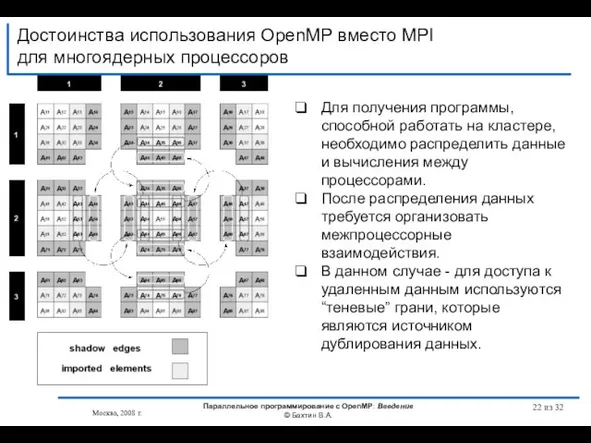

- 22. Достоинства использования OpenMP вместо MPI для многоядерных процессоров Москва, 2008 г. Параллельное программирование с OpenMP: Введение

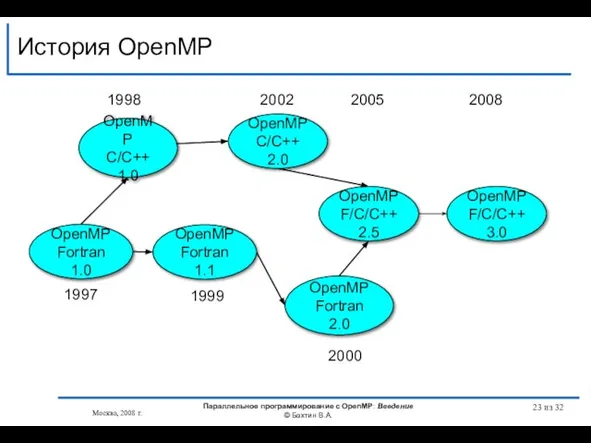

- 23. История OpenMP OpenMP Fortran 1.1 OpenMP C/C++ 1.0 OpenMP Fortran 2.0 OpenMP C/C++ 2.0 1998 2000

- 24. OpenMP Architecture Review Board AMD Cray Fujitsu HP IBM Intel NEC The Portland Group, Inc. SGI

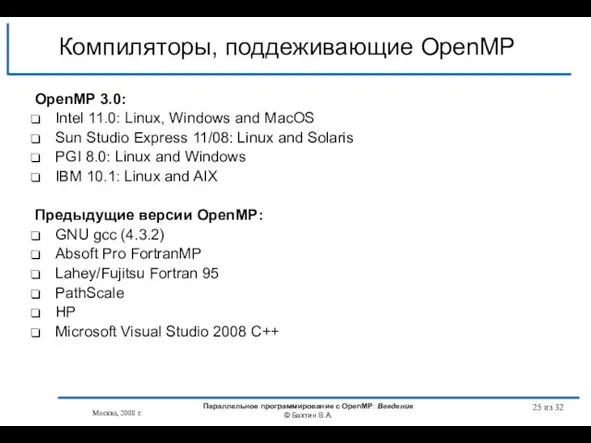

- 25. Компиляторы, поддеживающие OpenMP OpenMP 3.0: Intel 11.0: Linux, Windows and MacOS Sun Studio Express 11/08: Linux

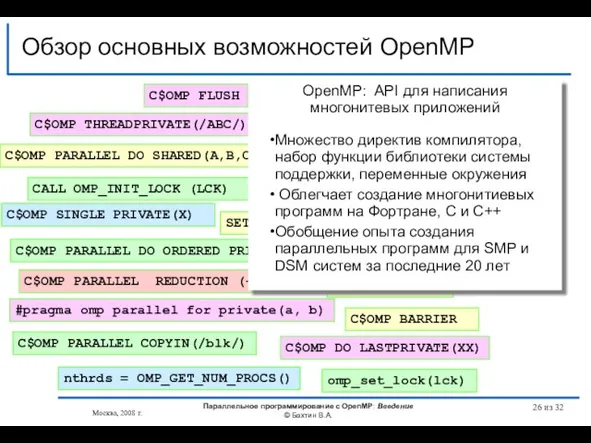

- 26. Обзор основных возможностей OpenMP omp_set_lock(lck) #pragma omp parallel for private(a, b) #pragma omp critical C$OMP PARALLEL

- 27. из 32 Литература… http://www.openmp.org http://www.compunity.org http://www.parallel.ru/tech/tech_dev/openmp.html Москва, 2008 г. Параллельное программирование с OpenMP: Введение © Бахтин

- 28. из 32 Литература… Гергель В.П. Теория и практика параллельных вычислений. - М.: Интернет-Университет, БИНОМ. Лаборатория знаний,

- 29. из 32 Литература… Учебные курсы Интернет Университета Информационных технологий Гергель В.П. Теория и практика параллельных вычислений.

- 30. из 32 Вопросы? Вопросы? Москва, 2008 г. Параллельное программирование с OpenMP: Введение © Бахтин В.А.

- 31. из 32 OpenMP – модель параллелизма по управлению Следующая тема Москва, 2008 г. Параллельное программирование с

- 33. Скачать презентацию

![из 32 #include "mpi.h" #include int main (int argc, char *argv[]) {](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/468078/slide-13.jpg)

Тульский самовар

Тульский самовар Презентация на тему Зарубежная литература 19 века

Презентация на тему Зарубежная литература 19 века

Астекс_19.04.19_финальная версия

Астекс_19.04.19_финальная версия Герои Советского Союза Петуховского района к 65- летию Великой Победы

Герои Советского Союза Петуховского района к 65- летию Великой Победы Формирование научного мировоззрения на уроках «Окружающего мира»

Формирование научного мировоззрения на уроках «Окружающего мира» Проблемы питания

Проблемы питания  Общественное объединение «Центр экономического и гражданского образования ЮКО «Интеллект»

Общественное объединение «Центр экономического и гражданского образования ЮКО «Интеллект» Слово Школа

Слово Школа Всё начинается с любви…

Всё начинается с любви… Межличностные отношения

Межличностные отношения La Republique En Marche

La Republique En Marche Импульс тела. Импульс силы. Закон сохранения импульса

Импульс тела. Импульс силы. Закон сохранения импульса COLLOCATIONAL ASPECTS OF TRANSLATION

COLLOCATIONAL ASPECTS OF TRANSLATION Лексикология. В поисках смысла…

Лексикология. В поисках смысла… Педагогические приемы создания ситуации успеха

Педагогические приемы создания ситуации успеха Чистые слова

Чистые слова Белочка

Белочка Информация Информационные процессы

Информация Информационные процессы  Лингвистическийинтеллектуальный марафон

Лингвистическийинтеллектуальный марафон Презентация на тему Эмоции

Презентация на тему Эмоции Единый Государственный экзамен

Единый Государственный экзамен CERT AM servicesСервисы CERT AM

CERT AM servicesСервисы CERT AM Химия в жизни общества

Химия в жизни общества Дорожки в газоне, экопарковки

Дорожки в газоне, экопарковки Нормативное правовое регулирование деятельности автономных учреждений

Нормативное правовое регулирование деятельности автономных учреждений Наука, Технология. Я

Наука, Технология. Я Implementing a cluster-based innovation policy in Russia : a model to invent Jean-Louis Truel Associate professor Université Paris-Est Créteil; Vice-President.

Implementing a cluster-based innovation policy in Russia : a model to invent Jean-Louis Truel Associate professor Université Paris-Est Créteil; Vice-President. Натюрморт. Ван Гог Натюрморт с подсолнухами

Натюрморт. Ван Гог Натюрморт с подсолнухами