- Главная

- Математика

- Кластерный анализ. Лекция 8

Содержание

- 2. Кластерный анализ. Основные понятия. Кластер имеет следующие математические характеристики: центр, радиус, среднеквадратическое отклонение, размер кластера. Центр

- 3. Кластерный анализ. Нормализация данных Эта проблема решается при помощи предварительной стандартизации переменных. Стандартизация или нормирование приводит

- 4. Кластерный анализ. Измерение близости объектов В кластерном анализе для количественной оценки сходства вводится понятие метрики. Сходство

- 5. Кластерный анализ. Характеристики близости объектов Объединение или метод древовидной кластеризации используется при формировании кластеров несходства или

- 6. Кластерный анализ. Характеристики близости объектов Таблица 1. способы определения близости между объектами

- 7. Кластерный анализ. Характеристики близости объектов Евклидово расстояние является самой популярной метрикой в кластерном анализе. Оно попросту

- 8. Кластерный анализ. Методы кластерного анализа Методы кластерного анализа можно разделить на две группы: иерархические; неиерархические. Каждая

- 9. Кластерный анализ. Иерархическая кластеризация Рис.1. Дендрограмма агломеративных и дивизимных методов

- 10. Кластерный анализ. Иерархическая кластеризация Иерархические методы кластеризации различаются правилами построения кластеров. В качестве правил выступают критерии,

- 11. Кластерный анализ. Иерархическая кластеризация Существует много способов построения дендограмм. В дендограмме объекты могут располагаться вертикально или

- 12. Кластерный анализ. Иерархическая кластеризация Обобщенная алгомеративная процедура. На первом шаге каждый объект считается отдельным кластером. На

- 13. Кластерный анализ. Расстояния между кластерами На первом шаге, когда каждый объект представляет собой отдельный кластер, расстояния

- 14. Кластерный анализ. Расстояния между кластерами 3. Невзвешенное попарное среднее. В этом методе расстояние между двумя различными

- 15. Кластерный анализ. Эталонные методы Наряду с иерархическими методами классификации, существует многочисленная группа итеративных методов кластерного анализа

- 17. Скачать презентацию

Слайд 2Кластерный анализ. Основные понятия.

Кластер имеет следующие математические характеристики: центр, радиус, среднеквадратическое отклонение,

Кластерный анализ. Основные понятия.

Кластер имеет следующие математические характеристики: центр, радиус, среднеквадратическое отклонение,

Центр кластера - это среднее геометрическое место точек в пространстве переменных.

Радиус кластера - максимальное расстояние точек от центра кластера. Кластеры могут быть перекрывающимися. Такая ситуация возникает, когда обнаруживается перекрытие кластеров. В этом случае невозможно при помощи математических процедур однозначно отнести объект к одному из двух кластеров. Такие объекты называют спорными.

Спорный объект - это объект, который по мере сходства может быть отнесен к нескольким кластерам.

Размер кластера может быть определен либо по радиусу кластера, либо по среднеквадратичному отклонению объектов для этого кластера. Объект относится к кластеру, если расстояние от объекта до центра кластера меньше радиуса кластера. Если это условие выполняется для двух и более кластеров, объект является спорным.

Работа кластерного анализа опирается на два предположения. Первое предположение - рассматриваемые признаки объекта в принципе допускают желательное разбиение совокупности объектов на кластеры.

Выбор масштаба в кластерном анализе имеет большое значение. Рассмотрим пример. Представим себе, что данные признака х в наборе данных А на два порядка больше данных признака у: значения переменной х находятся в диапазоне от 100 до 700, а значения переменной у - в диапазоне от 0 до 1. Тогда, при расчете величины расстояния между точками, отражающими положение объектов в пространстве их свойств, переменная, имеющая большие значения, т.е. переменная х, будет практически полностью доминировать над переменной с малыми значениями, т.е. переменной у.

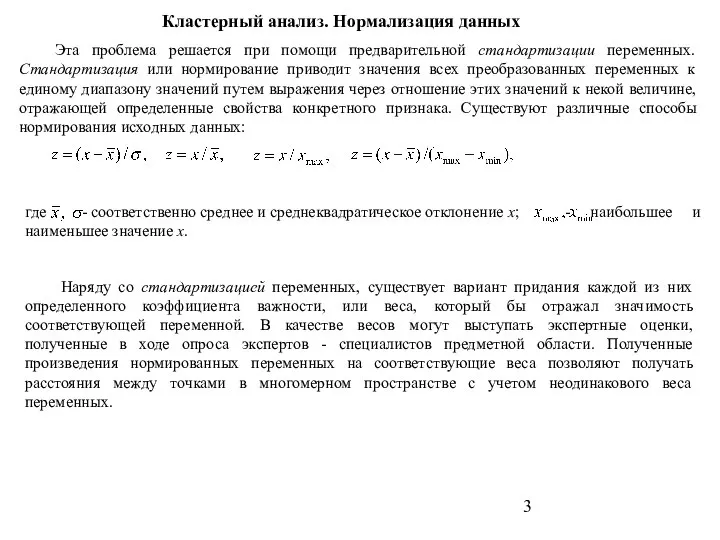

Слайд 3Кластерный анализ. Нормализация данных

Эта проблема решается при помощи предварительной стандартизации переменных. Стандартизация

Кластерный анализ. Нормализация данных

Эта проблема решается при помощи предварительной стандартизации переменных. Стандартизация

где - соответственно среднее и среднеквадратическое отклонение x; - наибольшее и наименьшее значение x.

Наряду со стандартизацией переменных, существует вариант придания каждой из них определенного коэффициента важности, или веса, который бы отражал значимость соответствующей переменной. В качестве весов могут выступать экспертные оценки, полученные в ходе опроса экспертов - специалистов предметной области. Полученные произведения нормированных переменных на соответствующие веса позволяют получать расстояния между точками в многомерном пространстве с учетом неодинакового веса переменных.

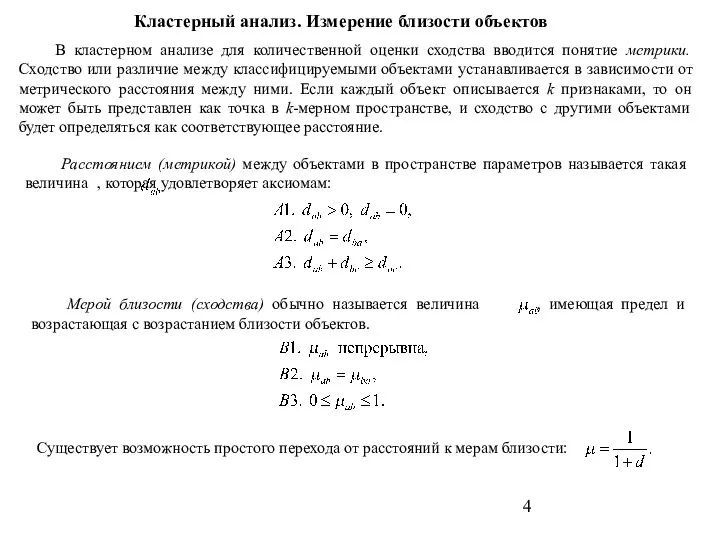

Слайд 4Кластерный анализ. Измерение близости объектов

В кластерном анализе для количественной оценки сходства вводится

Кластерный анализ. Измерение близости объектов

В кластерном анализе для количественной оценки сходства вводится

Расстоянием (метрикой) между объектами в пространстве параметров называется такая величина , которая удовлетворяет аксиомам:

Мерой близости (сходства) обычно называется величина , имеющая предел и возрастающая с возрастанием близости объектов.

Существует возможность простого перехода от расстояний к мерам близости:

Слайд 5Кластерный анализ. Характеристики близости объектов

Объединение или метод древовидной кластеризации используется при формировании

Кластерный анализ. Характеристики близости объектов

Объединение или метод древовидной кластеризации используется при формировании

Слайд 6Кластерный анализ. Характеристики близости объектов

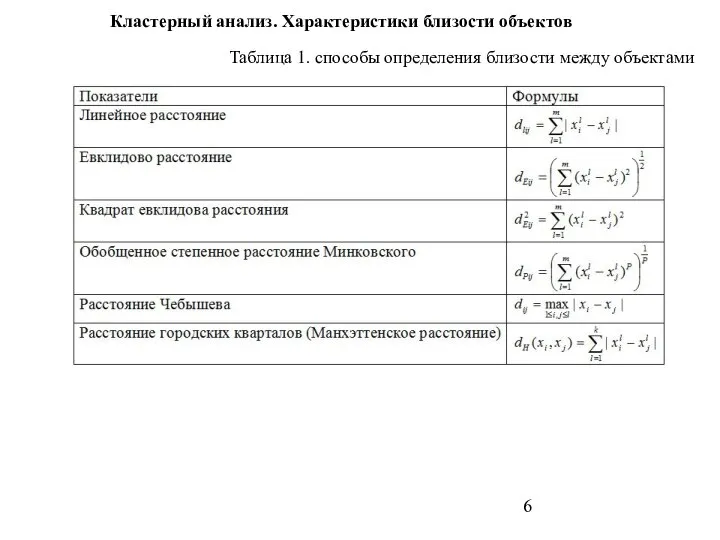

Таблица 1. способы определения близости между объектами

Кластерный анализ. Характеристики близости объектов

Таблица 1. способы определения близости между объектами

Слайд 7Кластерный анализ. Характеристики близости объектов

Евклидово расстояние является самой популярной метрикой в кластерном

Кластерный анализ. Характеристики близости объектов

Евклидово расстояние является самой популярной метрикой в кластерном

Квадрат евклидова расстояния. Для придания больших весов более отдаленным друг от друга объектам можно воспользоваться квадратом евклидова расстояния путем возведения в квадрат стандартного евклидова расстояния.

Обобщенное степенное расстояние представляет только математический интерес как универсальная метрика.

Расстояние Чебышева. Это расстояние стоит использовать, когда необходимо определить два объекта как "различные", если они отличаются по какому-то одному измерению.

Манхэттенское расстояние (расстояние городских кварталов), также называемое "хэмминговым" или "сити-блок" расстоянием. Это расстояние рассчитывается как среднее разностей по координатам. В большинстве случаев эта мера расстояния приводит к результатам, подобным расчетам расстояния евклида. Однако, для этой меры влияние отдельных выбросов меньше, чем при использовании евклидова расстояния, поскольку здесь координаты не возводятся в квадрат.

Процент несогласия. Это расстояние вычисляется, если данные являются категориальными.

Слайд 8Кластерный анализ. Методы кластерного анализа

Методы кластерного анализа можно разделить на две группы:

иерархические;

неиерархические.

Каждая

Кластерный анализ. Методы кластерного анализа

Методы кластерного анализа можно разделить на две группы:

иерархические;

неиерархические.

Каждая

Суть иерархической кластеризации состоит в последовательном объединении меньших кластеров в большие или разделении больших кластеров на меньшие.

Иерархические агломеративные методы (Agglomerative Nesting, AGNES)

Эта группа методов характеризуется последовательным объединением исходных элементов и соответствующим уменьшением числа кластеров. В начале работы алгоритма все объекты являются отдельными кластерами. На первом шаге наиболее похожие объекты объединяются в кластер. На последующих шагах объединение продолжается до тех пор, пока все объекты не будут составлять один кластер.

Иерархические дивизимные (делимые) методы (DIvisive ANAlysis, DIANA)

Эти методы являются логической противоположностью агломеративным методам. В начале работы алгоритма все объекты принадлежат одному кластеру, который на последующих шагах делится на меньшие кластеры, в результате образуется последовательность расщепляющих групп.

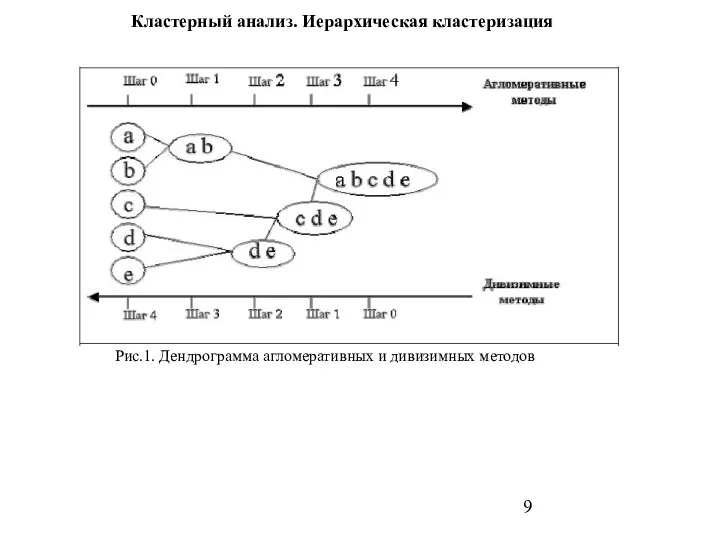

Слайд 9Кластерный анализ. Иерархическая кластеризация

Рис.1. Дендрограмма агломеративных и дивизимных методов

Кластерный анализ. Иерархическая кластеризация

Рис.1. Дендрограмма агломеративных и дивизимных методов

Слайд 10Кластерный анализ. Иерархическая кластеризация

Иерархические методы кластеризации различаются правилами построения кластеров. В качестве

Кластерный анализ. Иерархическая кластеризация

Иерархические методы кластеризации различаются правилами построения кластеров. В качестве

Иерархические методы кластерного анализа используются при небольших объемах наборов данных. Преимуществом иерархических методов кластеризации является их наглядность.

Иерархические алгоритмы связаны с построением дендрограмм, которые являются результатом иерархического кластерного анализа. Дендрограмма описывает близость отдельных точек и кластеров друг к другу, представляет в графическом виде последовательность объединения (разделения) кластеров.

Дендрограмма (dendrogram) - древовидная диаграмма, содержащая n уровней, каждый из которых соответствует одному из шагов процесса последовательного укрупнения кластеров. Дендрограмму также называют древовидной схемой, деревом объединения кластеров, деревом иерархической структуры.

Дендрограмма представляет собой вложенную группировку объектов, которая изменяется на различных уровнях иерархии.

Слайд 11Кластерный анализ. Иерархическая кластеризация

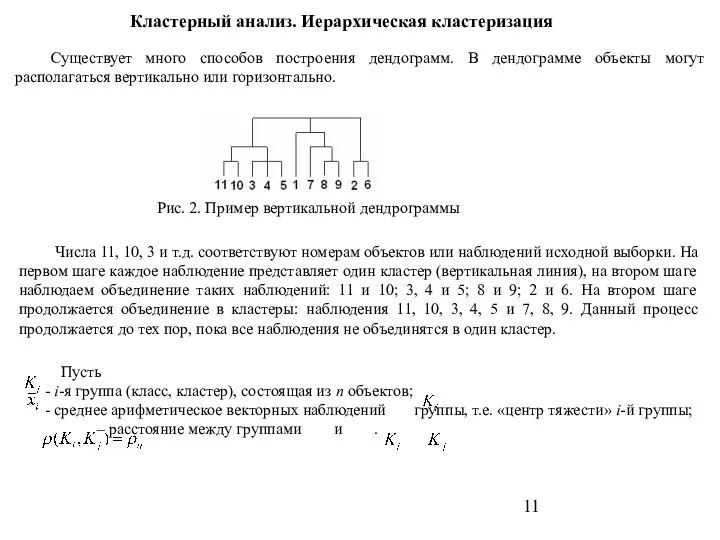

Существует много способов построения дендограмм. В дендограмме объекты могут

Кластерный анализ. Иерархическая кластеризация

Существует много способов построения дендограмм. В дендограмме объекты могут

Рис. 2. Пример вертикальной дендрограммы

Числа 11, 10, 3 и т.д. соответствуют номерам объектов или наблюдений исходной выборки. На первом шаге каждое наблюдение представляет один кластер (вертикальная линия), на втором шаге наблюдаем объединение таких наблюдений: 11 и 10; 3, 4 и 5; 8 и 9; 2 и 6. На втором шаге продолжается объединение в кластеры: наблюдения 11, 10, 3, 4, 5 и 7, 8, 9. Данный процесс продолжается до тех пор, пока все наблюдения не объединятся в один кластер.

Пусть

- i-я группа (класс, кластер), состоящая из n объектов;

- среднее арифметическое векторных наблюдений группы, т.е. «центр тяжести» i-й группы;

– расстояние между группами и .

Слайд 12Кластерный анализ. Иерархическая кластеризация

Обобщенная алгомеративная процедура. На первом шаге каждый объект считается

Кластерный анализ. Иерархическая кластеризация

Обобщенная алгомеративная процедура. На первом шаге каждый объект считается

Если сразу несколько объектов (классов) имеют минимальное расстояние, то возможны две стратегии: выбрать одну случайную пару или объединить сразу все пары. Первый способ является классическим и реализован во всех процедурах (иногда его называют восходящей иерархической классификацией). Второй способ называют методом ближайших соседей (не путать с алг. “Ближайшего соседа”) и используют реже.

Слайд 13Кластерный анализ. Расстояния между кластерами

На первом шаге, когда каждый объект представляет собой

Кластерный анализ. Расстояния между кластерами

На первом шаге, когда каждый объект представляет собой

Далее необходимо правило объединения или связи для двух кластеров. Здесь имеются различные возможности: например, можно связать два кластера вместе, когда любые два объекта в двух кластерах ближе друг к другу, чем соответствующее расстояние связи. Т.е. используется правило ближайшего соседа для определения расстояния между кластерами; этот метод называется методом одиночной связи. Это правило строит волокнистые кластеры, т.е. кластеры сцепленные вместе только отдельными элементами, случайно оказавшимися ближе остальных друг к другу. Как альтернативу можно использовать соседей в кластерах, которые находятся дальше всех остальных пар объектов друг от друга. Этот метод называется метод полной связи. Существует также множество других методов объединения кластеров.

1. Расстояние “Ближайшего соседа” (Одиночная связь). Первый шаг совпадает с первым шагом алгоритма Обобщенная алгомеративная процедура. Расстояние равно расстоянию между ближайшими объектами классов.

2. Расстояние “Дальнего соседа” (Полная связь). Расстояние равно расстоянию между самыми дальними объектами классов.

Слайд 14Кластерный анализ. Расстояния между кластерами

3. Невзвешенное попарное среднее. В этом методе расстояние

Кластерный анализ. Расстояния между кластерами

3. Невзвешенное попарное среднее. В этом методе расстояние

4. Взвешенное попарное среднее. Метод идентичен методу невзвешенного попарного среднего, за исключением того, что при вычислениях размер соответствующих кластеров (т.е. число объектов, содержащихся в них) используется в качестве весового коэффициента. Поэтому предлагаемый метод должен быть использован, когда предполагаются неравные размеры кластеров.

5. Невзвешенный центроидный метод. В этом методе расстояние между двумя кластерами определяется как расстояние между их центрами тяжести.

6. Взвешенный центроидный метод (медиана). Метод идентичен предыдущему, за исключением того, что при вычислениях используются веса для учёта разницы между размерами кластеров (т.е. числами объектов в них). Поэтому, если имеются (или подозреваются) значительные отличия в размерах кластеров, этот метод оказывается предпочтительнее предыдущего.

7. Метод Варда. В этом методе в качестве целевой функции применяют внутригрупповую сумму квадратов отклонений, которая есть ни что иное, как сумма квадратов расстояний между каждой точкой (объектом) и средней по кластеру, содержащему этот объект. На каждом шаге объединяются такие два кластера, которые приводят к минимальному увеличению целевой функции, т.е. внутригрупповой суммы квадратов. Этот метод направлен на объединение близко расположенных кластеров.

Слайд 15Кластерный анализ. Эталонные методы

Наряду с иерархическими методами классификации, существует многочисленная группа итеративных

Кластерный анализ. Эталонные методы

Наряду с иерархическими методами классификации, существует многочисленная группа итеративных

Математическое описание алгоритма метода k - средних.

Пусть имеется n наблюдений, каждое из которых характеризуется m признаками . Эти наблюдения необходимо разбить на k кластеров. Для начала из n точек исследуемой совокупности отбираются случайным образом или задаются исследователем исходя из каких-либо априорных соображений k точек (объектов). Эти точки принимаются за эталоны. Каждому эталону присваивается порядковый номер, который одновременно является и номером кластера.

калькуятор

калькуятор Теория вероятностей и математическая статистика

Теория вероятностей и математическая статистика Ракеты и символы

Ракеты и символы Презентация на тему Нахождение неизвестного по двум разностям

Презентация на тему Нахождение неизвестного по двум разностям  Таблицы сложения и вычитания с числом 2

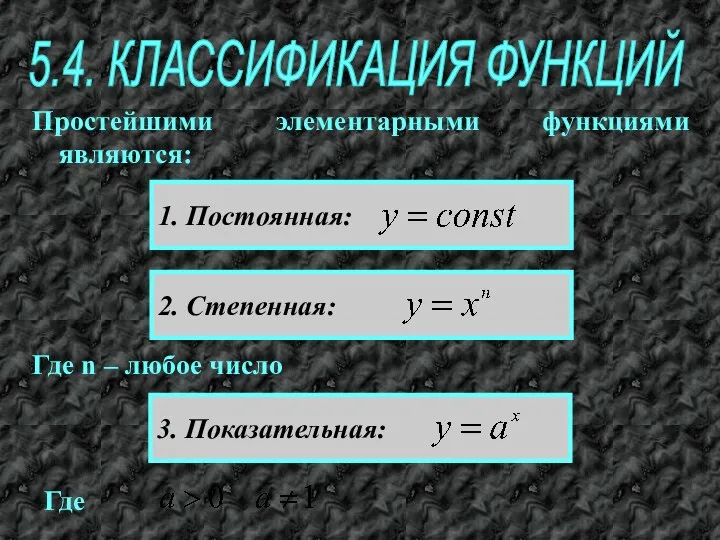

Таблицы сложения и вычитания с числом 2 Классификация функций

Классификация функций Вектор. Сложение векторов

Вектор. Сложение векторов Логические задачи. Математика и информатика. Тетрадь для 1–2 классов

Логические задачи. Математика и информатика. Тетрадь для 1–2 классов Математические основы ТАУ (продолжение)

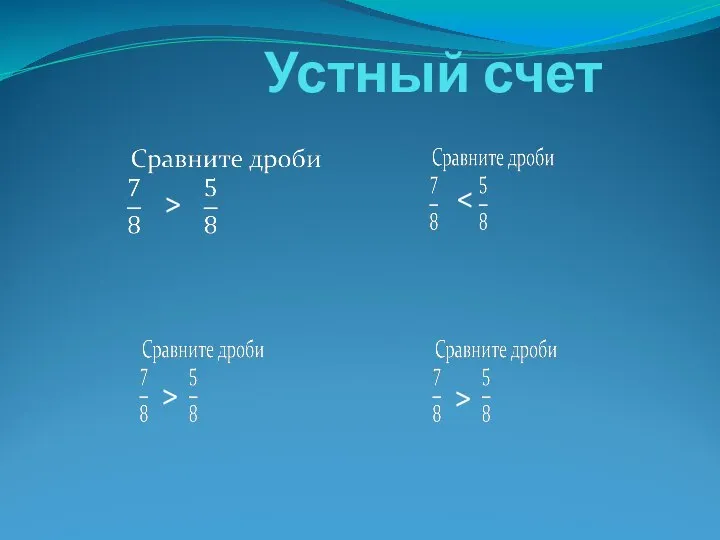

Математические основы ТАУ (продолжение) Устный счет. 5 класс

Устный счет. 5 класс Числовые ряды

Числовые ряды Считаем со смешариками. Тренажер Сложенеие и вычитание в пределах 10.Технологический прием Анимированная сорбонка

Считаем со смешариками. Тренажер Сложенеие и вычитание в пределах 10.Технологический прием Анимированная сорбонка Если я знаю, что знаю мало, я добьюсь того, чтобы знать больше

Если я знаю, что знаю мало, я добьюсь того, чтобы знать больше Первообразная. Правила нахождения первообразных

Первообразная. Правила нахождения первообразных Комбинаторика. Из истории комбинаторики

Комбинаторика. Из истории комбинаторики Параллельность в пространстве

Параллельность в пространстве Задуманное число. Общий множитель

Задуманное число. Общий множитель Теорема Пифагора

Теорема Пифагора Анализ результатов ЕГЭ и ОГЭ 2021 по математике

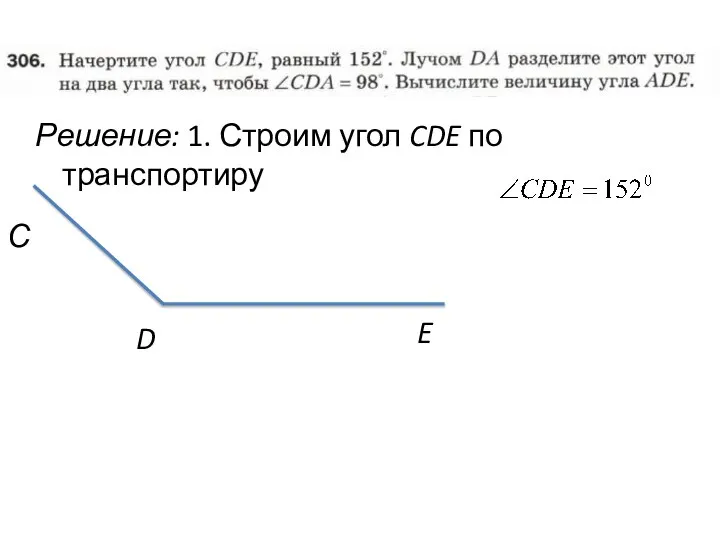

Анализ результатов ЕГЭ и ОГЭ 2021 по математике Построение угла по транспортиру. Задача

Построение угла по транспортиру. Задача Сложение. Увеличиваем на 1

Сложение. Увеличиваем на 1 Решение систем неравенств с одной переменной

Решение систем неравенств с одной переменной Геометричні переміщення

Геометричні переміщення Через точку А провести профильную прямую ВС, равнонаклоненную к плоскости П1 и плоскости П2. (задача 20)

Через точку А провести профильную прямую ВС, равнонаклоненную к плоскости П1 и плоскости П2. (задача 20) Площадь прямоугольника

Площадь прямоугольника Надежность технических систем

Надежность технических систем Сечение поверхности плоскостью

Сечение поверхности плоскостью Основы тригонометрии. Радианная мера угла. Вращательное движение точки вокруг начла координат

Основы тригонометрии. Радианная мера угла. Вращательное движение точки вокруг начла координат