Содержание

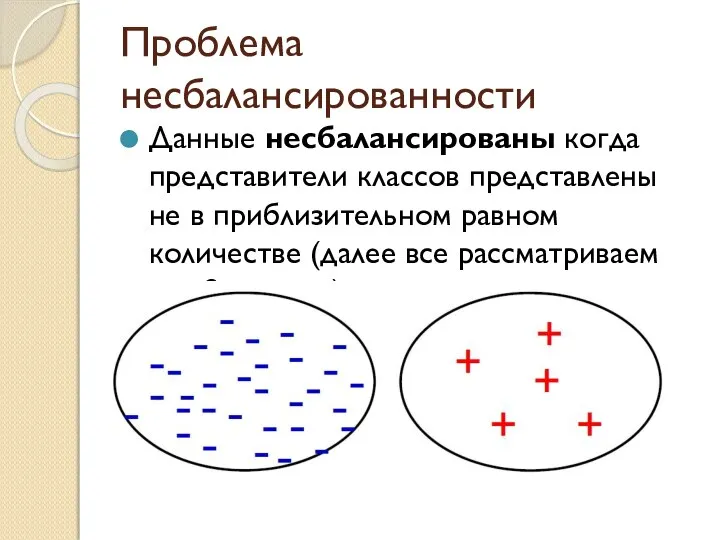

- 2. Проблема несбалансированности Данные несбалансированы когда представители классов представлены не в приблизительном равном количестве (далее все рассматриваем

- 3. В чем проблема? Многие стандартные классификаторы пытаются увеличить точность и не изменить распределение обучающей выборки, поэтому

- 4. Цель классификации - детектирование Стоимость ошибки неправильно классифицировать ненормальный образец данных как нормальный много выше чем

- 5. Примеры несбалансированных данных: 1) из 100 000 тысяч подавших заявку, только 2% проходят в гарвард на

- 6. Техники работы с несбалансированными данными I. Работа с данными : SMOTE Random Undersampling Random Oversampling II.Чувствительность

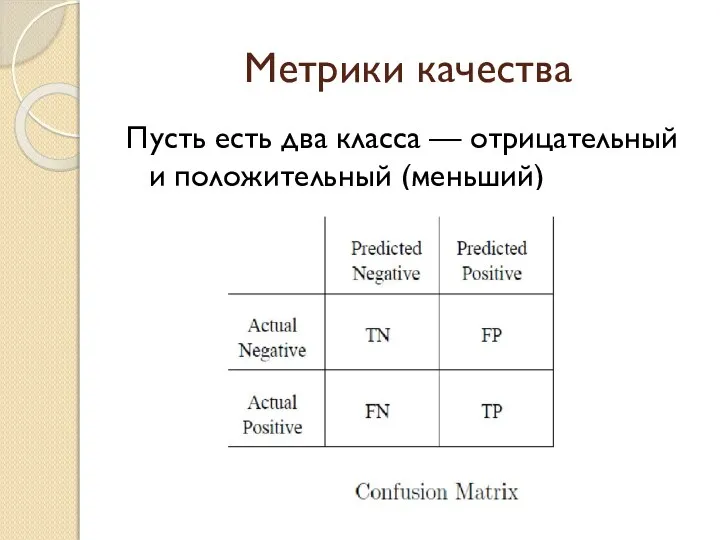

- 7. Метрики качества Пусть есть два класса — отрицательный и положительный (меньший)

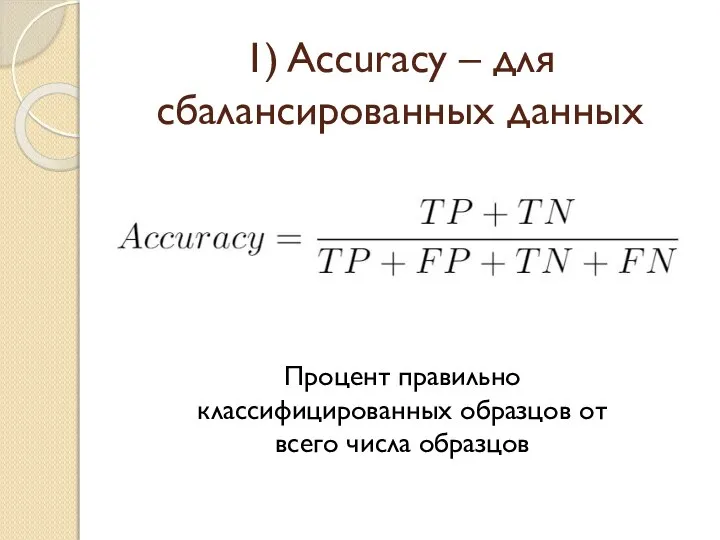

- 8. 1) Accuracy – для сбалансированных данных Процент правильно классифицированных образцов от всего числа образцов

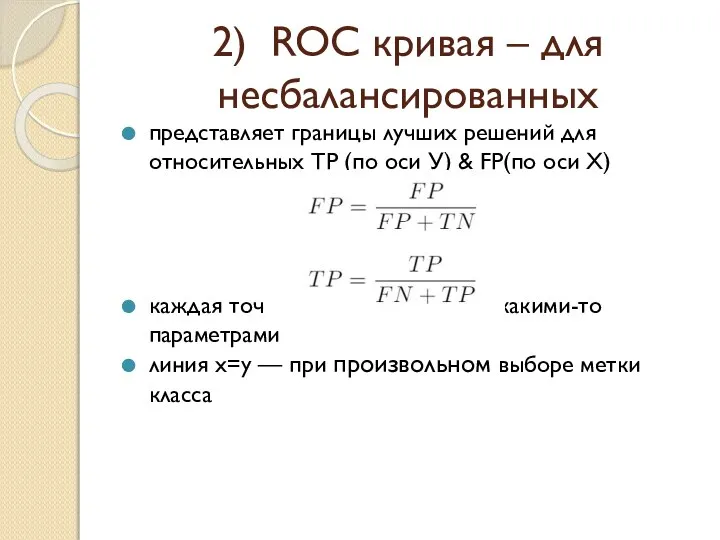

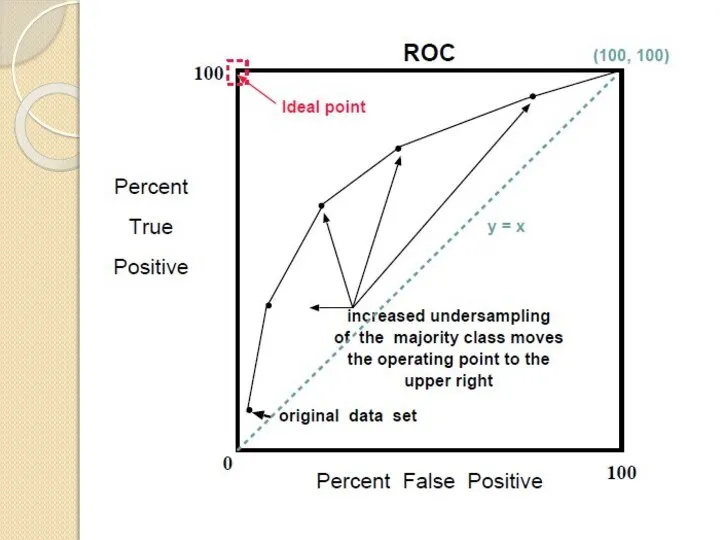

- 9. 2) ROC кривая – для несбалансированных представляет границы лучших решений для относительных TP (по оси У)

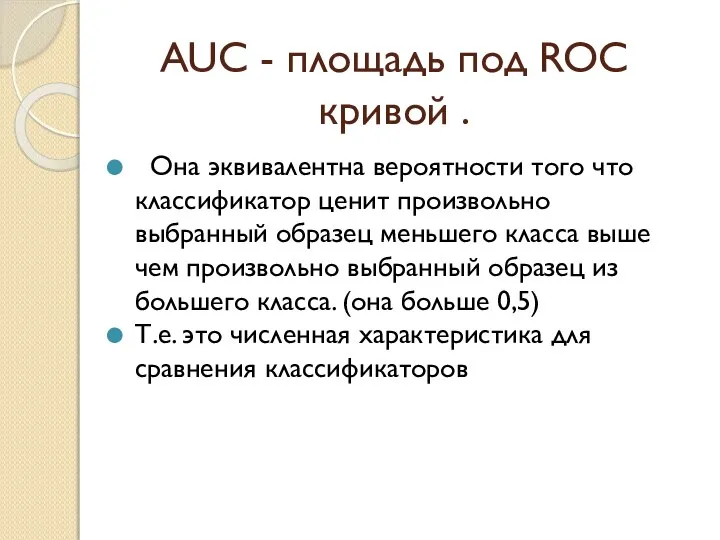

- 11. AUC - площадь под ROC кривой . Она эквивалентна вероятности того что классификатор ценит произвольно выбранный

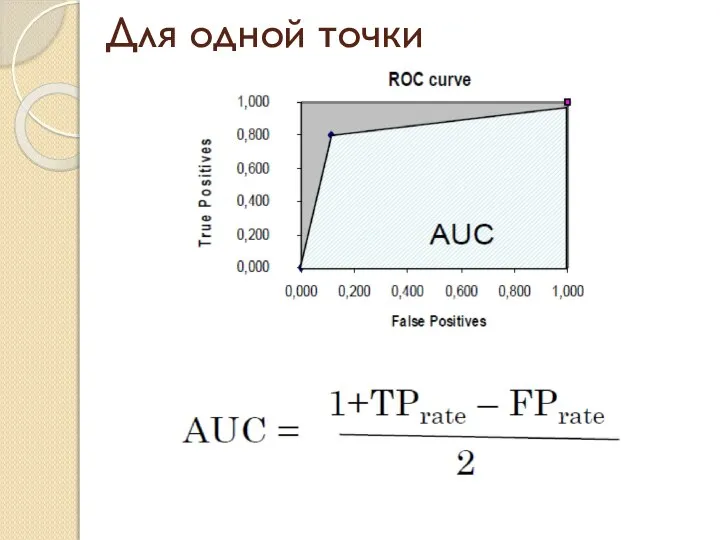

- 12. Для одной точки

- 13. Преимущества ROC Когда алгоритм изучает больше образцов одного (-) класса он будет ошибочно классифицировать больше образцов

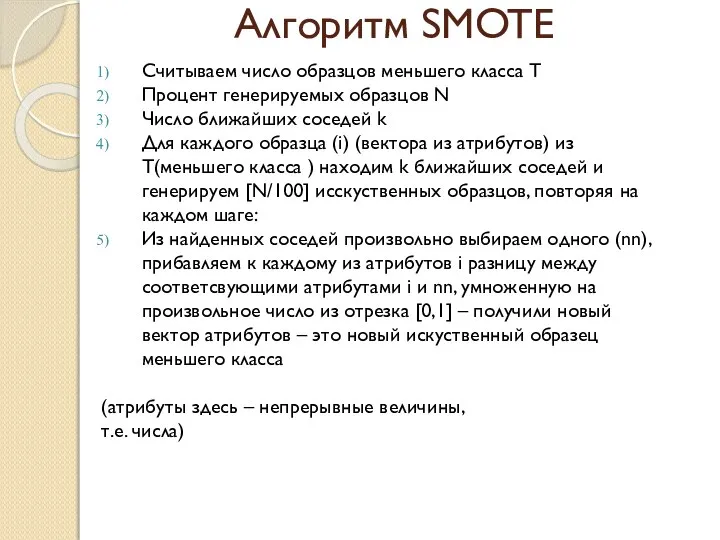

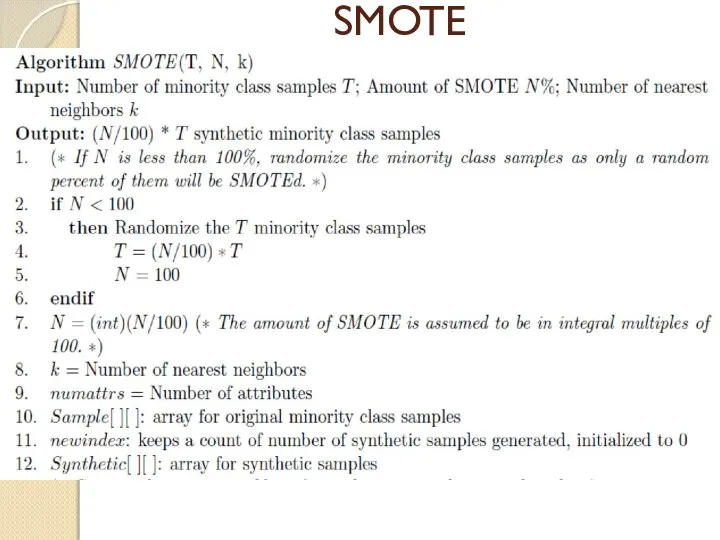

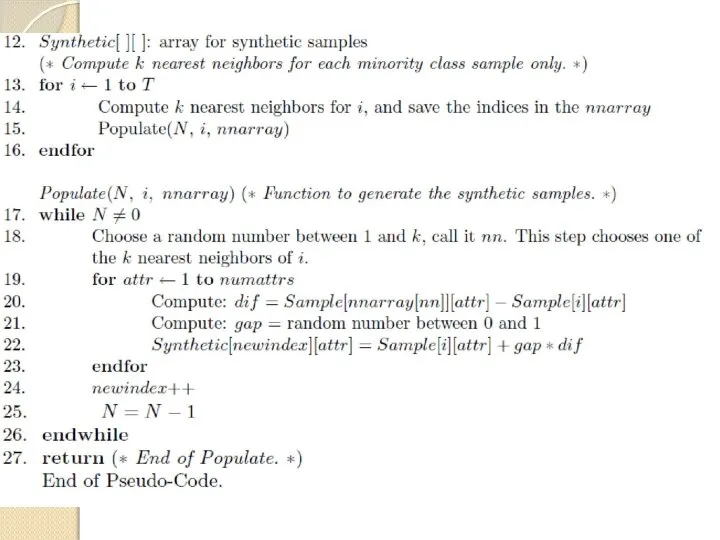

- 14. Алгоритм SMOTE Считываем число образцов меньшего класса Т Процент генерируемых образцов N Число ближайших соседей k

- 15. SMOTE

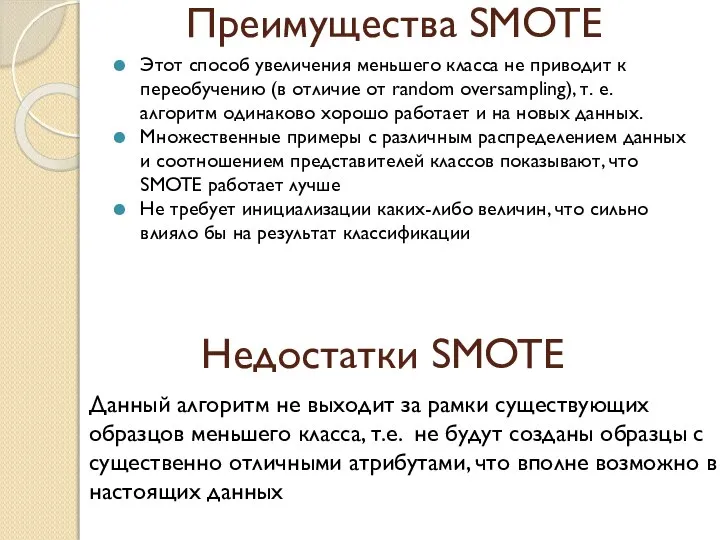

- 17. Преимущества SMOTE Этот способ увеличения меньшего класса не приводит к переобучению (в отличие от random oversampling),

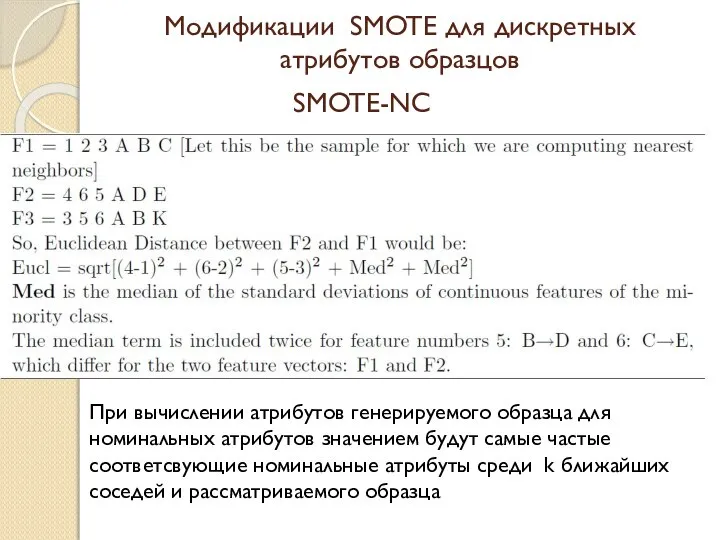

- 18. Модификации SMOTE для дискретных атрибутов образцов При вычислении атрибутов генерируемого образца для номинальных атрибутов значением будут

- 20. Скачать презентацию

Решение уравнений с неизвестным уменьшаемым

Решение уравнений с неизвестным уменьшаемым Школа волшебников

Школа волшебников Старинные меры длины

Старинные меры длины Проценты

Проценты Првильные многоугольники

Првильные многоугольники Аналитическая панель

Аналитическая панель Логарифмические неравенства

Логарифмические неравенства Как можно заменить произведение равных сомножителей?

Как можно заменить произведение равных сомножителей? Множества и отношения

Множества и отношения Решение квадратных неравенств

Решение квадратных неравенств Зачетная система в старших классах как средство предупреждения неуспеваемости

Зачетная система в старших классах как средство предупреждения неуспеваемости Деление дробных чисел

Деление дробных чисел Устный счет. 3 класс

Устный счет. 3 класс Электронное приложение к уроку по геометрии в 8 классе Теорема Пифагора. Методическая разработка

Электронное приложение к уроку по геометрии в 8 классе Теорема Пифагора. Методическая разработка Как построена задача, какие части есть в задаче

Как построена задача, какие части есть в задаче Микрокалькулятор

Микрокалькулятор Собираем ягоды. Математика 1 класс. Итоговое повторение. Тренажёр

Собираем ягоды. Математика 1 класс. Итоговое повторение. Тренажёр Динамические модели

Динамические модели Действуй активно. Задача предельного типа №1

Действуй активно. Задача предельного типа №1 Четырехугольники

Четырехугольники Наука Метрология

Наука Метрология Использование приёма обобщения в процессе развития мышления учащихся

Использование приёма обобщения в процессе развития мышления учащихся Стереометрия. Базовые понятия. Определения

Стереометрия. Базовые понятия. Определения Цифровой образовательный ресурс. Приложение к урокам алгебры. 7 класс

Цифровой образовательный ресурс. Приложение к урокам алгебры. 7 класс Тестовые задания

Тестовые задания Открытый урок по математике с использованием компьютеров

Открытый урок по математике с использованием компьютеров Преобразование иррациональных выражений

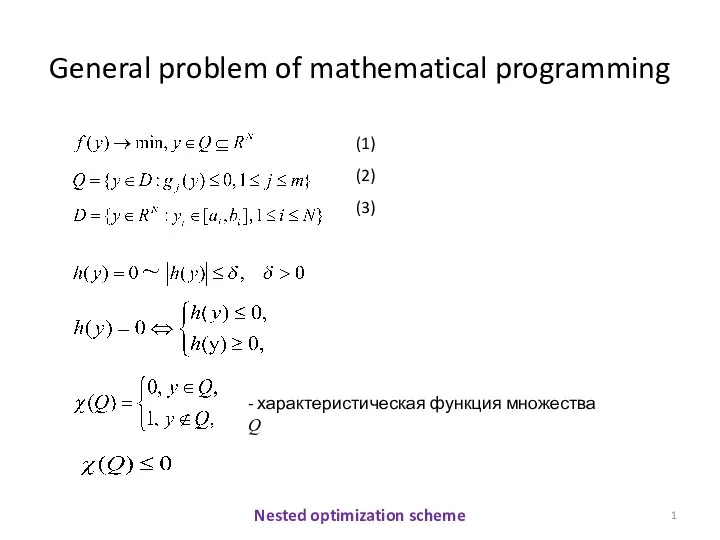

Преобразование иррациональных выражений General problem of mathematical programming

General problem of mathematical programming