Содержание

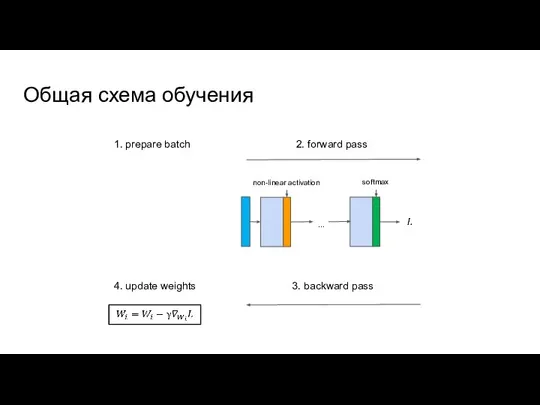

- 2. Общая схема обучения ... 1. prepare batch 2. forward pass 3. backward pass 4. update weights

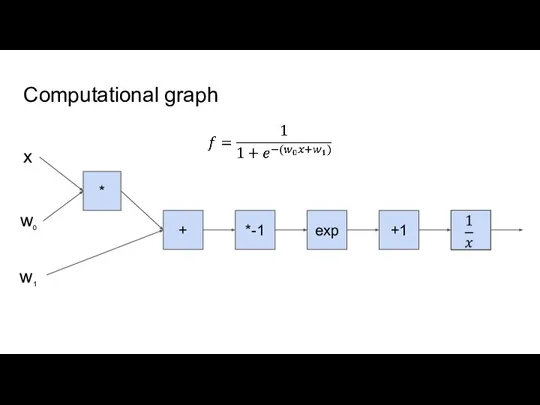

- 3. Computational graph * + *-1 exp +1 x w0 w1

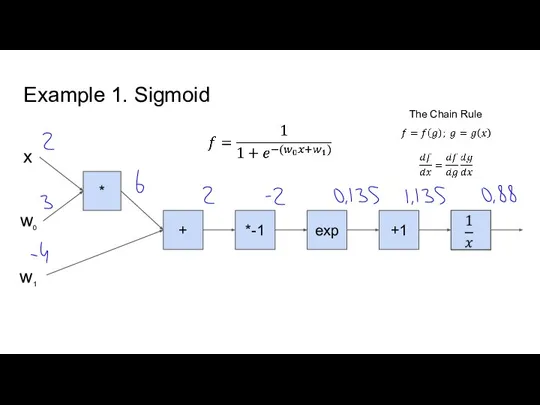

- 4. Example 1. Sigmoid * + *-1 exp +1 x w0 The Chain Rule w1

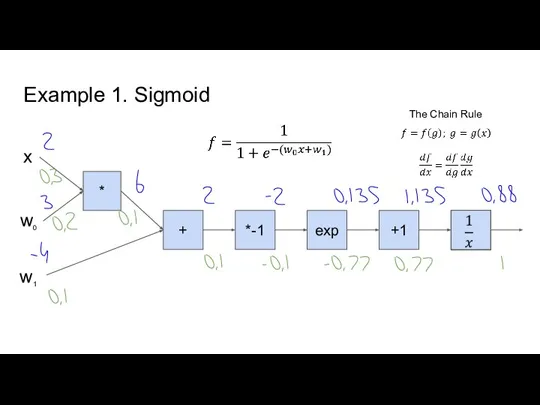

- 5. Example 1. Sigmoid * + *-1 exp +1 x w0 w1 The Chain Rule

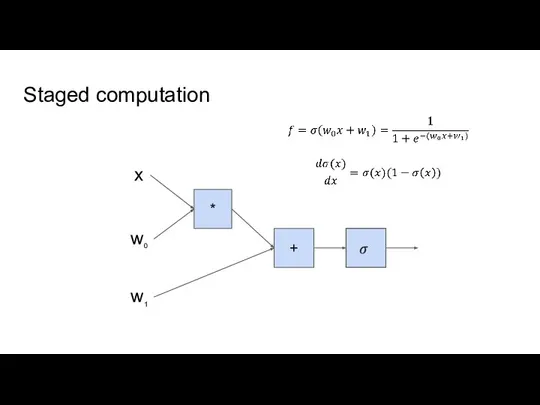

- 6. Staged computation * + x w0 w1

- 7. Gradient checking

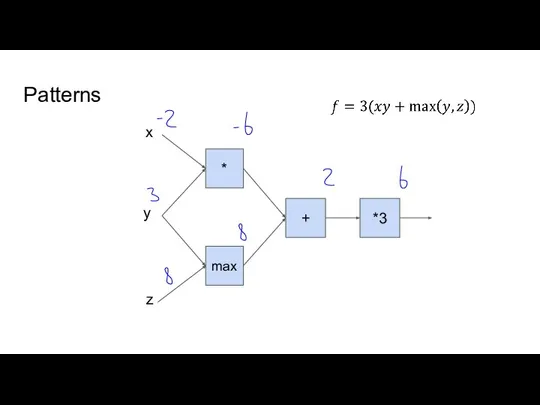

- 8. Patterns * + *3 x y z max

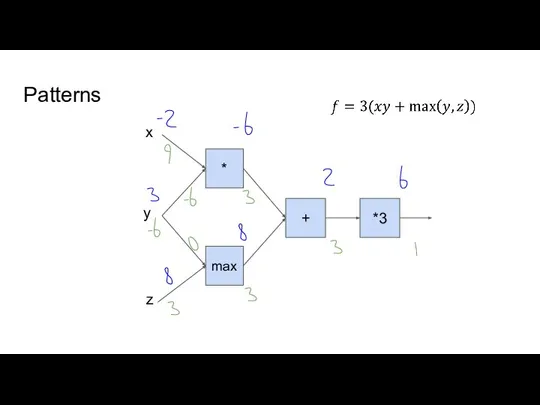

- 9. Patterns * + *3 max x y z

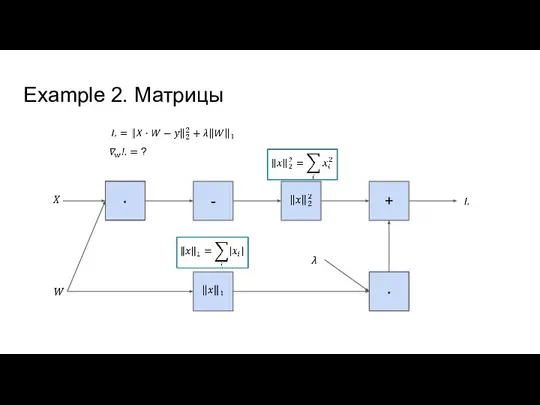

- 10. Example 2. Матрицы + -

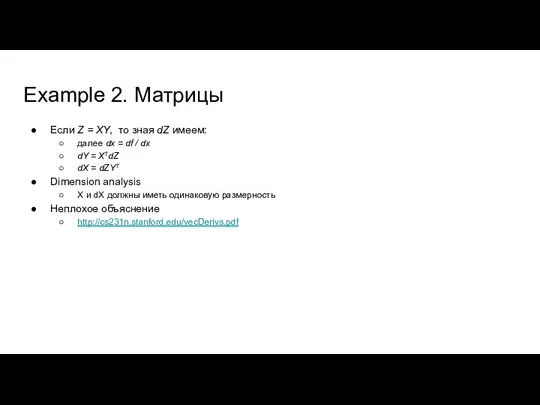

- 11. Example 2. Матрицы Если Z = XY, то зная dZ имеем: далее dx = df /

- 12. Example 3. Simple NN + + L

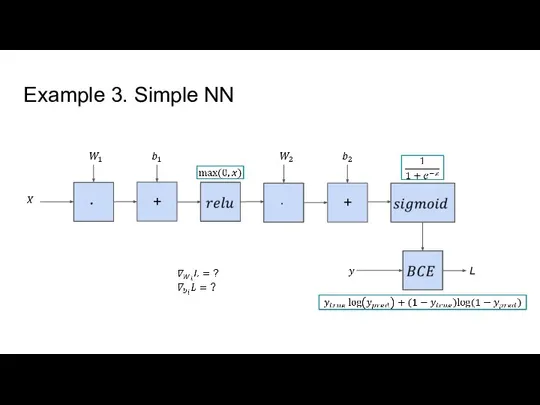

- 13. Example 4. Softmax

- 14. Example 4. Softmax

- 15. На практике backprop для softmax и cross-entropy loss обычно считают вместе В таком случае получается очень

- 17. Скачать презентацию

Уравнение. Решение задач с помощью уравнений

Уравнение. Решение задач с помощью уравнений Математика. Раздел 6. Метод координат в пространстве. Занятие 66. Уравнение плоскости

Математика. Раздел 6. Метод координат в пространстве. Занятие 66. Уравнение плоскости Средняя линия треугольника

Средняя линия треугольника Линии второго порядка

Линии второго порядка Каких чисел не бывает

Каких чисел не бывает Математика. Классная работа

Математика. Классная работа Теоремы синусов и косинусов. Тест

Теоремы синусов и косинусов. Тест Квиллинг и математика. Гипотеза

Квиллинг и математика. Гипотеза Соотношения между углами и сторонами треугольника

Соотношения между углами и сторонами треугольника Математический хоккей

Математический хоккей Презентация на тему Цилиндры и цилиндрические поверхности (11 класс)

Презентация на тему Цилиндры и цилиндрические поверхности (11 класс)  Человек и число

Человек и число Решение практических задач с помощью арифметической прогрессии

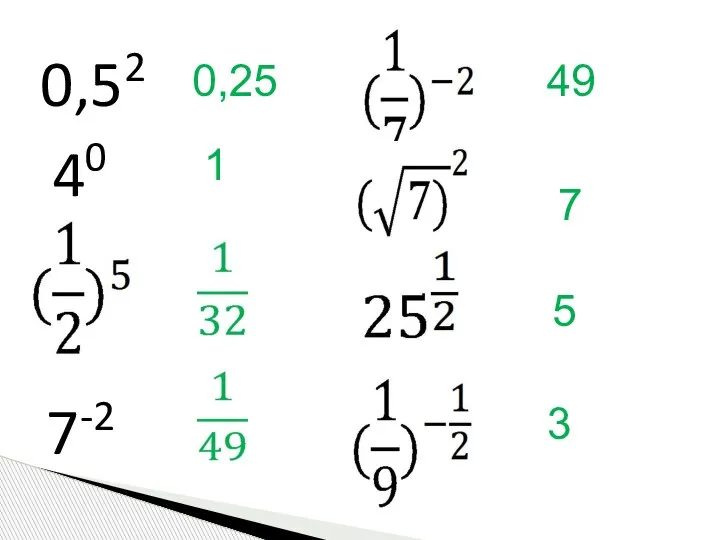

Решение практических задач с помощью арифметической прогрессии Показательная функция

Показательная функция Логарифм

Логарифм Геометрия. Это полезно знать

Геометрия. Это полезно знать О математическом языке

О математическом языке Кроссворд Площади фигур

Кроссворд Площади фигур Математическая сказка. День рождения

Математическая сказка. День рождения Аксонометрические проекции

Аксонометрические проекции Признаки делимости на 11

Признаки делимости на 11 Иррациональные неравенства

Иррациональные неравенства ЕГЭ Профиль - Задание 6

ЕГЭ Профиль - Задание 6 Виды углов

Виды углов Движение подводной лодки. Расчетная работа

Движение подводной лодки. Расчетная работа Числовые функции, их свойства и графики

Числовые функции, их свойства и графики Правило чтения графиков

Правило чтения графиков Задачи по аналитической геометрии на плоскости. Уравнения прямой на плоскости

Задачи по аналитической геометрии на плоскости. Уравнения прямой на плоскости